LLM Token Counter

Übersicht von LLM Token Counter

LLM Token Counter: Ein umfassendes Tool zur Verwaltung von LLM-Token-Limits

Was ist LLM Token Counter?

LLM Token Counter ist ein Tool, das Benutzern hilft, Token-Limits für verschiedene Sprachmodelle (LLMs) zu verwalten, darunter GPT-3.5, GPT-4, Claude-3 und Llama-3. Es unterstützt viele gängige Modelle und zielt darauf ab, eine optimale Erfahrung bei der Nutzung generativer KI-Technologie zu bieten.

Wie funktioniert LLM Token Counter?

LLM Token Counter verwendet Transformers.js, eine JavaScript-Implementierung der Hugging Face Transformers-Bibliothek. Tokenizer werden direkt in Ihren Browser geladen, sodass die Tokenanzahl clientseitig berechnet werden kann. Die effiziente Rust-Implementierung gewährleistet eine schnelle Tokenanzahlberechnung.

Warum ist LLM Token Counter wichtig?

LLMs haben inhärente Token-Beschränkungen, und das Überschreiten dieser Beschränkungen kann zu unerwarteten Ausgaben führen. LLM Token Counter hilft Ihnen, innerhalb der angegebenen Grenzen zu bleiben, um eine optimale Leistung zu gewährleisten.

Wird mein Prompt bei der Verwendung von LLM Token Counter durchsickern?

Nein, Ihr Prompt bleibt sicher. Die Tokenanzahlberechnung wird clientseitig durchgeführt, wodurch sichergestellt wird, dass Ihre sensiblen Daten niemals an den Server oder eine externe Einheit übertragen werden. Datenschutz hat höchste Priorität.

Wo kann ich LLM Token Counter verwenden?

LLM Token Counter ist online über eine Website zugänglich, sodass es bequem auf jedem Gerät mit einem Browser verwendet werden kann.

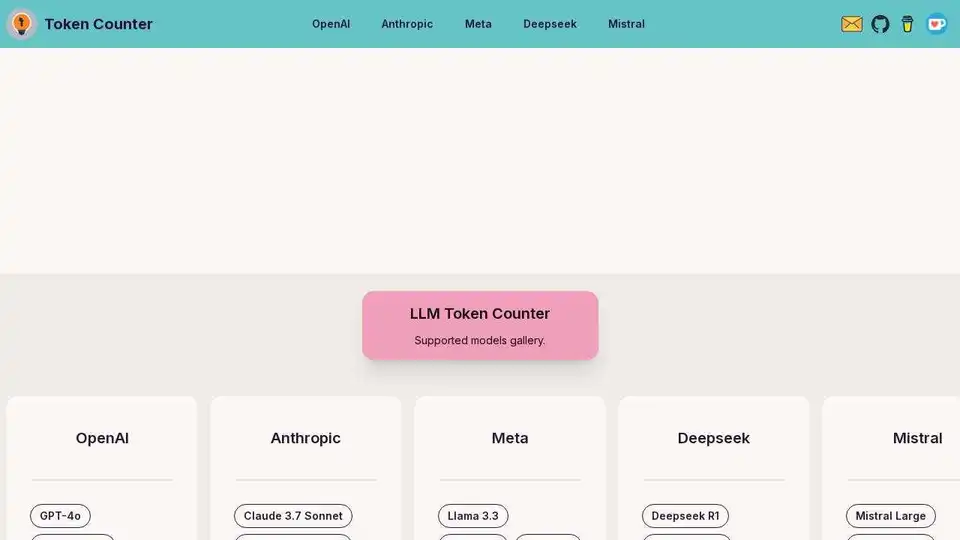

Unterstützte Modelle:

- OpenAI: GPT-4, GPT-3.5 Turbo, Embedding-Modelle

- Anthropic: Claude Opus, Claude Sonnet, Claude Haiku

- Meta: Llama 3, Llama 2, Code Llama

- Deepseek: Deepseek R1, Deepseek V3, Deepseek V2

- Mistral: Mistral Large, Mistral Small, Codestral

Wie verwaltet man LLM-Token-Limits am besten?

Verwenden Sie LLM Token Counter, um Token zu berechnen, bevor Sie Ihre Prompts einreichen, um die Einhaltung der Token-Limits sicherzustellen. Aktualisieren Sie regelmäßig auf die neuesten Modelle, um genaue Zählungen zu erhalten.

Wenn Sie Hilfe benötigen oder Vorschläge für zusätzliche Funktionen haben, können Sie sich gerne per E-Mail melden.

Beste Alternativwerkzeuge zu "LLM Token Counter"

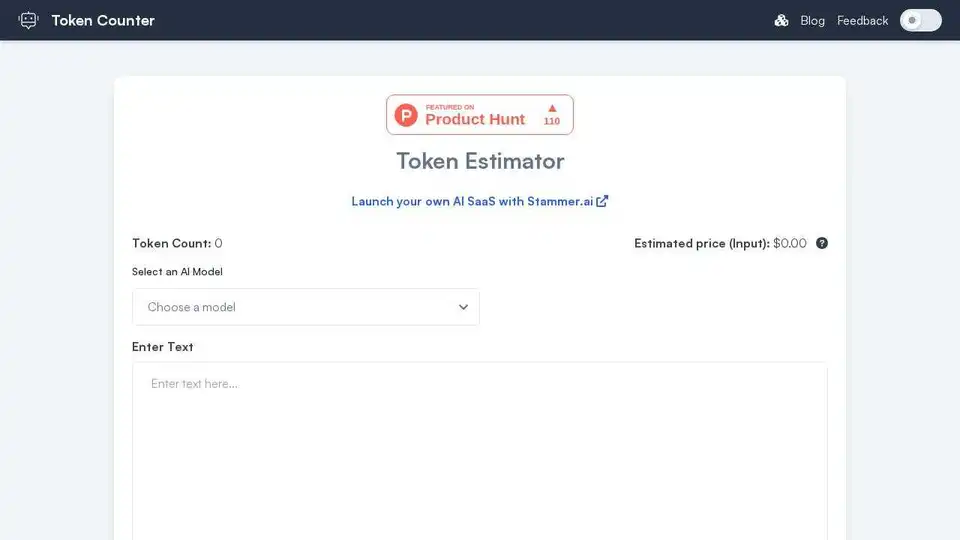

Token Counter: Zählen Sie Token, schätzen Sie die Kosten für jedes KI-Modell. Optimieren Sie Prompts, verwalten Sie Budgets und maximieren Sie die Effizienz bei KI-Interaktionen.

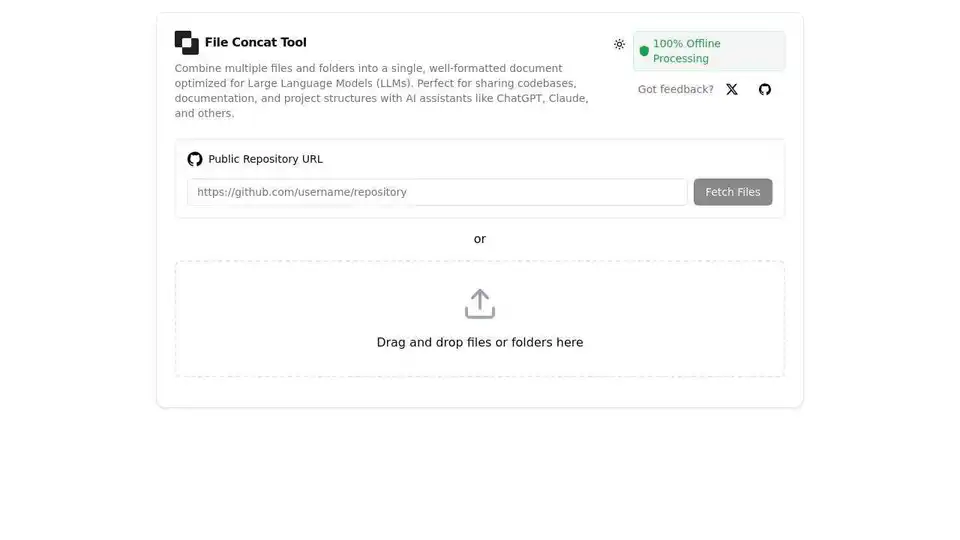

Kostenloses Online-Tool zur Dateiverkettung für KI-Assistenten. Kombinieren Sie Dateien in einem optimierten Format für ChatGPT, Claude, Gemini & andere LLMs.

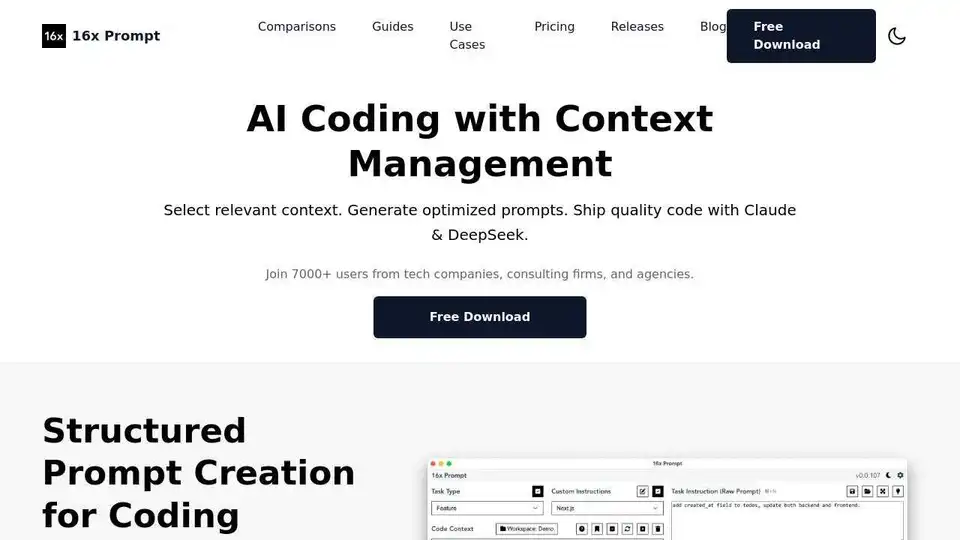

16x Prompt ist ein KI-Codierungstool zur Verwaltung des Code-Kontexts, zur Anpassung von Prompts und zur schnelleren Bereitstellung von Funktionen mit LLM-API-Integrationen. Ideal für Entwickler, die eine effiziente KI-gestützte Codierung suchen.

ModelFusion: Komplettes LLM-Toolkit für 2025 mit Kostenrechnern, Prompt-Bibliothek und KI-Observability-Tools für GPT-4, Claude und mehr.

Chatten Sie mit KI unter Verwendung Ihrer API-Schlüssel. Zahlen Sie nur für das, was Sie nutzen. Unterstützt GPT-4, Gemini, Claude und andere LLMs. Die beste Chat-LLM-Frontend-OI für alle KI-Modelle.

Blitzschnelle KI-Plattform für Entwickler. Bereitstellen, Feinabstimmen und Ausführen von über 200 optimierten LLMs und multimodalen Modellen mit einfachen APIs - SiliconFlow.

OpenUI ist ein Open-Source-Tool, das es Ihnen ermöglicht, UI-Komponenten in natürlicher Sprache zu beschreiben und sie live mit LLMs zu rendern. Konvertieren Sie Beschreibungen in HTML, React oder Svelte für schnelles Prototyping.

Awan LLM bietet eine unbegrenzte, uneingeschränkte und kostengünstige LLM-Inferenz-API-Plattform. Es ermöglicht Benutzern und Entwicklern den Zugriff auf leistungsstarke LLM-Modelle ohne Token-Beschränkungen, ideal für KI-Agenten, Rollenspiele, Datenverarbeitung und Code-Vervollständigung.

Botpress ist eine vollständige KI-Agentenplattform, die von den neuesten LLMs unterstützt wird. Sie ermöglicht Ihnen das Erstellen, Bereitstellen und Verwalten von KI-Agenten für Kundensupport, interne Automatisierung und mehr mit nahtlosen Integrationsfunktionen.

GPT Researcher ist ein Open-Source-KI-Forschungsassistent, der die Tiefenrecherche automatisiert. Es sammelt Informationen aus vertrauenswürdigen Quellen, aggregiert Ergebnisse und generiert schnell umfassende Berichte. Ideal für Einzelpersonen und Teams, die unvoreingenommene Einblicke suchen.

Awan LLM bietet eine uneingeschränkte und kostengünstige LLM-Inferenz-API-Plattform mit unbegrenzten Token, ideal für Entwickler und Power-User. Verarbeiten Sie Daten, vervollständigen Sie Code und erstellen Sie KI-Agenten ohne Token-Limits.

AiPrice bietet eine API zur Berechnung der OpenAI-Token-Preise. Schätzen Sie die Anzahl der Prompt-Token für verschiedene LLM-Modelle genau ab. Kostenloser Plan verfügbar, keine Kreditkarte erforderlich.

DeepSeek v3 ist ein leistungsstarkes KI-gestütztes LLM mit 671B Parametern, das API-Zugriff und ein Forschungspapier bietet. Testen Sie unsere Online-Demo für hochmoderne Leistung.

Fiorino.AI ist eine Open-Source-Lösung für SaaS-Unternehmen zur Verfolgung und Optimierung von KI-Kosten. Überwachen Sie die LLM-Nutzung, legen Sie Ausgabenlimits fest und automatisieren Sie die nutzungsbasierte Abrechnung.