mistral.rs

Übersicht von mistral.rs

Was ist mistral.rs?

Mistral.rs ist eine plattformübergreifende, blitzschnelle Inferenz-Engine für große Sprachmodelle (LLM), die in Rust geschrieben ist. Sie wurde entwickelt, um hohe Leistung und Flexibilität auf verschiedenen Plattformen und Hardwarekonfigurationen zu bieten. Mistral.rs unterstützt multimodale Workflows und verarbeitet Text, Vision, Bildgenerierung und Sprache.

Hauptmerkmale und Vorteile

- Multimodaler Workflow: Unterstützt Text↔Text, Text+Vision↔Text, Text+Vision+Audio↔Text, Text→Sprache, Text→Bild.

- APIs: Bietet Rust-, Python- und OpenAI HTTP-Server-APIs (mit Chat Completions, Responses API) zur einfachen Integration in verschiedene Umgebungen.

- MCP-Client: Verbindet sich automatisch mit externen Tools und Diensten, wie z. B. Dateisystemen, Websuche, Datenbanken und anderen APIs.

- Leistung: Nutzt Technologien wie ISQ (In-Place-Quantisierung), PagedAttention und FlashAttention für optimierte Leistung.

- Benutzerfreundlichkeit: Enthält Funktionen wie automatische Gerätezuordnung (Multi-GPU, CPU), Chat-Vorlagen und Tokenizer-Autoerkennung.

- Flexibilität: Unterstützt LoRA- & X-LoRA-Adapter mit Weight Merging, AnyMoE zur Erstellung von MoE-Modellen auf jedem Basismodell und anpassbare Quantisierung.

Wie funktioniert mistral.rs?

Mistral.rs nutzt verschiedene Schlüsseltechniken, um seine hohe Leistung zu erzielen:

- In-Place Quantization (ISQ): Reduziert den Speicherbedarf und verbessert die Inferenzgeschwindigkeit durch Quantisierung der Modellgewichte.

- PagedAttention & FlashAttention: Optimiert die Speichernutzung und die Recheneffizienz während der Aufmerksamkeitsmechanismen.

- Automatische Gerätezuordnung: Verteilt das Modell automatisch auf die verfügbaren Hardwareressourcen, einschließlich mehrerer GPUs und CPUs.

- MCP (Model Context Protocol): Ermöglicht die nahtlose Integration mit externen Tools und Diensten durch Bereitstellung eines standardisierten Protokolls für Tool-Aufrufe.

Wie verwendet man mistral.rs?

Installation: Befolgen Sie die Installationsanweisungen in der offiziellen Dokumentation. Dies beinhaltet in der Regel die Installation von Rust und das Klonen des mistral.rs-Repositorys.

Modellbeschaffung: Beschaffen Sie das gewünschte LLM-Modell. Mistral.rs unterstützt verschiedene Modellformate, darunter Hugging Face-Modelle, GGUF und GGML.

API-Nutzung: Verwenden Sie die Rust-, Python- oder OpenAI-kompatiblen HTTP-Server-APIs, um mit der Inferenz-Engine zu interagieren. Beispiele und Dokumentationen sind für jede API verfügbar.

- Python-API:

pip install mistralrs - Rust-API:

Fügen Sie

mistralrs = { git = "https://github.com/EricLBuehler/mistral.rs.git" }zu IhrerCargo.tomlhinzu.

- Python-API:

Server ausführen: Starten Sie den mistralrs-Server mit den entsprechenden Konfigurationsoptionen. Dies kann die Angabe des Modellpfads, der Quantisierungsmethode und anderer Parameter umfassen.

./mistralrs-server --port 1234 run -m microsoft/Phi-3.5-MoE-instruct

Anwendungsfälle

Mistral.rs eignet sich für eine Vielzahl von Anwendungen, darunter:

- Chatbots und konversationelle KI: Betreiben Sie interaktive und ansprechende Chatbots mit hochleistungsfähiger Inferenz.

- Textgenerierung: Generieren Sie realistische und kohärente Texte für verschiedene Zwecke, wie z. B. Inhaltserstellung und Zusammenfassung.

- Bild- und Videoanalyse: Verarbeiten und analysieren Sie visuelle Daten mit integrierten Vision-Funktionen.

- Spracherkennung und -synthese: Ermöglichen Sie sprachbasierte Interaktionen mit Unterstützung für Audioverarbeitung.

- Tool Calling und Automatisierung: Integrieren Sie externe Tools und Dienste für automatisierte Workflows.

Für wen ist mistral.rs gedacht?

Mistral.rs ist konzipiert für:

- Entwickler: Die eine schnelle und flexible LLM-Inferenz-Engine für ihre Anwendungen benötigen.

- Forscher: Die neue Modelle und Techniken in der Verarbeitung natürlicher Sprache erforschen.

- Organisationen: Die hochleistungsfähige KI-Funktionen für ihre Produkte und Dienstleistungen benötigen.

Warum mistral.rs wählen?

- Leistung: Bietet blitzschnelle Inferenzgeschwindigkeiten durch Techniken wie ISQ, PagedAttention und FlashAttention.

- Flexibilität: Unterstützt eine Vielzahl von Modellen, Quantisierungsmethoden und Hardwarekonfigurationen.

- Benutzerfreundlichkeit: Bietet einfache APIs und automatische Konfigurationsoptionen für die einfache Integration.

- Erweiterbarkeit: Ermöglicht die Integration mit externen Tools und Diensten über das MCP-Protokoll.

Unterstützte Beschleuniger

Mistral.rs unterstützt eine Vielzahl von Beschleunigern:

- NVIDIA GPUs (CUDA): Verwenden Sie die Feature-Flags

cuda,flash-attnundcudnn. - Apple Silicon GPU (Metal): Verwenden Sie das Feature-Flag

metal. - CPU (Intel): Verwenden Sie das Feature-Flag

mkl. - CPU (Apple Accelerate): Verwenden Sie das Feature-Flag

accelerate. - Generische CPU (ARM/AVX): Standardmäßig aktiviert.

Um Funktionen zu aktivieren, übergeben Sie sie an Cargo:

cargo build --release --features "cuda flash-attn cudnn"

Community und Support

Fazit

Mistral.rs zeichnet sich als leistungsstarke und vielseitige LLM-Inferenz-Engine aus, die blitzschnelle Leistung, umfangreiche Flexibilität und nahtlose Integrationsmöglichkeiten bietet. Seine plattformübergreifende Natur und die Unterstützung für multimodale Workflows machen es zu einer ausgezeichneten Wahl für Entwickler, Forscher und Organisationen, die die Leistungsfähigkeit großer Sprachmodelle in einer Vielzahl von Anwendungen nutzen möchten. Durch die Nutzung seiner fortschrittlichen Funktionen und APIs können Benutzer auf einfache Weise innovative und wirkungsvolle KI-Lösungen erstellen.

Für diejenigen, die ihre KI-Infrastruktur optimieren und das volle Potenzial von LLMs ausschöpfen möchten, bietet mistral.rs eine robuste und effiziente Lösung, die sich sowohl für Forschungs- als auch für Produktionsumgebungen gut eignet.

Beste Alternativwerkzeuge zu "mistral.rs"

Private LLM ist ein lokaler KI-Chatbot für iOS und macOS, der offline funktioniert und Ihre Informationen vollständig auf dem Gerät, sicher und privat hält. Genießen Sie unzensierte Chats auf Ihrem iPhone, iPad und Mac.

Awan LLM bietet eine unbegrenzte, uneingeschränkte und kostengünstige LLM-Inferenz-API-Plattform. Es ermöglicht Benutzern und Entwicklern den Zugriff auf leistungsstarke LLM-Modelle ohne Token-Beschränkungen, ideal für KI-Agenten, Rollenspiele, Datenverarbeitung und Code-Vervollständigung.

Botpress ist eine vollständige KI-Agentenplattform, die von den neuesten LLMs unterstützt wird. Sie ermöglicht Ihnen das Erstellen, Bereitstellen und Verwalten von KI-Agenten für Kundensupport, interne Automatisierung und mehr mit nahtlosen Integrationsfunktionen.

Nebius ist eine KI-Cloud-Plattform, die entwickelt wurde, um die KI-Infrastruktur zu demokratisieren und eine flexible Architektur, getestete Leistung und langfristigen Wert mit NVIDIA-GPUs und optimierten Clustern für Training und Inferenz bietet.

HUMAIN bietet Full-Stack-KI-Lösungen, die Infrastruktur, Daten, Modelle und Anwendungen abdecken. Beschleunigen Sie den Fortschritt und erschließen Sie mit den KI-nativen Plattformen von HUMAIN reale Auswirkungen in großem Maßstab.

AI Runner ist eine Offline-KI-Inferenz-Engine für Kunst, Echtzeit-Sprachkonversationen, LLM-gestützte Chatbots und automatisierte Arbeitsabläufe. Führen Sie Bilderzeugung, Voice-Chat und mehr lokal aus!

Friendli Inference ist die schnellste LLM-Inferenz-Engine, optimiert für Geschwindigkeit und Kosteneffizienz, die GPU-Kosten um 50-90 % senkt und gleichzeitig einen hohen Durchsatz und eine geringe Latenz bietet.

Awan LLM bietet eine uneingeschränkte und kostengünstige LLM-Inferenz-API-Plattform mit unbegrenzten Token, ideal für Entwickler und Power-User. Verarbeiten Sie Daten, vervollständigen Sie Code und erstellen Sie KI-Agenten ohne Token-Limits.

Ermöglichen Sie eine effiziente LLM-Inferenz mit llama.cpp, einer C/C++-Bibliothek, die für verschiedene Hardware optimiert ist und Quantisierung, CUDA und GGUF-Modelle unterstützt. Ideal für lokale und Cloud-Bereitstellung.

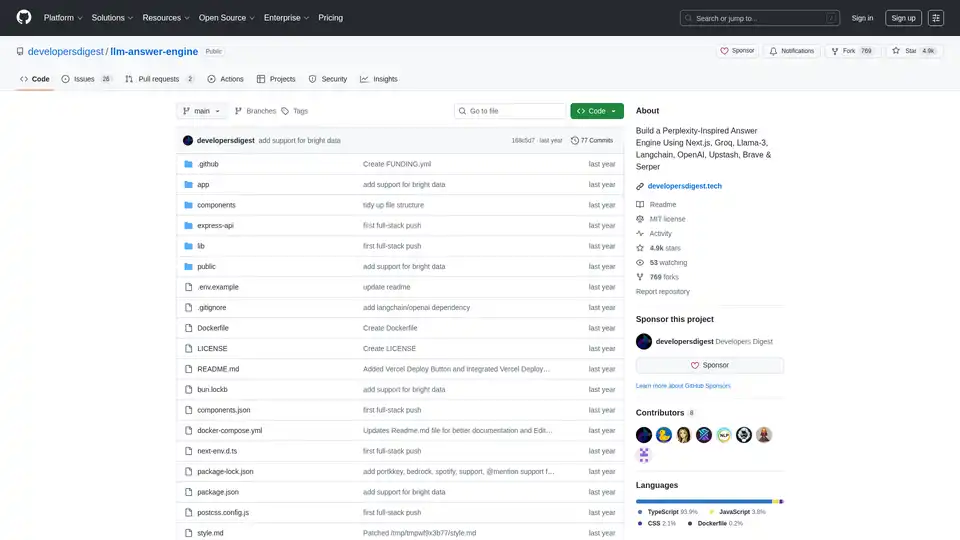

Erstellen Sie eine von Perplexity inspirierte KI-Antwort-Engine mit Next.js, Groq, Llama-3 und Langchain. Erhalten Sie effizient Quellen, Antworten, Bilder und Folgefragen.

vLLM ist eine Inferenz- und Serving-Engine mit hohem Durchsatz und Speichereffizienz für LLMs, die PagedAttention und kontinuierliche Batchverarbeitung für optimierte Leistung bietet.

Blitzschnelle KI-Plattform für Entwickler. Bereitstellen, Feinabstimmen und Ausführen von über 200 optimierten LLMs und multimodalen Modellen mit einfachen APIs - SiliconFlow.

Rierino ist eine leistungsstarke Low-Code-Plattform, die E-Commerce und digitale Transformation mit KI-Agenten, composable Commerce und nahtlosen Integrationen für skalierbare Innovation beschleunigt.

Spice.ai ist eine Open-Source-Daten- und KI-Inferenz-Engine zum Erstellen von KI-Apps mit SQL-Query-Federation, Beschleunigung, Suche und Abruf auf der Grundlage von Unternehmensdaten.