Featherless.ai

Übersicht von Featherless.ai

Was ist Featherless.ai?

Featherless.ai ist ein serverloser LLM-Hosting-Anbieter, der Ihnen Zugriff auf eine riesige Bibliothek von Open-Source-Modellen von Hugging Face bietet. Vergessen Sie die Komplexität der Serververwaltung und des betrieblichen Aufwands; Featherless kümmert sich um alles, sodass Sie sich darauf konzentrieren können, KI für Ihre Projekte zu nutzen.

Hauptmerkmale:

- Umfangreicher Modellkatalog: Greifen Sie auf über 11.900 Open-Source-Modelle zu.

- Serverlose Inferenz: Stellen Sie Modelle bereit, ohne Server zu verwalten.

- Pauschalpreise: Vorhersehbare Abrechnung mit unbegrenzten Token.

- Geringe Latenz: Profitieren Sie von fortschrittlichem Modellladen und GPU-Orchestrierung.

- LangChain-Kompatibilität: Nutzen Sie Ihre Anwendungen mit Featherless über die OpenAI SDK-Kompatibilität.

Wie verwende ich Featherless.ai?

- Anmelden: Erstellen Sie ein Konto auf Featherless.ai.

- Modelle erkunden: Durchsuchen Sie den umfangreichen Modellkatalog.

- Bereitstellen: Stellen Sie Modelle sofort für Feinabstimmung, Tests oder Produktion bereit.

- Integrieren: Verwenden Sie die API, um Modelle in Ihre Anwendungen zu integrieren.

Warum Featherless.ai wählen?

Featherless.ai bietet eine überzeugende Alternative zu anderen Anbietern, indem es einen riesigen Modellkatalog mit serverloser Infrastruktur und vorhersehbarer Preisgestaltung kombiniert. Es ist die ideale Lösung für KI-Teams, die die Leistungsfähigkeit von Open-Source-Modellen nutzen möchten, ohne den Aufwand der Serververwaltung.

Anwendungsfälle:

- OpenHands: Optimieren Sie die Softwareentwicklung mit KI-gestützten Codierungsaufgaben.

- NovelCrafter: Verbessern Sie das kreative Schreiben mit KI-Unterstützung während des gesamten Romanentstehungsprozesses.

- WyvernChat: Erstellen Sie einzigartige Charaktere mit benutzerdefinierten Persönlichkeiten mithilfe einer großen Auswahl an Open-Source-Modellen.

Preisgestaltung:

Featherless.ai bietet drei Preispläne an:

- Feather Basic: 10 US-Dollar/Monat für Modelle mit bis zu 15 Milliarden Parametern.

- Feather Premium: 25 US-Dollar/Monat für den Zugriff auf DeepSeek- und Kimi-K2-Modelle.

- Feather Scale: 75 US-Dollar/Monat für Geschäftspläne mit skalierbarer Parallelität.

Häufig gestellte Fragen:

Was ist Featherless?

Featherless ist ein LLM-Hosting-Anbieter, der Zugriff auf eine ständig wachsende Bibliothek von HuggingFace-Modellen bietet.

Protokollieren Sie meinen Chatverlauf?

Nein, die an unsere API gesendeten Eingabeaufforderungen und Vervollständigungen werden nicht protokolliert.

Welche Modellarchitekturen werden unterstützt?

Eine breite Palette von Llama-Modellen wird unterstützt, darunter Llama 2 und 3, Mistral, Qwen und DeepSeek.

Weitere Informationen finden Sie unter Featherless.ai und erkunden Sie die Dokumentation.

Beste Alternativwerkzeuge zu "Featherless.ai"

Avian API bietet die schnellste KI-Inferenz für Open-Source-LLMs und erreicht 351 TPS auf DeepSeek R1. Stellen Sie jeden HuggingFace LLM mit einer 3-10-fachen Geschwindigkeit mit einer OpenAI-kompatiblen API bereit. Enterprise-Grade-Performance und Datenschutz.

Blitzschnelle KI-Plattform für Entwickler. Bereitstellen, Feinabstimmen und Ausführen von über 200 optimierten LLMs und multimodalen Modellen mit einfachen APIs - SiliconFlow.

Awan LLM bietet eine uneingeschränkte und kostengünstige LLM-Inferenz-API-Plattform mit unbegrenzten Token, ideal für Entwickler und Power-User. Verarbeiten Sie Daten, vervollständigen Sie Code und erstellen Sie KI-Agenten ohne Token-Limits.

Ermöglichen Sie eine effiziente LLM-Inferenz mit llama.cpp, einer C/C++-Bibliothek, die für verschiedene Hardware optimiert ist und Quantisierung, CUDA und GGUF-Modelle unterstützt. Ideal für lokale und Cloud-Bereitstellung.

Awan LLM bietet eine unbegrenzte, uneingeschränkte und kostengünstige LLM-Inferenz-API-Plattform. Es ermöglicht Benutzern und Entwicklern den Zugriff auf leistungsstarke LLM-Modelle ohne Token-Beschränkungen, ideal für KI-Agenten, Rollenspiele, Datenverarbeitung und Code-Vervollständigung.

Deep Infra ist eine kostengünstige, skalierbare AI-Inferenz-Plattform mit +100 ML-Modellen wie DeepSeek-V3.2, Qwen und OCR-Tools. Entwicklerfreundliche APIs, GPU-Vermietung und Null-Datenretention.

Entdecken Sie Qwen3 Coder, das fortschrittliche KI-Code-Generierungsmodell von Alibaba Cloud. Erfahren Sie mehr über seine Funktionen, Leistungsbenchmarks und wie Sie dieses leistungsstarke Open-Source-Tool für die Entwicklung nutzen.

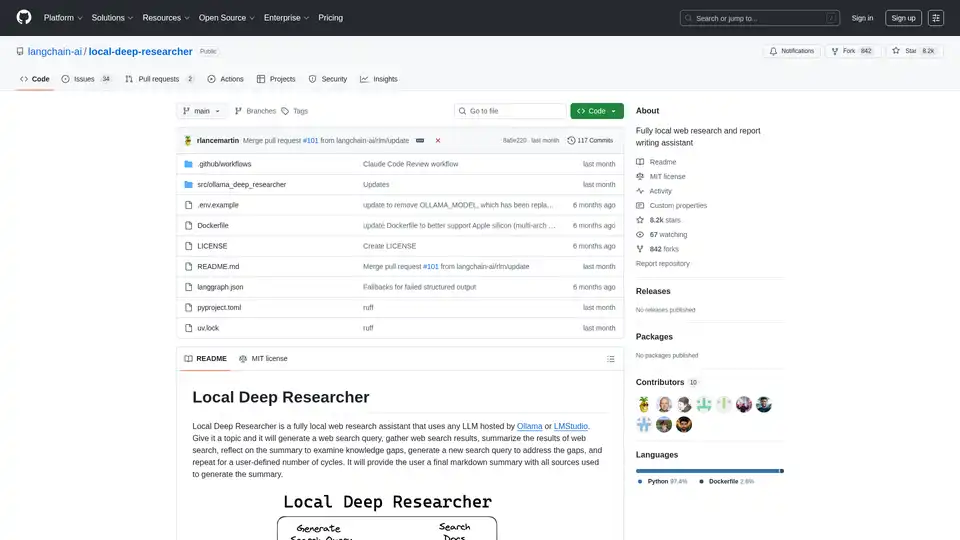

Local Deep Researcher ist ein vollständig lokaler Web-Recherche-Assistent, der LLMs über Ollama oder LMStudio verwendet, um Suchanfragen zu generieren, Ergebnisse zu sammeln, Erkenntnisse zusammenzufassen und umfassende Forschungsberichte mit ordnungsgemäßen Zitaten zu erstellen.

Vext entwickelt kundenspezifische KI-Lösungen für Unternehmen, einschließlich LLM-Anwendungen, Modell-Feinabstimmung, Managed Hosting und kundenspezifische API-Dienste.

Erstellen Sie mit Morph in wenigen Minuten KI-gestützte Daten-Apps. Python-Framework + Hosting mit integrierter Authentifizierung, Datenkonnektoren, CI/CD.

Parea AI ist eine KI-Experimentier- und Annotationsplattform, die Teams dabei unterstützt, LLM-Anwendungen zuverlässig auszuliefern. Sie bietet Funktionen für die Experimentverfolgung, Observability, Human Review und Prompt-Bereitstellung.

Lunary ist eine Open-Source-LLM-Engineering-Plattform, die Observability, Prompt-Management und Analysen für die Erstellung zuverlässiger KI-Anwendungen bietet. Es bietet Tools für das Debugging, die Leistungsverfolgung und die Gewährleistung der Datensicherheit.

LightOn Paradigm: Stellen Sie souveräne LLM- und KI-Agenten in Ihrer vertrauenswürdigen Umgebung bereit. Erstellen Sie Workflows mit vollständiger Datenkontrolle.

Confident AI ist eine auf DeepEval basierende LLM-Evaluierungsplattform, die Ingenieurteams befähigt, die Leistung von LLM-Anwendungen zu testen, zu bewerten, zu sichern und zu verbessern. Sie bietet erstklassige Metriken, Schutzmaßnahmen und Beobachtbarkeit zur Optimierung von KI-Systemen und zum Aufdecken von Regressionen.