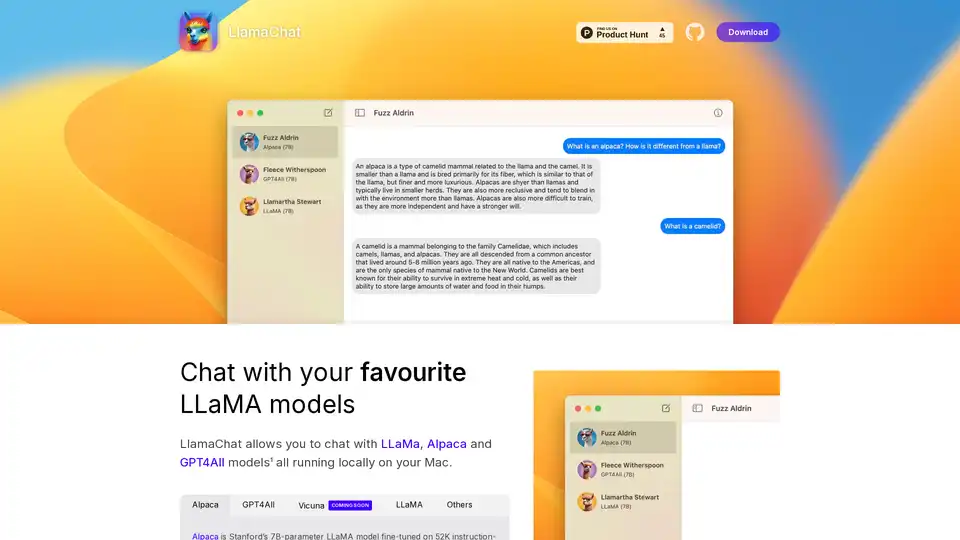

LlamaChat

Übersicht von LlamaChat

LlamaChat: Chatte mit lokalen LLaMA-Modellen auf deinem Mac

Was ist LlamaChat? LlamaChat ist eine macOS-Anwendung, die es Benutzern ermöglicht, mit verschiedenen Large Language Models (LLMs) wie LLaMA, Alpaca und GPT4All direkt auf ihrem Mac zu interagieren, ohne auf cloudbasierte Dienste angewiesen zu sein. Das bedeutet, dass die Modelle lokal laufen, was eine verbesserte Privatsphäre und Kontrolle bietet.

Hauptmerkmale und Funktionalität

- Lokale LLM-Unterstützung: LlamaChat unterstützt mehrere LLMs, darunter LLaMA, Alpaca und GPT4All, die alle lokal auf deinem Mac laufen.

- Modellkonvertierung: LlamaChat kann rohe PyTorch-Modell-Checkpoints oder vorkonvertierte .ggml-Modelldateien importieren, um die Verwendung zu erleichtern.

- Open-Source: Basierend auf Open-Source-Bibliotheken wie llama.cpp und llama.swift, was Transparenz und Community-gesteuerte Entwicklung gewährleistet.

- Kostenlos und Open-Source: LlamaChat ist komplett kostenlos und Open-Source, was Zugänglichkeit und Community-Beiträge sicherstellt.

Unterstützte Modelle

- Alpaca: Stanfords 7B-Parameter LLaMA-Modell, das auf 52.000 Instruction-Following-Demonstrationen feinabgestimmt wurde, die von OpenAI’s text-davinci-003 generiert wurden.

- GPT4All: Ein Open-Source-LLM.

- Vicuna: Ein Open-Source-LLM.

- LLaMA: Metas grundlegendes LLM.

Wie funktioniert LlamaChat?

LlamaChat nutzt Open-Source-Bibliotheken, um LLMs direkt auf deinem Rechner auszuführen. Es basiert auf llama.cpp und llama.swift. Dies ermöglicht es dir, rohe PyTorch-Modell-Checkpoints oder vorkonvertierte .ggml-Modelldateien zu konvertieren und zu importieren.

Wie verwende ich LlamaChat?

- Herunterladen: Lade LlamaChat von der offiziellen Website herunter oder verwende

brew install --cask llamachat. - Installieren: Installiere die Anwendung auf deinem macOS 13 oder höher.

- Modelle importieren: Importiere deine LLaMA-, Alpaca- oder GPT4All-Modelle in die Anwendung.

- Chatten: Beginne lokal mit deinen bevorzugten LLM-Modellen zu chatten.

Warum LlamaChat wählen?

- Privatsphäre: Führe Modelle lokal aus, ohne Daten an externe Server zu senden.

- Kontrolle: Volle Kontrolle über die verwendeten Modelle und Daten.

- Kosteneffektiv: Keine Abonnementgebühren oder Nutzungsentgelte.

- Open-Source: Profitiere von Community-gesteuerten Verbesserungen und Transparenz.

Für wen ist LlamaChat geeignet?

LlamaChat ist ideal für:

- Entwickler: Experimentieren mit LLMs auf lokalen Rechnern.

- Forscher: Durchführung von Forschung ohne Abhängigkeit von externen Diensten.

- Datenschutzbewusste Benutzer: Benutzer, die ihre Daten lokal und privat halten möchten.

Installation

LlamaChat kann installiert werden über:

- Herunterladen: Direkt von der GitHub-Seite des Projekts oder Product Hunt.

- Homebrew: Mit dem Befehl

brew install --cask llamachat.

Open Source Bibliotheken

LlamaChat basiert auf:

- llama.cpp: Für effiziente Inferenz von LLMs auf der CPU.

- llama.swift: Bereitstellung einer nativen macOS-Schnittstelle für LLMs.

Haftungsausschluss

LlamaChat ist nicht mit Meta Platforms, Inc., Leland Stanford Junior University oder Nomic AI, Inc. verbunden. Die Benutzer sind dafür verantwortlich, die entsprechenden Modelldateien in Übereinstimmung mit den jeweiligen Nutzungsbedingungen ihrer Anbieter zu beziehen und zu integrieren.

Beste Alternativwerkzeuge zu "LlamaChat"

Private LLM ist ein lokaler KI-Chatbot für iOS und macOS, der offline funktioniert und Ihre Informationen vollständig auf dem Gerät, sicher und privat hält. Genießen Sie unzensierte Chats auf Ihrem iPhone, iPad und Mac.

120 AI Chat bietet KI-gestützte native Apps mit blitzschneller Leistung von bis zu 120FPS. Es unterstützt mehrere KI-Modelle und bietet Funktionen wie Multi-Threading und eine für Entwickler optimierte Oberfläche.

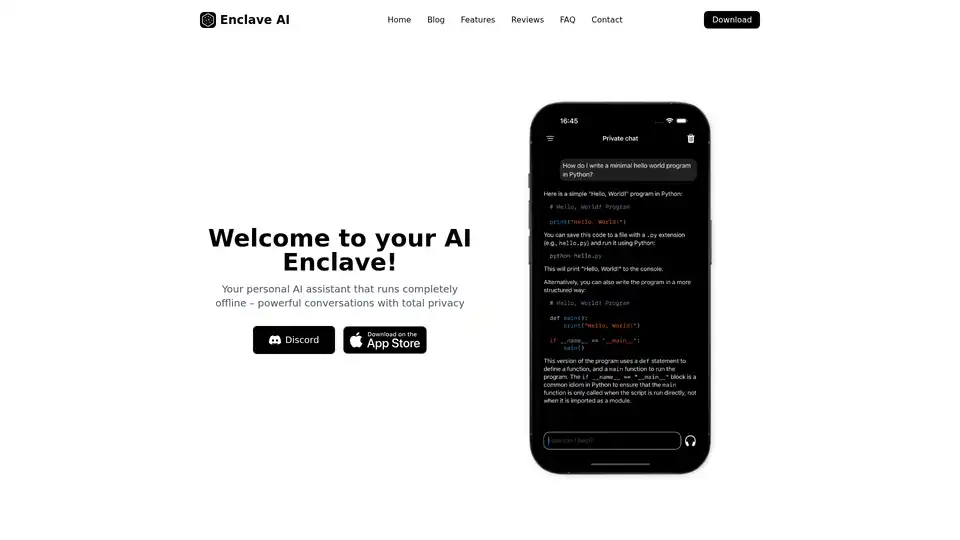

Enclave AI ist ein datenschutzorientierter KI-Assistent für iOS und macOS, der vollständig offline läuft. Er bietet lokale LLM-Verarbeitung, sichere Konversationen, Voice-Chat und Dokumenteninteraktion, ohne dass eine Internetverbindung erforderlich ist.

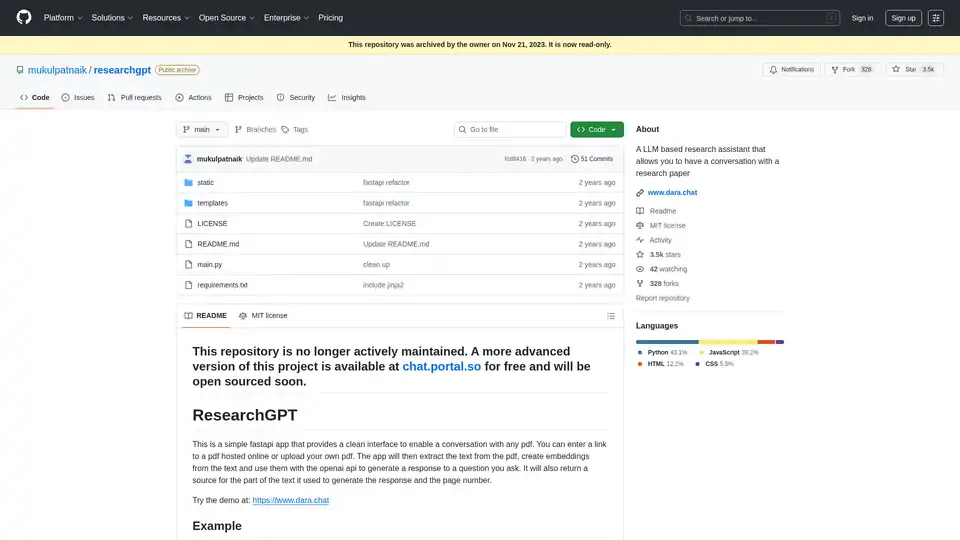

ResearchGPT ist ein Forschungsassistent, mit dem Sie sich mit Forschungsarbeiten unterhalten können. Es verwendet LLM und bietet eine übersichtliche Oberfläche zum Chatten mit jedem PDF.

Wandeln Sie Ihren Workflow mit BrainSoup um! Erstellen Sie benutzerdefinierte KI-Agenten, um Aufgaben zu handhaben und Prozesse durch natürliche Sprache zu automatisieren. Verbessern Sie KI mit Ihren Daten, während Sie Datenschutz und Sicherheit priorisieren.

Nutzen Sie Faune, um im Internet zu suchen, Bilder zu generieren und mit den weltweit führenden LLMs von OpenAI, Anthropic, Cohere.ai, MistralAI und mehr zu interagieren.

Remind AI ist ein Open-Source-Tool für lokales künstliches Gedächtnis, das Ihre digitalen Aktivitäten mit fortschrittlicher KI erfasst und die Produktivität ohne Cloud-Abhängigkeit steigert. Laden Sie es herunter und passen Sie es für den persönlichen Gebrauch an.

Essential ist eine Open-Source-MacOS-App, die als KI-Co-Pilot für Ihren Bildschirm dient, Entwicklern hilft, Fehler sofort zu beheben und wichtige Workflows mit Zusammenfassungen und Screenshots zu merken—keine Daten verlassen das Gerät.

GrammarBot ist eine KI-gestützte Grammatik- und Rechtschreibprüfung für MacOS, die offline funktioniert. Laden Sie die App und das KI-Modell einmal herunter und verbessern Sie Ihr Englisch für immer. Persönliche Lizenz $12.

AnythingLLM ist eine All-in-One-KI-Anwendung, mit der Sie mit Ihren Dokumenten chatten, Ihre Produktivität steigern und hochmoderne LLMs lokal und privat ausführen können. Nutzen Sie KI-Agenten und benutzerdefinierte Modelle ohne Einrichtung.

Warp ist eine KI-Agentenplattform, mit der Sie mehrere Agenten parallel ausführen können, um jede Entwicklungsaufgabe zu erledigen, und bietet einen Codierungs- und Terminalagenten, der Ihre Leistung verdoppelt.

LM Studio: Führen Sie LLaMa, MPT, Gemma und andere LLMs lokal auf Ihrem Laptop aus. Laden Sie kompatible Modelle von Hugging Face herunter und verwenden Sie sie offline.

RecurseChat: Eine persönliche KI-App, mit der Sie mit lokaler KI sprechen können, offline-fähig und mit PDF- und Markdown-Dateien chatten können.

MacCopilot: Native Copilot AI für macOS. Interagiere mit Bildschirminhalten mit GPT-4o, ClaudeAI und Google Gemini.