LM Studio

Übersicht von LM Studio

Was ist LM Studio? Lokale große Sprachmodelle freischalten

LM Studio ist eine bahnbrechende Desktop-Anwendung, die entwickelt wurde, um den Zugang zu modernster künstlicher Intelligenz, insbesondere großen Sprachmodellen (LLMs), zu demokratisieren. Es dient als umfassende Plattform, die es Benutzern ermöglicht, mühelos eine breite Palette von Open-Source-LLMs direkt auf ihren PCs zu erkunden, herunterzuladen und vollständig offline auszuführen. Dieses revolutionäre Tool macht fortschrittliche AI-Technologie für jedermann zugänglicher und handhabbarer, unabhängig von deren Programmierkenntnissen.

Im Kern zielt LM Studio darauf ab, den oft komplexen Prozess der Interaktion mit leistungsstarken AI-Modellen zu vereinfachen. Indem es LLMs auf Ihre lokale Maschine bringt, ermöglicht es Benutzern, die Funktionen von Modellen wie LLaMa 2, MPT, Gemma, Falcon, Mistral und StarCoder von Hugging Face zu nutzen, alles in einer sicheren und privaten Umgebung. Ob Sie ein AI-Enthusiast, ein Entwickler oder einfach nur neugierig auf das Potenzial generativer AI sind, LM Studio bietet einen intuitiven Zugang zur Welt der lokalen LLMs.

Hauptmerkmale von LM Studio: Ihre lokale AI-Reise stärken

LM Studio ist vollgepackt mit Funktionen, die ein nahtloses und leistungsstarkes lokales AI-Erlebnis bieten sollen. Hier ist ein genauerer Blick darauf, was diese Plattform auszeichnet:

Offline-LLM-Ausführung für verbesserte Privatsphäre und Geschwindigkeit

Einer der überzeugendsten Vorteile von LM Studio ist seine Fähigkeit, große Sprachmodelle vollständig offline auszuführen. Das bedeutet, dass alle Ihre Interaktionen mit der AI auf Ihrem lokalen Rechner stattfinden, ohne dass eine Internetverbindung erforderlich ist, um Daten an externe Server zu senden. Diese Funktion ist entscheidend für:

- Unübertroffene Datenprivatsphäre und -sicherheit: Sensible Informationen verlassen Ihr Gerät niemals, was es ideal für vertrauliche Projekte, den persönlichen Gebrauch oder Umgebungen mit strengen Datenschutzanforderungen macht.

- Reduzierte Latenz und schnellere Antworten: Durch die Eliminierung von Netzwerkverzögerungen können Sie nahezu sofortige Antworten von den LLMs erhalten, was zu einer viel flüssigeren und effizienteren Benutzererfahrung führt.

- Zuverlässige Zugänglichkeit: Ihre AI-Modelle sind immer verfügbar, auch in Bereichen mit schlechter oder keiner Internetverbindung, was einen ununterbrochenen Workflow gewährleistet.

Intuitive In-App-Chat-UI: Sofortige Interaktion mit AI

LM Studio bietet eine benutzerfreundliche Chat-Oberfläche, die direkt in die Anwendung integriert ist. Diese intuitive UI ermöglicht es Ihnen, mit Ihren ausgewählten LLMs in einer konversationellen Weise zu interagieren, ähnlich wie bei beliebten Online-AI-Chatbots. Diese Funktion ist perfekt für:

- Direkte Interaktion: Stellen Sie einfach Fragen, generieren Sie Text, fassen Sie Dokumente zusammen oder brainstormen Sie Ideen mit dem lokal ausgeführten AI-Modell.

- Experimente: Testen Sie schnell verschiedene Prompts und beobachten Sie das Modellverhalten ohne komplexe Einrichtung oder Codierung.

- Benutzerfreundlichkeit: Auch Personen ohne Programmierkenntnisse können bequem mit leistungsstarken AI-Modellen interagieren und diese nutzen.

OpenAI-kompatibler lokaler Server: Lokale AI mit bestehenden Workflows verbinden

Für Entwickler und diejenigen, die lokale LLMs in ihre eigenen Anwendungen integrieren möchten, bietet LM Studio einen OpenAI-kompatiblen lokalen Server. Diese entscheidende Funktion bedeutet, dass Ihre lokal ausgeführten LLMs über einen API-Endpunkt zugänglich sind, der die Struktur und das Verhalten der OpenAI API nachahmt. Dies eröffnet eine Welt von Möglichkeiten:

- Nahtlose Integration: Bestehende Anwendungen oder Skripte, die für die Zusammenarbeit mit der OpenAI API entwickelt wurden, können einfach neu konfiguriert werden, um mit Ihrem lokalen LM Studio-Server zu kommunizieren, was erhebliche Entwicklungszeit spart.

- Flexible Entwicklungsumgebung: Testen und entwickeln Sie AI-gestützte Funktionen offline, wodurch die Abhängigkeit von Cloud-Diensten und die damit verbundenen Kosten während der Entwicklungsphase reduziert werden.

- Anpassbare Bereitstellungen: Passen Sie Ihre AI-Lösungen mit spezifischen Modellen und Konfigurationen an, während Sie die lokale Kontrolle behalten.

Nahtloser Modelldownload aus Hugging Face Repositories

LM Studio vereinfacht den Prozess der Beschaffung von LLMs, indem es Benutzern ermöglicht, kompatible Modelldateien direkt aus Hugging Face Repositories innerhalb der App herunterzuladen. Hugging Face ist eine führende Plattform für Machine-Learning-Modelle, und LM Studio bietet Zugang zu einer riesigen und wachsenden Bibliothek, einschließlich:

- Populäre Architekturen: LLaMa 2, MPT, Gemma, Falcon, Mistral, StarCoder und viele mehr.

- Versionskontrolle und Updates: Finden und laden Sie einfach verschiedene Versionen oder optimierte Varianten von Modellen herunter.

- Vereinfachte Modellverwaltung: Keine Notwendigkeit, komplexe Dateisysteme oder Kommandozeilen-Schnittstellen zu navigieren; alles wird über die Oberfläche von LM Studio abgewickelt.

Neue AI-Modelle entdecken und erkunden

Es ist entscheidend, mit der sich schnell entwickelnden AI-Landschaft auf dem Laufenden zu bleiben. LM Studio enthält eine Entdeckungsfunktion auf seiner Startseite, die neue und bemerkenswerte LLMs präsentiert. Dies hilft Benutzern:

- Informiert bleiben: Bleiben Sie über die neuesten Fortschritte und Veröffentlichungen in der Open-Source-LLM-Community auf dem Laufenden.

- Fähigkeiten erweitern: Finden und experimentieren Sie einfach mit neuen Modellen, die einzigartige Fähigkeiten oder eine verbesserte Leistung für bestimmte Aufgaben bieten könnten.

So verwenden Sie LM Studio: Ihr Leitfaden zur lokalen AI-Beherrschung

Der Einstieg in LM Studio ist unkompliziert und auch für Anfänger zugänglich. Der Prozess umfasst typischerweise:

Erste Schritte: Installation und Einrichtung

LM Studio ist als native Anwendung für gängige Betriebssysteme verfügbar und gewährleistet eine breite Kompatibilität:

- Mac: Optimierte Versionen für M1/M2/M3 Apple Silicon Chips.

- Windows: Volle Unterstützung für Windows-Umgebungen.

- Linux (Beta): Eine Beta-Version ist für Linux-Benutzer verfügbar, was die kontinuierliche Entwicklung und breitere Reichweite demonstriert.

Laden Sie einfach den entsprechenden Installer von der offiziellen LM Studio-Website herunter und folgen Sie den Anweisungen auf dem Bildschirm. Die Installation ist benutzerfreundlich gestaltet und erfordert keine komplexen Konfigurationen oder Programmierkenntnisse.

Ihr erstes LLM auswählen und ausführen

Nach der Installation führt Sie die intuitive Oberfläche durch das Entdecken und Ausführen von Modellen:

- Durchsuchen und Entdecken: Navigieren Sie zur Startseite der App, um ein Modell zu finden, das Ihren Anforderungen entspricht, oder erkunden Sie den Hugging Face Repository-Bereich.

- Herunterladen: Laden Sie mit einem einzigen Klick die gewünschte kompatible Modelldatei direkt auf Ihren Computer herunter.

- Laden und Chatten: Wählen Sie das heruntergeladene Modell aus und interagieren Sie damit über die In-App-Chat-UI oder stellen Sie über den lokalen OpenAI-kompatiblen Server eine Verbindung von Ihren benutzerdefinierten Anwendungen her.

Wer kann von LM Studio profitieren?

LM Studio richtet sich an eine vielfältige Benutzergruppe und macht fortschrittliche AI-Funktionen einem breiteren Publikum zugänglich.

AI-Enthusiasten und Lernende

Für Neueinsteiger in die Welt der großen Sprachmodelle bietet LM Studio eine perfekte Sandbox. Es ermöglicht Ihnen, mit AI zu experimentieren, ohne teure Cloud-Computing-Dienste oder tiefgreifendes technisches Fachwissen zu benötigen. Lernen Sie, wie LLMs funktionieren, verstehen Sie deren Ausgaben und erkunden Sie ihr Potenzial in einer sicheren, kontrollierten und kostenlosen lokalen Umgebung.

Entwickler und Forscher

Entwickler können LM Studio nutzen, um AI-gestützte Anwendungen effizient zu erstellen und zu testen. Der OpenAI-kompatible lokale Server ist ein Game-Changer für schnelles Prototyping, das Offline-Entwicklung und -Iteration ermöglicht. Forscher können es verwenden, um verschiedene Modellarchitekturen zu erkunden, Hypothesen zu testen und Experimente mit bestimmten LLMs durchzuführen, wobei Datenprivatsphäre und volle Kontrolle über die Umgebung gewährleistet sind.

Datenschutzbewusste Einzelpersonen und Unternehmen

In einer Ära, in der Datenschutz an erster Stelle steht, bietet LM Studio eine robuste Lösung. Durch das vollständige Offline-Ausführen von LLMs können Benutzer sensible Informationen verarbeiten und Inhalte generieren, ohne sich Sorgen machen zu müssen, dass Daten an Drittanbieter-Server übertragen werden. Dies macht es zu einem unschätzbaren Werkzeug für juristische, medizinische, finanzielle oder andere stark regulierte Branchen, in denen Datenvertraulichkeit entscheidend ist.

Content-Ersteller und Autoren

Ob Sie kreative Geschichten generieren, Marketingtexte entwerfen, Forschungsarbeiten zusammenfassen oder Inspiration suchen – LLMs können leistungsstarke Assistenten sein. Mit LM Studio können Autoren diese Tools lokal nutzen, um sicherzustellen, dass ihr kreativer Prozess privat bleibt und ihre generierten Inhalte sicher sind.

Der praktische Wert von LM Studio in der heutigen AI-Landschaft

Die Wahl von LM Studio bietet deutliche Vorteile, die gängige Herausforderungen im AI-Ökosystem angehen.

Kosteneffizienz und Ressourcenoptimierung

Das lokale Ausführen von LLMs über LM Studio reduziert oder eliminiert die wiederkehrenden Kosten, die mit Cloud-basierten AI-Diensten und API-Aufrufen verbunden sind, erheblich. Durch die Nutzung Ihrer vorhandenen Hardware können Sie AI äußerst wirtschaftlich gestalten, insbesondere für häufige oder intensive Anwendungsfälle. Dies ist besonders vorteilhaft für Studenten, Hobbyisten und kleine Unternehmen, die AI ohne erhebliche Betriebskosten nutzen möchten.

Geschwindigkeit und Leistung

Die lokale Ausführung bedeutet, dass Daten minimale Entfernungen zurücklegen, was zu einer deutlich geringeren Latenz im Vergleich zur Interaktion mit entfernten Cloud-APIs führt. Dies führt zu einer schnelleren Abfrageverarbeitung und schnelleren Antworten, was die Produktivität und Benutzererfahrung verbessert, insbesondere für Echtzeitanwendungen oder interaktive Workflows.

Anpassung und Kontrolle

LM Studio gewährt Benutzern eine beispiellose Kontrolle über ihre AI-Umgebung. Sie können mit verschiedenen Modellquantisierungsstufen experimentieren, Parameter anpassen und Konfigurationen feinabstimmen, um optimale Leistung und gewünschte Ausgaben zu erzielen. Dieses Maß an Anpassung ist mit Black-Box-Cloud-API-Lösungen oft schwierig oder unmöglich zu erreichen, was wirklich maßgeschneiderte AI-Erlebnisse ermöglicht.

Häufig gestellte Fragen zu LM Studio

Um Ihnen zu helfen, LM Studio besser zu verstehen, finden Sie hier Antworten auf einige häufige Fragen:

Was ist LM Studio?

LM Studio ist eine benutzerfreundliche Desktop-Softwareanwendung, die den Prozess des Erkundens, Herunterladens und Ausführens verschiedener Open-Source-LLMs direkt auf Ihrem Computer vereinfacht und eine intuitive Oberfläche sowohl für technische als auch für nicht-technische Benutzer bietet.

Benötige ich Programmierkenntnisse, um LM Studio zu verwenden?

Nein, Sie benötigen keine Programmierkenntnisse. LM Studio ist mit einer intuitiven Benutzeroberfläche ausgestattet, die es jedem zugänglich macht und Benutzern ermöglicht, mit leistungsstarken AI-Modellen zu interagieren, ohne eine einzige Zeile Code schreiben zu müssen.

Kann ich mehrere AI-Modelle gleichzeitig mit LM Studio ausführen?

Die auf dieser Seite bereitgestellten Informationen geben keine expliziten Details über die Fähigkeit an, mehrere AI-Modelle gleichzeitig in LM Studio auszuführen. Benutzer, die an dieser spezifischen Funktionalität interessiert sind, sollten die offizielle LM Studio-Dokumentation oder Community-Foren für die aktuellsten und detailliertesten Informationen konsultieren.

Ist LM Studio kostenlos nutzbar?

Der bereitgestellte Text gibt nicht explizit an, ob LM Studio kostenlos nutzbar ist. Für genaue Informationen bezüglich Lizenzierung, Preisen und verfügbaren Editionen verweisen wir auf die offizielle LM Studio-Website.

Wie stellt LM Studio sicher, dass mein Computer ein AI-Modell verarbeiten kann?

Während der Quellinhalt keine spezifischen Mechanismen detailliert, die LM Studio für Hardware-Kompatibilitätsprüfungen verwendet, ist allgemein bekannt, dass das lokale Ausführen von LLMs angemessene Systemressourcen (RAM, CPU, GPU) erfordert. Benutzern wird dringend empfohlen, die offizielle Dokumentation von LM Studio für detaillierte Mindestanforderungen an die Hardware und Best Practices zu konsultieren, um optimale Leistung mit verschiedenen AI-Modellen zu gewährleisten.

Kann ich LM Studio für kommerzielle Zwecke verwenden?

Der bereitgestellte Text behandelt die Bedingungen für die kommerzielle Nutzung von LM Studio nicht. Wenn Sie LM Studio für kommerzielle Projekte oder Anwendungen verwenden möchten, ist es entscheidend, die offiziellen Lizenzvereinbarungen und Nutzungsbedingungen auf der LM Studio-Website zu überprüfen, um die Einhaltung sicherzustellen.

Beste Alternativwerkzeuge zu "LM Studio"

AI Runner ist eine Offline-KI-Inferenz-Engine für Kunst, Echtzeit-Sprachkonversationen, LLM-gestützte Chatbots und automatisierte Arbeitsabläufe. Führen Sie Bilderzeugung, Voice-Chat und mehr lokal aus!

Enclave AI ist ein datenschutzorientierter KI-Assistent für iOS und macOS, der vollständig offline läuft. Er bietet lokale LLM-Verarbeitung, sichere Konversationen, Voice-Chat und Dokumenteninteraktion, ohne dass eine Internetverbindung erforderlich ist.

GrammarBot ist eine KI-gestützte Grammatik- und Rechtschreibprüfung für MacOS, die offline funktioniert. Laden Sie die App und das KI-Modell einmal herunter und verbessern Sie Ihr Englisch für immer. Persönliche Lizenz $12.

Jan ist ein Open-Source-KI-Client, der in erster Linie offline funktioniert. Führen Sie Large Language Models (LLMs) lokal mit Datenschutz und ohne API-Gebühren aus. Verbinden Sie sich mit verschiedenen Modellen und Diensten.

RecurseChat: Eine persönliche KI-App, mit der Sie mit lokaler KI sprechen können, offline-fähig und mit PDF- und Markdown-Dateien chatten können.

Ncurator ist eine Browsererweiterung, die KI verwendet, um Ihnen bei der Verwaltung und Analyse Ihrer Wissensdatenbank zu helfen. Es kann Antworten für Sie finden und organisieren.

Dot ist ein lokales, Offline-KI-Chat-Tool, das von Mistral 7B unterstützt wird und es Ihnen ermöglicht, mit Dokumenten zu chatten, ohne Ihre Daten zu senden. Kostenlos und datenschutzorientiert.

Roo Code ist ein Open-Source-KI-gestützter Coding-Assistent für VS Code mit KI-Agenten für Multi-Datei-Bearbeitung, Debugging und Architektur. Es unterstützt verschiedene Modelle, gewährleistet Datenschutz und passt sich Ihrem Workflow für effiziente Entwicklung an.

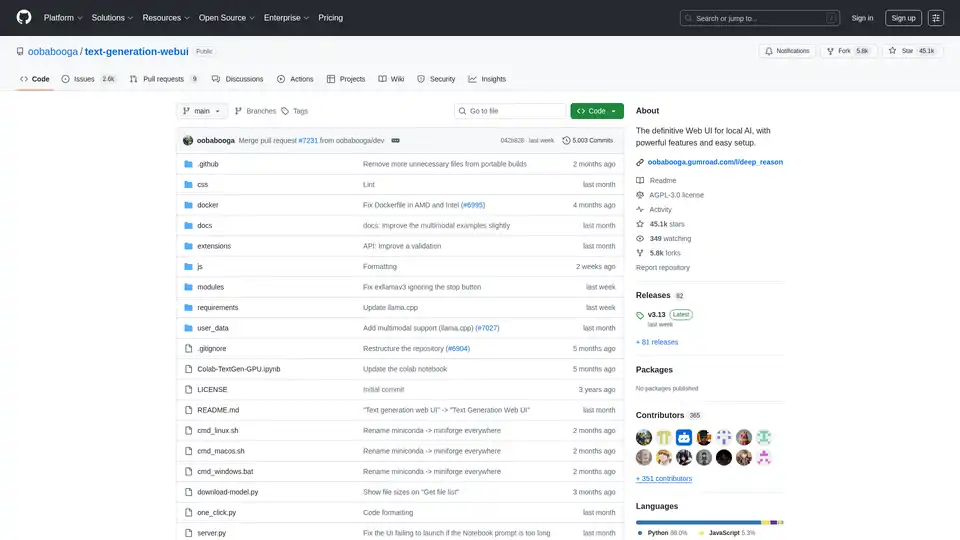

Text Generation Web UI ist eine leistungsstarke, benutzerfreundliche Gradio-Weboberfläche für lokale KI-basierte große Sprachmodelle. Unterstützt mehrere Backends, Erweiterungen und bietet Offline-Privatsphäre.

ProxyAI ist ein KI-Copilot für JetBrains IDEs, der Funktionen wie Codevervollständigung, Bearbeitung in natürlicher Sprache und Integration mit führenden LLMs bietet. Es unterstützt die Offline-Entwicklung und verschiedene Modelle über API-Schlüssel.

OpenUI ist ein Open-Source-Tool, das es Ihnen ermöglicht, UI-Komponenten in natürlicher Sprache zu beschreiben und sie live mit LLMs zu rendern. Konvertieren Sie Beschreibungen in HTML, React oder Svelte für schnelles Prototyping.

Mit VerbaGPT können Sie Daten mithilfe natürlicher Sprache analysieren, LLMs nutzen und gleichzeitig den Datenschutz gewährleisten. Stellen Sie Fragen zu SQL-Daten, CSVs oder Notizen und erhalten Sie Antworten.

Private LLM ist ein lokaler KI-Chatbot für iOS und macOS, der offline funktioniert und Ihre Informationen vollständig auf dem Gerät, sicher und privat hält. Genießen Sie unzensierte Chats auf Ihrem iPhone, iPad und Mac.

NativeMind ist eine open-source Chrome-Erweiterung, die lokale LLMs wie Ollama ausführt und eine vollständig offline, private ChatGPT-Alternative bietet. Funktionen: kontextbewusster Chat, Agentenmodus, PDF-Analyse, Schreibtools und Übersetzung – alles 100% auf dem Gerät ohne Cloud.