llmarena.ai

Übersicht von llmarena.ai

Was ist llmarena.ai?

llmarena.ai ist eine leistungsstarke Online-Plattform, die den Prozess des Vergleichs großer Sprachmodelle (LLMs) von verschiedenen KI-Anbietern vereinfacht. Früher bekannt als countless.dev, hat sie sich zu einem smarteren, effizienteren Tool für die Weiterleitung und Optimierung der KI-Nutzung entwickelt, während die Kosten im Griff bleiben. Ob Entwickler, Forscher oder Geschäftsfachmann – llmarena.ai bringt Modelle von führenden Anbietern wie OpenAI, Anthropic, Google, xAI, DeepSeek, Qwen und anderen in einem zentralen Hub zusammen. So wird es einfacher denn je, Optionen basierend auf Schlüsselschlüssel wie Preisen, Kontextfenstern, Ausgabefähigkeiten und Modalitäten zu bewerten, und hilft Nutzern, informierte Entscheidungen zu treffen, ohne zerstreute Dokumentationen durchsuchen zu müssen.

Im Kern adressiert llmarena.ai ein häufiges Problem im rasch expandierenden KI-Landschaft: die Komplexität der Wahl des richtigen LLM. Mit schnell fortschreitenden KI-Modellen aktualisieren Anbieter häufig Features und Preise, was Vergleiche zu einer zeitaufwändigen Aufgabe macht. Dieses Tool vereinfacht das, indem es Echtzeit-Einblicke in die Modellleistung bietet und sicherstellt, dass Sie die kosteneffektivste und passendste Option für Ihre spezifischen Bedürfnisse wählen – sei es für Programmieraufgaben, Inhaltsgenerierung oder Datenanalyse.

Wie funktioniert llmarena.ai?

Die Plattform arbeitet als intuitive webbasierte Vergleichssoftware, die Daten direkt von Anbietern zieht, um aktuelle Informationen anzuzeigen. Nutzer können auf mehrere Schlüsselbereiche zugreifen, einschließlich eines Preisrechners, eines Versus-Vergleichs-Tools und kategorisierten Modellerkundungen wie Programming, Roleplay, Marketing, Technology, Science, Translation, Legal, Finance, Health, Trivia, Academia, Multimodal und Long Context Models.

Hier eine Aufschlüsselung der primären Funktionen:

- Modelle-Auflistungen und Spezifikationen: Die Haupttabelle kategorisiert Modelle nach Anbieter und hebt wesentliche Specs hervor. Zum Beispiel zeigt sie Modalitäten (hauptsächlich Text oder 'T'), Kontextfenster (z. B. bis zu 2.000.000 Tokens für xAI's Grok 4 Fast), maximale Ausgabetokens und Preise pro Million Tokens für Prompts und Vervollständigungen. Das ermöglicht eine schnelle Übersicht der Fähigkeiten – wie Anthropic's Claude Sonnet 4 mit einem massiven 1.000.000-Token-Kontextfenster zu $3/$15 pro Million Tokens.

- Preisrechner: Ein interaktives Tool, in dem Nutzer ihre Nutzungsszenarien eingeben (z. B. Eingabe/Ausgabe-Token-Volumen), um Kosten über Modelle hinweg zu schätzen. Das ist unschätzbar für Budgetplanung, besonders beim Vergleich budgetfreundlicher Optionen wie Google's Gemma 3 12B ($0.04/$0.14) mit Premium-Modellen wie Anthropic's Claude Opus 4.1 ($15/$75).

- Versus-Vergleich: Seit-an-Seit-Bewertungen von zwei oder mehr Modellen, mit Fokus auf Features wie Eingabe-Kontextflexibilität (Any) und maximale Ausgabelimits. Es ist ideal für direkte Duelle, wie OpenAI's GPT-5 (400.000 Kontext, $1.25/$10) gegen Google's Gemini 2.5 Pro (1.048.576 Kontext, $1.25/$10).

- Kategorisierte Anwendungsfälle: Modelle sind für spezifische Domänen getaggt, um Nutzern zu helfen, relevante Anwendungen zu filtern. Zum Beispiel unter Programming könnten Sie xAI's Grok Code Fast 1 oder OpenAI's GPT-5 Codex erkunden, beide optimiert für Code-Generierung mit wettbewerbsfähigen Preisen.

Die Plattform betont 'smarter routing' – schlägt optimale Modelle basierend auf Ihrer Aufgabe vor – und priorisiert 'günstigere KI' durch transparente Kostenaufschlüsselungen. Alle Daten werden in einem sauberen, tabellarischen Format für leichte Lesbarkeit präsentiert, ohne manuelle Berechnungen.

Wichtige Features und Modell-Highlights

llmarena.ai zeichnet sich durch umfassende Abdeckung führender LLMs aus. Hier ein Snapshot einiger vorgestellter Modelle:

| Anbieter | Modell | Kontextfenster | Max. Ausgabetokens | Prompt $/1M | Vervollständigung $/1M |

|---|---|---|---|---|---|

| xAI | Grok Code Fast 1 | 256.000 | 10.000 | $0.2 | $1.5 |

| Anthropic | Claude Sonnet 4 | 1.000.000 | 64.000 | $3 | $15 |

| OpenAI | GPT-5 | 400.000 | 128.000 | $1.25 | $10 |

| Gemini 2.5 Flash | 1.048.576 | 65.535 | $0.3 | $2.5 | |

| DeepSeek | DeepSeek V3.1 | 163.840 | 163.840 | $0.2 | $0.8 |

| Qwen | Qwen3 Coder 480B A35B | 262.144 | 262.144 | $0.22 | $0.95 |

Diese Beispiele illustrieren die Vielfalt: Budget-Modelle wie OpenAI's gpt-oss-20b ($0.03/$0.15) für leichte Aufgaben oder hochkapazitive wie xAI's Grok 4 Fast für umfangreiche Kontexte. Features wie multimodale Unterstützung (obwohl hier hauptsächlich textbasiert) und Lang-Kontext-Handhabung bedienen fortgeschrittene Anwendungsfälle, wie die Verarbeitung großer Dokumente in rechtlichen oder akademischen Kontexten.

Das Tool unterstützt auch flexible Eingaben (Any) und Ausgaben, was es anpassbar für alles macht, von schnellen Trivia-Fragen bis hin zu tiefgehender wissenschaftlicher Analyse.

Anwendungsszenarien und praktischer Wert

llmarena.ai glänzt in Szenarien, in denen die Modellauswahl Effizienz und Ausgaben beeinflusst:

- Entwickler und Coder: Nutzen Sie die Programming-Kategorie, um code-fokussierte Modelle wie Qwen3 Coder Plus oder OpenAI's GPT-5 Codex zu vergleichen. Berechnen Sie schnell Kosten für iterative Coding-Sitzungen und sparen Sie API-Aufrufe.

- Content-Creator und Marketer: Für Marketing- oder Roleplay-Aufgaben bewerten Sie Modelle wie Claude 3.7 Sonnet für kreatives Schreiben und sorgen für hochwertige Ausgaben ohne Überausgaben.

- Forscher und Akademiker: In den Science- oder Academia-Abschnitten wählen Sie Lang-Kontext-Modelle für die Analyse von Papieren oder Datensätzen aus, mit Tools wie Gemini 2.5 Pro, die Millionen-Token-Eingaben handhaben.

- Geschäftsanwendungen: Finance-, Legal- und Health-Kategorien helfen Profis, konforme, kosteneffektive Modelle zu wählen – z. B. GLM 4.5 Air für günstige Übersetzungen in mehrsprachigen Operationen.

- Allgemeine KI-Experimente: Die Trivia- oder Multimodal-Filter erlauben Gelegenheitsnutzern, vielfältige Fähigkeiten zu testen, von lustigen Prompts bis zu komplexen multimodalen Integrationen.

Der praktische Wert liegt in seiner zeitsparenden Aggregation: Statt mehrere Anbieterseiten (OpenAI, Anthropic, Google usw.) zu besuchen, ist alles an einem Ort. Nutzer können Vendor-Lock-in vermeiden, indem sie Alternativen entdecken – z. B. den Wechsel von teurem Claude Opus zu günstigerem DeepSeek V3.1 für ähnliche Leistung. Für Teams hilft der Preisrechner bei der Prognose von API-Budgets und kann Kosten um 50 % oder mehr senken durch optimierte Wahl.

Für wen ist llmarena.ai?

Dieses Tool ist ideal für:

- KI-Enthusiasten und Hobbyisten: Diejenigen, die mit LLMs auf Budget experimentieren.

- Software-Ingenieure: Die zuverlässige Coding-Assistenten ohne hohe Gebühren brauchen.

- Data Scientists: Modelle für Machine-Learning-Pipelines vergleichen.

- Enterprise-Nutzer: In Finance- oder Legal-Bereichen, die präzise, skalierbare KI benötigen.

- Pädagogen und Studenten: Academia-fokussierte Modelle für Forschung erkunden.

Es eignet sich nicht für diejenigen, die vollständige Modell-Trainingsplattformen suchen, aber perfekt für Deployment- und Auswahlphasen.

Warum llmarena.ai wählen?

In einem überfüllten KI-Markt unterscheidet sich llmarena.ai durch Fokus auf Transparenz und Benutzerfreundlichkeit. Keine Anmeldungen erforderlich für grundlegende Vergleiche, und die Oberfläche ist responsiv für schnelle Mobile-Checks. Regelmäßige Updates stellen sicher, dass Specs die neuesten Releases widerspiegeln, wie aufkommende Modelle von MoonshotAI oder Z.AI. Durch Ermächtigung zu smarterem Routing schneidet es nicht nur Kosten, sondern steigert Produktivität – Nutzer berichten von schnelleren Projektstarts und besserer Ressourcenallokation.

Für die besten Ergebnisse beginnen Sie mit dem Preisrechner für Ihre Workload, dann nutzen Sie Versus für Feinabstimmung. Ob Sie für Geschwindigkeit, Kosten oder Kontextlänge optimieren – llmarena.ai verwandelt LLM-Komplexität in Klarheit und macht fortschrittliche KI für alle zugänglich.

Beste Alternativwerkzeuge zu "llmarena.ai"

Joythee AI ist eine KI-Begleiter-App, die für fesselnde und erhebende Gespräche entwickelt wurde. Sie bietet Funktionen wie Multi-KI-Agenten-Chat, Inkognito-Modus, personalisierte Erlebnisse und kontinuierliche Updates.

ChatOrDie.ai bietet anonymes Chatten mit Top-KI-Modellen wie Grok, ChatGPT, Gemini und Deepseek. Vergleichen Sie Antworten, erkennen Sie Verzerrungen und genießen Sie ungefilterte, private KI-Interaktionen.

Metabob ist ein KI-Code-Review-Tool, das Graph-Attention-Netzwerke und generative KI verwendet, um die Codekomplexität in Legacy- und KI-generierten Softwaresystemen zu adressieren.

Friendli Inference ist die schnellste LLM-Inferenz-Engine, optimiert für Geschwindigkeit und Kosteneffizienz, die GPU-Kosten um 50-90 % senkt und gleichzeitig einen hohen Durchsatz und eine geringe Latenz bietet.

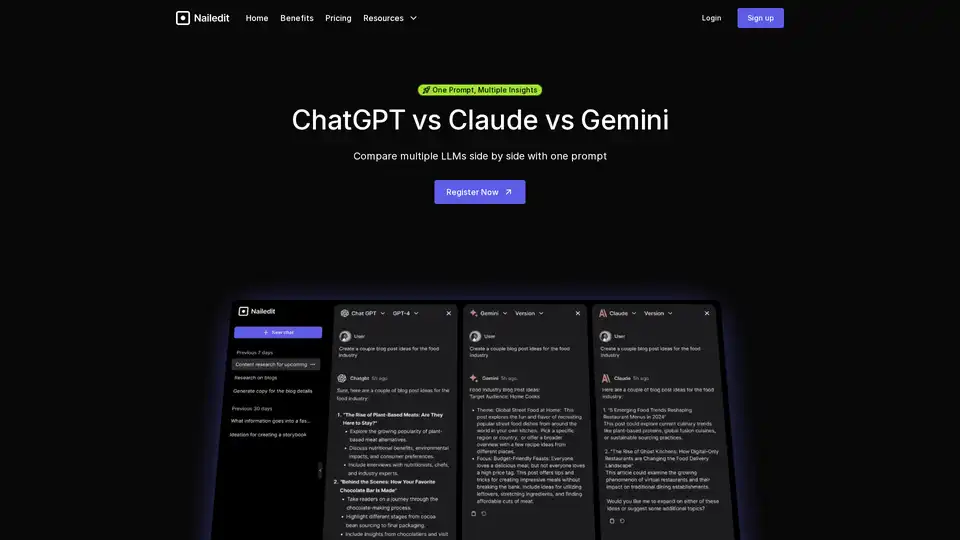

Mit NailedIt können Sie sofort Antworten von ChatGPT, Claude und Gemini vergleichen. Optimieren Sie Ihren Workflow und finden Sie mit einer einzigen Eingabe die besten Erkenntnisse aus mehreren KI-Modellen.

Allganize bietet sichere Enterprise AI-Lösungen mit fortschrittlicher LLM-Technologie, einschließlich agentischem RAG, No-Code AI-Buildern und On-Premise-Bereitstellung für Datenhoheit.

Parea AI ist die ultimative Experimentier- und Human-Annotationsplattform für AI-Teams, die nahtlose LLM-Bewertung, Prompt-Tests und Produktionsbereitstellung für zuverlässige AI-Anwendungen ermöglicht.

Athina ist eine kollaborative AI-Plattform, die Teams dabei hilft, LLM-basierte Funktionen 10-mal schneller zu entwickeln, zu testen und zu überwachen. Mit Tools für Prompt-Management, Evaluierungen und Observability gewährleistet sie Datenschutz und unterstützt benutzerdefinierte Modelle.

Smatr-AI ist eine Browser-Erweiterung, die GPT/LLM integriert, um schnelle Textzusammenfassungen und Antworten zu finden und Informationsüberflutung zu bekämpfen.

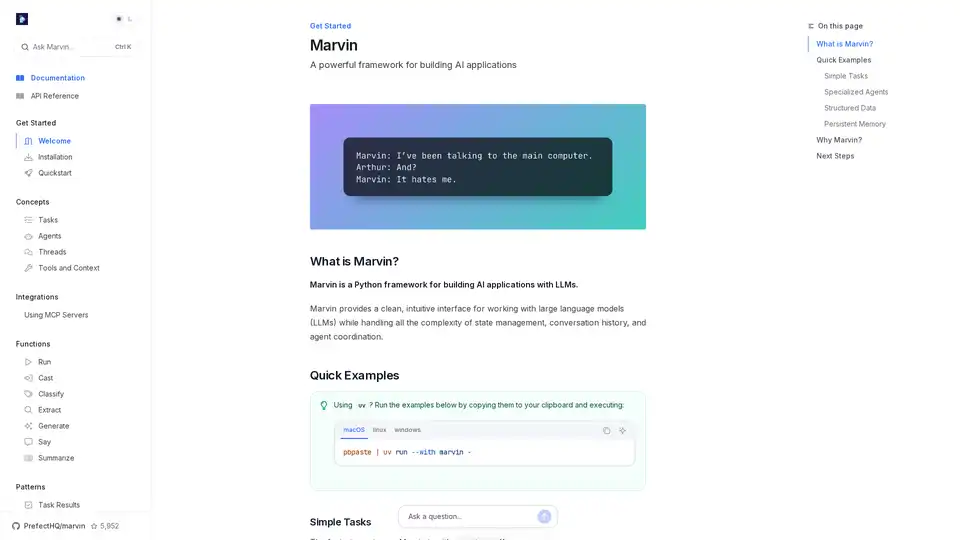

Marvin ist ein leistungsstarkes Python-Framework zum Erstellen von AI-Anwendungen mit Large Language Models (LLM). Es vereinfacht die Zustandsverwaltung, Agenten-Koordination und strukturierte Ausgaben für Entwickler, die intelligente Apps erstellen.

Bolt Foundry bietet Context-Engineering-Tools, um KI-Verhalten vorhersagbar und testbar zu machen, und hilft Ihnen so, vertrauenswürdige LLM-Produkte zu entwickeln. Testen Sie LLMs wie Sie Code testen.

Visor.ai bietet KI-gestützte Kundenservice-Automatisierung unter Verwendung von LLM und generativer KI für intelligentere Konversationen und effiziente Prozessautomatisierung, wodurch die Geschäftseffizienz und Kundenzufriedenheit verbessert werden.

Fusion AI integriert führende KI-Modelle in eine einzige Plattform, vereinfacht die komplexe KI-Landschaft und bietet außergewöhnliche Qualität für Datenanalyse, Berichtserstellung und mehr. Erhalten Sie 5 $ kostenlose Credits, um zu beginnen.

Cabina.AI bietet Zugriff auf GPT-4, Claude, LLama und mehr, alles an einem Ort. Chatten Sie mit PDF, analysieren Sie Dateien, transkribieren Sie Audio, generieren Sie Videos und Bilder. Starten Sie kostenlos!