Parea AI

Übersicht von Parea AI

Was ist Parea AI?

Parea AI zeichnet sich als umfassende Plattform für Experimente und menschliche Annotation aus, die speziell für AI-Teams entwickelt wurde, die an Anwendungen mit großen Sprachmodellen (LLM) arbeiten. Entwickelt, um die Lücke zwischen Entwicklung und Produktion zu schließen, befähigt Parea AI Entwickler, Data Scientists und Product-Teams, ihre AI-Systeme selbstbewusst zu testen, zu bewerten und zu verfeinern. Egal ob Sie neue Features prototypen oder bestehende LLM-Pipelines optimieren, diese Plattform bietet die notwendigen Tools, um Experimente zu verfolgen, menschliches Feedback zu sammeln und die Leistung in Echtzeit zu überwachen. Indem sie sich auf Schlüsselaspekte wie Bewertung, Observability und Deployment konzentriert, hilft Parea AI Teams, produktionsreife LLM-Apps schneller und zuverlässiger zu releasen.

Im Kern adressiert Parea AI gängige Pain Points in der AI-Entwicklung, wie das Debuggen von Fehlern, das Messen von Modellverbesserungen und das Einbinden menschlicher Einsichten in den Prozess. Es ist nicht nur ein Logging-Tool; es ist ein vollwertiges Ökosystem, das nahtlos mit populären LLM-Anbietern und Frameworks integriert ist und für Teams aller Größen zugänglich macht.

Wie funktioniert Parea AI?

Parea AI arbeitet über eine modulare Architektur, die automatisches Tracking, manuelle Überprüfungsmöglichkeiten und fortschrittliche Analysen kombiniert. Hier ist eine Aufschlüsselung ihres Workflows:

Experiment-Tracking und -Bewertung: Beginnen Sie damit, Ihre AI-Experimente zu loggen. Parea AI erstellt automatisch domain-spezifische Bewertungen, die es Ihnen ermöglichen, die Leistung über die Zeit zu testen und zu verfolgen. Zum Beispiel können Sie kritische Fragen beantworten wie „Welche Samples haben sich nach einem Modell-Update verschlechtert?“ oder „Verbessert der Wechsel zu einer neuen LLM-Variante die Genauigkeit?“ Diese Funktion verwendet eingebaute Metriken und benutzerdefinierte Eval-Funktionen, um Verbesserungen oder Regressionen zu quantifizieren und datenbasierte Entscheidungen zu gewährleisten.

Menschliche Überprüfung und Annotation: Menschliche Eingaben sind entscheidend für das Fine-Tuning von LLMs. Parea AI ermöglicht Teams, Feedback von Endnutzern, Fachleuten oder internen Stakeholdern zu sammeln. Sie können Logs kommentieren, Antworten für Qualitätssicherung annotieren und Daten speziell für Q&A-Aufgaben oder Modell-Fine-Tuning labeln. Dieser kollaborative Annotation-Prozess verwandelt rohe Ausgaben in handlungsrelevante Datasets und verbessert die Modellzuverlässigkeit.

Prompt-Playground und Deployment: Experimentieren hört nicht bei Tests auf – der Prompt-Playground von Parea AI lässt Sie mit mehreren Prompt-Variationen auf Sample-Datasets basteln. Testen Sie sie im großen Maßstab, identifizieren Sie Top-Performer und deployen Sie sie direkt in die Produktion. Dieser iterative Ansatz minimiert Risiken, die mit Prompt-Engineering verbunden sind, einem gängigen Engpass in der LLM-Entwicklung.

Observability und Logging: Sobald in der Produktion, behalten Sie die Übersicht mit robusten Observability-Tools. Loggen Sie Daten aus Staging- und Produktionsumgebungen, debuggen Sie Probleme vor Ort und führen Sie Online-Bewertungen durch. Verfolgen Sie essentielle Metriken wie Kosten, Latenz und Ausgabequalität in einem einheitlichen Dashboard. Nutzerfeedback wird nahtlos erfasst und liefert laufende Einblicke in die Leistung in der realen Welt.

Datasets-Management: Parea AI glänzt darin, geloggte Daten in wertvolle Assets zu verwandeln. Integrieren Sie Produktionslogs in Test-Datasets für kontinuierliche Modellverbesserungen. Dieses geschlossene Schleifensystem unterstützt Fine-Tuning und stellt sicher, dass Ihre LLMs sich mit tatsächlichen Nutzungsmustern weiterentwickeln.

Die Einfachheit der Plattform wird durch ihre SDKs verstärkt. Mit Unterstützung für Python und JavaScript/TypeScript ist die Integration unkompliziert. Zum Beispiel können Sie in Python einen OpenAI-Client mit Pareas Tracer umschließen, um LLM-Aufrufe automatisch zu loggen, und dann Funktionen für Bewertungen dekorieren. Ähnlich patcht das TypeScript-SDK OpenAI-Instanzen für müheloses Tracing. Native Integrationen mit Tools wie LangChain, DSPy, Anthropic und LiteLLM bedeuten, dass Sie Parea AI in Ihren bestehenden Stack einbinden können, ohne große Umstellungen.

Kernfunktionen von Parea AI

Parea AI überzeugt mit Funktionen, die den gesamten Lebenszyklus von LLM-Anwendungen abdecken:

Automatisch erstellte domain-spezifische Evals: Kein Bedarf, Bewertungssuites von Grund auf zu bauen. Parea AI generiert maßgeschneiderte Evals basierend auf Ihrer Domain, spart Zeit und gewährleistet Relevanz.

Leistungs-Tracking: Überwachen Sie Metriken über die Zeit, um Trends, Regressionen oder Gewinne zu erkennen. Debuggen Sie Fehlschläge mit detaillierten Logs und Visualisierungen.

Kollaboratives menschliches Feedback: Vereinfachen Sie Annotation-Workflows für Teams, mit Optionen für Labeling und Kommentieren, die direkt in das Modelltraining einfließen.

Skalierbares Prompt-Testing: Der Playground unterstützt große Datasets und ermöglicht A/B-Tests von Prompts vor dem Deployment.

Einheitliches Observability-Dashboard: Zentralisieren Sie Logs, Kosten, Latenz und Qualitätsscores. Führen Sie Evals in der Produktion durch, ohne Services zu stören.

Einfache Dataset-Erstellung: Verwandeln Sie reale Logs in Fine-Tuning-Datasets und schließen Sie die Feedback-Schleife für bessere Modelle.

Diese Funktionen werden durch vertrauenswürdige Integrationen mit großen LLM-Anbietern unterstützt und gewährleisten Kompatibilität mit OpenAI, Anthropic und Frameworks wie LangChain. Für Teams, die mehr brauchen, bietet Parea AI AI-Beratungsdienste für schnelles Prototyping, RAG-Optimierung und LLM-Weiterbildung.

Wie man Parea AI verwendet: Ein Schritt-für-Schritt-Leitfaden

Der Einstieg in Parea AI ist unkompliziert, besonders mit dem kostenlosen Builder-Plan. So integrieren und nutzen Sie es:

Anmelden und Setup: Erstellen Sie ein Konto auf der Parea AI-Website – keine Kreditkarte für den Free-Tier nötig. Generieren Sie einen API-Key und installieren Sie das SDK via pip (Python) oder npm (JS/TS).

Code integrieren: Verwenden Sie das SDK, um LLM-Aufrufe zu tracen. Für Python:

from openai import OpenAI from parea import Parea, trace client = OpenAI() p = Parea(api_key="YOUR_PAREA_API_KEY") p.wrap_openai_client(client) @trace(eval_funcs=[your_eval_function]) def your_llm_function(input): return client.chat.completions.create(...)Dies loggt und bewertet Aufrufe automatisch.

Experimente ausführen: Verwenden Sie

p.experiment(), um Datasets zu testen. Definieren Sie Eval-Funktionen, um Ausgaben gegen Ground Truth oder benutzerdefinierte Kriterien zu bewerten.Annotieren und Überprüfen: Laden Sie Teammitglieder zur Plattform ein für menschliche Reviews. Weisen Sie Logs für Annotation zu, verfolgen Sie Fortschritt und exportieren Sie gelabelte Daten.

Deployen und Überwachen: Wählen Sie gewinnende Prompts aus dem Playground und deployen Sie sie. Nutzen Sie Observability-Tools, um Produktionsmetriken zu beobachten.

Für fortgeschrittene Nutzer erkunden Sie die Docs für benutzerdefinierte Integrationen oder On-Prem-Deployment im Enterprise-Plan.

Warum Parea AI gegenüber anderen Tools wählen?

In einer überfüllten AI-Tooling-Landschaft differenziert sich Parea AI durch seinen End-to-End-Fokus auf LLM-Experimente. Im Gegensatz zu einfachen Logging-Tools kombiniert es Bewertung, menschliche Annotation und Observability in einer Plattform und reduziert Tool-Sprawl. Teams bei führenden Unternehmen vertrauen darauf für seine Zuverlässigkeit – unterstützt von Investoren und integriert mit Top-Frameworks.

Die Preisgestaltung ist transparent und skalierbar: Kostenlos für kleine Teams (3k Logs/Monat), Team für 150 $/Monat bei 100k Logs und custom Enterprise für unbegrenzte Skalierung mit SLAs und Sicherheitsfeatures. Der 20% Jahresrabatt macht es kosteneffizient für wachsende Teams.

Im Vergleich zu Alternativen glänzt Parea AI in Human-in-the-Loop-Workflows und ist ideal für Anwendungen, die nuanciertes Feedback erfordern, wie Chatbots oder Content-Generierung.

Für wen ist Parea AI?

Parea AI ist perfekt für:

- AI-Entwickler und -Ingenieure: Aufbau und Optimierung von LLM-Apps mit einfachem Tracing und Deployment.

- Data Scientists: Durchführung von Experimenten, Fine-Tuning von Modellen mit annotierten Datasets.

- Product-Teams: Sammlung von Nutzerfeedback und Sicherstellung von Produktionsqualität.

- Startups und Enterprises: Von kostenlosem Prototyping bis zu sicheren, On-Prem-Lösungen.

Wenn Sie in Domains wie RAG-Pipelines, Q&A-Systemen oder personalisierten AIs sind, beschleunigen Parea AIs domain-spezifische Evals und Observability Ihren Workflow.

Praktischer Wert und reale Anwendungen

Der wahre Wert von Parea AI liegt in seiner Fähigkeit, AI-Deployments zu ent-risiken. Durch präzise Bewertung und menschliche Aufsicht vermeiden Teams kostspielige Produktionsprobleme. Zum Beispiel hilft Parea AI bei der Optimierung von RAG (Retrieval-Augmented Generation)-Pipelines, Prompt-Schwächen früh zu identifizieren. In Forschungs-Settings unterstützt es Weiterbildung durch hands-on Tools für LLM-Experimente.

Nutzer-Testimonials heben seine Einfachheit hervor: „Parea hat unseren Eval-Prozess gestrafft und die Debug-Zeit halbiert.“ (Hypothetisch basierend auf Plattform-Fokus). Mit Features wie unbegrenzten Projekten in bezahlten Plänen und Community-Support via Discord ist es ein kollaborativer Hub für AI-Innovation.

Zusammenfassend ist Parea AI nicht nur ein Tool – es ist ein Partner für den Aufbau robuster LLM-Anwendungen. Starten Sie heute mit dem Free-Plan und erleben Sie, wie es Ihren AI-Entwicklungszyklus transformiert.

Beste Alternativwerkzeuge zu "Parea AI"

Parea AI ist eine KI-Experimentier- und Annotationsplattform, die Teams dabei unterstützt, LLM-Anwendungen zuverlässig auszuliefern. Sie bietet Funktionen für die Experimentverfolgung, Observability, Human Review und Prompt-Bereitstellung.

UpTrain ist eine Full-Stack-LLMOps-Plattform, die Tools der Enterprise-Klasse zur Bewertung, zum Experimentieren, Überwachen und Testen von LLM-Anwendungen bereitstellt. Hosten Sie in Ihrer eigenen sicheren Cloud-Umgebung und skalieren Sie KI zuverlässig.

Maxim AI ist eine End-to-End-Bewertungs- und Observability-Plattform, die Teams dabei unterstützt, KI-Agenten zuverlässig und 5-mal schneller bereitzustellen, mit umfassenden Test-, Überwachungs- und Qualitätssicherungswerkzeugen.

FinetuneDB ist eine AI-Fine-Tuning-Plattform, mit der Sie Datensätze erstellen und verwalten können, um benutzerdefinierte LLMs schnell und kostengünstig zu trainieren und die Modellleistung mit Produktionsdaten und Kollaborationswerkzeugen zu verbessern.

Athina ist eine kollaborative AI-Plattform, die Teams dabei hilft, LLM-basierte Funktionen 10-mal schneller zu entwickeln, zu testen und zu überwachen. Mit Tools für Prompt-Management, Evaluierungen und Observability gewährleistet sie Datenschutz und unterstützt benutzerdefinierte Modelle.

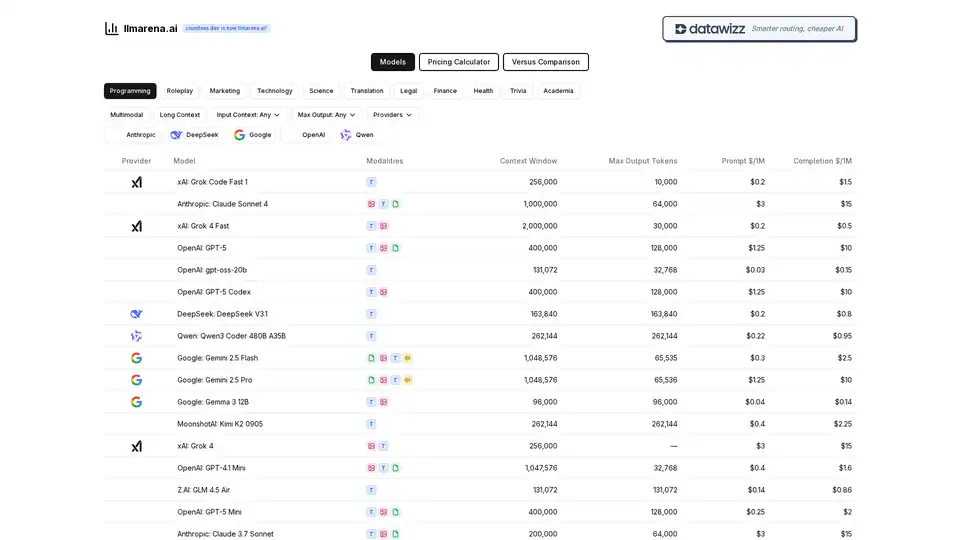

Vergleichen Sie AI-Modelle einfach! Alle Anbieter an einem Ort. Finden Sie das beste LLM für Ihre Bedürfnisse mit unserer umfassenden Preiskalkulator- und Funktionsvergleichs-Tool. OpenAI, Anthropic, Google und mehr.

Weights & Biases ist die KI-Entwicklerplattform zum Trainieren und Feinabstimmung von Modellen, zum Verwalten von Modellen und zum Verfolgen von GenAI-Anwendungen. Erstellen Sie KI-Agenten und -Modelle mit Zuversicht.

Keywords AI ist eine führende LLM-Monitoring-Plattform, die für KI-Startups entwickelt wurde. Überwachen und verbessern Sie Ihre LLM-Anwendungen einfach mit nur 2 Codezeilen. Debuggen Sie, testen Sie Prompts, visualisieren Sie Protokolle und optimieren Sie die Leistung für zufriedene Benutzer.

Latitude ist eine Open-Source-Plattform für Prompt-Engineering, die es Fachexperten ermöglicht, mit Ingenieuren zusammenzuarbeiten, um LLM-Funktionen in Produktionsqualität bereitzustellen. KI-Produkte mit Vertrauen erstellen, bewerten und bereitstellen.

Klu ist eine LLM-App-Plattform der nächsten Generation, die Teams dabei unterstützt, LLM-basierte Anwendungen sicher zu iterieren, zu bewerten und zu optimieren. Arbeiten Sie gemeinsam an Prompts, verfolgen Sie Änderungen und iterieren Sie schnell mit Erkenntnissen.

Vellum AI ist eine Enterprise-Plattform für die Orchestrierung, Bewertung und Überwachung von KI-Agenten. Erstellen Sie KI-Workflows schneller mit einem visuellen Builder und SDK.

LangWatch ist eine Plattform für KI-Agenten-Tests, LLM-Evaluierung und LLM-Observability. Testen Sie Agenten, verhindern Sie Regressionen und beheben Sie Probleme.

WhyLabs bietet KI-Observability, LLM-Sicherheit und Modellüberwachung. Schützen Sie generative KI-Anwendungen in Echtzeit, um Risiken zu mindern.

Future AGI bietet eine einheitliche LLM Observability- und KI-Agenten-Evaluierungsplattform für KI-Anwendungen, die Genauigkeit und verantwortungsvolle KI von der Entwicklung bis zur Produktion gewährleistet.