local.ai

Übersicht von local.ai

Lokaler KI-Spielplatz: Ihr Tor zum Offline-KI-Experimentieren

Was ist Local AI Playground?

Local AI Playground, betrieben von local.ai, ist eine kostenlose und Open-Source-basierte Native-Anwendung, die entwickelt wurde, um den Prozess des Experimentierens mit KI-Modellen lokal zu vereinfachen, auch ohne GPU. Sie ermöglicht es Ihnen, KI-Inferenz offline und privat durchzuführen und bietet sowohl Anfängern als auch fortgeschrittenen Benutzern eine optimierte Erfahrung.

Wie funktioniert local.ai?

Local.ai vereinfacht das KI-Modellmanagement, die Verifizierung und die Inferenz durch seine benutzerfreundliche Oberfläche und das effiziente Rust-Backend. Hier ist eine Aufschlüsselung seiner wichtigsten Funktionen und Funktionalitäten:

Hauptmerkmale:

- CPU-Inferenz: Passt sich an die verfügbaren Threads an und unterstützt GGML-Quantisierung (q4, 5.1, 8, f16) für effiziente CPU-basierte KI-Inferenz.

- Modellmanagement: Zentraler Ort für die Verfolgung von KI-Modellen mit Funktionen wie fortsetzbarem, gleichzeitigem Downloader, nutzungsbasierter Sortierung und verzeichnisagnostischer Einrichtung.

- Digest-Verifizierung: Stellt die Modellintegrität mit BLAKE3- und SHA256-Digest-Berechnung, Known-Good-Model-API und Lizenz-/Nutzungs-Chips sicher.

- Inferenzserver: Startet einen lokalen Streaming-Server für KI-Inferenz mit nur zwei Klicks und bietet eine schnelle Inferenz-UI und schreibt Ausgaben in .mdx-Dateien.

Verfügbare Funktionen:

- Streaming-Server

- Schnelle Inferenz-UI

- Schreibt in .mdx

- Inferenzparameter

- Remote-Vokabular

- Digest-Berechnung

- Known-Good-Model-API

- Lizenz- und Nutzungs-Chips

- BLAKE3-Schnellprüfung

- Modellinfokarte

Kommende Funktionen:

- GPU-Inferenz

- Parallele Sitzung

- Verschachteltes Verzeichnis

- Benutzerdefinierte Sortierung und Suche

- Model Explorer

- Modellsuche

- Modellempfehlung

- Server Manager

- /audio

- /image

Wie man local.ai benutzt:

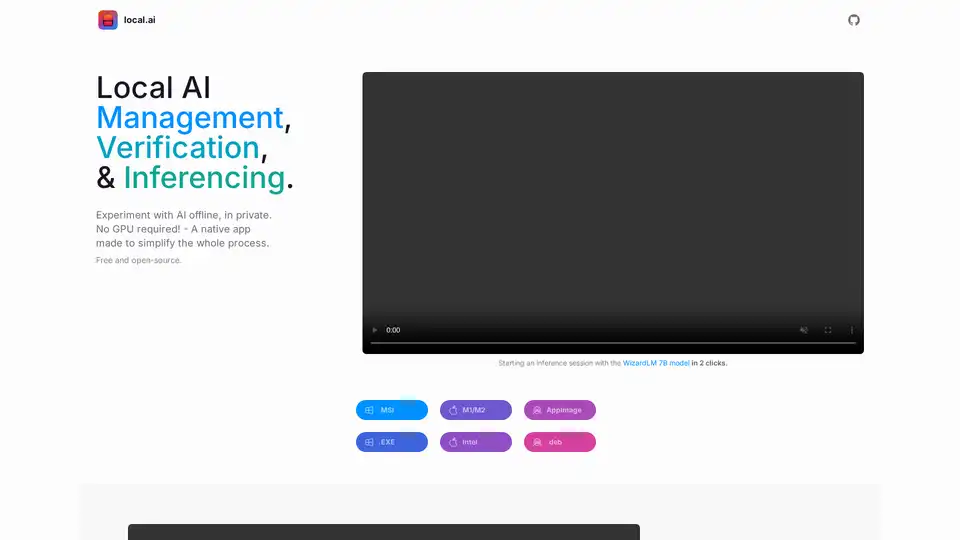

- Herunterladen und Installieren: Laden Sie die passende Version für Ihr Betriebssystem herunter (.MSI, .EXE, M1/M2, Intel, AppImage, .deb).

- Modellmanagement: Wählen Sie ein Verzeichnis aus, um Ihre KI-Modelle zu verfolgen. Die App bietet Funktionen wie fortsetzbare Downloads und nutzungsbasierte Sortierung.

- Inferenzserver: Laden Sie ein Modell und starten Sie den Server mit nur zwei Klicks, um mit der KI-Inferenz zu beginnen.

Warum ist local.ai wichtig?

- Privatsphäre: Führen Sie KI-Modelle offline und privat aus.

- Zugänglichkeit: Keine GPU erforderlich, wodurch KI-Experimente für mehr Benutzer zugänglich werden.

- Effizienz: Das Rust-Backend sorgt für Speichereffizienz und einen kompakten Footprint.

- Open Source: Kostenlos und Open Source, was Community-Beiträge und Transparenz fördert.

Wo kann ich local.ai verwenden?

Local.ai kann in verschiedenen Umgebungen eingesetzt werden, darunter:

- KI-Entwicklung: Zum Testen und Experimentieren mit KI-Modellen, ohne auf Cloud-Dienste angewiesen zu sein.

- Bildungszwecke: Zum Erlernen und Verstehen von KI-Konzepten in einer praktischen Offline-Umgebung.

- Datenschutzsensible Anwendungen: Zum Ausführen von KI-Modellen auf sensiblen Daten, ohne diese an externe Server zu übertragen.

Wie fange ich am besten mit local.ai an?

Laden Sie local.ai herunter und experimentieren Sie dann mit dem WizardLM 7B-Modell oder einem anderen Open-Source-Modell mit nur wenigen Klicks. local.ai bietet einen optimierten Prozess und leistungsstarke Funktionen, mit denen Sie alle Ihre KI-Modelle offline oder online verwalten können.

Beste Alternativwerkzeuge zu "local.ai"

Local AI ist eine kostenlose Open-Source-Native-Anwendung, die das Experimentieren mit KI-Modellen lokal vereinfacht. Es bietet CPU-Inferenz, Modellverwaltung und Digest-Verifizierung und benötigt keine GPU.

AI Runner ist eine Offline-KI-Inferenz-Engine für Kunst, Echtzeit-Sprachkonversationen, LLM-gestützte Chatbots und automatisierte Arbeitsabläufe. Führen Sie Bilderzeugung, Voice-Chat und mehr lokal aus!

NativeMind ist eine open-source Chrome-Erweiterung, die lokale LLMs wie Ollama ausführt und eine vollständig offline, private ChatGPT-Alternative bietet. Funktionen: kontextbewusster Chat, Agentenmodus, PDF-Analyse, Schreibtools und Übersetzung – alles 100% auf dem Gerät ohne Cloud.

Agent Herbie ist ein Offline-KI-Agent, der für Echtzeit- und unternehmenskritische Operationen in privaten Umgebungen entwickelt wurde. Er nutzt LLMs, SLMs und ML für unübertroffene Flexibilität und Zuverlässigkeit ohne Datenabfluss.

Jan ist ein Open-Source-KI-Client, der in erster Linie offline funktioniert. Führen Sie Large Language Models (LLMs) lokal mit Datenschutz und ohne API-Gebühren aus. Verbinden Sie sich mit verschiedenen Modellen und Diensten.

LM Studio ist eine benutzerfreundliche Desktop-Anwendung zum lokalen Ausführen und Herunterladen von Open-Source-Sprachmodellen (LLMs) wie LLaMa und Gemma auf Ihrem Computer. Es bietet eine In-App-Chat-Benutzeroberfläche und einen OpenAI-kompatiblen Server für die Offline-KI-Modellinteraktion, wodurch fortschrittliche KI ohne Programmierkenntnisse zugänglich wird.

Hachi ist ein KI-gestütztes Tool, das die natürliche Sprachsuche in Ihren Videos und Bildern ermöglicht. Es bietet auch Gesichtserkennung für eine schnelle und einfache Suche. Datenschutzorientiert und funktioniert offline.

HaiVE bietet lokale KI-Agenten für die Sprachkommunikation und gewährleistet Datensouveränität, geringe Latenz und vorhersehbare Kosten. Stellen Sie KI-Agenten bereit, die tatsächlich Tickets und Geschäfte abschließen.

Aftershoot: KI-Fotobearbeitungssoftware zum Auswählen, Bearbeiten und Retuschieren. Optimieren Sie Ihren Fotografie-Workflow und sparen Sie jeden Monat über 18 Stunden.

Amuse ist ein kostenloser KI-Kunstgenerator, der Stable Diffusion-Modelle verwendet, die für AMD-Hardware optimiert sind und die Generierung von Bildern und Videos auf persönlichen PCs ohne Internetverbindung ermöglicht.

DrawingPics ist ein Offline-KI-Kunstgenerator, der grobe Skizzen in ansprechende Bilder verwandelt. Es unterstützt benutzerdefinierte Modelle und LoRAs und läuft zu 100 % lokal.

Skribr ist eine private On-Device-KI-Chat-App mit Tools, die lokal auf Ihrem iPhone, iPad und Mac ausgeführt werden und Datensicherheit und Offline-Zugriff gewährleisten.

Layla AI ist die beste Offline-KI-Assistenten-App für Android und iOS. Erleben Sie die Leistungsfähigkeit von Offline-KI mit Layla. Maximieren Sie das Potenzial Ihres Smartphones mit modernsten KI-Tools.

MICRO LLM ist ein KI-Assistent, der als ultimativer persönlicher Assistent entwickelt wurde und Ihnen hilft, Ihre Aufgabenliste zu organisieren und mit Offline-LLMs produktiv zu bleiben.