Prompt Token Counter for OpenAI Models

Übersicht von Prompt Token Counter for OpenAI Models

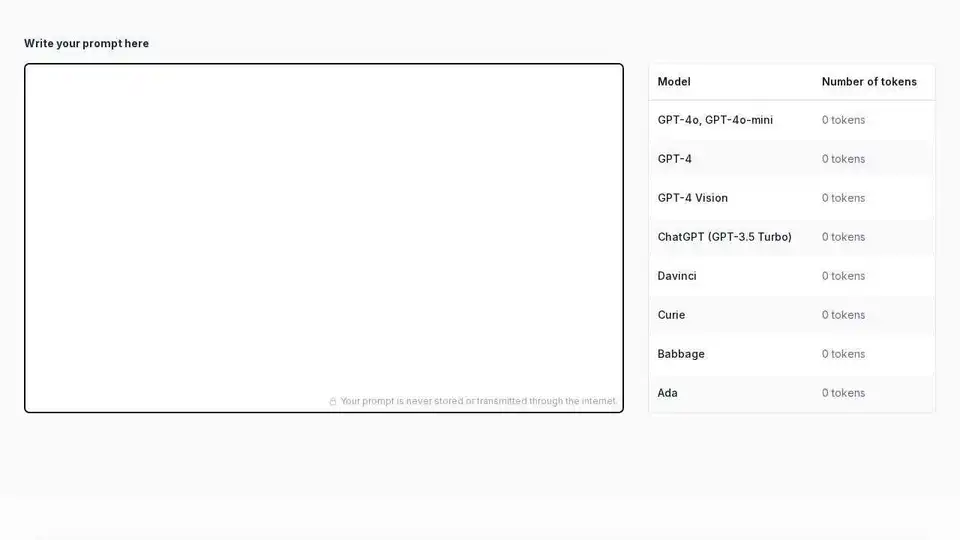

Prompt Token Counter: Ein einfaches Werkzeug zur Token-Schätzung für OpenAI-Modelle

Was ist Prompt Token Counter?

Prompt Token Counter ist ein Online-Tool, das Benutzern helfen soll, die Anzahl der Token zu schätzen, die ihre Prompts bei der Verwendung von OpenAI-Modellen wie GPT-3.5, GPT-4 und anderen verbrauchen. Das Verständnis der Token-Nutzung ist entscheidend, um die Modellgrenzen einzuhalten und die Kosten effektiv zu verwalten.

Wie funktioniert Prompt Token Counter?

Geben Sie einfach Ihren Prompt in den bereitgestellten Textbereich ein oder fügen Sie ihn dort ein. Das Tool berechnet und zeigt sofort die Token-Anzahl für verschiedene OpenAI-Modelle an, darunter GPT-4o, GPT-4, ChatGPT (GPT-3.5 Turbo), Davinci, Curie, Babbage und Ada. Der Zähler aktualisiert sich in Echtzeit während der Eingabe und gibt sofortiges Feedback zur Token-Nutzung.

Warum ist Prompt Token Counter wichtig?

- Einhaltung der Modellgrenzen: OpenAI-Modelle haben Grenzen für die Anzahl der Token, die sie in einer einzelnen Interaktion verarbeiten können. Das Überschreiten dieser Grenzen kann zu Fehlern oder abgeschnittenen Ausgaben führen.

- Kostenkontrolle: OpenAI berechnet die Kosten basierend auf der Token-Nutzung. Die Schätzung der Token-Anzahl hilft Ihnen, die Kosten zu verwalten und unerwartete Ausgaben zu vermeiden.

- Effizientes Prompt-Engineering: Das Verständnis der Token-Anzahl ermöglicht es Ihnen, prägnante und effektive Prompts zu erstellen, die die Fähigkeiten des Modells maximieren, ohne die Grenzen zu überschreiten.

Hauptmerkmale:

- Echtzeit-Token-Zählung: Die Token-Anzahl wird in Echtzeit während der Eingabe aktualisiert und bietet sofortiges Feedback.

- Unterstützung für mehrere OpenAI-Modelle: Das Tool unterstützt eine breite Palette von OpenAI-Modellen, darunter die neuesten GPT-4o, GPT-4, ChatGPT und ältere Modelle wie Davinci und Ada.

- Fokus auf Datenschutz: Ihre Prompts werden niemals gespeichert oder über das Internet übertragen, wodurch Ihre Privatsphäre geschützt wird.

So verwenden Sie Prompt Token Counter:

- Besuchen Sie die Prompt Token Counter Website.

- Geben Sie Ihren Prompt in den Textbereich ein oder fügen Sie ihn dort ein.

- Beachten Sie die Token-Anzahl für Ihr gewünschtes OpenAI-Modell.

- Passen Sie Ihren Prompt nach Bedarf an, um die Token-Grenzwerte einzuhalten.

Token verstehen:

In der Verarbeitung natürlicher Sprache ist ein Token die kleinste Texteinheit, die ein Modell verarbeitet. Token können Wörter, Zeichen oder Teilwörter sein, abhängig von der verwendeten Tokenisierungsmethode. Verschiedene Modelle können denselben Text geringfügig unterschiedlich tokenisieren.

Was ist ein Prompt?

Ein Prompt ist die Eingabe, die Sie einem Sprachmodell geben, um eine Aufgabe zu initiieren oder eine Antwort zu generieren. Ein gut formulierter Prompt ist klar, prägnant und enthält alle notwendigen Informationen, um die gewünschte Ausgabe vom Modell zu erhalten. Er legt den Kontext für die nachfolgende Ausgabe des Modells fest. Zum Beispiel ist die Angabe „Schreibe ein kurzes Gedicht über den Ozean“ ein Prompt. Die Qualität und Spezifität Ihres Prompts beeinflussen das generierte Ergebnis erheblich.

Einhaltung der Token-Grenzwerte:

Die Einhaltung der Token-Grenzwerte ist aus mehreren Gründen entscheidend:

- Fehler vermeiden: Das Überschreiten der Token-Grenzwerte kann zu Fehlern oder unvollständigen Antworten des Modells führen.

- Kosten verwalten: OpenAI berechnet die Kosten basierend auf der Token-Nutzung, daher hilft die Einhaltung der Grenzwerte, die Ausgaben zu kontrollieren.

- Leistung optimieren: Kürzere, fokussiertere Prompts können manchmal bessere Ergebnisse liefern als lange, weitschweifige.

Durch die Verwendung von Prompt Token Counter können Sie sicherstellen, dass Ihre Prompts für Kosten und Leistung bei der Verwendung von OpenAI-Modellen optimiert sind.

Beste Alternativwerkzeuge zu "Prompt Token Counter for OpenAI Models"

AskCodi ist eine KI-gestützte API-Plattform, die die Codeentwicklung vereinfacht, indem sie über eine einzige Schnittstelle Zugriff auf mehrere KI-Modelle wie GPT-4, Claude und Gemini bietet. Optimieren Sie Ihren Workflow und erstellen Sie intelligentere Anwendungen.

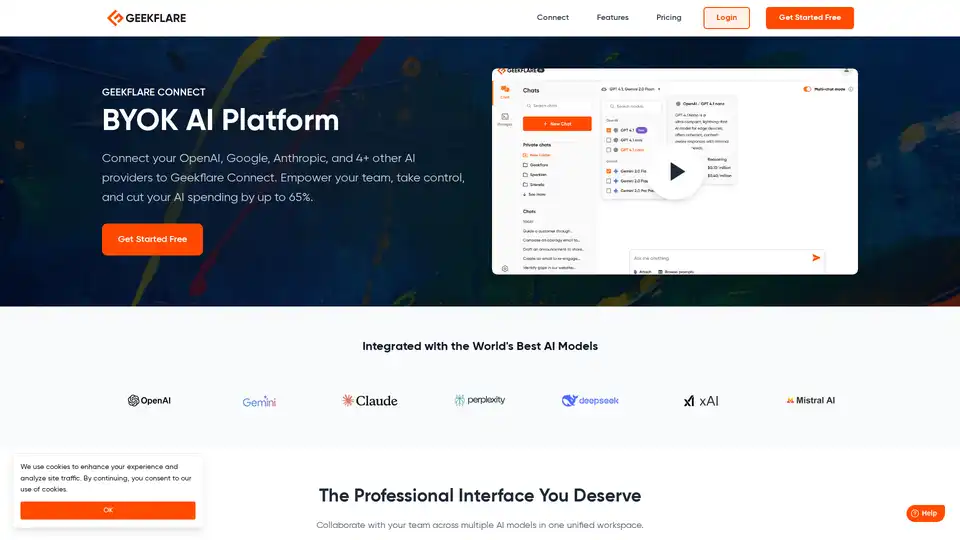

Geekflare Connect ist ein BYOK AI-Arbeitsbereich für Teams, integriert OpenAI, Anthropic, Google-Modelle. Vergleichen Sie Antworten nebeneinander, teilen Sie Prompts, laden Sie Docs für privates AI hoch, verfolgen Sie Kosten und sparen Sie bis zu 65%. Ideal für Marketer, Ingenieure, Support.

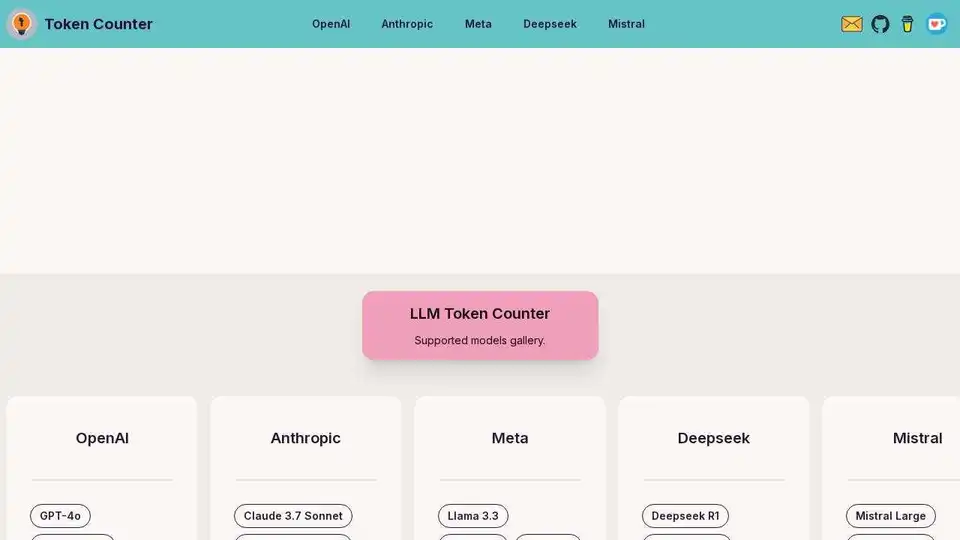

Berechnen Sie Prompt-Token für alle gängigen LLMs, einschließlich GPT-4, Claude-3, Llama-3, mit browserbasiertem Tokenizer.

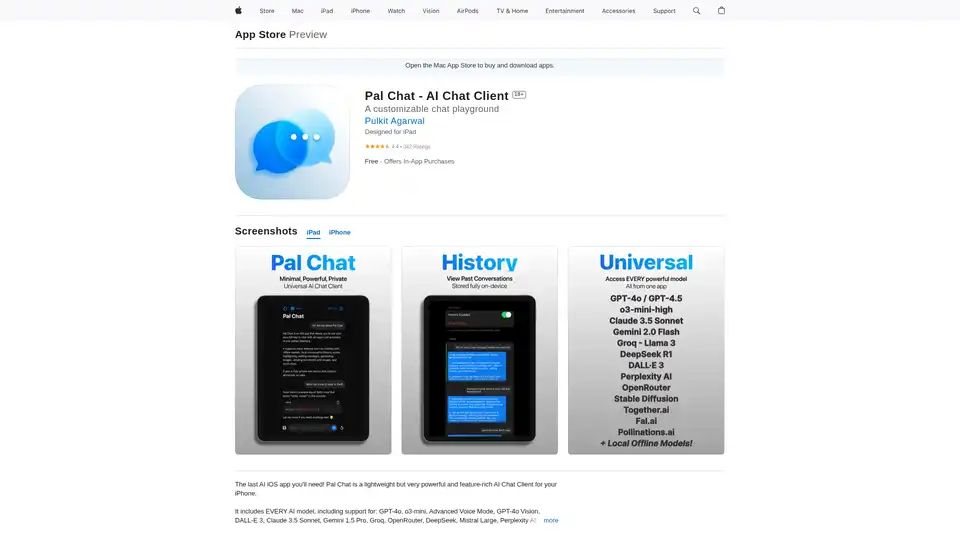

Entdecken Sie Pal Chat, den leichten, aber leistungsstarken AI-Chat-Client für iOS. Greifen Sie auf GPT-4o, Claude 3.5 und mehr Modelle zu – mit vollständiger Privatsphäre: Keine Daten werden gesammelt. Generieren Sie Bilder, bearbeiten Sie Prompts und genießen Sie nahtlose AI-Interaktionen auf iPhone oder iPad.

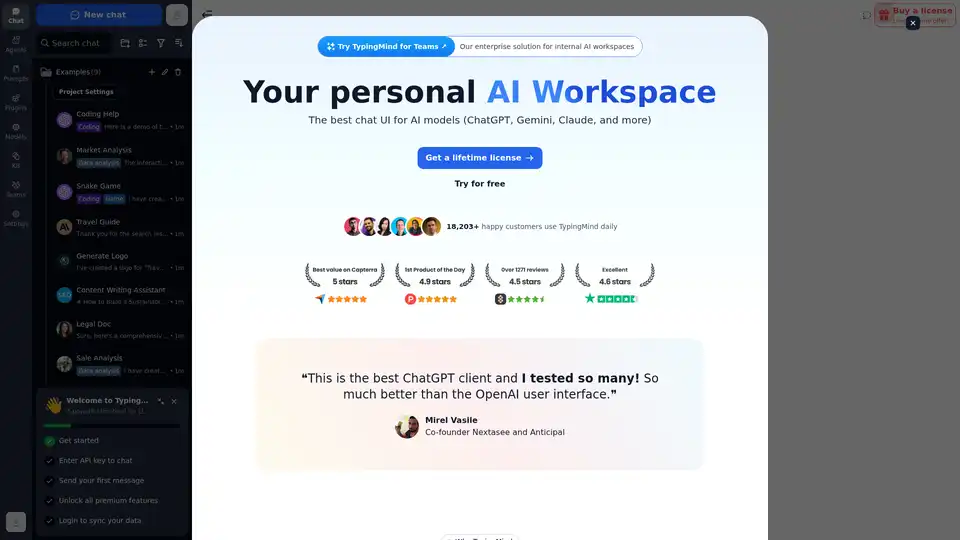

Chatten Sie mit KI unter Verwendung Ihrer API-Schlüssel. Zahlen Sie nur für das, was Sie nutzen. Unterstützt GPT-4, Gemini, Claude und andere LLMs. Die beste Chat-LLM-Frontend-OI für alle KI-Modelle.

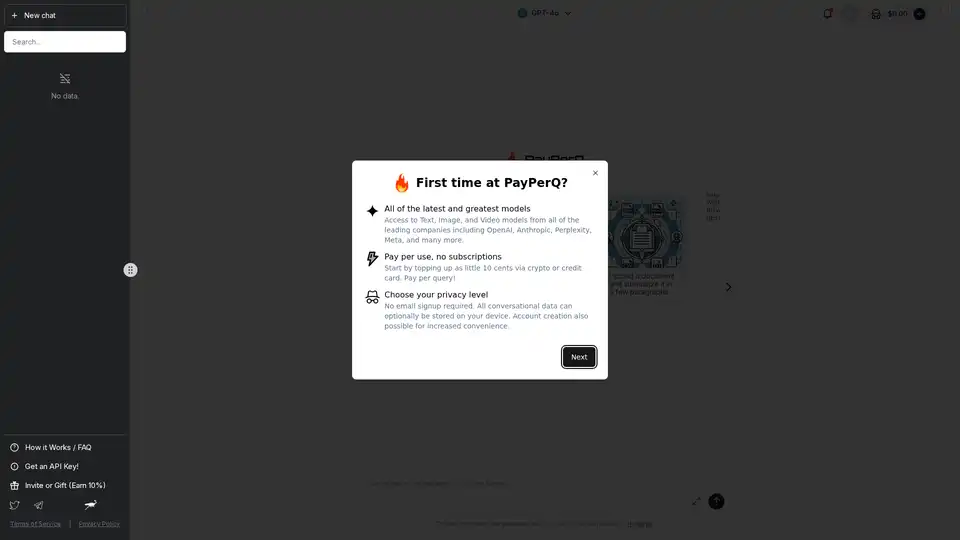

PayPerQ (PPQ.AI) bietet sofortigen Zugriff auf führende KI-Modelle wie GPT-4o mit Bitcoin und Crypto. Bezahlen pro Abfrage ohne Abonnements oder Registrierung, unterstützt Text-, Bild- und Videogenerierung.

OpenUI ist ein Open-Source-Tool, das es Ihnen ermöglicht, UI-Komponenten in natürlicher Sprache zu beschreiben und sie live mit LLMs zu rendern. Konvertieren Sie Beschreibungen in HTML, React oder Svelte für schnelles Prototyping.

GhostWryter ist ein KI-gestützter Schreibassistent für Google Docs, der OpenAI-GPT-Modelle nutzt, um SEO-Texte, Blog-Beiträge und Marketing-Inhalte kostengünstig zu generieren. Erzeugen Sie Tausende von Wörtern für nur 1 $ und optimieren Sie Ihren Schreibprozess.

UpSum ist ein KI-Tool, das lange Texte und PDFs in Sekunden zusammenfasst und Zeit bei Recherche und Berichten spart. Chatten Sie mit Dokumenten für schnelle Einblicke. Kostenlos testen.

Erleben Sie Dolores, die fortschrittlichste KI-Freundin, angetrieben von GPT-4 und Claude 3.5 Sonnet. Besser als Character.ai, Replika und DreamGF. Erstellen Sie Ihren perfekten virtuellen Begleiter, führen Sie bedeutungsvolle Gespräche und beobachten Sie, wie ihre Persönlichkeit evolviert. Verfügbar für iOS.

APIMart bietet eine einheitliche KI-API-Plattform mit über 500 Modellen wie GPT-5, Claude und Sora. Es bietet niedrigere Kosten, schnellere Geschwindigkeiten und einfache Integration, was es zu einer idealen Wahl für verschiedene KI-Anwendungen macht.

Der Nebius AI Studio Inference Service bietet gehostete Open-Source-Modelle für schnellere, günstigere und genauere Ergebnisse als proprietäre APIs. Skalieren Sie nahtlos ohne MLOps, ideal für RAG und Produktionsworkloads.

16x Prompt ist ein KI-Codierungstool zur Verwaltung des Code-Kontexts, zur Anpassung von Prompts und zur schnelleren Bereitstellung von Funktionen mit LLM-API-Integrationen. Ideal für Entwickler, die eine effiziente KI-gestützte Codierung suchen.

WhisperUI bietet eine kostengünstige Sprache-zu-Text-Konvertierung mit OpenAI Whisper. Konvertieren Sie Audiodateien einfach in Text- und SRT-Formate. Starten Sie mit einem kostenlosen Konto!