Runpod

Übersicht von Runpod

Runpod: Die Cloud, entwickelt für KI

Runpod ist eine All-in-One-Cloud-Plattform, die den Prozess des Trainierens, Feinabstimmens und Bereitstellens von KI-Modellen vereinfachen soll. Sie richtet sich an KI-Entwickler, indem sie eine vereinfachte GPU-Infrastruktur und eine End-to-End-KI-Cloud-Lösung bietet.

Was ist Runpod?

Runpod ist eine umfassende Cloud-Plattform, die die Komplexität des Erstellens und Bereitstellens von KI-Modellen vereinfacht. Sie bietet eine Reihe von GPU-Ressourcen und Tools, die es Entwicklern ermöglichen, sich auf Innovationen statt auf Infrastrukturmanagement zu konzentrieren.

Wie funktioniert Runpod?

Runpod vereinfacht den KI-Workflow zu einem einzigen, kohärenten Fluss, der es Benutzern ermöglicht, nahtlos von der Idee zur Bereitstellung zu gelangen. So funktioniert es:

- Hochfahren: Starten Sie einen GPU-Pod in Sekunden und eliminieren Sie Bereitstellungsverzögerungen.

- Erstellen: Trainieren Sie Modelle, rendern Sie Simulationen oder verarbeiten Sie Daten ohne Einschränkungen.

- Iterieren: Experimentieren Sie mit Vertrauen mit sofortigem Feedback und sicheren Rollbacks.

- Bereitstellen: Automatische Skalierung über Regionen hinweg ohne Leerlaufkosten und Ausfallzeiten.

Hauptmerkmale und Vorteile:

- On-Demand-GPU-Ressourcen:

- Unterstützt über 30 GPU-SKUs, von B200s bis RTX 4090s.

- Bietet voll ausgestattete, GPU-fähige Umgebungen in weniger als einer Minute.

- Globale Bereitstellung:

- Führen Sie Workloads in über 8 Regionen weltweit aus.

- Gewährleistet eine latenzarme Leistung und globale Zuverlässigkeit.

- Serverloses Skalieren:

- Passt sich in Echtzeit an Ihre Workload an und skaliert von 0 auf 100 Compute-Worker.

- Sie zahlen nur für das, was Sie verbrauchen.

- Enterprise-Grade-Uptime:

- Behandelt Failover und sorgt für einen reibungslosen Ablauf der Workloads.

- Verwaltete Orchestrierung:

- Serverlose Queues und verteilt Aufgaben nahtlos.

- Echtzeitprotokolle:

- Bietet Echtzeitprotokolle, Überwachung und Metriken.

Warum Runpod wählen?

- Kosteneffizient:

- Runpod wurde entwickelt, um den Durchsatz zu maximieren, die Skalierung zu beschleunigen und die Effizienz zu steigern, sodass jeder Dollar härter arbeitet.

- Flexibilität und Skalierbarkeit:

- Die skalierbare GPU-Infrastruktur von Runpod bietet die Flexibilität, die erforderlich ist, um Kundentraffic und Modellkomplexität anzupassen.

- Entwicklerfreundlich:

- Runpod vereinfacht jeden Schritt des KI-Workflows und ermöglicht es Entwicklern, sich auf das Erstellen und Innovieren zu konzentrieren.

- Zuverlässigkeit:

- Bietet Enterprise-Grade-Uptime und stellt sicher, dass Workloads reibungslos laufen, auch wenn Ressourcen fehlen.

Für wen ist Runpod geeignet?

Runpod ist konzipiert für:

- KI-Entwickler

- Ingenieure für maschinelles Lernen

- Data Scientists

- Forscher

- Startups

- Unternehmen

Wie verwende ich Runpod?

- Anmelden: Erstellen Sie ein Konto auf der Runpod-Plattform.

- Starten Sie einen GPU-Pod: Wählen Sie aus einer Vielzahl von GPU-SKUs und starten Sie in Sekundenschnelle eine voll ausgestattete Umgebung.

- Erstellen und Trainieren: Verwenden Sie die Umgebung, um Modelle zu trainieren, Simulationen zu rendern oder Daten zu verarbeiten.

- Bereitstellen: Skalieren Sie Ihre Workloads über mehrere Regionen hinweg ohne Ausfallzeiten.

Erfolgsgeschichten von Kunden:

Viele Entwickler und Unternehmen haben mit Runpod Erfolg gehabt. Hier sind einige Beispiele:

- InstaHeadshots: Sparten 90 % ihrer Infrastrukturkosten, indem sie bei Bedarf Bursty Compute nutzten.

- Coframe: Skalierte mühelos hoch, um die Nachfrage beim Start zu decken, dank der Flexibilität von Runpod.

Anwendungen in der realen Welt

Runpod ist vielseitig und unterstützt verschiedene Anwendungen, darunter:

- Inferenz

- Feinabstimmung

- KI-Agenten

- Rechenintensive Aufgaben

Durch die Wahl von Runpod können Unternehmen:

- Den Overhead des Infrastrukturmanagements reduzieren.

- KI-Entwicklungszyklen beschleunigen.

- Kosteneffiziente Skalierung erreichen.

- Zuverlässige Leistung sicherstellen.

Runpod macht das Infrastrukturmanagement zu seiner Aufgabe, sodass Sie sich auf das Erstellen des Nächsten konzentrieren können. Egal, ob Sie ein Startup oder ein Unternehmen sind, die KI-Cloud-Plattform von Runpod bietet die Ressourcen und Unterstützung, die Sie benötigen, um Ihre KI-Projekte zum Leben zu erwecken.

Zusammenfassend bietet Runpod eine umfassende, kostengünstige und skalierbare Lösung für KI-Entwicklung und -Bereitstellung. Es ist eine ideale Plattform für Entwickler, die Machine-Learning-Modelle effizient erstellen, trainieren und skalieren möchten.

Beste Alternativwerkzeuge zu "Runpod"

Runpod ist eine All-in-One-KI-Cloud-Plattform, die das Erstellen und Bereitstellen von KI-Modellen vereinfacht. Trainieren, optimieren und stellen Sie KI mühelos mit leistungsstarker Rechenleistung und automatischer Skalierung bereit.

GreenNode bietet umfassende KI-fähige Infrastruktur und Cloud-Lösungen mit H100-GPUs ab 2,34 $/Stunde. Greifen Sie auf vorkonfigurierte Instanzen und eine Full-Stack-KI-Plattform für Ihre KI-Reise zu.

Massed Compute bietet On-Demand-GPU- und CPU-Cloud-Computing-Infrastruktur für KI, maschinelles Lernen und Datenanalyse. Greifen Sie mit flexiblen und erschwinglichen Plänen auf hochleistungsfähige NVIDIA-GPUs zu.

SaladCloud bietet eine erschwingliche, sichere und Community-gesteuerte verteilte GPU-Cloud für KI/ML-Inferenz. Sparen Sie bis zu 90 % der Rechenkosten. Ideal für KI-Inferenz, Stapelverarbeitung und mehr.

eeat ist ein KI-gestütztes Analysetool mit GPT-3.5 und GPT-4, das detaillierte Daten zu kommerziellen Keywords und Wettbewerbern sammelt, um EEAT-konformes Experten-Content zu erstellen und Suchmaschinen-Rankings sowie die Geschäftskonkurrenzfähigkeit zu steigern.

Novita AI bietet mehr als 200 Model-APIs, benutzerdefinierte Bereitstellung, GPU-Instanzen und serverlose GPUs. Skalieren Sie die KI, optimieren Sie die Leistung und innovieren Sie mühelos und effizient.

Vocareum bietet KI-Bildungslösungen mit Cloud-Labs, KI-Notebooks und KI-Gateways für praktisches Lernen und Forschung.

QSC Cloud bietet erstklassige NVIDIA GPU Cloud-Cluster für KI-, Deep-Learning- und HPC-Workloads mit globaler GPU-Konnektivität.

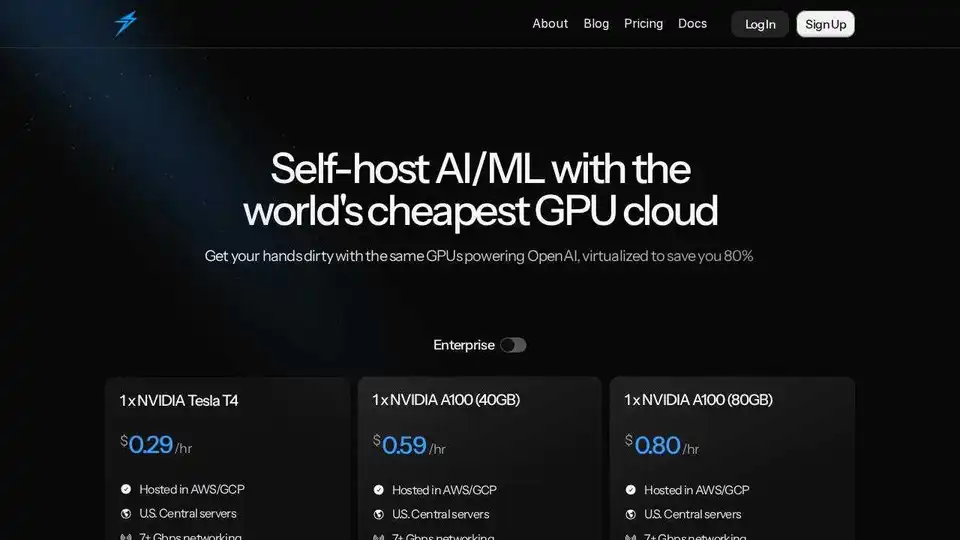

Thunder Compute ist eine GPU-Cloud-Plattform für KI/ML, die GPU-Instanzen mit einem Klick in VSCode zu Preisen anbietet, die 80 % niedriger sind als die der Konkurrenz. Perfekt für Forscher, Startups und Datenwissenschaftler.

Mieten Sie mit Vast.ai kostengünstig Hochleistungs-GPUs. Stellen Sie sofort GPU-Mieten für KI, maschinelles Lernen, Deep Learning und Rendering bereit. Flexible Preise und schnelle Einrichtung.

Cirrascale AI Innovation Cloud beschleunigt die KI-Entwicklung, das Training und die Inferenz-Workloads. Testen und implementieren Sie auf führenden KI-Beschleunigern mit hohem Durchsatz und geringer Latenz.

Phala Cloud bietet eine vertrauenswürdige Open-Source-Cloud-Infrastruktur für die Bereitstellung von KI-Agenten und Web3-Anwendungen, die von TEE unterstützt wird. Es gewährleistet Datenschutz, Skalierbarkeit und wird durch Code gesteuert.

Juice ermöglicht GPU-over-IP und ermöglicht Ihnen, Ihre GPUs mit Software für KI- und Grafik-Workloads zu vernetzen und zu bündeln.

AIStocks.io ist eine KI-gestützte Aktienforschungsplattform, die Echtzeit-Prognosen, automatisierte Trading-Signale und umfassende Risikomanagement-Tools für selbstbewusste Anlageentscheidungen bietet.