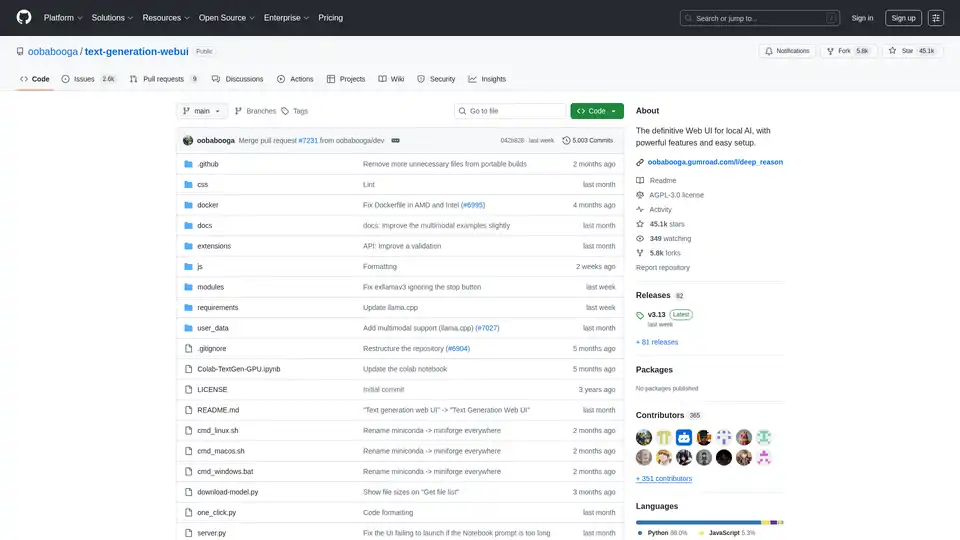

Text Generation Web UI

Übersicht von Text Generation Web UI

Text Generation Web UI: Die ultimative Web-Oberfläche für lokale KI

Was ist Text Generation Web UI?

Text Generation Web UI, auch bekannt als oobabooga/text-generation-webui, ist eine benutzerfreundliche und funktionsreiche Gradio-Weboberfläche, die für die Interaktion mit großen Sprachmodellen (LLMs) lokal entwickelt wurde. Sie bietet eine umfassende Reihe von Werkzeugen und Funktionalitäten, um die Leistungsfähigkeit der KI-Textgenerierung auf Ihrem eigenen Rechner zu nutzen und gleichzeitig Privatsphäre und Kontrolle zu gewährleisten.

Wie funktioniert Text Generation Web UI?

Diese Web-UI fungiert als Brücke zwischen Ihnen und verschiedenen lokalen Textgenerierungs-Backends. Sie unterstützt mehrere Backends wie llama.cpp, Transformers, ExLlamaV3, ExLlamaV2 und TensorRT-LLM. Die UI ermöglicht Ihnen:

- Auswahl Ihres bevorzugten Backends: Wählen Sie das Backend, das Ihren Hardware- und Modellanforderungen entspricht.

- Laden und Verwalten von Modellen: Laden Sie auf einfache Weise verschiedene LLMs und wechseln Sie zwischen ihnen, ohne die Anwendung neu zu starten.

- Konfigurieren von Generierungsparametern: Optimieren Sie den Textgenerierungsprozess mit verschiedenen Sampling-Parametern und Generierungsoptionen.

- Interaktion mit dem Modell: Nutzen Sie die intuitive Chat-Oberfläche oder den frei gestaltbaren Notebook-Tab, um mit dem Modell zu interagieren.

Warum Text Generation Web UI wählen?

- Privatsphäre: Die gesamte Verarbeitung erfolgt lokal, wodurch sichergestellt wird, dass Ihre Daten privat bleiben.

- Offline-Funktionalität: Es ist keine Internetverbindung erforderlich, sodass Sie das Tool jederzeit und überall nutzen können.

- Vielseitigkeit: Unterstützt mehrere Backends und Modelltypen und bietet Flexibilität und Anpassungsmöglichkeiten.

- Erweiterbarkeit: Bietet Unterstützung für Erweiterungen zum Hinzufügen neuer Funktionen und Funktionalitäten.

- Benutzerfreundlichkeit: Benutzerfreundliche Oberfläche mit dunklen und hellen Designs, Syntaxhervorhebung und LaTeX-Rendering.

Hauptmerkmale:

- Unterstützung mehrerer Backends: Integriert sich nahtlos in

llama.cpp,Transformers,ExLlamaV3,ExLlamaV2undTensorRT-LLM. - Einfache Einrichtung: Bietet portable Builds für Windows/Linux/macOS, die keine Einrichtung erfordern, sowie ein One-Click-Installationsprogramm für eine in sich geschlossene Umgebung.

- Offline und privat: Funktioniert zu 100 % offline ohne Telemetrie, externe Ressourcen oder Remote-Update-Anfragen.

- Datei-Anhänge: Ermöglicht das Hochladen von Textdateien, PDF-Dokumenten und .docx-Dateien, um deren Inhalt mit der KI zu besprechen.

- Vision (Multimodale Modelle): Unterstützt das Anhängen von Bildern an Nachrichten für visuelles Verständnis (Tutorial).

- Websuche: Kann optional das Internet mit LLM-generierten Abfragen durchsuchen, um Konversationen Kontext hinzuzufügen.

- Ästhetische UI: Bietet eine saubere und ansprechende Benutzeroberfläche mit dunklen und hellen Designs.

- Syntaxhervorhebung und LaTeX-Rendering: Bietet Syntaxhervorhebung für Codeblöcke und LaTeX-Rendering für mathematische Ausdrücke.

- Instruktions- und Chat-Modi: Beinhaltet den Instruktionsmodus für das Befolgen von Anweisungen und Chat-Modi für die Interaktion mit benutzerdefinierten Charakteren.

- Automatische Prompt-Formatierung: Verwendet Jinja2-Vorlagen für die automatische Prompt-Formatierung.

- Nachrichtenbearbeitung und Konversationsverzweigung: Ermöglicht das Bearbeiten von Nachrichten, das Navigieren zwischen Versionen und das Verzweigen von Konversationen.

- Mehrere Sampling-Parameter: Bietet ausgefeilte Kontrolle über die Textgenerierung mit verschiedenen Sampling-Parametern und Generierungsoptionen.

- Modellwechsel: Ermöglicht das Umschalten zwischen verschiedenen Modellen in der UI, ohne dass ein Neustart erforderlich ist.

- Automatische GPU-Layer: Konfiguriert automatisch GPU-Layer für GGUF-Modelle auf NVIDIA-GPUs.

- Freie Textgenerierung: Bietet einen Notebook-Tab für die freie Textgenerierung ohne Einschränkungen bei Chat-Turns.

- OpenAI-kompatible API: Enthält eine OpenAI-kompatible API mit Chat- und Completions-Endpunkten, einschließlich Unterstützung für Tool-Aufrufe.

- Erweiterungs-Support: Unterstützt zahlreiche integrierte und von Benutzern beigesteuerte Erweiterungen.

So installieren Sie Text Generation Web UI:

- Portable Builds (Empfohlen für den schnellen Start):

- Laden Sie den portablen Build von der Releases-Seite herunter.

- Entpacken Sie die heruntergeladene Datei.

- Führen Sie die ausführbare Datei aus.

- Manuelle portable Installation mit venv:

git clone https://github.com/oobabooga/text-generation-webui cd text-generation-webui python -m venv venv # On Windows: venv\Scripts\activate # On macOS/Linux: source venv/bin/activate pip install -r requirements/portable/requirements.txt --upgrade python server.py --portable --api --auto-launch deactivate - One-Click-Installer (Für fortgeschrittene Benutzer):

- Klonen Sie das Repository oder laden Sie den Quellcode herunter.

- Führen Sie das Startskript für Ihr Betriebssystem aus (start_windows.bat, start_linux.sh oder start_macos.sh).

- Wählen Sie Ihren GPU-Anbieter aus, wenn Sie dazu aufgefordert werden.

- Öffnen Sie nach der Installation

http://127.0.0.1:7860in Ihrem Browser.

Modelle herunterladen:

Modelle sollten im Ordner text-generation-webui/user_data/models abgelegt werden. GGUF-Modelle sollten direkt in diesen Ordner abgelegt werden, während andere Modelltypen in einem Unterordner abgelegt werden sollten.

Beispiel:

text-generation-webui

└── user_data

└── models

└── llama-2-13b-chat.Q4_K_M.gguf

text-generation-webui

└── user_data

└── models

└── lmsys_vicuna-33b-v1.3

├── config.json

├── generation_config.json

├── pytorch_model-00001-of-00007.bin

...

Sie können die UI auch verwenden, um Modelle automatisch von Hugging Face herunterzuladen, oder das Befehlszeilentool verwenden:

python download-model.py organization/model

Führen Sie python download-model.py --help aus, um alle Optionen anzuzeigen.

Für wen ist Text Generation Web UI geeignet?

Text Generation Web UI ist ideal für:

- Forscher und Entwickler, die mit LLMs arbeiten.

- KI-Enthusiasten, die mit Textgenerierung experimentieren möchten.

- Benutzer, die Wert auf Datenschutz legen und LLMs lokal ausführen möchten.

Nützliche Ressourcen:

Text Generation Web UI bietet eine leistungsstarke und vielseitige Plattform, um die Möglichkeiten der lokalen KI-Textgenerierung zu erkunden. Seine Benutzerfreundlichkeit, die umfangreichen Funktionen und das Engagement für den Datenschutz machen es zu einer ausgezeichneten Wahl für alle, die daran interessiert sind, mit großen Sprachmodellen zu ihren eigenen Bedingungen zu arbeiten.

Beste Alternativwerkzeuge zu "Text Generation Web UI"

AI Runner ist eine Offline-KI-Inferenz-Engine für Kunst, Echtzeit-Sprachkonversationen, LLM-gestützte Chatbots und automatisierte Arbeitsabläufe. Führen Sie Bilderzeugung, Voice-Chat und mehr lokal aus!

TemplateAI ist die führende NextJS-Vorlage für AI-Apps mit Supabase-Authentifizierung, Stripe-Zahlungen, OpenAI/Claude-Integration und einsatzbereiten AI-Komponenten für schnelle Full-Stack-Entwicklung.

Testsigma ist eine KI-gestützte No-Code-Testautomatisierungsplattform, die es Benutzern ermöglicht, automatisierte Tests über Web-, Mobil-, API- und ERP-Systeme hinweg zu generieren, auszuführen, zu analysieren, zu warten und zu optimieren. Es nutzt KI-Agenten, um Tests zu beschleunigen und die Wartung zu reduzieren.

Engagieren Sie sich schneller mit personalisierten LinkedIn-Kommentaren in Ihrer Stimme. Wachsen Sie Ihr Profil und Unternehmensseiten, dann unterstützen Sie sie mit Inhalten in über 15 Stilen, um Aufmerksamkeit zu erregen und Konversionen zu steigern.

Formix ist eine KI-gestützte Chrome-Erweiterung, die das Ausfüllen von Formularen durch intelligentes automatisches Ausfüllen und sicheren Datenschutz vereinfacht und mit allen Online-Formularen kompatibel ist.

Describe Picture: KI-gestützte Bildbeschreibungen, Textextraktion und Konvertierung. Verbessern Sie SEO und Barrierefreiheit mit intelligenter Bildanalyse.

Viinyx AI ist eine leistungsstarke KI-Browsererweiterung, die mehrere KI-Modelle wie ChatGPT, Gemini und Claude integriert und die Text- und Bilderzeugung, Zusammenfassung und mehr direkt in Ihrem Browser ermöglicht.

PayPerQ (PPQ.AI) bietet sofortigen Zugriff auf führende KI-Modelle wie GPT-4o mit Bitcoin und Crypto. Bezahlen pro Abfrage ohne Abonnements oder Registrierung, unterstützt Text-, Bild- und Videogenerierung.

Mit LM Studio können Sie lokale KI-Modelle wie gpt-oss, Qwen, Gemma und DeepSeek privat und kostenlos auf Ihrem Computer ausführen. Es unterstützt Entwicklerressourcen wie JS- und Python-SDKs.

LM-Kit bietet Toolkits der Enterprise-Klasse für die lokale KI-Agentenintegration und kombiniert Geschwindigkeit, Datenschutz und Zuverlässigkeit, um Anwendungen der nächsten Generation zu unterstützen. Nutzen Sie lokale LLMs für schnellere, kostengünstigere und sicherere KI-Lösungen.

Enclave AI ist ein datenschutzorientierter KI-Assistent für iOS und macOS, der vollständig offline läuft. Er bietet lokale LLM-Verarbeitung, sichere Konversationen, Voice-Chat und Dokumenteninteraktion, ohne dass eine Internetverbindung erforderlich ist.

Private LLM ist ein lokaler KI-Chatbot für iOS und macOS, der offline funktioniert und Ihre Informationen vollständig auf dem Gerät, sicher und privat hält. Genießen Sie unzensierte Chats auf Ihrem iPhone, iPad und Mac.

Testen Sie DeepSeek V3 kostenlos online ohne Registrierung. Dieses leistungsstarke Open-Source-KI-Modell umfasst 671B Parameter, unterstützt kommerzielle Nutzung und bietet unbegrenzten Zugriff über Browser-Demo oder lokale Installation auf GitHub.

Laden Sie GPT4Audio herunter, die KI-gestützte Sprache-zu-Text-Desktop-Anwendung für effiziente Audiotranskription und -übersetzung. Steigern Sie jetzt Ihre Produktivität!