Weco AI

Übersicht von Weco AI

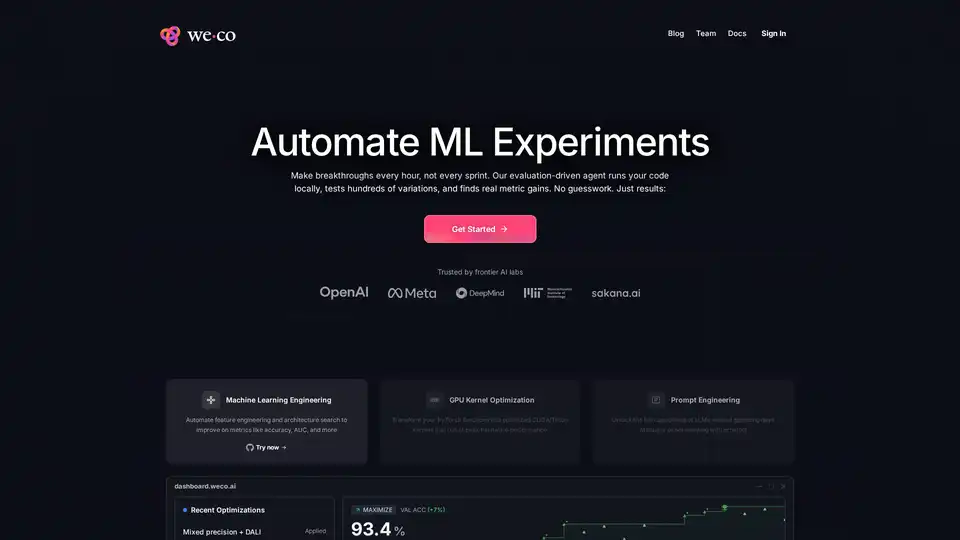

Was ist Weco AI?

Weco AI ist eine fortschrittliche Plattform für maschinelles Lernen, die ML-Experimente mithilfe von AIDE ML-Technologie automatisiert. Dieses innovative System setzt auf Agenten, die von großen Sprachmodellen angetrieben werden, um maschinelle Lernpipelines durch evaluierungsgesteuerte Experimente systematisch zu optimieren.

Wie funktioniert Weco AI?

Die Plattform arbeitet in einem ausgeklügelten dreistufigen Prozess:

1. Lokales Evaluierungssystem

Weco AI führt Ihren Code lokal auf Ihrer eigenen Infrastruktur aus, gewährleistet Datenschutz und behält gleichzeitig die vollständige Kontrolle über Ihre ML-Umgebung. Das System verbindet sich über eine einfache Befehlszeilenschnittstelle mit Ihren Evaluierungsskripten.

2. Automatisierte Experimentierung

Mit AIDE ML-Agenten testet Weco systematisch Hunderte von Codevarianten, einschließlich:

- Architekturmodifikationen (Änderungen der Modellstruktur)

- Hyperparameteroptimierung (Lernraten, Batch-Größen)

- Datenanreicherungstechniken (CutMix, RandAugment)

- Leistungsoptimierungen (gemischte Präzision, CUDA-Kernel)

- Verbesserungen der Trainingsmethodik (Planeränderungen, Regularisierungstechniken)

3. Metrikgesteuerte Optimierung

Das System bewertet kontinuierlich die Leistung anhand Ihrer spezifizierten Metriken (Genauigkeit, AUC, Durchsatz usw.) und entwickelt Lösungen basierend auf empirischen Ergebnissen, wodurch eine Baumsuche erfolgreicher Variationen erstellt wird.

Kernfunktionen und Fähigkeiten

🚀 Automatisierte ML-Entwicklung

- Automatisierung der Feature-Entwicklung: Systematische Erforschung und Implementierung von Feature-Transformationen

- Architektursuche: Testet verschiedene Modellarchitekturen und Konfigurationen

- Hyperparameteroptimierung: Automatische Erforschung optimaler Parameterkombinationen

⚡ GPU-Kernel-Optimierung

- CUDA/Triton-Kernel-Generierung: Wandelt PyTorch-Funktionen in optimierte GPU-Kernel um

- Maximierung der Hardwareleistung: Erreicht maximale Hardwareauslastung

- Implementierung gemischter Präzision: Führt automatisch FP16/FP32-gemischtes Training durch

🤖 Automatisierung des Prompt-Engineerings

- LLM-Optimierung: Experimentiert automatisch mit Prompt-Variationen

- Systematisches Testen: Bewertet Hunderte von Prompt-Kombinationen

- Leistungsverfolgung: Misst und vergleicht die Ausgabequalität von LLMs

Praktische Anwendungen und Use Cases

Weco AI glänzt in mehreren ML-Szenarien:

Forschung und Entwicklung

- Akademische Forschung: Beschleunigt ML-Forschung durch Automatisierung von Experimenten

- Industrie-R&D: Beschleunigt Produktentwicklungszyklen

- Benchmark-Optimierung: Verbessert die Leistung bei standardisierten Benchmarks

Produktions-ML-Systeme

- Modellleistungsverbesserung: Erhöht Genauigkeit und Effizienz von Produktionsmodellen

- Infrastrukturoptimierung: Reduziert Rechenkosten durch bessere Ressourcennutzung

- Bereitschaft zur Bereitstellung: Stellt sicher, dass Modelle für Produktionsumgebungen optimiert sind

Spezialisierte Optimierungsaufgaben

- Computervision-Modelle: Optimiert CNNs, Transformer und andere Vision-Architekturen

- NLP-Systeme: Verbessert Leistung und Effizienz von Sprachmodellen

- Verstärkendes Lernen: Optimiert RL-Algorithmen und Umgebungen

Technische Implementierung

Die Plattform unterstützt mehrere Programmiersprachen und Frameworks:

- Hauptsprache: Python (PyTorch, TensorFlow, JAX)

- Zusätzliche Unterstützung: C++, Rust, JavaScript

- Framework-Kompatibilität: Funktioniert mit großen ML-Frameworks und benutzerdefinierten Implementierungen

- Hardware-Flexibilität: Unterstützt verschiedene GPU-Architekturen (NVIDIA, AMD, Apple Silicon)

Leistung und Ergebnisse

Weco AI hat signifikante Verbesserungen in verschiedenen Benchmarks demonstriert:

- CIFAR-10-Validierung: Erzielte +7 % Genauigkeitsverbesserung gegenüber der Basislinie

- ResNet-18-Optimierung: 2,3-fache Beschleunigung durch gemischte Präzision und DALI-Implementierung

- OpenAI MLE-Bench: 4-mal mehr Medaillen als der nächstbeste autonome Agent

- METR RE-Bench: Übertraf menschliche Experten in 6-stündigen Optimierungsherausforderungen

Für wen ist Weco AI?

Zielgruppe

- ML-Ingenieure: Fachleute, die ihre Workflows automatisieren und optimieren möchten

- KI-Forscher: Akademiker und Forscher, die Experimente beschleunigen möchten

- Data Scientists: Praktiker, die Modellleistung effizient verbessern möchten

- Technologieunternehmen: Organisationen, die ihre ML-Operationen skalieren möchten

Qualifikationsanforderungen

- Mittlere ML-Kenntnisse: Verständnis von Konzepten des maschinellen Lernens

- Programmierkenntnisse: Vertrautheit mit Python und ML-Frameworks

- Experimentelle Denkweise: Bereitschaft, automatisierte Experimente zu nutzen

Erste Schritte mit Weco AI

Die Plattform bietet einen unkomplizierten Onboarding-Prozess:

- Installation:

pip install weco - Konfiguration: Zeigen Sie auf Ihr Evaluierungsskript

- Ausführung: Führen Sie Optimierungsbefehle aus

- Überwachung: Verfolgen Sie den Echtzeit-Fortschritt über das Dashboard

Die durchschnittliche Onboarding-Zeit beträgt weniger als 10 Minuten, was es für Teams jeder Größe zugänglich macht.

Warum Weco AI wählen?

Wettbewerbsvorteile

- Datenschutz-first-Ansatz: Ihre Daten verlassen niemals Ihre Infrastruktur

- Kosteneffizienz: Erreicht mehr mit weniger Rechenressourcen

- Systematische Methodik: Basierend auf bewährter AIDE ML-Forschung

- Bewährte Ergebnisse: Nachgewiesener Erfolg in mehreren Benchmarks

- Open-Source-Basis: Kerntechnologie ist offen für Überprüfung und Beiträge

Vergleich mit Alternativen

Im Gegensatz zu One-Shot-Codegenerierungstools setzt Weco AI auf systematische Evaluierung und Iteration, um messbare Verbesserungen statt spekulativer Änderungen zu gewährleisten.

Preise und Zugänglichkeit

Weco AI verwendet ein kreditbasiertes Preissystem:

- Free-Tier: 20 Credits (ca. 100 Optimierungsschritte)

- Keine Kreditkarte erforderlich für die Erstnutzung

- Transparente Preisgestaltung: Klare Kostenstruktur basierend auf Optimierungsschritten

Die Plattform bietet einen ausgezeichneten Wert für ML-Teams, die ihre Forschungs- und Entwicklungszyklen beschleunigen möchten, während sie die Kontrolle über ihre Daten und Infrastruktur behalten.

Beste Alternativwerkzeuge zu "Weco AI"

Drafter AI ist eine No-Code-Plattform, die es Benutzern ermöglicht, KI-gestützte Tools und Automatisierungen ohne Programmierung zu erstellen. Es integriert über 100 Datenquellen und KI-Technologien und ermöglicht so eine mühelose KI-Entwicklung und Workflow-Automatisierung.

TestGrid ist eine KI-gestützte End-to-End-Testplattform, die Softwaretests mit Funktionen wie Codeless Testing, Cross-Browser-Testing und Mobile App-Testing vereinfacht. Es hilft Teams, Software schneller zu veröffentlichen und die Qualität sicherzustellen.

i10X ist ein KI-Agenten-Marktplatz, der über 500 KI-Tools für Chat, Bilderzeugung, Dokumentenanalyse und mehr bietet. Sparen Sie Zeit und Kosten mit diesem All-in-One-KI-Arbeitsbereich. Testen Sie es risikofrei!

Fynite ist eine KI-Automatisierungsplattform für Unternehmen, die Daten vereinheitlicht, domänenspezifische Modelle trainiert und autonome KI-Agenten einsetzt, um Ergebnisse mit Geschwindigkeit, Skalierbarkeit und Vertrauen auszuführen.

Substrate ist die ultimative Plattform für Compound AI mit leistungsstarken SDKs, die optimierte Modelle, Vektorspeicher, Code-Interpreter und agentische Steuerung bieten. Bauen Sie effiziente Multi-Step-AI-Workflows schneller als je zuvor – verabschieden Sie sich von LangChain für optimierte Entwicklung.

Chatlify ist ein KI-gestützter Chatbot, der den Kundensupport und den Vertrieb für Unternehmen revolutioniert. Er bietet 24/7-Unterstützung, personalisierte Empfehlungen, mehrsprachigen Support und nahtlose Integration, um Engagement und Effizienz zu steigern.

Yugo vereinfacht die Integration von KI in Web-Dienste durch automatisierte API-Analyse, personalisierte Funktionsempfehlungen und Ein-Klick-Implementierung, wodurch Entwickler effizient fortschrittliche Anwendungen erstellen können.

Xander ist eine Open-Source-Desktop-Plattform, die No-Code-KI-Modelltraining ermöglicht. Beschreiben Sie Aufgaben in natürlicher Sprache für automatisierte Pipelines in Textklassifikation, Bildanalyse und LLM-Fine-Tuning, mit Garantie für Datenschutz und Leistung auf Ihrem lokalen Gerät.

ML Blocks ist eine No-Code-Plattform, die es Benutzern ermöglicht, KI-gestützte Workflows für die Bildgenerierung, -bearbeitung und -analyse zu erstellen. Drag-and-Drop-Tools erleichtern die Automatisierung mit Modellen wie Stable Diffusion und transparenter Nutzungsbezahlung.

AI Bucket ist das führende Verzeichnis für die besten KI-Tools mit einer umfangreichen Sammlung von über 2000 KI-Tools in mehr als 20 Kategorien.

Sagify ist ein Open-Source-Python-Tool, das Machine-Learning-Pipelines auf AWS SageMaker vereinfacht und eine einheitliche LLM-Gateway für die nahtlose Integration proprietärer und Open-Source-Großsprachmodelle bietet.

Quantum Copilot ist ein KI-unterstütztes Tool für Quantencomputing, das es Benutzern ermöglicht, in einfacher Sprache zu programmieren, Quantencode zu generieren, Schaltungen zu simulieren und auf realer Hardware auszuführen – ideal für Anfänger und Experten.

Testen Sie DeepSeek V3 kostenlos online ohne Registrierung. Dieses leistungsstarke Open-Source-KI-Modell umfasst 671B Parameter, unterstützt kommerzielle Nutzung und bietet unbegrenzten Zugriff über Browser-Demo oder lokale Installation auf GitHub.

Qubinets ist eine Open-Source-Plattform, die die Bereitstellung und Verwaltung von KI- und Big-Data-Infrastruktur vereinfacht. Einfaches Erstellen, Verbinden und Bereitstellen. Konzentrieren Sie sich auf den Code, nicht auf die Konfiguration.