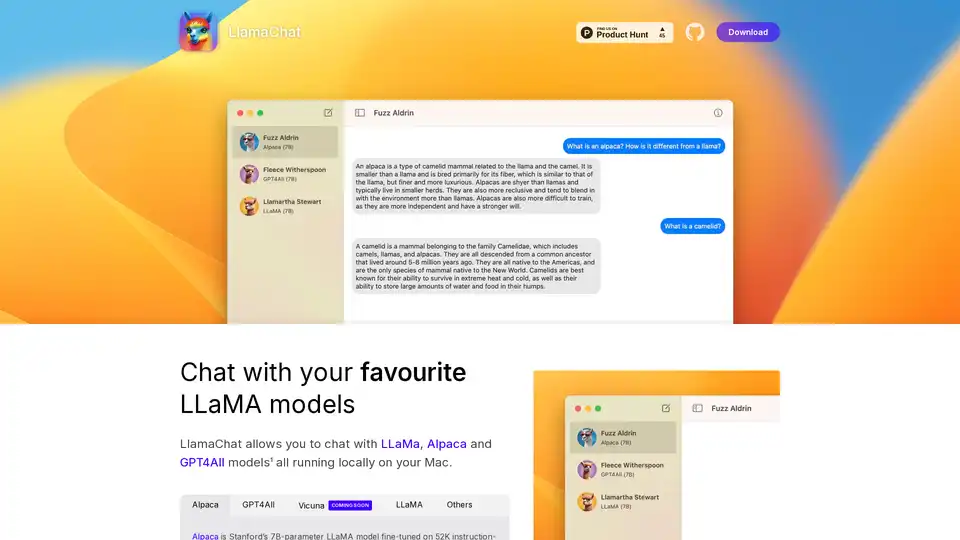

LlamaChat

Descripción general de LlamaChat

LlamaChat: Chatea con modelos LLaMA locales en tu Mac

¿Qué es LlamaChat? LlamaChat es una aplicación para macOS que permite a los usuarios interactuar con varios Modelos de Lenguaje Grandes (LLMs) como LLaMA, Alpaca y GPT4All directamente en su Mac, sin depender de servicios basados en la nube. Esto significa que los modelos se ejecutan localmente, ofreciendo mayor privacidad y control.

Características y Funcionalidad Clave

- Soporte Local de LLM: LlamaChat soporta múltiples LLMs incluyendo LLaMA, Alpaca y GPT4All, todos ejecutándose localmente en tu Mac.

- Conversión de Modelos: LlamaChat puede importar puntos de control de modelos PyTorch sin procesar o archivos de modelos .ggml pre-convertidos para facilitar su uso.

- Código Abierto: Impulsado por bibliotecas de código abierto como llama.cpp y llama.swift, asegurando transparencia y desarrollo impulsado por la comunidad.

- Gratuito y de Código Abierto: LlamaChat es completamente gratuito y de código abierto, asegurando accesibilidad y contribución de la comunidad.

Modelos Soportados

- Alpaca: Modelo LLaMA de 7B parámetros de Stanford, ajustado en 52K demostraciones de seguimiento de instrucciones generadas a partir del text-davinci-003 de OpenAI.

- GPT4All: Un LLM de código abierto.

- Vicuna: Un LLM de código abierto.

- LLaMA: El LLM fundacional de Meta.

¿Cómo funciona LlamaChat?

LlamaChat aprovecha bibliotecas de código abierto para ejecutar LLMs directamente en tu máquina. Está construido usando llama.cpp y llama.swift. Esto te permite convertir e importar puntos de control de modelos PyTorch sin procesar o archivos de modelos .ggml pre-convertidos.

¿Cómo usar LlamaChat?

- Descargar: Descarga LlamaChat desde el sitio web oficial o usando

brew install --cask llamachat. - Instalar: Instala la aplicación en tu macOS 13 o posterior.

- Importar Modelos: Importa tus modelos LLaMA, Alpaca o GPT4All en la aplicación.

- Chatear: Comienza a chatear con tus modelos LLM favoritos localmente.

¿Por qué elegir LlamaChat?

- Privacidad: Ejecuta modelos localmente sin enviar datos a servidores externos.

- Control: Control total sobre los modelos y los datos utilizados.

- Rentable: Sin cuotas de suscripción ni cargos por uso.

- Código Abierto: Benefíciate de las mejoras impulsadas por la comunidad y la transparencia.

¿Para quién es LlamaChat?

LlamaChat es ideal para:

- Desarrolladores: Experimentar con LLMs en máquinas locales.

- Investigadores: Realizar investigaciones sin depender de servicios externos.

- Usuarios Conscientes de la Privacidad: Usuarios que desean mantener sus datos locales y privados.

Instalación

LlamaChat puede ser instalado vía:

- Descargar: Directamente desde la página de GitHub del proyecto o Product Hunt.

- Homebrew: Usando el comando

brew install --cask llamachat.

Bibliotecas de Código Abierto

LlamaChat está construido sobre:

- llama.cpp: Para la inferencia eficiente de LLMs en la CPU.

- llama.swift: Proporcionando una interfaz nativa de macOS para LLMs.

Descargo de Responsabilidad

LlamaChat no está afiliado a Meta Platforms, Inc., Leland Stanford Junior University, o Nomic AI, Inc. Los usuarios son responsables de obtener e integrar los archivos de modelo apropiados de acuerdo con los respectivos términos y condiciones establecidos por sus proveedores.

Mejores herramientas alternativas a "LlamaChat"

Private LLM es un chatbot de IA local para iOS y macOS que funciona sin conexión, manteniendo su información completamente en el dispositivo, segura y privada. Disfrute de un chat sin censura en su iPhone, iPad y Mac.

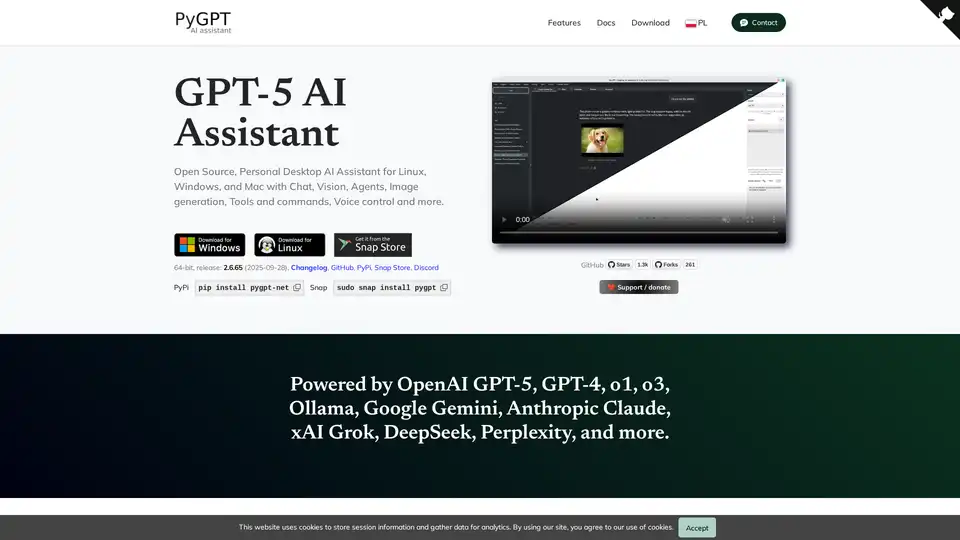

PyGPT es un asistente de IA de escritorio de código abierto y gratuito para Windows, macOS y Linux. Ofrece chat, visión, agentes, generación de imágenes, control por voz y más, impulsado por modelos como GPT-5, GPT-4, Google Gemini y otros.

Nexa SDK permite una inferencia de IA rápida y privada en el dispositivo para modelos LLM, multimodales, ASR y TTS. Implemente en dispositivos móviles, PC, automotrices e IoT con un rendimiento listo para producción en NPU, GPU y CPU.

Enclave AI es un asistente de IA centrado en la privacidad para iOS y macOS que se ejecuta completamente sin conexión. Ofrece procesamiento local de LLM, conversaciones seguras, chat de voz e interacción con documentos sin necesidad de una conexión a Internet.

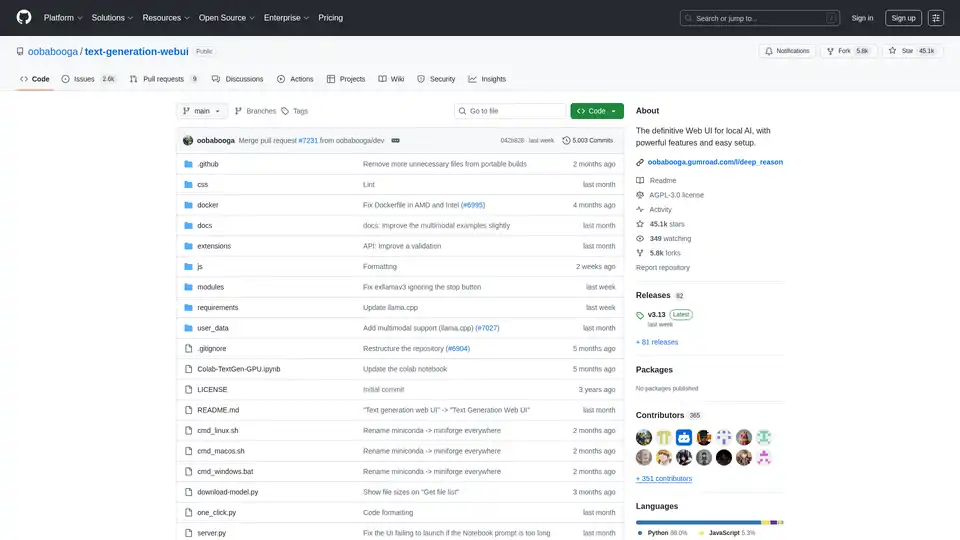

Text Generation Web UI es una interfaz web Gradio potente y fácil de usar para modelos de lenguaje grandes de IA local. Admite múltiples backends, extensiones y ofrece privacidad sin conexión.

Repo Prompt mejora la codificación asistida por IA con ingeniería de contexto visual, mapas de código e integración del servidor MCP, lo que permite interacciones de IA más rápidas y precisas con su base de código. Perfecto para desarrolladores que utilizan herramientas de IA.

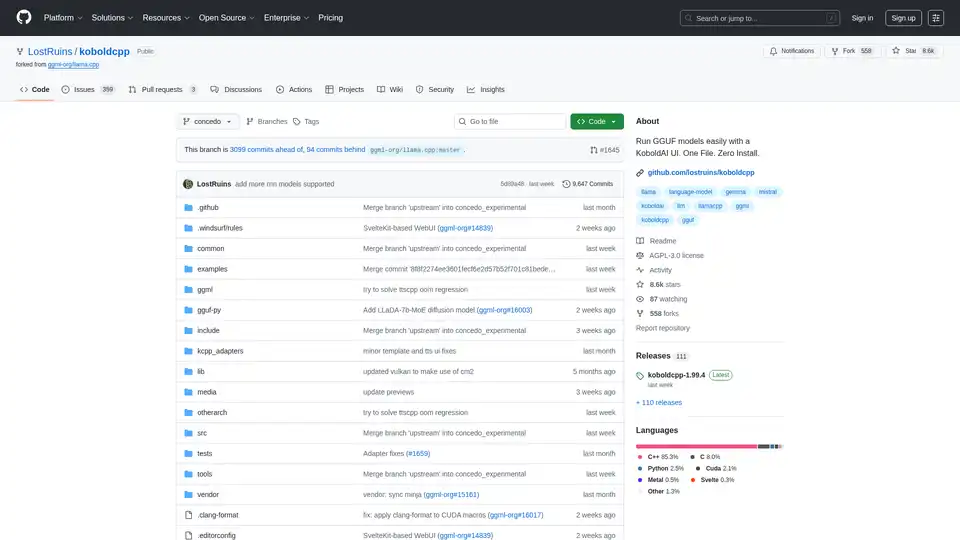

KoboldCpp: Ejecuta modelos GGUF fácilmente para generación de texto e imágenes con IA usando una interfaz de KoboldAI. Un solo archivo, sin instalación. Compatible con CPU/GPU, STT, TTS y Stable Diffusion.

Chatea con IA usando tus claves API. Paga solo por lo que uses. Soporta GPT-4, Gemini, Claude y otros LLMs. La mejor interfaz de chat frontend LLM para todos los modelos de IA.

Remind AI es una herramienta de memoria artificial local de código abierto que captura tus actividades digitales con IA avanzada, impulsando la productividad sin dependencia de la nube. Descarga y personaliza para uso personal.

GrammarBot es un corrector de gramática y ortografía con IA para MacOS que funciona sin conexión. Descarga la aplicación y el modelo de IA una vez y mejora tu inglés para siempre. Licencia personal $12.

AnythingLLM es una aplicación de IA todo en uno que te permite chatear con tus documentos, mejorar tu productividad y ejecutar LLM de última generación de forma local y privada. Aprovecha los agentes de IA y los modelos personalizados sin necesidad de configuración.

LM Studio: Ejecute LLaMa, MPT, Gemma y otros LLM localmente en su computadora portátil. Descargue modelos compatibles de Hugging Face y utilícelos sin conexión.

RecurseChat: Una aplicación de IA personal que te permite hablar con IA local, sin conexión y chatear con archivos PDF y markdown.

MacCopilot: Copilot AI nativo para macOS. Interactúa con cualquier contenido de la pantalla usando GPT-4o, ClaudeAI y Google Gemini.