llmarena.ai

Descripción general de llmarena.ai

¿Qué es llmarena.ai?

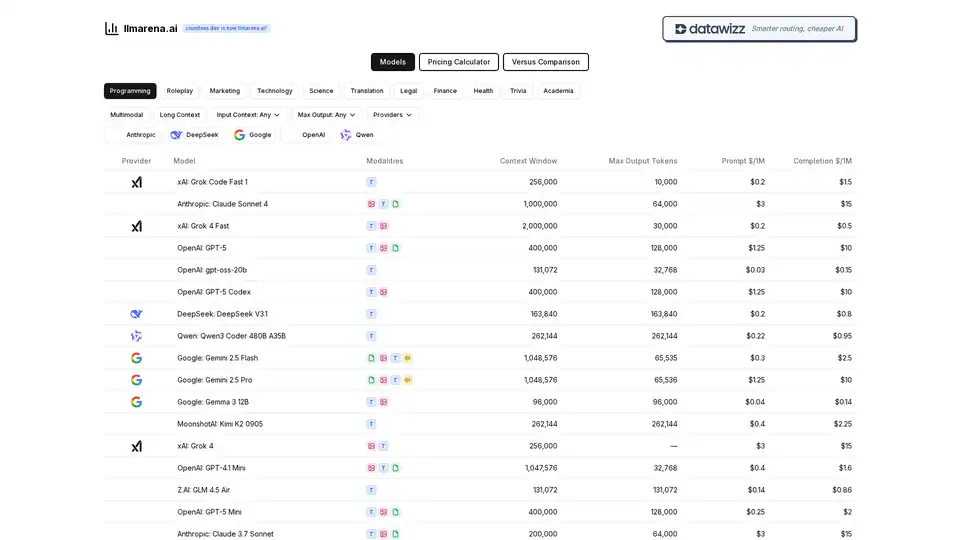

llmarena.ai es una potente plataforma en línea diseñada para simplificar el proceso de comparación de modelos de lenguaje grandes (LLMs) de diversos proveedores de IA. Anteriormente conocida como countless.dev, ha evolucionado hacia una herramienta más inteligente y eficiente para el enrutamiento y optimización del uso de IA, manteniendo los costos bajo control. Ya seas un desarrollador, investigador o profesional de negocios, llmarena.ai reúne modelos de los principales proveedores como OpenAI, Anthropic, Google, xAI, DeepSeek, Qwen y otros en un centro centralizado. Esto facilita más que nunca evaluar opciones basadas en métricas clave como precios, ventanas de contexto, capacidades de salida y modalidades, ayudando a los usuarios a tomar decisiones informadas sin revisar documentación dispersa.

En su núcleo, llmarena.ai aborda un punto de dolor común en el rápidamente expansivo panorama de la IA: la complejidad de elegir el LLM adecuado. Con los modelos de IA avanzando rápidamente, los proveedores actualizan frecuentemente características y precios, haciendo que las comparaciones sean una tarea que consume tiempo. Esta herramienta agiliza eso ofreciendo insights en tiempo real sobre el rendimiento de los modelos, asegurando que selecciones la opción más rentable y adecuada para tus necesidades específicas, ya sea tareas de programación, generación de contenido o análisis de datos.

¿Cómo funciona llmarena.ai?

La plataforma opera como un comparador web intuitivo, extrayendo datos directamente de los proveedores para mostrar información actualizada. Los usuarios pueden acceder a varias secciones clave, incluyendo una Calculadora de Precios, herramienta de Comparación Versus y exploraciones de modelos categorizados como Programación, Roleplay, Marketing, Tecnología, Ciencia, Traducción, Legal, Finanzas, Salud, Trivia, Académica, Multimodal y modelos de Contexto Largo.

Aquí hay un desglose de sus funcionalidades principales:

- Listados de Modelos y Especificaciones: La tabla principal categoriza modelos por proveedor y resalta especificaciones esenciales. Por ejemplo, muestra modalidades (principalmente Texto, o 'T'), ventanas de contexto (p. ej., hasta 2.000.000 tokens para Grok 4 Fast de xAI), tokens de salida máximos y precios por millón de tokens para prompts y completaciones. Esto permite un escaneo rápido de capacidades—como Claude Sonnet 4 de Anthropic ofreciendo una masiva ventana de contexto de 1.000.000 tokens a $3/$15 por millón de tokens.

- Calculadora de Precios: Una herramienta interactiva donde los usuarios ingresan sus escenarios de uso (p. ej., volúmenes de tokens de entrada/salida) para estimar costos en modelos. Esto es invaluable para presupuestos, especialmente al comparar opciones amigables con el presupuesto como Gemma 3 12B de Google ($0.04/$0.14) contra premium como Claude Opus 4.1 de Anthropic ($15/$75).

- Comparación Versus: Evaluaciones lado a lado de dos o más modelos, enfocándose en características como flexibilidad de contexto de entrada (Any) y límites de salida máximos. Es perfecta para enfrentamientos directos, como enfrentar GPT-5 de OpenAI (400.000 contexto, $1.25/$10) contra Gemini 2.5 Pro de Google (1.048.576 contexto, $1.25/$10).

- Casos de Uso Categorizados: Los modelos están etiquetados para dominios específicos, ayudando a los usuarios a filtrar para aplicaciones relevantes. Por ejemplo, bajo Programación, podrías explorar Grok Code Fast 1 de xAI o GPT-5 Codex de OpenAI, ambos optimizados para generación de código con precios competitivos.

La plataforma enfatiza 'enrutamiento más inteligente'—sugiriendo modelos óptimos basados en tu tarea—mientras prioriza 'IA más barata' a través de desgloses de costos transparentes. Todos los datos se presentan en un formato tabular limpio para una lectura fácil, sin necesidad de cálculos manuales.

Características Clave y Destacados de Modelos

llmarena.ai se destaca con su cobertura integral de LLMs líderes. Aquí hay una instantánea de algunos modelos destacados:

| Provider | Model | Context Window | Max Output Tokens | Prompt $/1M | Completion $/1M |

|---|---|---|---|---|---|

| xAI | Grok Code Fast 1 | 256,000 | 10,000 | $0.2 | $1.5 |

| Anthropic | Claude Sonnet 4 | 1,000,000 | 64,000 | $3 | $15 |

| OpenAI | GPT-5 | 400,000 | 128,000 | $1.25 | $10 |

| Gemini 2.5 Flash | 1,048,576 | 65,535 | $0.3 | $2.5 | |

| DeepSeek | DeepSeek V3.1 | 163,840 | 163,840 | $0.2 | $0.8 |

| Qwen | Qwen3 Coder 480B A35B | 262,144 | 262,144 | $0.22 | $0.95 |

Estos ejemplos ilustran la diversidad: modelos de presupuesto como gpt-oss-20b de OpenAI ($0.03/$0.15) para tareas ligeras, o de alta capacidad como Grok 4 Fast de xAI para contextos extensos. Características como soporte multimodal (aunque mayormente enfocado en texto aquí) y manejo de contexto largo atienden a casos de uso avanzados, como procesar grandes documentos en entornos legales o académicos.

La herramienta también soporta entradas (Any) y salidas flexibles, haciéndola adaptable para todo, desde consultas rápidas de trivia hasta análisis científicos en profundidad.

Escenarios de Uso y Valor Práctico

llmarena.ai brilla en escenarios donde la selección de modelos impacta la eficiencia y los gastos:

- Desarrolladores y Codificadores: Usa la categoría de Programación para comparar modelos enfocados en código como Qwen3 Coder Plus o GPT-5 Codex de OpenAI. Calcula rápidamente costos para sesiones de codificación iterativas, ahorrando en llamadas a API.

- Creadores de Contenido y Marketers: Para tareas de Marketing o Roleplay, evalúa modelos como Claude 3.7 Sonnet para escritura creativa, asegurando salidas de alta calidad sin gastar de más.

- Investigadores y Académicos: En secciones de Ciencia o Académica, selecciona modelos de contexto largo para analizar papers o datasets, con herramientas como Gemini 2.5 Pro manejando entradas de millón de tokens.

- Aplicaciones Empresariales: Categorías de Finanzas, Legal y Salud ayudan a profesionales a elegir modelos compliant y rentables—p. ej., GLM 4.5 Air para traducción asequible en operaciones multilingües.

- Experimentación General con IA: Los filtros de Trivia o Multimodal permiten a usuarios casuales probar capacidades diversas, desde prompts divertidos hasta integraciones multimodales complejas.

El valor práctico radica en su agregación ahorradora de tiempo: en lugar de visitar múltiples sitios de proveedores (OpenAI, Anthropic, Google, etc.), todo está en un solo lugar. Los usuarios pueden evitar el lock-in de proveedores al detectar alternativas—p. ej., cambiar de Claude Opus costoso a DeepSeek V3.1 más barato para rendimiento similar. Para equipos, la calculadora de precios ayuda en pronósticos de presupuestos de API, potencialmente reduciendo costos en un 50% o más a través de elecciones optimizadas.

¿Para quién es llmarena.ai?

Esta herramienta es ideal para:

- Entusiastas y Aficionados de IA: Aquellos experimentando con LLMs en un presupuesto.

- Ingenieros de Software: Necesitando asistentes de codificación confiables sin tarifas altas.

- Científicos de Datos: Comparando modelos para pipelines de machine learning.

- Usuarios Empresariales: En campos de finanzas o legales requiriendo IA precisa y escalable.

- Educadores y Estudiantes: Explorando modelos enfocados en academia para investigación.

No es adecuada para quienes buscan plataformas completas de entrenamiento de modelos, pero perfecta para fases de despliegue y selección.

¿Por qué elegir llmarena.ai?

En un mercado de IA saturado, llmarena.ai se diferencia con su enfoque en transparencia y usabilidad. No se requieren registros para comparaciones básicas, y la interfaz es responsive para chequeos rápidos en móvil. Actualizaciones regulares aseguran que las especificaciones reflejen los lanzamientos más recientes, como modelos emergentes de MoonshotAI o Z.AI. Al empoderar enrutamiento más inteligente, no solo reduce costos sino que mejora la productividad—los usuarios reportan inicios de proyectos más rápidos y mejor asignación de recursos.

Para los mejores resultados, empieza con la Calculadora de Precios para tu carga de trabajo, luego usa Versus para ajustes finos. Ya sea que optimices por velocidad, costo o longitud de contexto, llmarena.ai convierte la complejidad de LLMs en claridad, haciendo que la IA avanzada sea accesible para todos.

Mejores herramientas alternativas a "llmarena.ai"

TeamAI es una plataforma multi-LLM que permite a los equipos acceder y colaborar con modelos de IA como Gemini, DeepSeek y OpenAI en un solo lugar. Ofrece ahorro de costos, bibliotecas de avisos compartidas y creación de agentes de IA sin código.

Joythee AI es una aplicación complementaria de IA diseñada para conversaciones atractivas y edificantes. Ofrece funciones como chat con múltiples agentes de IA, modo de incógnito, experiencias personalizadas y actualizaciones continuas.

ChatOrDie.ai ofrece chat anónimo con los mejores modelos de IA como Grok, ChatGPT, Gemini y Deepseek. Compare respuestas, detecte sesgos y disfrute de interacciones de IA privadas y sin filtros.

Los agentes de IA de Patsnap Eureka automatizan los flujos de trabajo de gran intensidad de mano de obra para IP, I+D, ciencias de la vida y materiales, lo que permite a los expertos centrarse en decisiones e innovación de alto impacto. Ofrece resultados precisos, proporcionando información fiable.

Friendli Inference es el motor de inferencia LLM más rápido, optimizado para la velocidad y la rentabilidad, reduciendo los costos de GPU en un 50-90% al tiempo que ofrece un alto rendimiento y baja latencia.

Mercury de Inception, los LLM de difusión más rápidos para aplicaciones de IA. Potenciando la codificación, la voz, la búsqueda y los agentes de vanguardia con una inferencia increíblemente rápida y una calidad de vanguardia.

Aicado.ai proporciona una herramienta de comparación de modelos de IA en paralelo, incluyendo GPT-4o, Claude, Llama y más. Prueba prompts en tiempo real y analiza el rendimiento de la IA.

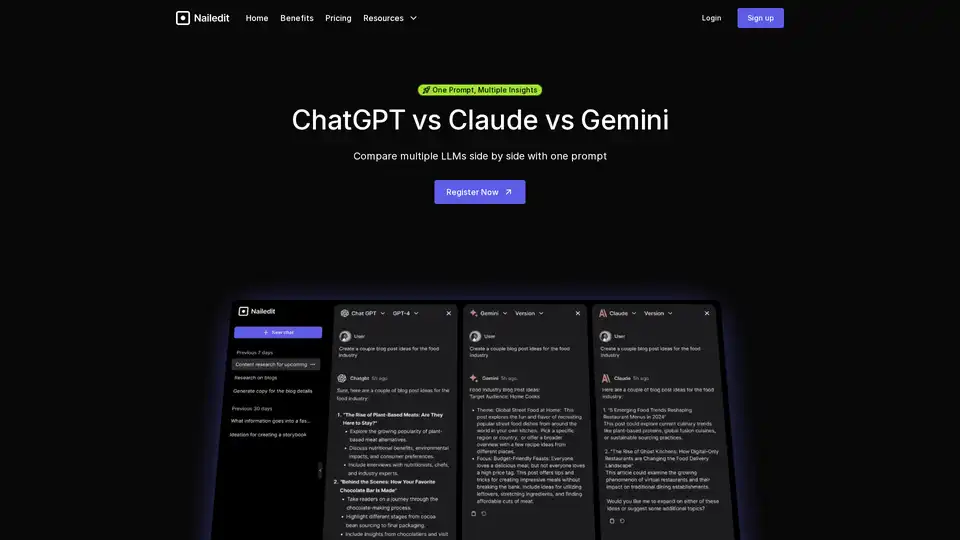

NailedIt te permite comparar instantáneamente las respuestas de ChatGPT, Claude y Gemini. Simplifica tu flujo de trabajo y encuentra las mejores ideas de múltiples modelos de IA con una sola instrucción.

PriceResonance es una plataforma impulsada por IA para el seguimiento, análisis y optimización de precios competitivos. Rastrea los precios de la competencia, analiza las tendencias y optimiza tu estrategia de precios.

Mejora APM con OpenLIT, una plataforma de código abierto en OpenTelemetry. Simplifica el desarrollo de IA con trazas y métricas unificadas en una interfaz potente, optimizando la observabilidad de LLM y GenAI.

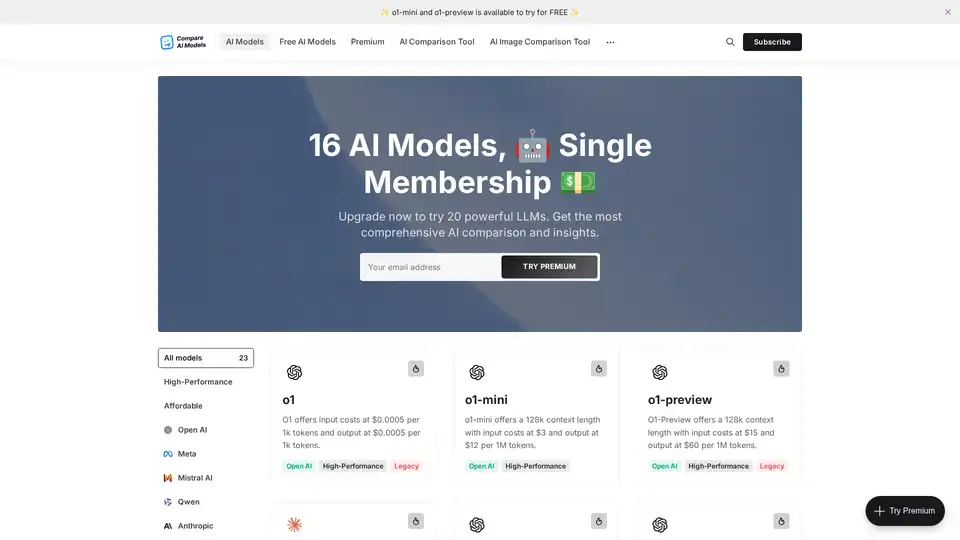

Compare los precios de los modelos de IA para ChatGPT, Claude, Gemini y más con AI Models Pricing. Calcule los costos y encuentre la solución de IA más rentable para sus necesidades.

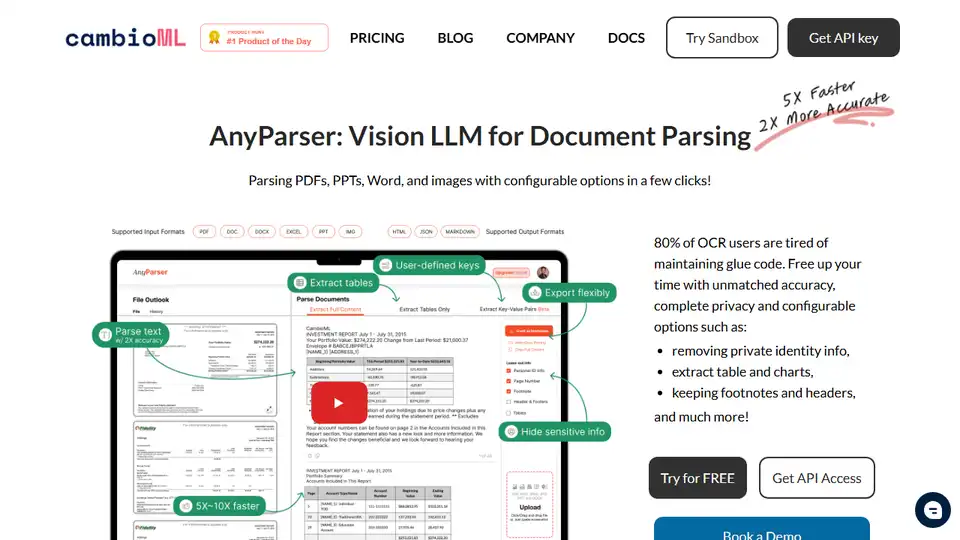

AnyParser: Visión LLM para el análisis de documentos. Extrae con precisión texto, tablas, gráficos y diseño de PDF, PPT e imágenes. Prioriza la privacidad y la integración empresarial.

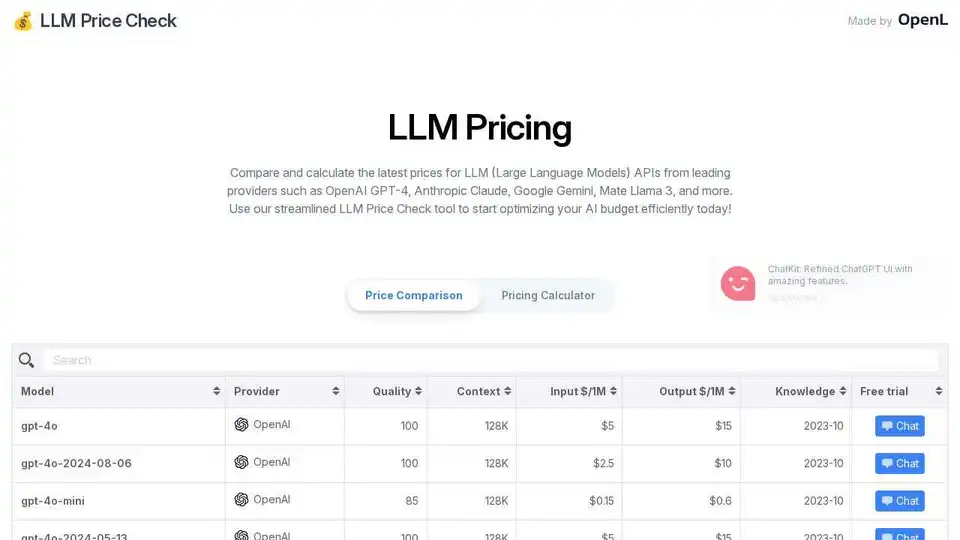

Compare los precios de la API LLM de OpenAI, Anthropic, Google y más. Optimice su presupuesto de IA con la calculadora de precios optimizada de LLM Price Check.

Cabina.AI ofrece acceso a GPT-4, Claude, LLama y más, todo en un solo lugar. Chatea con PDF, analiza archivos, transcribe audio, genera video e imágenes. ¡Empieza gratis!