Local AI

Descripción general de Local AI

AI Local: Tu Campo de Juego Privado de IA

¿Qué es AI Local? AI Local es una aplicación nativa gratuita y de código abierto diseñada para simplificar el proceso de experimentar con modelos de AI localmente. Permite a los usuarios ejecutar inferencias de AI sin conexión y en privado, sin necesidad de una GPU.

Características Clave de AI Local:

- Inferencia de CPU: Se adapta a los hilos disponibles y admite la cuantificación GGML (q4, 5.1, 8, f16).

- Gestión de Modelos: Ubicación centralizada para realizar un seguimiento de los modelos de AI, con descargas reanudables y clasificación basada en el uso.

- Verificación de Digest: Garantiza la integridad de los modelos descargados con las funciones de cálculo de digest BLAKE3 y SHA256.

- Servidor de Inferencia: Inicie un servidor de transmisión local para la inferencia de AI con solo unos clics.

¿Cómo funciona AI Local?

AI Local aprovecha un backend de Rust para la eficiencia de la memoria y una huella compacta (menos de 10 MB en Mac M2, Windows y Linux .deb). La aplicación proporciona una interfaz fácil de usar para:

- Descargar y administrar modelos de AI de varias fuentes.

- Verificar la integridad de los modelos descargados utilizando digests criptográficos.

- Ejecutar sesiones de inferencia en la CPU sin necesidad de una GPU.

- Iniciar un servidor de transmisión local para la inferencia de AI.

¿Cómo usar AI Local?

El uso de AI Local está diseñado para ser sencillo:

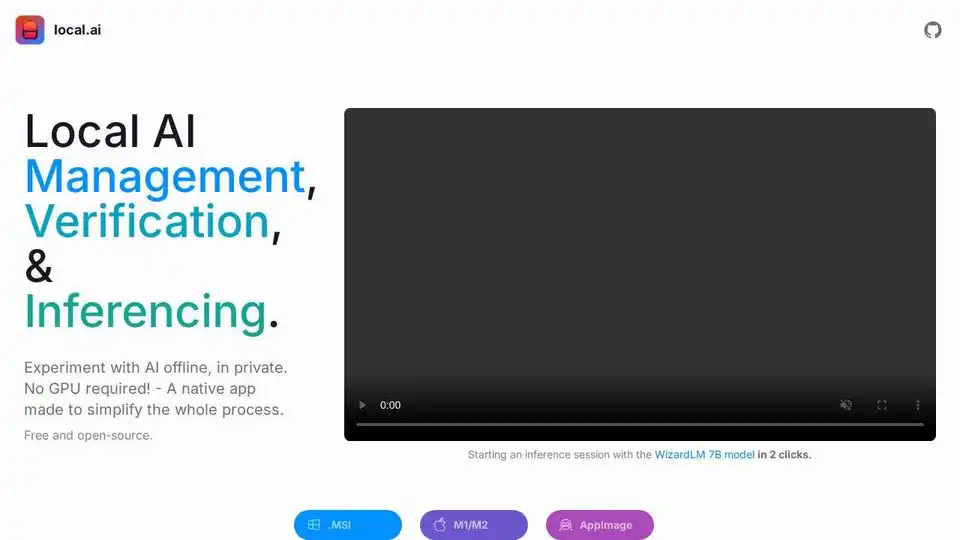

- Descargar: Descargue e instale la aplicación para su sistema operativo (.MSI, .EXE, M1/M2, Intel, AppImage, .deb).

- Gestión de Modelos: Seleccione un directorio para almacenar sus modelos de AI. AI Local rastreará y administrará los modelos en esa ubicación.

- Inferencia: Cargue un modelo e inicie una sesión de inferencia con solo unos clics. Puede utilizar la interfaz de usuario de inferencia rápida integrada o iniciar un servidor de transmisión para aplicaciones más avanzadas.

- Verificación de Digest: Verifique la integridad de sus modelos descargados utilizando la función de cálculo de digest BLAKE3 y SHA256.

¿Para quién es AI Local?

AI Local es ideal para:

- Entusiastas de la IA: Individuos interesados en experimentar con modelos de AI sin la necesidad de hardware costoso o configuraciones complejas.

- Usuarios Conscientes de la Privacidad: Aquellos que desean ejecutar inferencias de AI sin conexión y en privado, sin enviar datos a servidores externos.

- Desarrolladores: Que necesitan una forma sencilla y eficiente de probar e implementar modelos de AI localmente.

¿Por qué elegir AI Local?

- Facilidad de Uso: Simplifica el proceso de experimentar con modelos de AI.

- Privacidad: Ejecuta inferencias de AI sin conexión y en privado.

- Eficiencia: Utiliza un backend de Rust para la eficiencia de la memoria y una huella compacta.

- Versatilidad: Admite una variedad de modelos y aplicaciones de AI.

Próximas Características

El equipo de AI Local está trabajando activamente en nuevas características, que incluyen:

- Inferencia de GPU

- Sesiones paralelas

- Directorio anidado para la gestión de modelos

- Clasificación y búsqueda personalizadas

- Explorador y búsqueda de modelos

- Endpoints del servidor de inferencia de audio/imagen

En conclusión, AI Local es una herramienta valiosa para cualquiera que busque experimentar con modelos de AI localmente, ofreciendo una interfaz fácil de usar, características robustas y un compromiso con la privacidad y la eficiencia. ¿Cuál es la mejor manera de empezar a experimentar con modelos de AI? Con AI Local, es más fácil que nunca. ¡Pruébalo hoy mismo!

Mejores herramientas alternativas a "Local AI"

Experimente con modelos de IA localmente sin configuración técnica utilizando local.ai, una aplicación nativa gratuita y de código abierto diseñada para la inferencia de IA sin conexión. ¡No se requiere GPU!

Modal: Plataforma sin servidor para equipos de IA y datos. Ejecute cómputo intensivo de CPU, GPU y datos a escala con su propio código.

UsageGuard ofrece una plataforma unificada de IA para acceso seguro a LLMs de OpenAI, Anthropic y más, con salvaguardas integradas, optimización de costos, monitoreo en tiempo real y seguridad de grado empresarial para agilizar el desarrollo de IA.

OpenUI es una herramienta de código abierto que te permite describir componentes de UI en lenguaje natural y renderizarlos en vivo usando LLMs. Convierte descripciones en HTML, React o Svelte para prototipado rápido.

dstack es un motor de orquestación de contenedores de IA de código abierto que proporciona a los equipos de ML un plano de control unificado para el aprovisionamiento y la orquestación de GPU en la nube, Kubernetes y on-premise. Agiliza el desarrollo, el entrenamiento y la inferencia.

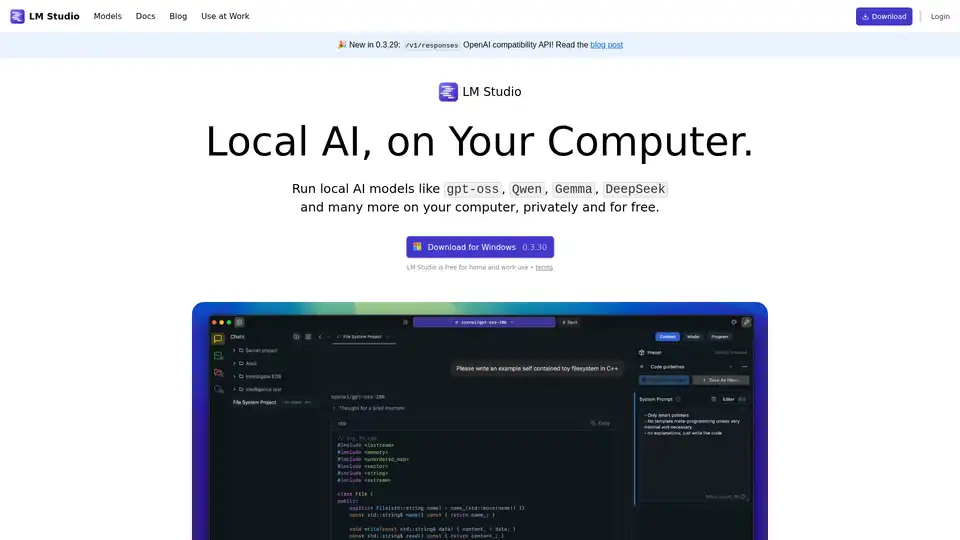

LM Studio te permite ejecutar modelos de IA locales como gpt-oss, Qwen, Gemma y DeepSeek en tu computadora, de forma privada y gratuita. Soporta recursos para desarrolladores como JS y Python SDKs.

NativeMind es una extensión de Chrome de código abierto que ejecuta LLMs locales como Ollama para una alternativa completamente offline y privada a ChatGPT. Incluye chat consciente del contexto, modo agente, análisis de PDF, herramientas de escritura y traducción, todo 100% en el dispositivo sin nube.

Cerebrium es una plataforma de infraestructura de IA sin servidor que simplifica la implementación de aplicaciones de IA en tiempo real con baja latencia, cero DevOps y facturación por segundo. Implemente LLM y modelos de visión a nivel mundial.

RewiredMind es una app impulsada por IA que ofrece técnicas personalizadas de gestión del estrés como journaling, afirmaciones y CBT para reducir la ansiedad y promover el bienestar mental. Comienza con una prueba gratuita para planes de acción personalizados.

Prodia proporciona APIs rápidas y escalables para herramientas creativas de IA, ofreciendo generación de medios de baja latencia para desarrolladores. Integra la IA en tus aplicaciones en minutos.

Vulse es una plataforma B2B de promoción de empleados y gestión de contenido de LinkedIn. Potencia a tu equipo para crear, compartir y hacer crecer la presencia de tu empresa con facilidad utilizando herramientas impulsadas por IA.

AI Runner es un motor de inferencia de IA sin conexión para arte, conversaciones de voz en tiempo real, chatbots impulsados por LLM y flujos de trabajo automatizados. ¡Ejecute la generación de imágenes, el chat de voz y más localmente!

Private LLM es un chatbot de IA local para iOS y macOS que funciona sin conexión, manteniendo su información completamente en el dispositivo, segura y privada. Disfrute de un chat sin censura en su iPhone, iPad y Mac.

ChatLLaMA es un asistente de IA entrenado con LoRA basado en modelos LLaMA, que permite conversaciones personalizadas en tu GPU local. Incluye GUI de escritorio, entrenado en el conjunto de datos HH de Anthropic, disponible para modelos de 7B, 13B y 30B.