Awan LLM

Vue d'ensemble de Awan LLM

Awan LLM : Libérer la puissance de l’inférence LLM illimitée

Qu’est-ce qu’Awan LLM ? Awan LLM est une plateforme de pointe qui fournit un accès illimité, sans restriction et rentable à l’API d’inférence de grand modèle linguistique (LLM). Conçu pour les utilisateurs expérimentés et les développeurs, Awan LLM élimine les contraintes des modèles de tarification basés sur les jetons, permettant une intégration transparente des LLM dans diverses applications.

Principales fonctionnalités

- Jetons illimités: Envoyez et recevez des jetons illimités jusqu’à la limite de contexte des modèles, ce qui vous évite de dépasser les budgets de jetons.

- Accès sans restriction: Utilisez les modèles LLM sans contraintes ni censure, ce qui permet une plus grande flexibilité et créativité.

- Rentable: Payez des frais mensuels au lieu d’un coût par jeton, ce qui le rend beaucoup moins cher que les autres fournisseurs d’API LLM.

Comment fonctionne Awan LLM ?

Awan LLM se distingue par le fait qu’il possède ses propres centres de données et GPU. Cette infrastructure lui permet d’offrir une génération de jetons illimitée sans les limitations typiques imposées par les fournisseurs qui dépendent de la facturation basée sur les jetons.

Pour commencer à utiliser Awan LLM :

- Inscrivez-vous pour obtenir un compte.

- Consultez la page de démarrage rapide pour faciliter l’intégration des points de terminaison d’API.

Pourquoi choisir Awan LLM ?

- Assistants AI: Bénéficiez d’une assistance AI illimitée grâce à l’API Awan LLM.

- Agents AI: Donnez aux agents AI les moyens de travailler sur des tâches importantes sans vous soucier des jetons.

- Jeux de rôle: Participez à des aventures de jeux de rôle non censurées sans limite de jetons.

- Traitement des données: Traitez rapidement de grands ensembles de données sans restrictions d’utilisation.

- Complétion de code: Écrivez du code plus rapidement grâce à des complétions de code illimitées.

- Applications: Rentabilisez les applications basées sur l’AI en éliminant les coûts des jetons.

À qui s’adresse Awan LLM ?

Awan LLM est conçu pour un large éventail d’utilisateurs, notamment :

- Développeurs: Qui créent des applications basées sur l’AI et qui ont besoin d’une API LLM fiable et rentable.

- Utilisateurs expérimentés: Qui ont besoin d’un accès sans restriction aux LLM pour diverses tâches.

- Entreprises: Qui cherchent à intégrer l’AI dans leurs flux de travail sans engager de coûts de jetons élevés.

Applications pratiques

Awan LLM peut être utilisé dans divers scénarios :

- Assistance client basée sur l’AI: Développez des chatbots AI pour traiter les demandes des clients de manière efficace et efficiente.

- Création de contenu: Générez du contenu de haute qualité pour les blogs, les articles et le matériel de marketing.

- Génération de code: Automatisez les tâches de génération de code, augmentant ainsi la productivité des développeurs.

- Analyse des données: Traitez et analysez de grands ensembles de données pour en extraire des informations précieuses.

Réduction des coûts

L’utilisation d’Awan LLM peut entraîner d’importantes réductions de coûts par rapport aux fournisseurs d’API LLM traditionnels basés sur les jetons. En payant des frais mensuels fixes, les utilisateurs peuvent éviter les coûts imprévisibles associés à la consommation de jetons.

Répondre aux préoccupations

- Journalisation des données: Awan LLM ne journalise pas les invites ni les générations, ce qui garantit la confidentialité des utilisateurs.

- Limites de débit: Les limites de débit des requêtes sont clairement expliquées sur la page Modèles et Tarification.

Awan LLM vs. auto-hébergement

L’utilisation de l’API d’Awan LLM est plus rentable que l’auto-hébergement de LLM, car elle élimine la nécessité de louer des GPU ou de payer l’électricité pour faire fonctionner votre propre matériel.

Futurs modèles

Les utilisateurs peuvent demander l’ajout de modèles spécifiques qui ne sont pas actuellement disponibles sur la page Modèles, ce qui garantit que la plateforme reste adaptable à leurs besoins.

Conclusion

Awan LLM offre une solution intéressante pour les utilisateurs qui recherchent un accès illimité, sans restriction et rentable à l’API d’inférence LLM. Son infrastructure unique et son modèle de tarification en font une alternative intéressante aux fournisseurs traditionnels basés sur les jetons et à l’auto-hébergement, permettant aux développeurs et aux entreprises d’exploiter la puissance des LLM sans se ruiner. Avec des applications allant des assistants AI à la complétion de code, Awan LLM est sur le point de donner un nouvel élan à une nouvelle ère d’innovation basée sur l’AI. La disponibilité de modèles tels que Meta Llama 3.1 8B et 70B consolide encore sa position de plateforme d’API LLM de premier plan.

Meilleurs outils alternatifs à "Awan LLM"

Awan LLM offre une plateforme d'API d'inférence LLM illimitée et économique avec des jetons illimités, idéale pour les développeurs et les utilisateurs expérimentés. Traitez des données, complétez du code et créez des agents IA sans limite de jetons.

Exécutez instantanément n'importe quel modèle Llama depuis HuggingFace sans configurer de serveurs. Plus de 11 900 modèles disponibles. À partir de 10 $/mois pour un accès illimité.

Meteron AI est un ensemble d'outils d'IA tout-en-un qui gère la mesure, l'équilibrage de charge et le stockage des LLM et de l'IA générative, ce qui permet aux développeurs de se concentrer sur la création de produits basés sur l'IA.

DeepSeek-v3 est un modèle d'IA basé sur l'architecture MoE, fournissant des solutions d'IA stables et rapides avec une formation étendue et une prise en charge multilingue.

Locus est un copilote IA qui améliore la productivité en permettant des recherches intelligentes sur les pages web et les fichiers PDF en utilisant le langage naturel. Il aide les utilisateurs à trouver rapidement des informations pertinentes, à résumer le contenu et à brainstormer des idées.

Everyprompt est un terrain de jeu GPT-3 pour la création et le déploiement d'API basées sur l'IA. Testez, créez et déployez facilement des outils d'IA, avec CI/CD, des paramètres intuitifs et un support d'équipe.

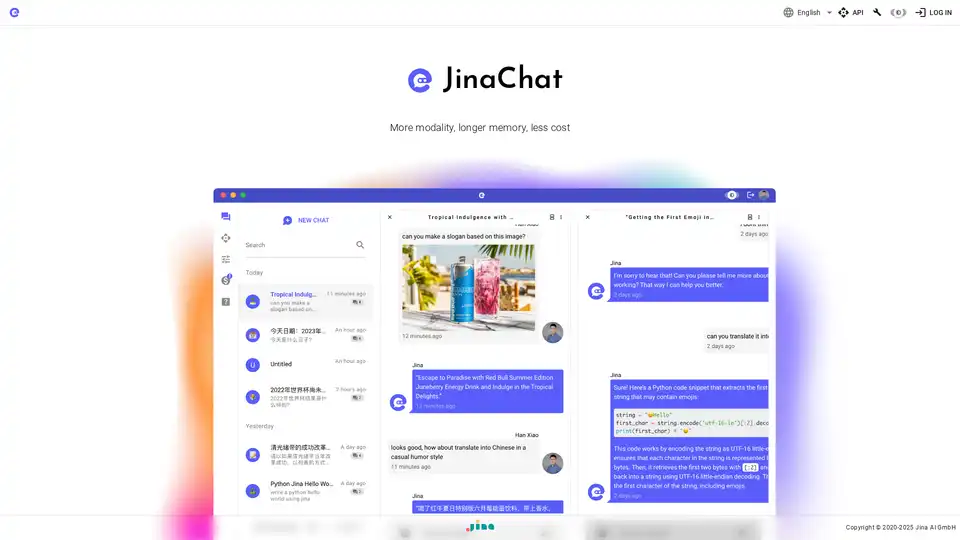

JinaChat est un service LLM multimodal conçu pour les utilisateurs professionnels, offrant une mémoire longue, des capacités de chat multimodal et une API économique, ce qui le rend idéal pour les applications complexes.

AiPrice propose une API pour calculer le prix des jetons OpenAI. Estimez avec précision le nombre de jetons d'invite pour différents modèles LLM. Plan gratuit disponible, aucune carte de crédit nécessaire.

Graydient AI est une plateforme offrant une génération illimitée d'images, de vidéos et de texte par IA avec divers modèles d'IA. Les fonctionnalités incluent un portfolio d'IA, des images de stock, la création de bandes dessinées, etc.

Code Snippets AI améliore le codage grâce à la gestion des extraits basée sur l'IA, en intégrant de manière transparente les LLM pour une génération, un débogage et une collaboration de code efficaces. Essayez-le gratuitement !

Sécurisez vos clés API LLM avec Backmesh, un backend open source. Empêchez les fuites, contrôlez l'accès et mettez en œuvre des limites de débit pour réduire les coûts de l'API LLM.

16x Prompt est un outil de codage IA permettant de gérer le contexte du code, de personnaliser les invites et de livrer des fonctionnalités plus rapidement grâce aux intégrations d'API LLM. Idéal pour les développeurs à la recherche d'un codage efficace assisté par l'IA.

Phala Cloud offre une infrastructure cloud open source et sans confiance pour déployer des agents d'IA et des applications Web3, alimentée par TEE. Il garantit la confidentialité, l'évolutivité et est régi par le code.

GPTkids est un tuteur et ami alimenté par l'IA pour les enfants, offrant une aide aux devoirs, des jeux d'apprentissage et des activités créatives. Il rend l'apprentissage amusant et engageant.