Cerebrium

Vue d'ensemble de Cerebrium

Cerebrium : Infrastructure d’IA sans serveur pour les applications en temps réel

Qu’est-ce que Cerebrium ? Cerebrium est une plateforme d’infrastructure cloud sans serveur conçue pour simplifier la création et le déploiement d’applications d’IA. Elle offre des solutions évolutives et performantes pour l’exécution de GPU sans serveur avec de faibles démarrages à froid, prend en charge une large gamme de types de GPU et permet des tâches par lots à grande échelle et des applications en temps réel.

Comment fonctionne Cerebrium ?

Cerebrium simplifie le flux de travail de développement de l’IA en répondant aux principaux défis en matière de configuration, de développement, de déploiement et d’observabilité :

- Configuration: Il fournit des options de configuration faciles, permettant aux utilisateurs de configurer de nouvelles applications en quelques secondes. La plateforme évite la syntaxe complexe, permettant une initialisation rapide du projet, une sélection du matériel et un déploiement.

- Développement: Cerebrium aide à rationaliser le processus de développement, en fournissant des outils et des fonctionnalités qui réduisent la complexité.

- Déploiement: La plateforme garantit des démarrages à froid rapides (en moyenne 2 secondes ou moins) et une évolutivité transparente, permettant aux applications de passer de zéro à des milliers de conteneurs automatiquement.

- Observabilité: Cerebrium prend en charge le suivi complet des performances des applications avec des mesures, des traces et des journaux unifiés via OpenTelemetry.

Principales fonctionnalités et avantages

- Démarrages à froid rapides: Les applications démarrent en moyenne en 2 secondes ou moins.

- Déploiements multirégionaux: Déployez des applications à l’échelle mondiale pour une meilleure conformité et des performances améliorées.

- Mise à l’échelle transparente: Mettez automatiquement à l’échelle les applications de zéro à des milliers de conteneurs.

- Traitement par lots: Combinez les demandes en lots pour minimiser le temps d’inactivité du GPU et améliorer le débit.

- Simultanéité: Mettez à l’échelle dynamiquement les applications pour gérer des milliers de demandes simultanées.

- Tâches asynchrones: Mettez en file d’attente les charges de travail et exécutez-les en arrière-plan pour les tâches de formation.

- Stockage distribué: Conservez les poids du modèle, les journaux et les artefacts dans tous les déploiements sans configuration externe.

- Large gamme de types de GPU: Choisissez parmi les GPU T4, A10, A100, H100, Trainium, Inferentia et autres.

- Points de terminaison WebSocket: Permet des interactions en temps réel et des réponses à faible latence.

- Points de terminaison de diffusion en continu: Envoyez des jetons ou des blocs aux clients au fur et à mesure de leur génération.

- Points de terminaison REST API: Exposez le code en tant que points de terminaison REST API avec une mise à l’échelle automatique et une fiabilité intégrée.

- Apportez votre propre environnement d’exécution: Utilisez des Dockerfiles ou des environnements d’exécution personnalisés pour un contrôle total sur les environnements d’application.

- CI/CD et déploiements progressifs: Prend en charge les pipelines CI/CD et les déploiements progressifs sécurisés pour les mises à jour sans interruption de service.

- Gestion des secrets: Stockez et gérez en toute sécurité les secrets via le tableau de bord.

Couche logicielle de confiance

Cerebrium fournit une couche logicielle de confiance avec des fonctionnalités telles que :

- Traitement par lots: Combinez les demandes en lots, minimisant le temps d’inactivité du GPU et améliorant le débit.

- Simultanéité: Mettez à l’échelle dynamiquement les applications pour gérer des milliers de demandes simultanées.

- Tâches asynchrones: Mettez en file d’attente les charges de travail et exécutez-les en arrière-plan, parfait pour toute tâche de formation

- Stockage distribué: Conservez les poids du modèle, les journaux et les artefacts dans tout votre déploiement sans configuration externe.

- Déploiements multirégionaux: Déployez à l’échelle mondiale dans plusieurs régions et offrez aux utilisateurs un accès local rapide, où qu’ils se trouvent.

- OpenTelemetry: Suivez les performances de l’application de bout en bout avec des mesures, des traces et une observabilité des journaux unifiées.

- Plus de 12 types de GPU: Sélectionnez parmi les GPU T4, A10, A100, H100, Trainium, Inferentia et autres pour des cas d’utilisation spécifiques

- Points de terminaison WebSocket: Les interactions en temps réel et les réponses à faible latence améliorent l’expérience utilisateur

- Points de terminaison de diffusion en continu: Les points de terminaison de diffusion en continu natifs envoient des jetons ou des blocs aux clients au fur et à mesure de leur génération.

- Points de terminaison REST API: Exposez le code en tant que points de terminaison REST API : mise à l’échelle automatique et fiabilité améliorée intégrées.

Cas d’utilisation

Cerebrium convient pour :

- LLM: Déployez et mettez à l’échelle des modèles de langage volumineux.

- Agents: Créez et déployez des agents d’IA.

- Modèles de vision: Déployez des modèles de vision pour diverses applications.

- Traitement vidéo : Expériences d’IA à l’échelle humaine.

- IA générative : Surmonter les barrières linguistiques avec Lelapa AI.

- Avatars numériques : Mise à l’échelle des humains numériques pour les assistants virtuels avec bitHuman

À qui s’adresse Cerebrium ?

Cerebrium est conçu pour les startups et les entreprises qui cherchent à mettre à l’échelle leurs applications d’IA sans les complexités de DevOps. Il est particulièrement utile pour ceux qui travaillent avec les LLM, les agents d’IA et les modèles de vision.

Tarification

Cerebrium propose un modèle de tarification à l’utilisation. Les utilisateurs peuvent estimer leurs coûts mensuels en fonction des besoins de calcul, de la sélection du matériel (CPU uniquement, L4, L40s, A10, T4, A100 (80 Go), A100 (40 Go), H100, H200 GPU, etc.) et des besoins en mémoire.

Pourquoi Cerebrium est-il important ?

Cerebrium simplifie le déploiement et la mise à l’échelle des applications d’IA, permettant aux développeurs de se concentrer sur la création de solutions innovantes. Son infrastructure sans serveur, sa large gamme d’options de GPU et ses fonctionnalités complètes en font un outil précieux pour quiconque travaille avec l’IA.

En conclusion, Cerebrium est une plateforme d’infrastructure d’IA sans serveur qui offre un ensemble complet de fonctionnalités pour le déploiement et la mise à l’échelle d’applications d’IA en temps réel. Avec sa configuration facile, sa mise à l’échelle transparente et sa couche logicielle de confiance, Cerebrium simplifie le flux de travail de développement de l’IA et permet aux entreprises de se concentrer sur l’innovation. La plateforme prend en charge différents types de GPU, les tâches asynchrones, le stockage distribué et les déploiements multirégionaux, ce qui la rend adaptée à une large gamme d’applications d’IA et de cas d’utilisation.

Meilleurs outils alternatifs à "Cerebrium"

Baseten est une plateforme pour déployer et mettre à l'échelle des modèles d'IA en production. Il offre des runtimes de modèles performants, une haute disponibilité inter-cloud et des flux de travail de développeur transparents, alimentés par Baseten Inference Stack.

Phala Cloud offre une infrastructure cloud open source et sans confiance pour déployer des agents d'IA et des applications Web3, alimentée par TEE. Il garantit la confidentialité, l'évolutivité et est régi par le code.

Float16.cloud offre des GPU sans serveur pour le développement de l'IA. Déployez instantanément des modèles sur des GPU H100 avec une tarification à l'utilisation. Idéal pour les LLM, le réglage fin et la formation.

Runpod est une plateforme cloud d'IA simplifiant la construction et le déploiement de modèles d'IA. Offrant des ressources GPU à la demande, une mise à l'échelle sans serveur et une disponibilité de niveau entreprise pour les développeurs d'IA.

GPUX est une plateforme d'inférence GPU sans serveur permettant des démarrages à froid en 1 seconde pour des modèles IA comme StableDiffusionXL, ESRGAN et AlpacaLLM avec des performances optimisées et des capacités P2P.

Plateforme IA ultra-rapide pour les développeurs. Déployez, affinez et exécutez plus de 200 LLMs et modèles multimodaux optimisés avec des API simples - SiliconFlow.

Summie est votre application iOS pour enregistrer des réunions sur votre téléphone, fournissant des résumés précis alimentés par IA, des points clés et des éléments d'action. Entièrement automatisé, conforme au RGPD et facile à utiliser n'importe où.

Prodia transforme l'infrastructure IA complexe en flux de travail prêts pour la production : rapides, évolutifs et conviviaux pour les développeurs.

ChatLLaMA est un assistant IA entraîné avec LoRA basé sur les modèles LLaMA, permettant des conversations personnalisées sur votre GPU local. Inclut une interface graphique de bureau, entraîné sur le dataset HH d'Anthropic, disponible pour les modèles 7B, 13B et 30B.

Transformez la communication de votre entreprise avec Bland AI. Automatisez les appels entrants et sortants en utilisant une IA qui sonne humaine. Parfait pour les ventes, le support client et les opérations avec des voix personnalisables et des intégrations fluides.

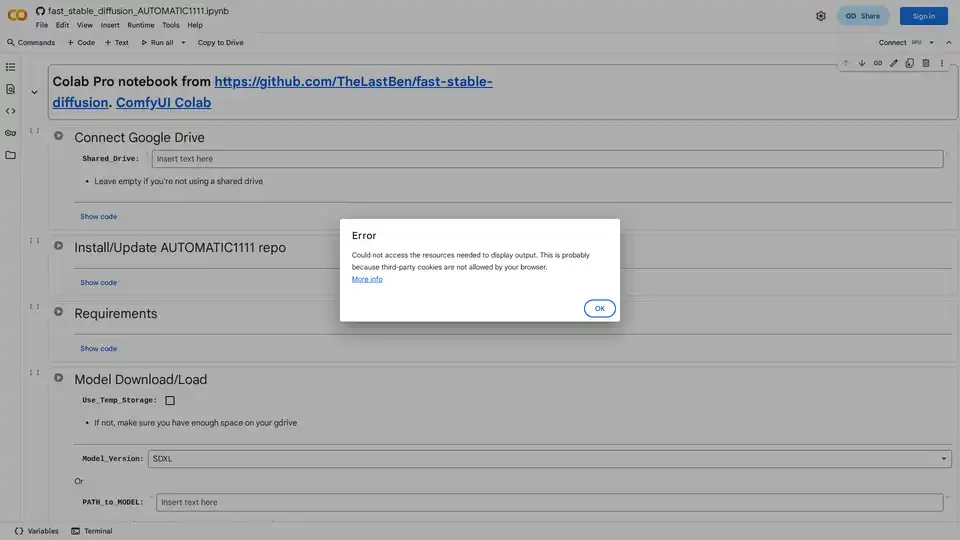

Découvrez comment exécuter Stable Diffusion en utilisant l'interface web d'AUTOMATIC1111 sur Google Colab. Installez des modèles, LoRAs et ControlNet pour une génération d'images IA rapide sans matériel local.

Runpod est une plateforme cloud IA tout-en-un qui simplifie la construction et le déploiement de modèles d'IA. Entraînez, affinez et déployez l'IA sans effort grâce à une puissance de calcul élevée et à une mise à l'échelle automatique.

Ardor est un créateur d'applications agentic full-stack qui vous permet de créer et de déployer des applications agentic d'IA prêtes pour la production, de la génération de spécifications au code, à l'infrastructure, au déploiement et à la surveillance avec une simple invite.

Deployo simplifie le déploiement des modèles d'IA, transformant les modèles en applications prêtes pour la production en quelques minutes. Infrastructure d'IA agnostique du cloud, sécurisée et évolutive pour un flux de travail d'apprentissage automatique sans effort.