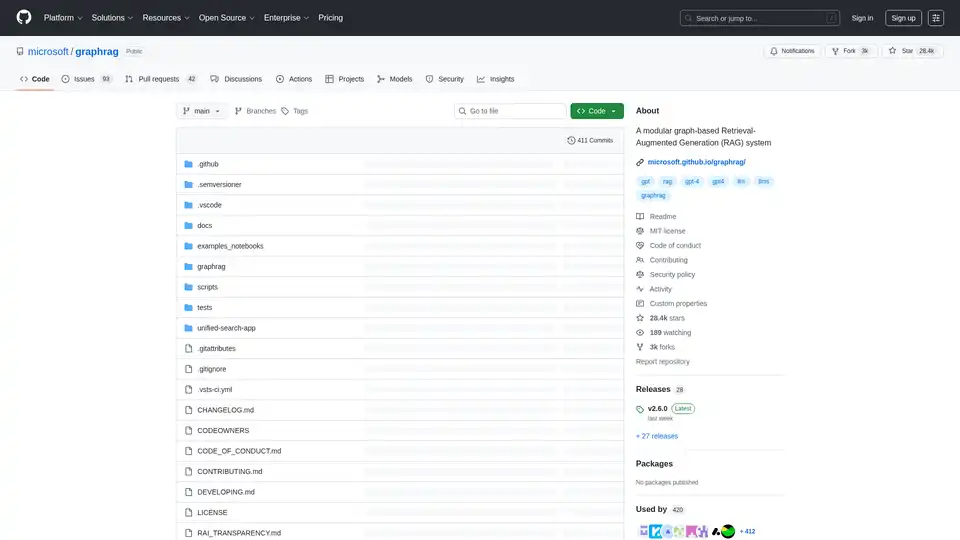

GraphRAG

Vue d'ensemble de GraphRAG

GraphRAG : Améliorer les LLM avec des graphes de connaissances

GraphRAG est un projet open source de Microsoft Research, conçu pour améliorer les sorties des grands modèles de langage (LLM) en utilisant des structures de mémoire de graphes de connaissances. Il s'agit d'un pipeline de données modulaire et d'une suite de transformation qui extrait des données structurées significatives à partir de texte non structuré en utilisant la puissance des LLM.

Qu'est-ce que GraphRAG ?

GraphRAG (Génération Augmentée de Récupération basée sur des Graphes) est un système qui utilise des graphes de connaissances pour améliorer les capacités de raisonnement des LLM. En structurant l'information dans un format de graphe, GraphRAG permet aux LLM d'accéder et de traiter les données plus efficacement, ce qui conduit à des sorties meilleures et plus précises.

Comment fonctionne GraphRAG ?

GraphRAG fonctionne en :

- Extrayant des données: Il extrait des données de texte non structuré à l'aide de LLM.

- Structurant les données: Il transforme les données extraites en un graphe de connaissances.

- Améliorant les sorties des LLM: Il utilise le graphe de connaissances pour améliorer les sorties des LLM.

Fonctionnalités clés:

- Conception modulaire: GraphRAG est conçu avec une architecture modulaire, permettant une personnalisation et une extension faciles.

- Pipeline de données: Il fournit un pipeline de données complet pour l'extraction, la transformation et le chargement de données dans un graphe de connaissances.

- Intégration LLM: Il s'intègre de manière transparente aux LLM pour améliorer leurs capacités de raisonnement.

Comment utiliser GraphRAG ?

Pour commencer avec GraphRAG, suivez ces étapes :

- Installation: Clonez le référentiel et installez les dépendances nécessaires.

- Initialisation: Exécutez

graphrag init --root [path] --forcepour initialiser le système. - Configuration: Configurez le système pour vous connecter à vos sources de données et à vos LLM.

- Indexation: Indexez vos données pour créer le graphe de connaissances. Sachez que l'indexation GraphRAG peut être une opération coûteuse, veuillez lire toute la documentation pour comprendre le processus et les coûts impliqués, et commencez petit.

- Réglage des invites: Affinez vos invites pour obtenir les meilleurs résultats possibles.

Pourquoi choisir GraphRAG ?

- Raisonnement amélioré: GraphRAG améliore les capacités de raisonnement des LLM, ce qui conduit à des sorties plus précises et fiables.

- Données structurées: Il transforme le texte non structuré en graphes de connaissances structurés, ce qui facilite l'accès et le traitement des données.

- Open-Source: GraphRAG est un projet open source, permettant les contributions et la personnalisation de la communauté.

À qui s'adresse GraphRAG ?

GraphRAG convient à :

- Chercheurs: Qui explorent l'utilisation de graphes de connaissances pour améliorer les LLM.

- Développeurs: Qui construisent des applications nécessitant des capacités de raisonnement avancées.

- Organisations: Qui souhaitent améliorer la précision et la fiabilité de leurs sorties LLM.

Exemples de cas d'utilisation:

- Réponse aux questions: Améliorez la précision des systèmes de réponse aux questions en tirant parti des graphes de connaissances.

- Intégration de données: Intégrez des données provenant de plusieurs sources dans un graphe de connaissances unifié.

- Découverte de connaissances: Découvrez de nouvelles informations et relations au sein de vos données.

Gestion des versions: Exécutez toujours graphrag init --root [path] --force entre les augmentations de version mineure pour vous assurer d'avoir le format de configuration le plus récent. Exécutez le notebook de migration fourni entre les augmentations de version majeure si vous souhaitez éviter de réindexer les ensembles de données antérieurs. Notez que cela écrasera votre configuration et vos invites, alors effectuez une sauvegarde si nécessaire.

IA responsable: Veuillez consulter RAI_TRANSPARENCY.md pour les considérations relatives à l'IA responsable.

En utilisant des graphes de connaissances, GraphRAG permet aux LLM d'accéder et de traiter les données plus efficacement, ce qui conduit à des résultats meilleurs et plus précis. Cela en fait un outil précieux pour quiconque cherche à améliorer les capacités de raisonnement de ses LLM.

Meilleurs outils alternatifs à "GraphRAG"

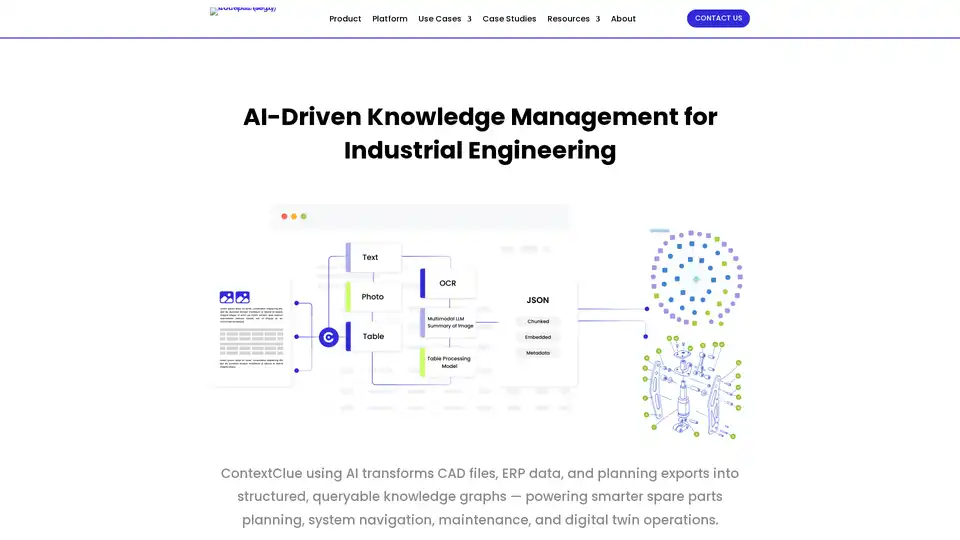

Optimisez les flux de travail en ingénierie avec une gestion intelligente des connaissances – organisez, recherchez et partagez des données techniques dans tout votre écosystème grâce aux outils alimentés par IA de ContextClue pour les graphes de connaissances et les jumeaux numériques.

Aionlinecourse propose des cours, des projets, des tutoriels et des logiciels d'IA en ligne. Maîtrisez les bases de l'IA, l'apprentissage automatique, le NLP et l'IA générative. Commencez votre parcours d'IA dès maintenant !

Oda Studio propose des solutions basées sur l'IA pour l'analyse de données complexes, transformant les données non structurées en informations exploitables pour les secteurs de la construction, de la finance et des médias. Experts en IA vision-langage et en graphes de connaissances.

Lettria est une plateforme d'IA qui transforme les données non structurées en connaissances structurées à l'aide de GraphRAG, améliorant ainsi la prise de décision dans les secteurs réglementés tels que la finance, la santé et le droit.

Lettria est une plateforme d'IA transformant les données non structurées en connaissances structurées pour une prise de décision plus intelligente. Améliorez la précision de RAG grâce à l'IA basée sur des graphes de Lettria.

Zep est une plateforme d'ingénierie de contexte pour la construction d'agents IA personnalisés. Elle comprend la mémoire de l'agent, le graphe RAG et l'assemblage automatisé du contexte, ce qui permet aux agents de se souvenir des détails importants et d'accéder aux données pertinentes.

xMem suralimente les applications LLM avec une mémoire hybride, combinant connaissances à long terme et contexte en temps réel pour une IA plus intelligente.

InfraNodus est un outil d'analyse de texte IA qui exploite des graphes de connaissances pour visualiser les textes, révéler les lacunes de contenu et générer de nouveaux insights pour la recherche, l'idéation et l'optimisation SEO.

Créez des agents personnalisés orientés tâches pour votre base de code qui exécutent des tâches d'ingénierie avec une grande précision, alimentées par l'intelligence et le contexte de vos données. Créez des agents pour des cas d'utilisation comme la conception de systèmes, le débogage, les tests d'intégration, l'intégration, etc.

Akooda est une plateforme d'intelligence d'entreprise basée sur l'IA qui recherche en toute sécurité dans les données de votre entreprise, fournissant des informations exploitables et transformant les silos de données en un centre de connaissances centralisé.

Morphik centralise les connaissances, crée des agents d’IA fiables pour automatiser les tâches. RAG de pointe pour l’analyse de documents et la recherche sémantique. Essayez Morphik gratuitement!

ZGI est une plateforme d'IA de niveau entreprise pour la conception visuelle de flux de travail d'agents, les systèmes RAG avancés et l'orchestration multi-agents.

Cognee est un moteur de mémoire d'IA pour les agents d'IA ayant besoin d'une mémoire fiable. Il offre des couches de mémoire modulaires pour des secteurs tels que la construction, l'éducation et la finance, permettant l'ingénierie de contexte et des réponses précises.

Discovery Outcomes est un graphe de connaissance GTM alimenté par l'IA qui cartographie les données publiques sur les entreprises, les concurrents et les marchés, fournissant des réponses rapides et contextuelles pour les équipes de vente, marketing et produit en entreprise.