OpenLIT

Vue d'ensemble de OpenLIT

OpenLIT : Observabilité native OpenTelemetry pour les applications GenAI et LLM

Qu'est-ce qu'OpenLIT ?

OpenLIT est une plateforme open source basée sur OpenTelemetry, conçue pour simplifier les flux de travail de développement de l'IA, en particulier pour l'IA générative et les grands modèles linguistiques (LLM). Elle rationalise les tâches essentielles telles que l'expérimentation avec les LLM, l'organisation et le versionnage des invites, et la gestion sécurisée des clés d'API.

Principales caractéristiques et avantages :

- Suivi des applications et des requêtes: OpenLIT fournit un suivi de bout en bout des requêtes entre différents fournisseurs afin d'améliorer la visibilité des performances. Cela vous permet de surveiller chaque span pour le temps de réponse et l'efficacité.

- Suivi des coûts: Suit les coûts associés, ce qui facilite la prise de décisions concernant les revenus.

- Surveillance des exceptions: Surveille et enregistre les erreurs d'application pour aider à détecter et à résoudre les problèmes. Elle offre une surveillance automatique des exceptions avec des SDK pour Python et TypeScript, des traces de pile détaillées et une intégration avec les données de trace basées sur OpenTelemetry.

- Openground (Openlit PlayGround): Vous permet de tester et de comparer différents LLM côte à côte en fonction des performances, des coûts et d'autres mesures clés. Il génère des rapports détaillés qui compilent et visualisent les données de comparaison, ce qui favorise une prise de décision éclairée.

- Référentiel d'invites centralisé: Permet le stockage, le versionnage et l'utilisation organisés des invites avec des variables dynamiques dans différentes applications. Prend en charge les mises à jour majeures, mineures et correctives pour une gestion claire des versions.

- Gestion sécurisée des secrets (Vault Hub): Offre un moyen sûr de stocker et de gérer les secrets d'application sensibles. Vous permet de créer, de modifier et de surveiller les secrets associés à vos applications, et de les intégrer en toute sécurité dans vos environnements Node.js ou Python.

- Diffusion de données en temps réel: Diffuse des données pour vous permettre de visualiser vos données et de prendre des décisions et des modifications rapides.

- Faible latence: Garantit que les données sont traitées rapidement sans affecter les performances de votre application.

- Native OpenTelemetry: Intégration transparente : la prise en charge native d'OpenLIT rend son ajout à vos projets facile et intuitif.

- Informations granulaires sur l'utilisation: Analysez les performances et les coûts des LLM, Vectordb et GPU pour atteindre une efficacité et une évolutivité maximales.

- Gestion des invites et du coffre-fort: Vous aide à gérer vos invites et vos secrets pour faciliter le développement de votre application.

Comment fonctionne OpenLIT ?

OpenLIT s'intègre de manière transparente à OpenTelemetry, ce qui vous permet de suivre automatiquement vos applications d'IA. Il utilise des SDK pour Python et TypeScript pour surveiller les exceptions sans modifier de manière significative le code de votre application. En ajoutant openlit.init() à votre code, vous pouvez commencer à collecter des données à partir de votre application LLM. La plateforme diffuse ensuite les données en temps réel, ce qui vous permet de visualiser les performances et les coûts associés à vos LLM, vos bases de données vectorielles et vos GPU.

Comment utiliser OpenLIT ?

- Installation: Vous pouvez configurer rapidement OpenLIT en exécutant

docker-compose up -d. - Intégration: Ajoutez

openlit.init()à votre application LLM pour commencer à collecter des données. - Vault Hub: Définissez les secrets directement en tant que variables d'environnement pour faciliter leur utilisation dans les applications utilisant leurs SDK.

- Connexion: Connectez-vous facilement aux systèmes d'observabilité populaires, notamment Datadog et Grafana Cloud, pour exporter automatiquement les données.

Nature Open Source :

OpenLIT est un projet open source, ce qui signifie que vous pouvez voir exactement ce que fait le code et même l'héberger vous-même. Cette transparence garantit la confidentialité et permet un meilleur contrôle de vos données.

Intégrations :

OpenLIT offre des intégrations avec des systèmes d'observabilité populaires tels que Datadog et Grafana Cloud, ce qui vous permet d'exporter automatiquement les données.

Communauté et assistance :

- Slack: Rejoignez la communauté OpenLIT sur Slack.

- Github: Ajoutez le projet aux favoris sur GitHub.

- Discord: Interagissez avec la communauté sur Discord.

- mail: Contactez l'équipe OpenLIT par e-mail.

Pourquoi OpenLIT est-il important ?

Dans le domaine de l'IA en évolution rapide, en particulier avec l'essor de l'IA générative et des LLM, il est essentiel de comprendre les performances, les coûts et les problèmes potentiels de vos applications. OpenLIT fournit les outils nécessaires pour surveiller, gérer et optimiser efficacement vos applications d'IA. Son intégration avec OpenTelemetry assure une adoption transparente et fournit des informations granulaires sur le comportement de votre application.

Meilleurs outils alternatifs à "OpenLIT"

HoneyHive fournit des outils d'évaluation, de test et d'observabilité de l'IA pour les équipes développant des applications LLM. Il offre une plateforme LLMOps unifiée.

Arize AI fournit une plateforme unifiée d'observabilité LLM et d'évaluation d'agents pour les applications d'IA, du développement à la production. Optimisez les invites, suivez les agents et surveillez les performances de l'IA en temps réel.

Pydantic AI est un framework d'agent GenAI en Python, conçu pour créer des applications de qualité de production avec l'IA générative. Il prend en charge divers modèles, offre une observabilité transparente et garantit un développement de type sûr.

Neural Netwrk est une société de portefeuille qui investit dans des entreprises innovantes d'IA et de technologie, notamment Jobstronauts AI, Meld LLM, etc. Explorez l'avenir des solutions basées sur l'IA.

Langtrace est une plateforme d'observabilité et d'évaluations open source conçue pour améliorer les performances et la sécurité des agents d'IA. Suivez les métriques essentielles, évaluez les performances et assurez une sécurité de niveau entreprise pour vos applications LLM.

Future AGI offre une plateforme unifiée d'observabilité LLM et d'évaluation d'agents IA pour les applications d'IA, garantissant la précision et l'IA responsable du développement à la production.

Freeplay est une plateforme d'IA conçue pour aider les équipes à créer, tester et améliorer les produits d'IA grâce à la gestion des invites, aux évaluations, à l'observabilité et aux flux de travail d'examen des données. Il rationalise le développement de l'IA et garantit une qualité de produit élevée.

PromptLayer est une plateforme d'ingénierie IA pour la gestion des invites, l'évaluation et l'observabilité LLM. Collaborez avec des experts, surveillez les agents IA et améliorez la qualité des invites grâce à des outils puissants.

Vellum AI est une plateforme d'orchestration et d'observabilité LLM permettant de créer, d'évaluer et de produire des flux de travail et des agents d'IA d'entreprise avec un constructeur visuel et un SDK.

Athina est une plateforme collaborative d'IA qui aide les équipes à construire, tester et surveiller les fonctionnalités basées sur LLM 10 fois plus rapidement. Avec des outils pour la gestion de prompts, les évaluations et l'observabilité, elle assure la confidentialité des données et prend en charge les modèles personnalisés.

Future AGI est une plateforme unifiée d'observabilité LLM et d'évaluation d'agents IA qui aide les entreprises à atteindre 99% de précision dans les applications IA grâce à des outils complets de test, d'évaluation et d'optimisation.

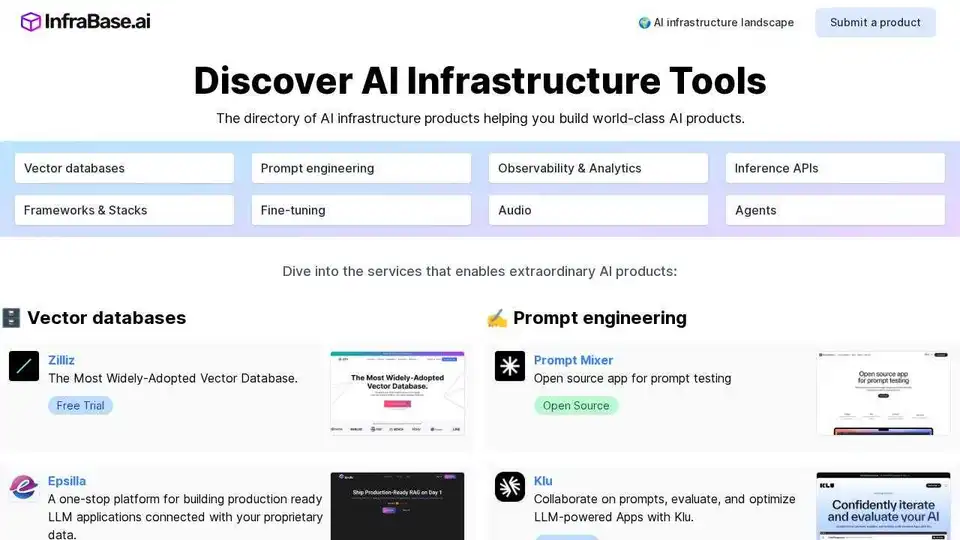

Infrabase.ai est le répertoire pour découvrir les outils et services d'infrastructure d'IA. Trouvez des bases de données vectorielles, des outils d'ingénierie de prompts, des API d'inférence et plus encore pour créer des produits d'IA de classe mondiale.

Surveillez, analysez et protégez les agents d'IA, les LLM et les modèles ML avec Fiddler AI. Bénéficiez de visibilité et d'informations exploitables grâce à la plateforme unifiée d'observabilité de l'IA de Fiddler.

Elixir est une plateforme d'AI Ops et d'assurance qualité conçue pour surveiller, tester et déboguer les agents vocaux d'IA. Il offre des tests automatisés, une revue d'appels et un suivi LLM pour garantir des performances fiables.