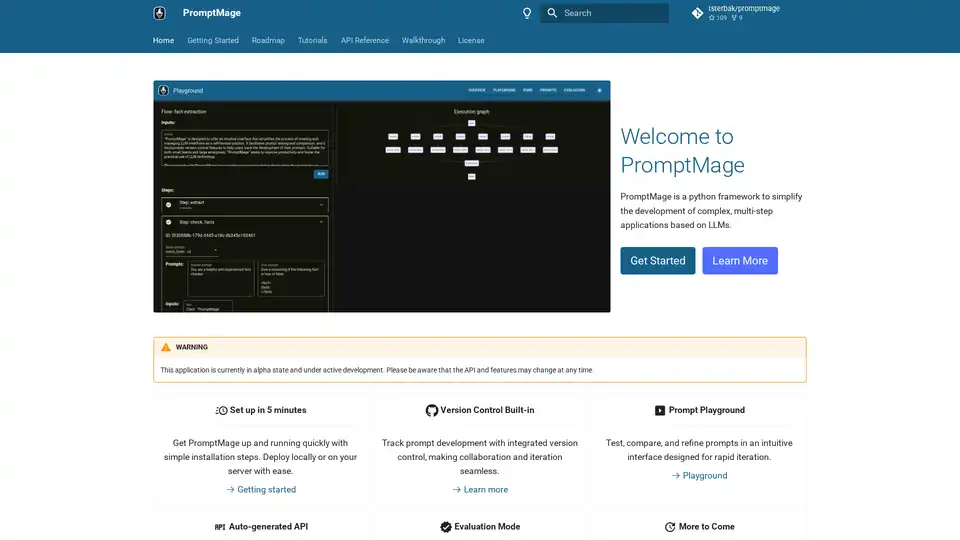

PromptMage

Vue d'ensemble de PromptMage

PromptMage : Simplifier le développement d’applications LLM

Qu’est-ce que PromptMage ? PromptMage est un framework Python conçu pour rationaliser le développement d’applications complexes, multi-étapes basées sur les grands modèles linguistiques (LLM). Il fournit une interface intuitive pour créer et gérer les flux de travail LLM, ce qui en fait une solution auto-hébergée précieuse pour les développeurs, les chercheurs et les organisations.

Principales caractéristiques et avantages :

- Gestion simplifiée du flux de travail LLM: PromptMage simplifie la création et la gestion des flux de travail LLM avec une interface intuitive.

- Test et comparaison des invites: Facilite le test et la comparaison des invites, ce qui permet aux utilisateurs d’affiner les invites pour des performances optimales.

- Contrôle de version: Intègre des fonctions de contrôle de version, permettant aux utilisateurs de suivre le développement de leurs invites et de collaborer efficacement.

- API auto-générée: Tire parti d’une API créée automatiquement et basée sur FastAPI pour une intégration et un déploiement faciles.

- Mode d’évaluation: Évalue les performances des invites grâce à des tests manuels et automatiques, garantissant ainsi la fiabilité avant le déploiement.

- Itération rapide: L’environnement de test d’invites permet de tester, de comparer et d’affiner rapidement les invites.

- Collaboration transparente: Le contrôle de version intégré rend la collaboration et l’itération transparentes.

- Intégration et déploiement faciles: Une API créée automatiquement simplifie l’intégration et le déploiement.

Comment fonctionne PromptMage ?

PromptMage fonctionne en fournissant un ensemble d’outils et de fonctionnalités qui simplifient le processus de développement et de gestion des applications basées sur LLM. Ceux-ci inclus :

- Environnement de test d’invites: Une interface web pour tester et comparer les invites.

- Contrôle de version: Un système pour suivre les modifications apportées aux invites au fil du temps.

- Génération d’API: Un outil pour générer automatiquement des API à partir d’invites.

- Mode d’évaluation: Un système pour évaluer les performances des invites.

Fonctionnalité principale :

- Intégration de l’environnement de test d’invites: Intégrez de manière transparente l’environnement de test d’invites dans votre flux de travail pour une itération rapide.

- Les invites en tant que citoyens de première classe: Traitez les invites comme des citoyens de première classe avec des fonctions de contrôle de version et de collaboration.

- Tests manuels et automatiques: Validez les invites par le biais de tests manuels et automatiques.

- Partage facile: Partagez facilement les résultats avec les experts du domaine et les parties prenantes.

- API FastAPI: API intégrée, créée automatiquement avec FastAPI pour une intégration et un déploiement faciles.

- Indication de type: Utilisez l’indication de type pour l’inférence automatique et la magie de la validation.

À qui s’adresse PromptMage ?

PromptMage est adapté aux :

- Développeurs créant des applications basées sur LLM

- Chercheurs expérimentant avec les LLM

- Organisations cherchant à rationaliser leurs flux de travail LLM

Cas d’utilisation

- product-review-research: Une application web AI construite avec PromptMage pour fournir une analyse approfondie des produits en effectuant des recherches sur des avis en ligne fiables.

Démarrage

Pour commencer à utiliser PromptMage, vous pouvez suivre ces étapes :

- Installez PromptMage à l’aide de pip :

pip install promptmage - Explorez la documentation et les tutoriels pour apprendre à utiliser le framework.

- Commencez à créer votre application LLM !

Pourquoi choisir PromptMage ?

PromptMage est une solution pragmatique qui comble le fossé actuel dans la gestion des flux de travail LLM. Il donne aux développeurs, aux chercheurs et aux organisations les moyens de rendre la technologie LLM plus accessible et plus gérable, soutenant ainsi la prochaine vague d’innovations en matière d’AI.

En utilisant PromptMage, vous pouvez :

- Augmenter la productivité

- Améliorer la qualité de vos applications LLM

- Faciliter la collaboration

- Accélérer l’innovation

Contribuer à PromptMage

Le projet PromptMage accueille les contributions de la communauté. Si vous souhaitez améliorer PromptMage, vous pouvez contribuer des manières suivantes :

- Signaler les bogues : Soumettez un problème dans notre référentiel, en fournissant une description détaillée du problème et les étapes à suivre pour le reproduire.

- Améliorer la documentation : Si vous trouvez des erreurs ou si vous avez des suggestions pour améliorer la documentation, veuillez soumettre un problème ou une demande de tirage.

- Corriger les bogues : Consultez notre liste de problèmes ouverts et soumettez une demande de tirage pour corriger les bogues que vous trouvez.

- Demandes de fonctionnalités : Vous avez des idées sur la façon d’améliorer PromptMage ? Nous serions ravis de vous entendre ! Veuillez soumettre un problème, en détaillant vos suggestions.

- Demandes de tirage : Les contributions via les demandes de tirage sont très appréciées. Veuillez vous assurer que votre code respecte les normes de codage du projet, et soumettez une demande de tirage avec une description claire de vos modifications.

Pour plus d’informations ou pour toute demande de renseignements, vous pouvez contacter les responsables du projet à l’adresse promptmage@tobiassterbak.com.

Meilleurs outils alternatifs à "PromptMage"

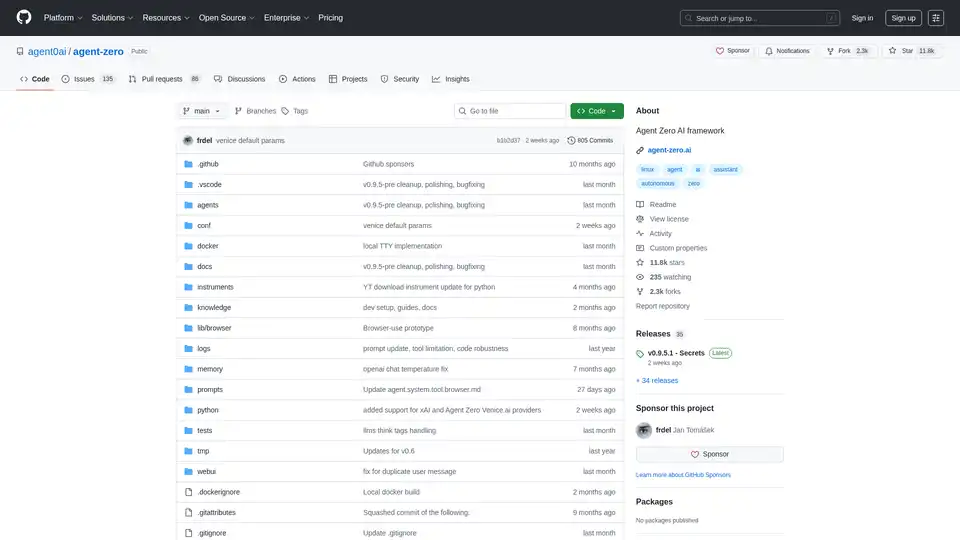

Agent Zero est un framework IA open source pour construire des agents autonomes qui apprennent et grandissent organiquement. Il propose une coopération multi-agents, l'exécution de code et des outils personnalisables.

Lunary est une plateforme d'ingénierie LLM open source qui fournit l'observabilité, la gestion des prompts et des analyses pour construire des applications d'IA fiables. Elle offre des outils pour le débogage, le suivi des performances et la garantie de la sécurité des données.

Parea AI est la plateforme ultime d'expérimentation et d'annotation humaine pour les équipes d'IA, permettant une évaluation fluide des LLM, des tests de prompts et un déploiement en production pour construire des applications d'IA fiables.

Weco AI automatise les expériences d'apprentissage automatique en utilisant la technologie AIDE ML, optimisant les pipelines ML grâce à l'évaluation de code pilotée par IA et l'expérimentation systématique pour améliorer les métriques de précision et de performance.

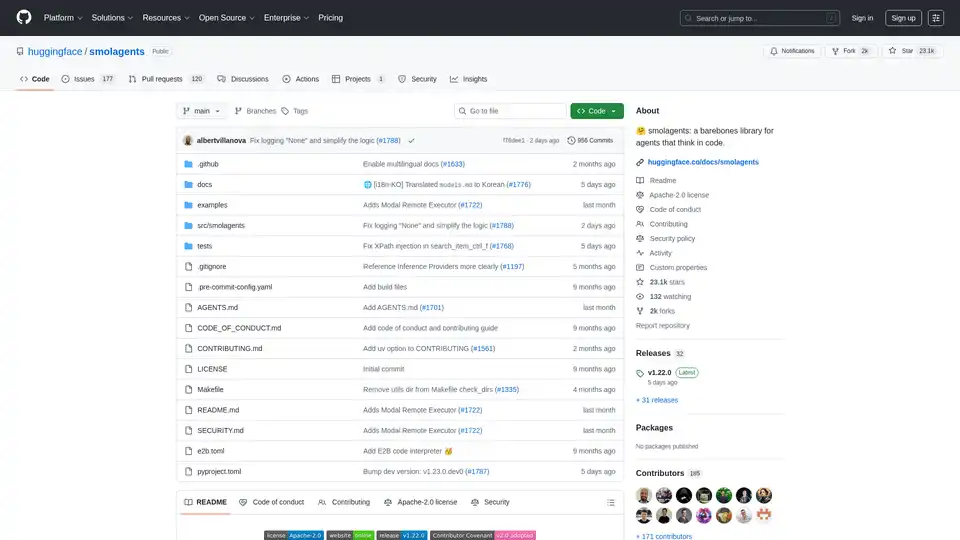

Smolagents est une bibliothèque Python minimaliste pour créer des agents IA qui raisonnent et agissent via du code. Elle prend en charge les modèles LLM agnostiques, les sandboxes sécurisées et une intégration fluide avec Hugging Face Hub pour des flux de travail d'agents basés sur le code efficaces.

Maxim AI est une plateforme d'évaluation et d'observabilité de bout en bout qui aide les équipes à déployer des agents IA de manière fiable et 5 fois plus rapidement avec des outils complets de test, de surveillance et d'assurance qualité.

Athina est une plateforme collaborative d'IA qui aide les équipes à construire, tester et surveiller les fonctionnalités basées sur LLM 10 fois plus rapidement. Avec des outils pour la gestion de prompts, les évaluations et l'observabilité, elle assure la confidentialité des données et prend en charge les modèles personnalisés.

Créez des agents personnalisés orientés tâches pour votre base de code qui exécutent des tâches d'ingénierie avec une grande précision, alimentées par l'intelligence et le contexte de vos données. Créez des agents pour des cas d'utilisation comme la conception de systèmes, le débogage, les tests d'intégration, l'intégration, etc.

Roo Code est un assistant de codage open-source propulsé par IA pour VS Code, avec des agents IA pour l'édition multi-fichiers, le débogage et l'architecture. Il prend en charge divers modèles, assure la confidentialité et se personnalise pour un développement efficace.

Klu est une plateforme d'applications LLM de nouvelle génération conçue pour aider les équipes à itérer, évaluer et optimiser en toute confiance les applications optimisées par LLM. Collaborez sur les invites, suivez les modifications et itérez rapidement grâce aux informations.

ModelFusion : Boîte à outils LLM complète pour 2025 avec des calculateurs de coûts, une bibliothèque de prompts et des outils d'observabilité de l'IA pour GPT-4, Claude, etc.

Freshly.ai fournit des outils et des aperçus de l'IA pour le développement d'applications d'IA, l'ingénierie des prompts et l'art de l'IA. Explorez des applications et techniques d'IA innovantes pour stimuler la créativité et la productivité.

Latitude est une plateforme open source pour l'ingénierie des prompts, permettant aux experts de domaine de collaborer avec les ingénieurs pour fournir des fonctionnalités LLM de qualité production. Construisez, évaluez et déployez des produits d'IA en toute confiance.

Trouvez des cours et certifications en intelligence artificielle auprès des meilleures universités. Apprenez l'IA, l'apprentissage automatique, l'apprentissage profond et plus encore. Lisez les avis pour choisir le bon cours.