Mercury

Vue d'ensemble de Mercury

Mercury : Révolutionner l’IA avec les LLM de diffusion

Qu’est-ce que Mercury ? Mercury, développé par Inception, représente une nouvelle ère dans les grands modèles linguistiques (LLM) en tirant parti de la technologie de diffusion. Ces LLM de diffusion (dLLM) offrent des avantages significatifs en termes de vitesse, d’efficacité, de précision et de contrôlabilité par rapport aux LLM autorégressifs traditionnels.

Comment fonctionne Mercury ?

Contrairement aux LLM classiques qui génèrent du texte de manière séquentielle, un jeton à la fois, les dLLM de Mercury génèrent des jetons en parallèle. Ce traitement parallèle augmente considérablement la vitesse et optimise l’efficacité du GPU, ce qui le rend idéal pour les applications d’IA en temps réel.

Principales caractéristiques et avantages :

- Inférence ultrarapide: Bénéficiez d’une latence ultrafaible, permettant des interactions d’IA réactives.

- Qualité supérieure: Bénéficiez d’une grande précision et d’une génération de texte contrôlable.

- Rentable: Réduisez les coûts opérationnels grâce à une efficacité GPU optimisée.

- Compatible avec l’API OpenAI: Intégrez de manière transparente Mercury aux flux de travail existants en tant que remplacement direct des LLM traditionnels.

- Grande fenêtre contextuelle: Mercury Coder et Mercury prennent en charge une fenêtre contextuelle de 128 K.

Applications d’IA optimisées par Mercury :

La vitesse et l’efficacité de Mercury ouvrent un large éventail d’applications d’IA :

- Codage: Accélérez les flux de travail de codage grâce à la saisie semi-automatique, aux suggestions d’onglets et à la modification ultrarapides.

- Voix: Offrez des expériences vocales réactives dans les domaines du service client, de la traduction et des ventes.

- Recherche: Faites apparaître instantanément des données pertinentes à partir de n’importe quelle base de connaissances, minimisant ainsi le temps de recherche.

- Agents: Exécutez des systèmes complexes à plusieurs tours tout en maintenant une faible latence.

Modèles de Mercury :

- Mercury Coder: Optimisé pour les flux de travail de codage, prenant en charge le streaming, l’utilisation d’outils et la sortie structurée. Tarification : Entrée 0,25 \(| Sortie 1 \) par million de jetons.

- Mercury: dLLM à usage général offrant une latence ultrafaible, prenant également en charge le streaming, l’utilisation d’outils et la sortie structurée. Tarification : Entrée 0,25 \(| Sortie 1 \) par million de jetons.

Pourquoi choisir Mercury ?

Les témoignages de professionnels du secteur soulignent la vitesse et l’impact exceptionnels de Mercury :

- Jacob Kim, ingénieur logiciel : « J’ai été stupéfait de sa rapidité. Les milliers de jetons par seconde étaient absolument incroyables, je n’avais jamais rien vu de tel. »

- Oliver Silverstein, PDG : « Après avoir essayé Mercury, il est difficile de revenir en arrière. Nous sommes ravis de déployer Mercury pour prendre en charge tous nos agents vocaux. »

- Damian Tran, PDG : « Nous avons réduit les frais généraux de routage et de classification à des latences inférieures à la seconde, même sur des traces d’agents complexes. »

À qui s’adresse Mercury ?

Mercury est conçu pour les entreprises qui cherchent à :

- Améliorer les performances des applications d’IA.

- Réduire les coûts d’infrastructure d’IA.

- Acquérir un avantage concurrentiel grâce à une technologie d’IA de pointe.

Comment intégrer Mercury :

Mercury est disponible via les principaux fournisseurs de cloud tels qu’AWS Bedrock et Azure Foundry. Il est également accessible via des plateformes telles qu’OpenRouter et Quora. Vous pouvez commencer avec leur API.

Pour explorer le réglage fin, les déploiements privés et le support technique d’ingénierie déployé, contactez Inception.

Mercury offre une approche transformatrice de l’IA, la rendant plus rapide, plus efficace et plus accessible pour un large éventail d’applications. Essayez l’API Mercury dès aujourd’hui et découvrez la prochaine génération d’IA.

Meilleurs outils alternatifs à "Mercury"

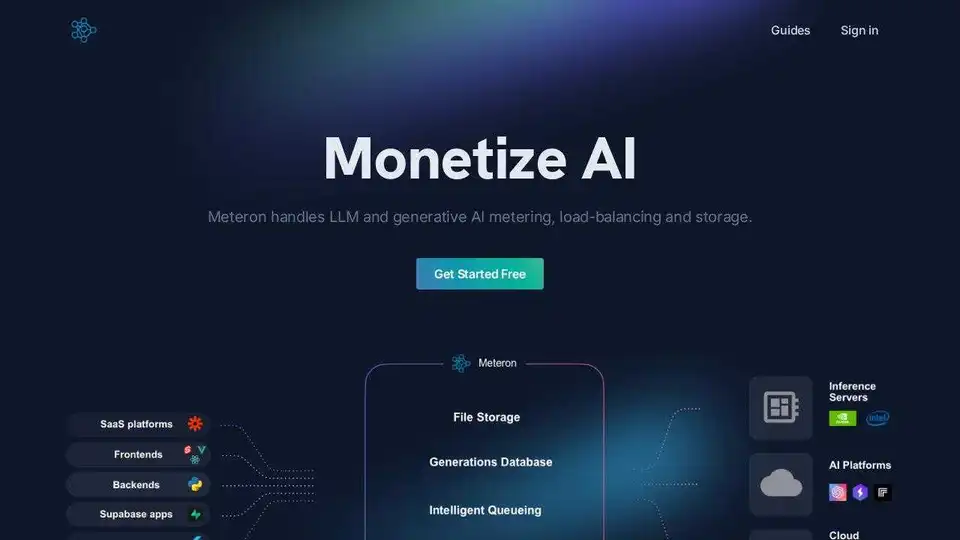

Meteron AI est un ensemble d'outils d'IA tout-en-un qui gère la mesure, l'équilibrage de charge et le stockage des LLM et de l'IA générative, ce qui permet aux développeurs de se concentrer sur la création de produits basés sur l'IA.

Explorez AI Library, le catalogue complet de plus de 2150 réseaux neuronaux et outils d'IA pour la création de contenu génératif. Découvrez les meilleurs modèles d'art IA, outils pour texte vers image, génération de vidéo et plus pour booster vos projets créatifs.

Tate-A-Tate est un créateur d'agents d'IA sans code qui vous permet de créer, de déployer et de monétiser des agents d'IA sans codage. Il dispose d'un marché intégré et d'une intégration transparente sur plusieurs plateformes.

BoltAI est une application Mac native qui intègre l'IA à votre flux de travail pour le codage, la création de contenu et plus encore, améliorant ainsi la productivité.

EmbedAPI est une plateforme d'intégration d'IA qui permet aux développeurs de se connecter à divers modèles d'IA tels que OpenAI, Anthropic et Google Gemini via une API unique. Elle offre des outils pour créer plus rapidement des applications alimentées par l'IA.

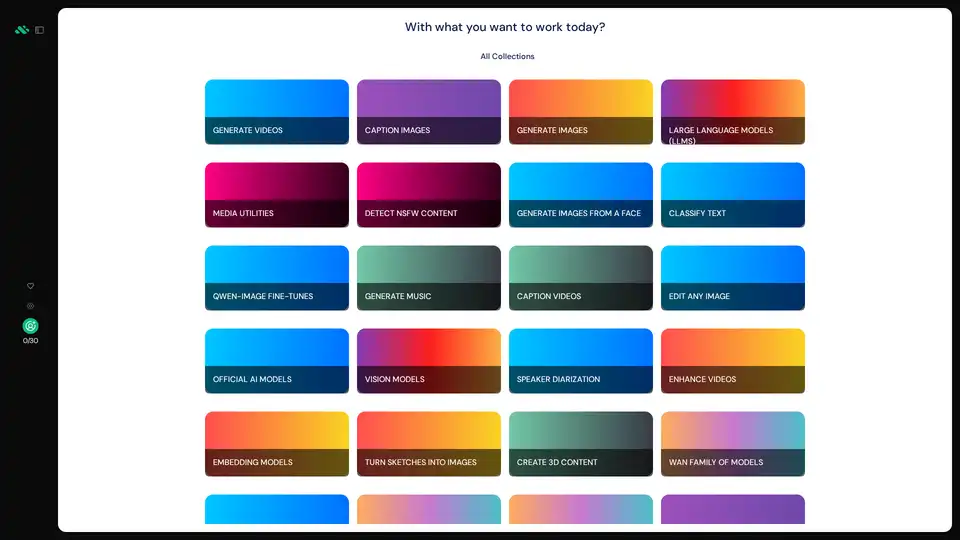

AIverse est une plateforme tout-en-un offrant l'accès à des milliers de modèles IA pour la génération d'images/vidéos, LLMs, texte-parole, création musicale et plus. Utilisation illimitée pour 20 $/mois.

TemplateAI est le modèle NextJS leader pour les apps IA, avec authentification Supabase, paiements Stripe, intégration OpenAI/Claude et composants AI prêts à l'emploi pour un développement full-stack rapide.

Discutez avec l'IA en utilisant vos clés API. Payez uniquement ce que vous utilisez. Prend en charge GPT-4, Gemini, Claude et autres LLMs. La meilleure interface de chat frontend LLM pour tous les modèles d'IA.

n8n est une plateforme d'automatisation de flux de travail alimentée par l'IA qui combine la flexibilité du code avec la vitesse sans code, offrant 500+ intégrations pour que les équipes techniques puissent créer des agents IA multi-étapes et automatiser des processus métier complexes.

PromptBuilder est une plateforme d'ingénierie d'invites d'IA conçue pour aider les utilisateurs à générer, optimiser et organiser des invites de haute qualité pour divers modèles d'IA tels que ChatGPT, Claude et Gemini, garantissant ainsi des résultats d'IA cohérents et efficaces.

Explorez TavonnAI, la plateforme ultime pour l'IA open source. Générez des images, des GIF animés et discutez avec l'IA en utilisant plus de 30 LLM. Essayez-le gratuitement dès aujourd'hui !

Cerebrium est une plateforme d'infrastructure d'IA sans serveur qui simplifie le déploiement d'applications d'IA en temps réel avec une faible latence, zéro DevOps et une facturation à la seconde. Déployez des LLM et des modèles de vision à l'échelle mondiale.

Writetic est un espace de travail IA conçu pour les spécialistes du marketing de contenu. Rationalisez la création de contenu grâce à des flux de travail basés sur l'IA, générez des articles optimisés pour le référencement et suivez les progrès de votre équipe au même endroit.

AllAIs : Écosystème IA qui multiplie par 10 votre productivité. Centre névralgique d'outils, de ressources et de tutoriels IA, qui libère le potentiel de l'IA.