Nebius

Vue d'ensemble de Nebius

Nebius : le cloud ultime pour les innovateurs en matière d’IA

Nebius est conçu comme la plateforme cloud ultime pour les innovateurs en IA, visant à démocratiser l’infrastructure d’IA et à autonomiser les créateurs du monde entier. Il offre une suite complète de ressources et de services pour prendre en charge chaque étape du cycle de vie du développement de l’IA.

Qu’est-ce que Nebius ?

Nebius est une plateforme cloud spécialement conçue pour les charges de travail d’IA exigeantes. Elle intègre des accélérateurs GPU NVIDIA avec des pilotes préconfigurés, InfiniBand à haute performance et des outils d’orchestration comme Kubernetes ou Slurm. Cette combinaison garantit une efficacité maximale pour la formation de modèles d’IA et l’inférence à n’importe quelle échelle.

Principales caractéristiques et avantages :

- Architecture flexible: faites évoluer en toute transparence les charges de travail d’IA d’un seul GPU à des clusters préoptimisés avec des milliers de GPU NVIDIA.

- Performance testée: conçue pour les charges de travail d’IA exigeantes, garantissant une efficacité maximale.

- Valeur à long terme: optimise chaque couche de la pile pour une efficacité inégalée et une valeur client substantielle.

- Derniers GPU NVIDIA: accès aux GPU NVIDIA GB200 NVL72, HGX B200, H200, H100 et L40S, connectés par un réseau InfiniBand avec jusqu’à 3,2 Tbit/s par hôte.

- Services gérés: déploiement fiable de MLflow, PostgreSQL et Apache Spark avec zéro effort de maintenance.

- Expérience native du cloud: gérez l’infrastructure en tant que code à l’aide de Terraform, API et CLI, ou utilisez la console intuitive.

- Assistance d’experts: assistance d’experts 24 h/24, 7 j/7 et assistance dédiée des architectes de solutions.

Comment fonctionne Nebius ?

Nebius optimise chaque couche de la pile d’IA pour fournir un environnement à haute performance. Cela comprend :

- Intégration du GPU NVIDIA: utilise les accélérateurs GPU NVIDIA avec des pilotes préconfigurés.

- Réseau à haute performance: utilise la technologie InfiniBand pour assurer un transfert de données rapide.

- Outils d’orchestration: tire parti de Kubernetes et de Slurm pour une gestion efficace des ressources.

Pourquoi choisir Nebius ?

Nebius offre plusieurs avantages par rapport à ses concurrents :

- Réduction des coûts: amélioration des réductions de coûts sur les GPU NVIDIA avec un engagement de centaines d’unités pendant au moins 3 mois.

- Évolutivité: capacité de passer d’un seul GPU à des milliers dans un cluster.

- Fiabilité: les services entièrement gérés garantissent un déploiement fiable des outils et des frameworks critiques.

À qui s’adresse Nebius ?

Nebius est idéal pour :

- Les chercheurs et les développeurs en IA

- Les ingénieurs en apprentissage automatique

- Les scientifiques des données

- Les organisations ayant besoin d’une infrastructure d’IA évolutive

Applications pratiques et cas d’utilisation :

Nebius a joué un rôle déterminant dans l’accélération de l’innovation en matière d’IA dans divers domaines :

- CRISPR-GPT (édition de gènes): a permis le criblage rapide des modèles et le réglage fin, transformant l’édition de gènes en flux de travail automatisés.

- Shopify (commerce électronique): fournit des clusters GPU à grande échelle pour le développement de modèles d’IA, améliorant la recherche de produits et les processus de paiement.

- vLLM (inférence LLM open source): performance d’inférence optimisée pour les modèles basés sur des transformateurs avec un débit élevé et une évolutivité transparente.

- Brave Software (recherche Web): fournit des résumés d’IA en temps réel pour les requêtes de recherche tout en maintenant les normes de confidentialité.

- CentML Platform (déploiement d’IA): optimise les plateformes d’inférence, offrant une mise à l’échelle flexible et une utilisation améliorée du matériel.

- TheStage AI (Stable Diffusion): réduit les coûts GPU grâce à des outils d’optimisation DNN.

- Recraft (outil de conception d’IA): a formé le premier modèle d’IA générative pour les concepteurs à partir de zéro.

- Wubble (création musicale): rationalise la création musicale avec une génération de musique de haute qualité et libre de droits.

- Simulacra AI (chimie quantique): génère des ensembles de données de haute précision pour les modèles de dynamique moléculaire.

- Quantori (découverte de médicaments): développe un cadre d’IA pour générer des molécules avec des formes 3D précises.

Nebius AI Cloud vs. Nebius AI Studio

Nebius propose deux produits principaux :

- AI Cloud: fournit un accès en libre-service à l’infrastructure d’IA.

- AI Studio: offre un environnement géré pour le développement de l’IA.

Tarification

Nebius offre des prix compétitifs pour les GPU NVIDIA, notamment :

- NVIDIA B200 GPU

- NVIDIA H200 GPU

- NVIDIA H100 GPU

En conclusion

Nebius se distingue comme une plateforme cloud robuste, flexible et rentable conçue pour accélérer l’innovation en matière d’IA. En donnant accès à des GPU NVIDIA de pointe, à une infrastructure optimisée et à une assistance d’experts, Nebius permet aux créateurs d’IA d’obtenir des résultats remarquables dans divers secteurs.

Meilleurs outils alternatifs à "Nebius"

Massed Compute offre une infrastructure de cloud computing GPU et CPU à la demande pour l'IA, l'apprentissage automatique et l'analyse de données. Accédez à des GPU NVIDIA hautes performances avec des forfaits flexibles et abordables.

Runpod est une plateforme cloud d'IA simplifiant la construction et le déploiement de modèles d'IA. Offrant des ressources GPU à la demande, une mise à l'échelle sans serveur et une disponibilité de niveau entreprise pour les développeurs d'IA.

Louez des GPU haute performance à faible coût avec Vast.ai. Déployez instantanément des locations de GPU pour l'IA, l'apprentissage automatique, l'apprentissage profond et le rendu. Tarification flexible et configuration rapide.

Anyscale, alimenté par Ray, est une plateforme pour exécuter et mettre à l'échelle toutes les charges de travail de ML et d'IA sur n'importe quel cloud ou sur site. Créez, déboguez et déployez des applications d'IA avec facilité et efficacité.

Deployo simplifie le déploiement des modèles d'IA, transformant les modèles en applications prêtes pour la production en quelques minutes. Infrastructure d'IA agnostique du cloud, sécurisée et évolutive pour un flux de travail d'apprentissage automatique sans effort.

AIStocks.io est une plateforme de recherche boursière alimentée par l'IA fournissant des prévisions en temps réel, des signaux de trading automatisés et des outils complets de gestion des risques pour des décisions d'investissement confiantes.

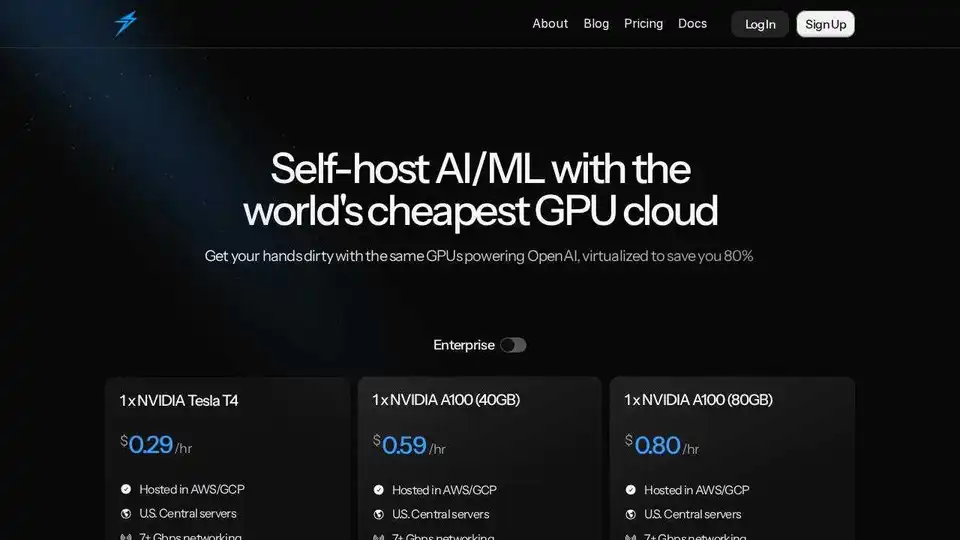

Thunder Compute est une plateforme cloud GPU pour l'IA/ML, offrant des instances GPU en un clic dans VSCode à des prix 80 % inférieurs à ceux de la concurrence. Parfait pour les chercheurs, les startups et les data scientists.

Phala Cloud offre une infrastructure cloud open source et sans confiance pour déployer des agents d'IA et des applications Web3, alimentée par TEE. Il garantit la confidentialité, l'évolutivité et est régi par le code.

Lumino est un SDK facile à utiliser pour l'entraînement à l'IA sur une plateforme cloud mondiale. Réduisez vos coûts de formation ML jusqu'à 80 % et accédez à des GPU non disponibles ailleurs. Commencez à entraîner vos modèles d'IA dès aujourd'hui !

Replicate vous permet d'exécuter et d'affiner des modèles d'apprentissage automatique open source avec une API cloud. Créez et faites évoluer facilement des produits d'IA.

Cirrascale AI Innovation Cloud accélère le développement de l'IA, la formation et les charges de travail d'inférence. Testez et déployez sur les principaux accélérateurs d'IA avec un débit élevé et une faible latence.

Float16.Cloud fournit des GPU sans serveur pour un développement rapide de l'IA. Exécutez, entraînez et faites évoluer des modèles d'IA instantanément sans configuration. Comprend des GPU H100, une facturation à la seconde et une exécution Python.

Plateforme IA ultra-rapide pour les développeurs. Déployez, affinez et exécutez plus de 200 LLMs et modèles multimodaux optimisés avec des API simples - SiliconFlow.

Predibase est une plateforme de développement pour l'affinage et le service de LLM open source. Obtenez une précision et une vitesse inégalées grâce à une infrastructure de formation et de service de bout en bout, avec un affinage de renforcement.