Spice.ai の概要

Spice.ai: オープンソースのデータと AI 推論エンジン

Spice.ai とは何ですか?

Spice.ai は、開発者が AI アプリケーションを簡単に構築できるように設計されたオープンソースのデータと AI 推論エンジンです。データ主導の AI ソリューションを構築するための構成要素を提供し、エンタープライズデータに基づいた SQL クエリフェデレーション、高速化、検索、および取得を可能にします。

主な機能と利点

- SQL クエリフェデレーション: 単一の SQL クエリを使用して、データベース、データウェアハウス、データレイク、APIs など、さまざまなソースのデータを結合します。これにより、データのサイロ化が解消され、データアクセスが簡素化されます。

- データ高速化: メモリ内または DuckDB や SQLite などの埋め込みデータベースを使用したデータの具体化と高速化により、高速、低レイテンシ、および高同時実行性のクエリパフォーマンスを実現します。

- AI モデルのデプロイとサービング: Llama3 などのローカルモデルをロードしてサービングするか、OpenAI、xAI、NVidia NIM などのホストされている AI プラットフォームを利用します。Spice.ai は、検索と取得のために特別に構築された LLM ツールを提供します。

- コンポーザブルな構成要素: データアクセス、高速化、検索、取得、および AI 推論のための構成要素を段階的に採用します。それらを構成して、データに基づいたアプリやエージェントを開発します。

- リアルタイムデータ更新: Debezium を使用した Change-Data-Capture (CDC) で高速化をリアルタイムで更新します。

- マルチクラウドと高可用性: エンタープライズレベルの SLA とサポートによってバックアップされた、高可用性、セキュリティ、パフォーマンス、およびコンプライアンスを備えたマルチクラウド環境で Spice Cloud Platform をデプロイします。SOC 2 Type II 認証を取得しています。

- エコシステム互換性: NumPy、Pandas、TensorFlow、PyTorch などの一般的なデータサイエンスライブラリとシームレスに統合します。

Spice.ai はどのように機能しますか?

Spice.ai は、Apache Arrow と DataFusion 上の Rust で構築されたポータブルコンピューティングエンジンを利用して、高速なシングルノードクエリエンジンを提供します。これにより、さまざまなソースからデータをクエリし、低レイテンシアクセスを実現するために高速化できます。

Spice.ai の使い方

- データに接続: Spice.ai は、Databricks、MySQL、FTP サーバー上の CSV ファイルなど、30 以上の最新およびレガシーソース用のコネクタを提供しています。ODBC、JDBC、ADBC、HTTP、Apache Arrow Flight (gRPC) などの業界標準プロトコルをサポートしています。

- データをクエリ: SQL を使用して、複数のソースにわたるデータをクエリします。Spice.ai は、単一のクエリで異なるソースからのデータを結合できる SQL クエリフェデレーション機能を提供します。

- データを高速化: メモリ内または DuckDB や SQLite などの埋め込みデータベースを使用してデータを具体化し、高速化します。これにより、クエリのパフォーマンスが向上します。

- AI モデルをデプロイしてサービング: ローカルモデルをロードしてサービングするか、ホストされている AI プラットフォームを利用します。Spice.ai は、検索と取得のために特別に構築された LLM ツールを提供します。

Spice.ai は誰のためのものですか?

Spice.ai は、データ主導の AI アプリケーションを構築したい開発者、データサイエンティスト、および AI エンジニア向けに設計されています。以下を含む幅広いユースケースに適しています。

- AI 搭載アプリケーション: さまざまなソースからのデータを活用するインテリジェントなアプリケーションを構築します。

- リアルタイム分析: データをリアルタイムで分析して、インサイトを得て、情報に基づいた意思決定を行います。

- 機械学習: 機械学習モデルを簡単にトレーニングしてデプロイします。

Spice.ai が重要なのはなぜですか?

Spice.ai は、包括的なツールと機能のセットを提供することで、データ主導の AI アプリケーションの構築プロセスを簡素化します。複雑なデータパイプラインとインフラストラクチャを構築する必要がなくなり、開発者は革新的な AI ソリューションの構築に集中できます。

Spice Cloud Platform とは何ですか?

Spice Cloud Platform は、Spice.ai を実行するためのマルチクラウド、高可用性環境を提供するマネージドサービスです。エンタープライズレベルの SLA とサポートによってバックアップされた、エンタープライズグレードのセキュリティ、パフォーマンス、およびコンプライアンスなどの機能が含まれています。

Spice.ai を始める

Spice.ai の使用を開始するのは簡単です。無料で開始し、わずか 3 行のコードでクエリを実行できます。

ユースケース

- データ主導のアプリケーションの構築

- リアルタイムデータ分析の実装

- 機械学習ワークフローの強化

コンポーザブルな構成要素とエンタープライズグレードのインフラストラクチャにより、Spice.ai は開発者が次世代のインテリジェントなアプリケーションを作成できるようにします。

Spice.ai の価格

Spice.ai は、さまざまなユーザーのニーズを満たすさまざまな価格プランを提供しています。無料プランから始めて、ニーズに合わせて有料プランにアップグレードできます。

結論

Spice.ai は、データ主導の AI アプリケーションの構築プロセスを簡素化する、強力なオープンソースのデータと AI 推論エンジンです。AI 搭載アプリケーションの構築、リアルタイム分析の実行、または機械学習モデルのトレーニングのいずれの場合でも、Spice.ai は成功に必要な構成要素を提供します。SQL クエリフェデレーション、データ高速化、および AI モデルのデプロイを提供し、簡単に始めることができます。データを高速化し、AI アプリケーションを構築する方法を探している開発者であれば、Spice.ai が最適なソリューションである可能性があります。

"Spice.ai" のベストな代替ツール

Nexa SDK は、LLM、マルチモーダル、ASR および TTS モデルの高速かつプライベートなデバイス上 AI 推論を可能にします。NPU、GPU、CPU を介して、モバイル、PC、自動車、IoT デバイスに本番環境対応のパフォーマンスでデプロイ。

AI Runnerは、アート、リアルタイムの音声会話、LLMを搭載したチャットボット、および自動化されたワークフローのためのオフラインAI推論エンジンです。画像生成、音声チャットなどをローカルで実行します!

Friendli Inference は、最速の LLM 推論エンジンであり、速度とコスト効率が最適化されており、高スループットと低レイテンシーを実現しながら、GPU コストを 50 ~ 90% 削減します。

llama.cpp を使用して効率的な LLM 推論を有効にします。これは、多様なハードウェア向けに最適化された C/C++ ライブラリで、量子化、CUDA、GGUF モデルをサポートしています。 ローカルおよびクラウド展開に最適です。

BrainHost VPS は、高性能 KVM 仮想サーバーを NVMe ストレージで提供し、AI 推論、ウェブサイト、eコマースに最適です。香港と US West で 30 秒の迅速なプロビジョニングにより、信頼性の高いグローバルアクセスを実現。

NVIDIA NIM API を利用して、主要な AI モデルの最適化された推論とデプロイメントを実現しましょう。サーバーレス API を使用してエンタープライズ生成 AI アプリケーションを構築したり、GPU インフラストラクチャでセルフホストしたりできます。

Floor Plan AIを使用して、AIでフロアプランを無料でデザインおよび生成します。数回クリックするだけで、テキストやスケッチをレイアウトや3D対応のビジュアルに変えることができます。サインアップは不要です。

MindSporeは、Huaweiが開発したオープンソースのAIフレームワークで、全シナリオの深層学習トレーニングと推論をサポートします。自動微分、分散トレーニング、柔軟なデプロイメントを特徴としています。

Cirrascale AI Innovation Cloudは、AI開発、トレーニング、推論のワークロードを加速します。 高スループットと低遅延で、主要なAIアクセラレータでテストおよびデプロイします。

エッジコンピューティング、産業オートメーション、AIソリューション向けに設計されたUP AI開発キットをご覧ください。高度なパフォーマンスのためにHailo-8を搭載。

SUFY の無料 CDN とスケーラブルなオブジェクトストレージを使用して、シームレスなデータ管理とメディア AI を実現します。100GB CDN/月と 3000 分のビデオトランスコーディングを無料で入手できます。

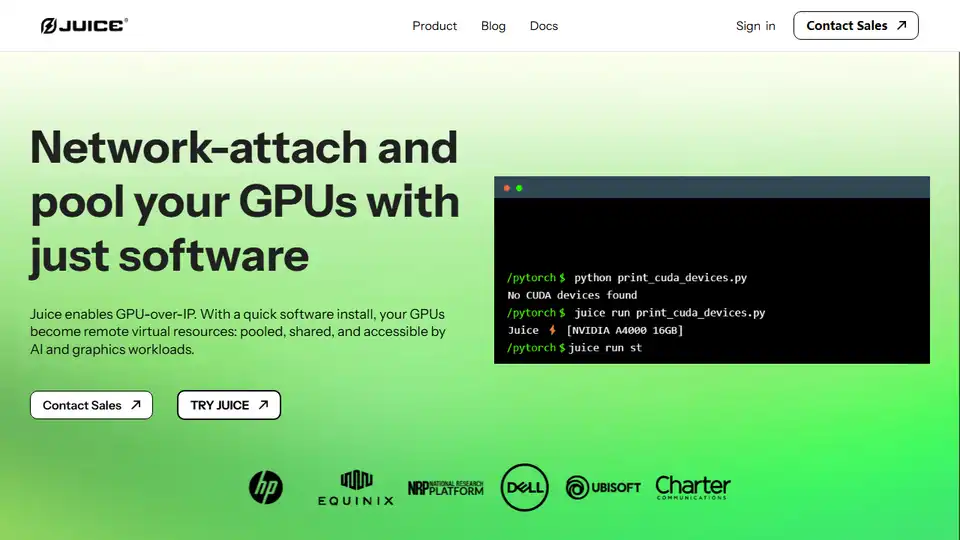

JuiceはGPU over IPを可能にし、ソフトウェアを使用してGPUをネットワーク接続してプールし、AIおよびグラフィックスのワークロードに使用できるようにします。

Denvr Dataworks は、オンデマンドGPUクラウド、AI推論、プライベートAIプラットフォームを含む、高性能AIコンピューティングサービスを提供します。 NVIDIA H100、A100、Intel Gaudi HPUでAI開発を加速。

LM-Kitは、エンタープライズグレードのツールキットを提供し、ローカルAIエージェントの統合、速度、プライバシー、信頼性を組み合わせ、次世代アプリケーションを強化します。ローカルLLMを活用して、より高速で、コスト効率が高く、安全なAIソリューションを実現します。