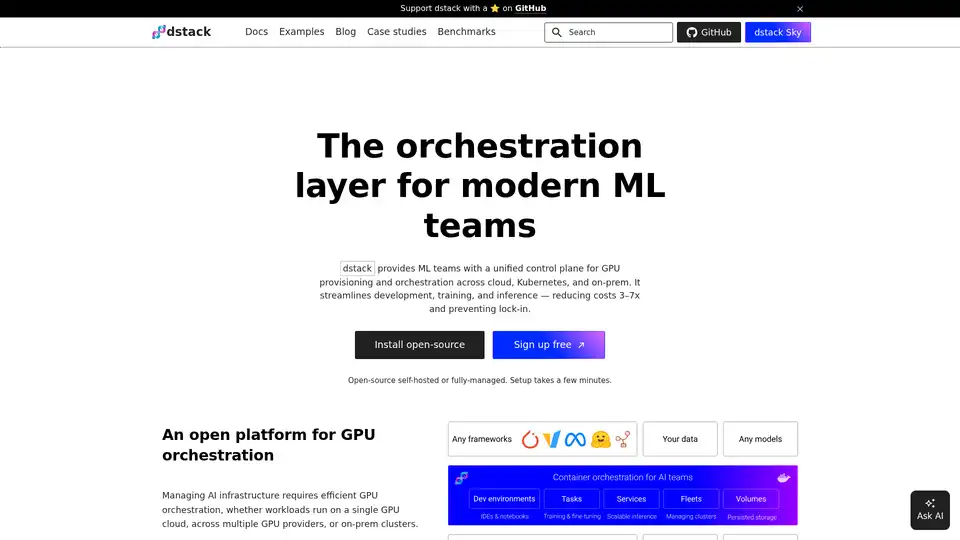

dstack の概要

dstackとは?

dstackは、機械学習(ML)チームの開発、トレーニング、推論プロセスを効率化するために設計されたオープンソースのAIコンテナオーケストレーションエンジンです。クラウド、Kubernetes、オンプレミスインフラストラクチャなど、さまざまな環境にわたるGPUプロビジョニングとオーケストレーションのための統一されたコントロールプレーンを提供します。dstackは、コストを削減し、ベンダーロックインを防ぐことで、MLチームがインフラストラクチャ管理ではなく、研究開発に集中できるようにします。

dstackの仕組み

dstackは、AIインフラストラクチャの管理を簡素化するオーケストレーションレイヤーとして機能します。主要なGPUクラウドとネイティブに統合し、クラスタプロビジョニングとワークロードオーケストレーションを自動化します。また、オンプレミスクラスタへの接続のためにKubernetesおよびSSHフリートをサポートします。主な機能は次のとおりです。

- GPUオーケストレーション: さまざまな環境にわたってGPUリソースを効率的に管理します。

- 開発環境: デスクトップIDEを強力なクラウドまたはオンプレミスGPUに簡単に接続できます。

- スケーラブルなサービスエンドポイント: モデルを安全で自動スケーリング可能なOpenAI互換のエンドポイントとして簡単にデプロイできます。

dstackは、あらゆるハードウェア、オープンソースツール、フレームワークと互換性があり、柔軟性を提供し、ベンダーロックインを回避します。

dstackの主な機能

- 統一されたコントロールプレーン: さまざまな環境にわたってGPUリソースを管理するための単一のインターフェイスを提供します。

- GPUクラウドとのネイティブ統合: 主要なGPUクラウドプロバイダーとのクラスタプロビジョニングとワークロードオーケストレーションを自動化します。

- KubernetesおよびSSHフリートのサポート: KubernetesまたはSSHフリートを使用してオンプレミスクラスタに接続します。

- 開発環境: クラウドまたはオンプレミスGPUへの接続を可能にすることで、開発ループを簡素化します。

- スケーラブルなサービスエンドポイント: モデルをOpenAIと互換性のある安全で自動スケーリング可能なエンドポイントとしてデプロイします。

- シングルノードおよび分散タスク: シングルインスタンスの実験とマルチノードの分散トレーニングの両方をサポートします。

dstackを選ぶ理由

dstackは、MLチームにいくつかの魅力的なメリットを提供します。

- コスト削減: 効率的なリソース利用により、インフラストラクチャコストを3〜7倍削減します。

- ベンダーロックインの防止: あらゆるハードウェア、オープンソースツール、フレームワークで動作します。

- 簡素化されたインフラストラクチャ管理: クラスタプロビジョニングとワークロードオーケストレーションを自動化します。

- 改善された開発ワークフロー: 使いやすい開発環境で開発ループを効率化します。

ユーザーの声:

- Wah Loon Keng, Sr. AI Engineer @Electronic Arts:「dstackを使用すると、EAのAI研究者はインフラストラクチャに触れることなく実験を開始およびスケーリングできます。」

- Aleksandr Movchan, ML Engineer @Mobius Labs:「dstackのおかげで、私のチームは手頃な価格のGPUにすばやくアクセスし、テストと開発から本格的なアプリケーション展開までのワークフローを効率化できます。」

dstackの使い方

- インストール:

uv tool install "dstack[all]"を介してdstackをインストールします。 - セットアップ: バックエンドまたはSSHフリートをセットアップします。

- チームの追加: チームをdstack環境に追加します。

dstackは、dstackai/dstack Dockerイメージを使用してどこにでもデプロイできます。

dstackは誰のためのものですか?

dstackは、以下のような場合に最適です。

- GPUリソースの利用率を最適化しようとしているMLチーム。

- インフラストラクチャコストを削減しようとしている組織。

- スケーラブルで柔軟な実験環境を必要とするAI研究者。

- ML開発ワークフローを効率化しようとしているエンジニア。

AIコンテナをオーケストレーションする最良の方法は?

dstackは、AIコンテナオーケストレーションのための優れたソリューションとして際立っており、さまざまな環境にわたるGPUリソースの管理にシームレスで効率的、かつ費用対効果の高いアプローチを提供します。Kubernetes、SSHフリートとの互換性、および主要なGPUクラウドとのネイティブ統合により、生産性を向上させ、インフラストラクチャのオーバーヘッドを削減しようとしているあらゆるMLチームにとって多目的な選択肢となります。

"dstack" のベストな代替ツール

Denvr Dataworks は、オンデマンドGPUクラウド、AI推論、プライベートAIプラットフォームを含む、高性能AIコンピューティングサービスを提供します。 NVIDIA H100、A100、Intel Gaudi HPUでAI開発を加速。

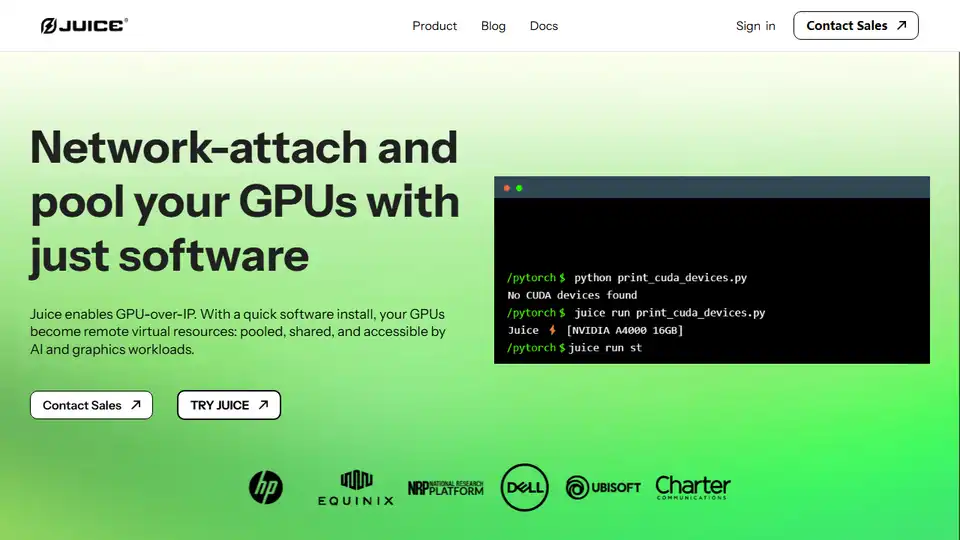

JuiceはGPU over IPを可能にし、ソフトウェアを使用してGPUをネットワーク接続してプールし、AIおよびグラフィックスのワークロードに使用できるようにします。

SaladCloudは、AI/ML推論向けの低価格で安全なコミュニティ主導の分散型GPUクラウドを提供します。計算コストを最大90%削減。AI推論、バッチ処理などに最適です。

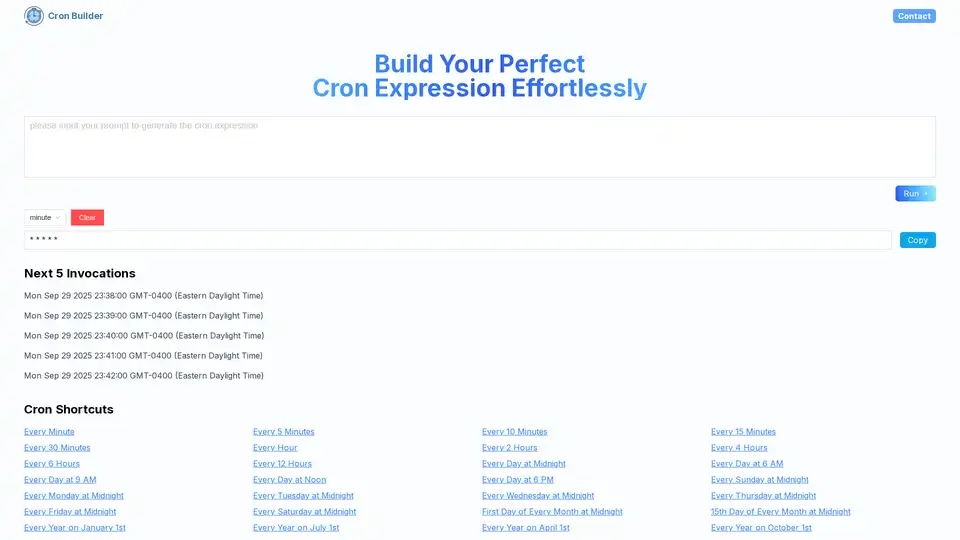

Cron AI Builderは、自然言語の記述とAI技術を使用して、タスクスケジューリングの自動化のためにcron式を簡単に生成するオンラインツールです。

ClawCloud Runは、統合GitOpsワークフロー、Docker/Kubernetesサポート、GitHub統合、AI自動化ツールを備えた高性能クラウドネイティブデプロイメントプラットフォームです。

Union.ai は、ワークフローの編成、コストの最適化、大規模な非構造化データの管理により、AI 開発ライフサイクルを効率化します。 Flyte 上に構築されており、本番環境に対応した AI システムの構築に役立ちます。

Flyte は、耐久性があり、柔軟性があり、Kubernetes ネイティブの AI/ML ワークフローを編成します。 スケーラブルなパイプラインの作成とデプロイメントで 3,000 以上のチームから信頼されています。

iBEAM の AI 駆動 4 ステッププロセスで、数週間でレガシー アプリケーションを近代化。専門家主導のアプリ変革で、パフォーマンスを向上させ、コストを削減し、セキュリティを強化し、スケーラビリティを確保。

Momentum AIは、75以上のSDLCワークフローを自動化するAI搭載の開発コンテナです。ローカルファースト実行で、安全、プライベート、無制限のコーディング、テスト、デプロイメントを提供します。

Klu は、チームが LLM を利用したアプリケーションを自信を持って反復、評価、最適化できるように設計された次世代 LLM アプリプラットフォームです。 プロンプトで共同作業し、変更を追跡し、インサイトを活用して迅速に反復します。

Signal0ne は、コンテナ化されたアプリケーション向けの AI 搭載デバッグを提供し、アラートのエンリッチメントと相関関係を通じて根本原因分析を自動化します。 今すぐディスカバリーミーティングをスケジュールしてください!

AquilaX Securityは、AIを搭載したDevSecOpsプラットフォームであり、セキュリティスキャンを自動化し、誤検知を減らし、開発者がより迅速に安全なコードを出荷できるようにします。SAST、SCA、コンテナ、IaC、シークレット、マルウェアスキャナーを統合します。

Snykは、AIによって生成されたコードからAIネイティブアプリまで、企業がアプリケーションを保護するのに役立つAI搭載の開発者セキュリティプラットフォームです。 SAST、SCA、コンテナセキュリティ、IaCセキュリティ、APIおよびWebセキュリティ用のツールを提供します。