Fireworks AI の概要

Fireworks AI: 生成AIのための最速推論エンジン

Fireworks AIとは? Fireworks AIは、生成AIモデルに最速の推論速度を提供するように設計されたプラットフォームです。ユーザーは、さまざまなユースケースに最適化されたオープンソースモデルを活用して、AIアプリケーションを簡単に構築、調整、拡張できます。

Fireworks AIの仕組み Fireworks AIは、低レイテンシ、高スループット、および同時実行のために最適化された推論エンジンを通じて、高いパフォーマンスを実現します。このプラットフォームは、DeepSeek、Llama、Qwen、Mistralなどの一般的なモデルをサポートしており、開発者はFireworks SDKを使用して迅速に実験と反復を行うことができます。

主な機能と利点

- 超高速推論: ミッションクリティカルなアプリケーションに適した、最小限のレイテンシでリアルタイムパフォーマンスを提供します。

- 高度なチューニング: 強化学習や量子化対応チューニングなどの手法を通じて、モデルの品質を最大化するためのツールを提供します。

- シームレスなスケーリング: 最新のGPUを複数のクラウドとリージョンにわたって自動的にプロビジョニングし、高可用性と一貫したパフォーマンスを保証します。

- オープンソースモデル: 幅広いオープンソースモデルをサポートし、柔軟性とカスタマイズオプションを提供します。

- エンタープライズ対応: 安全なチームコラボレーション、監視、およびコンプライアンス(SOC2 Type II、GDPR、HIPAA)の機能が含まれています。

ユースケース

Fireworks AIは、以下を含むさまざまなアプリケーションに適しています。

- 音声エージェント: 低レイテンシでリアルタイムの音声インタラクションを強化します。

- コードアシスタント: 高速な推論速度でコードの生成と補完を強化します。

- AI開発ツール: 微調整、AI搭載のコード検索、および改善された開発ワークフローのための深いコードコンテキストを可能にします。

Fireworks AIが重要な理由

Fireworks AIは、生成AIアプリケーションにおける速度とスケーラビリティのニーズに対応します。推論を最適化し、シームレスなスケーリングを提供することで、企業はパフォーマンスや費用対効果を犠牲にすることなく、AI機能を大規模に展開できます。

Fireworks AIは誰のためのものか?

Fireworks AIは以下に最適です。

- エンタープライズ: エンタープライズグレードのセキュリティとコンプライアンスを備えたAIソリューションを展開したいと考えています。

- 開発者: オープンソースモデルを試すための高速で柔軟なプラットフォームを探しています。

- AI研究者: AIモデルをトレーニングおよび展開するための堅牢なインフラストラクチャが必要です。

顧客の声

いくつかの企業がFireworks AIで成功を収めています。

- Cursor: CPOのSualeh Asif氏は、Fireworksのパフォーマンスと量子化されたモデルの品質の低下が最小限である点を称賛しました。

- Quora: プロダクトリードのSpencer Chan氏は、FireworksをオープンソースLLMの提供とLoRAアダプターのスケーリングに最適なプラットフォームとして強調しました。

- Sourcegraph: CTOのBeyang Liu氏は、CodyのようなAI開発ツールを構築するためのFireworksの高速で信頼性の高いモデル推論に注目しました。

- Notion: AIリードのSarah Sachs氏は、モデルを微調整するためにFireworksと提携することで、レイテンシが大幅に短縮されたと報告しました。

価格

Fireworks AIは、さまざまなニーズに合わせて柔軟な価格オプションを提供しています。詳細については、Pricingページをご覧ください。

はじめに

Fireworks AIでの構築を開始するには、websiteにアクセスして、利用可能なモデルとドキュメントをご覧ください。エンタープライズソリューションについては、セールスチームにお問い合わせください。

Fireworks AIを活用する最良の方法は何ですか? Fireworks AIのメリットを最大限に活用するには、まず特定のユースケースを特定し、適切なオープンソースモデルを選択します。Fireworks SDKを利用して、モデルを微調整し、アプリケーション用に最適化します。プラットフォームのスケーリング機能を利用して、インフラストラクチャを管理せずにAI機能をグローバルに展開します。

堅牢でスケーラブルな推論エンジンを提供することにより、Fireworks AIは開発者と企業が前例のない速度と効率で生成AIの力を活用できるようにします。

"Fireworks AI" のベストな代替ツール

開発者向けの超高速AIプラットフォーム。シンプルなAPIで200以上の最適化されたLLMとマルチモーダルモデルをデプロイ、ファインチューニング、実行 - SiliconFlow。

Xanderは、オープンソースのデスクトッププラットフォームで、ノーコードAIモデルトレーニングを可能にします。自然言語でタスクを記述するだけで、テキスト分類、画像分析、LLMファインチューニングの自動化パイプラインを実行し、ローカルマシンでプライバシーとパフォーマンスを確保します。

Friendli Inference は、最速の LLM 推論エンジンであり、速度とコスト効率が最適化されており、高スループットと低レイテンシーを実現しながら、GPU コストを 50 ~ 90% 削減します。

AI 駆動のアプリと AI エージェントを作成し、タスクを自動的に計画・実行します。Momen の柔軟な GenAI アプリ開発フレームワークでフルスタック AI アプリを構築し、収益化しましょう。今日から始めよう!

Spice.ai は、エンタープライズデータに基づいた SQL クエリフェデレーション、アクセラレーション、検索、および取得を使用して AI アプリを構築するためのオープンソースのデータおよび AI 推論エンジンです。

Devika AIは、高レベルの指示を理解し、それを分解し、関連情報を調査し、Claude 3、GPT-4、GPT-3.5、およびローカルLLMを使用してコードを生成できるオープンソースのAIソフトウェアエンジニアです。

AI Runnerは、アート、リアルタイムの音声会話、LLMを搭載したチャットボット、および自動化されたワークフローのためのオフラインAI推論エンジンです。画像生成、音声チャットなどをローカルで実行します!

Agent TARS は、オープンソースのマルチモーダル AI エージェントで、ブラウザ操作、コマンドライン、ファイルシステムをシームレスに統合し、ワークフロー自動化を強化します。高度な視覚解釈と洗練された推論でタスクを効率的に処理します。

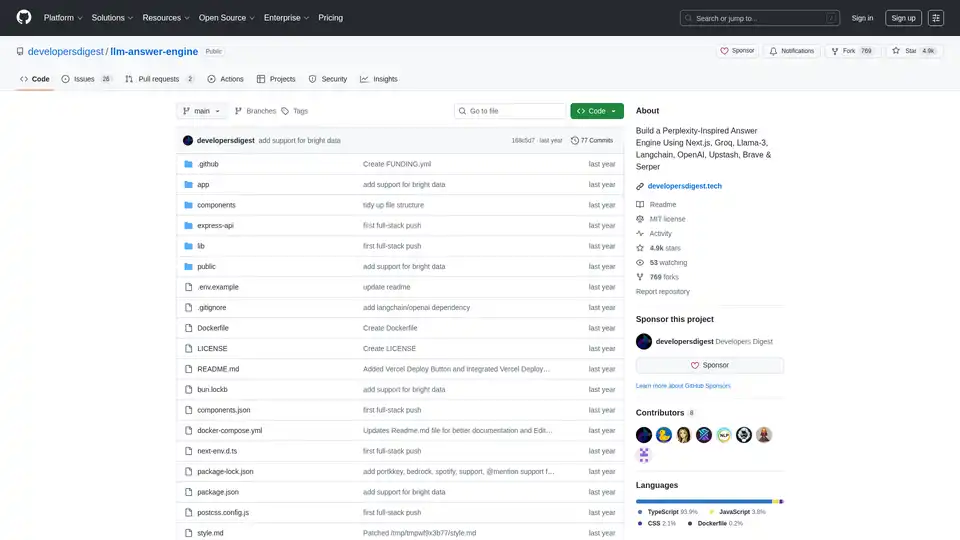

Next.js, Groq, Llama-3、Langchain を使用して、Perplexity に触発された AI 回答エンジンを構築します。ソース、回答、画像、フォローアップの質問を効率的に取得します。

Lettria は、構造化されていないデータを構造化された知識に変換し、よりスマートな意思決定を可能にする AI プラットフォームです。 Lettria のグラフベース AI で RAG の精度を向上させます。

Chat2DB は、自然言語を SQL クエリに変換する AI 搭載の SQL クライアントです。MySQL、Redis、MongoDB をサポートし、Text2SQL および BI 機能でデータベース管理を強化します。

Lettriaは、GraphRAGを使用して非構造化データを構造化された知識に変換し、金融、ヘルスケア、法律などの規制産業における意思決定を強化するAIプラットフォームです。

vLLMは、LLM のための高スループットかつメモリ効率の良い推論およびサービングエンジンであり、最適化されたパフォーマンスのためにPagedAttentionと継続的なバッチ処理を備えています。

Cortexは、分散型ネットワーク上でAIモデルをサポートするオープンソースのブロックチェーンプラットフォームであり、スマートコントラクトとDAppsへのAI統合を可能にします。