Vespa.ai の概要

Vespa.aiとは?

Vespa.aiは、ビッグデータ、ベクトル検索、機械学習ランキング、リアルタイム推論を活用した大規模アプリケーションの開発と運用向けに設計された強力なAI検索プラットフォームです。開発者は、Retrieval Augmented Generation(RAG)、レコメンデーションエンジン、インテリジェントな検索機能など、洗練されたリアルタイムAIアプリケーションをエンタープライズ規模で構築できます。

Vespa.aiの仕組み

Vespa.aiは、いくつかの主要機能を組み合わせてその機能を提供します。

- ベクトル、テキスト、構造化検索: Vespaは、ベクトル、テンソル、テキスト、構造化データを使用して、クエリ、整理、推論をサポートします。

- 分散型機械学習ランキング: 関連性のために機械学習モデル推論を統合し、高品質の検索結果を保証します。

- 高パフォーマンス: Vespaは、数十億のデータアイテムにスケールし、1秒あたり数千のクエリを処理し、100ミリ秒未満のレイテンシを維持するように設計されています。

- 自動スケーラビリティ: 無限の自動スケーラビリティにより、アプリケーションはパフォーマンスのボトルネックなしに成長できます。

- 継続的なデプロイメントとアップグレード: アプリケーションを最新の状態に保つための継続的なデプロイメントとアップグレードをサポートします。

- 強力なセキュリティによる完全な管理: 堅牢なセキュリティ機能を備えた完全管理環境を提供します。

Vespa.aiの主な機能と利点

- ハイブリッド検索: ベクトル類似性、関連性モデル、およびマルチベクトル表現を組み合わせて、優れた検索関連性を実現します。

- リアルタイムAI: RAG、レコメンデーション、インテリジェント検索などのリアルタイムAIアプリケーションをエンタープライズ規模で実現します。

- スケーラビリティ: 常に変化する数十億のデータアイテムを処理するように設計されており、大規模アプリケーションに適しています。

- 低レイテンシ: 100ミリ秒未満のレイテンシで検索結果を提供し、応答性の高いユーザーエクスペリエンスを保証します。

- 汎用性: 検索、生成AI、レコメンデーション、半構造化ナビゲーションなど、幅広いユースケースをサポートします。

ユースケース

Vespa.aiは、さまざまなユースケースに適しています。

- 検索: 主要なオープンテキスト検索エンジンとして、Vespaは他のソリューションでは実現が難しい高品質の検索アプリケーションを可能にします。

- 生成AI(RAG): Vespaは、ハイブリッド検索、関連性モデル、マルチベクトル表現を通じて優れた検索関連性を提供することにより、GenAIアプリケーションを強化します。

- レコメンデーションとパーソナライゼーション: コンテンツ検索と機械学習モデル評価を組み合わせた、レコメンデーション、パーソナライゼーション、広告ターゲティングシステムを構築します。

- 半構造化ナビゲーション: 構造化データとテキスト+画像の組み合わせを必要とするeコマースアプリケーションに最適で、検索とレコメンデーションを構造化ナビゲーションとシームレスに統合します。

- 個人/プライベート検索: 個人データを扱うアプリケーション向けの特別なモード(ストリーミング検索)を提供し、業界をリードする機能を低コストで提供します。

Vespa.aiは誰のためですか?

Vespa.aiは、次のユーザー向けに設計されています。

- 開発者: データ駆動型アプリケーションを構築するためのツールとリソースを提供します。

- データサイエンティスト: ランキングと関連性のために機械学習モデルの使用を可能にします。

- エンタープライズ: 厳しいパフォーマンス要件を持つ大規模アプリケーションをサポートします。

Vespa.aiの使い方

- 無料トライアルを開始: 無料トライアルにサインアップして、Vespaの機能を探索します。

- 最初のアプリケーションを構築: サンプルアプリと開発者リソースを利用して、最初のアプリケーションを作成します。

- ドキュメントの探索: 包括的なドキュメントにアクセスして、Vespaのアーキテクチャ、機能、ユースケースを理解します。

- コミュニティに参加: Slackで他のVespa開発者と交流して、知識を交換し、サポートを受けます。

Vespa.aiを選ぶ理由

- 大規模での実績: Spotify、Elicit、Yahoo、Farfetchなどの世界中の革新的なチームから信頼されています。

- 柔軟性: さまざまなタイプのデータと複雑なランキング要件に対応します。

- 効率: リソースの使用率を最適化し、運用コストを削減します。

- イノベーション: 最新のAIアプリケーションの要求を満たすために継続的に進化しています。

顧客の声

- Spotify: Spotifyの検索エンジニアリングディレクターであるDaniel Doro氏は、VespaがSpotifyでの検索を可能にする上で重要な役割を果たし、Spotifyリスナーのエクスペリエンスを向上させることができたと述べています。

結論

Vespa.aiは、機能、パフォーマンス、スケーラビリティの独自の組み合わせを提供する包括的なAI検索プラットフォームです。検索エンジン、レコメンデーションシステム、または生成AIアプリケーションを構築する場合でも、Vespa.aiは成功に必要なツールとインフラストラクチャを提供します。複雑なデータを処理し、リアルタイムの結果を提供し、数十億のデータアイテムにスケールする機能により、AIの力を活用しようとする企業にとって理想的な選択肢です。

ベクトル検索、機械学習ランキング、リアルタイム推論を統合することにより、Vespa.aiは開発者がビジネス価値を推進し、ユーザーエクスペリエンスを向上させるインテリジェントなデータ駆動型アプリケーションを作成できるようにします。データ駆動型アプリケーションを構築する最良の方法をお探しの場合、Vespa.aiは信頼できる選択肢です。

"Vespa.ai" のベストな代替ツール

Sagify は、オープンソースの Python ツールで、AWS SageMaker 上の機械学習パイプラインを簡素化し、独自およびオープンソースの大規模言語モデルをシームレスに統合する統一 LLM ゲートウェイを提供します。

Weaviateは、AIを活用したアプリケーションの構築を簡素化するAIネイティブなベクトルデータベースです。セマンティック検索、RAG、AIエージェントなどの機能を提供します。AIイノベーターから信頼され、数十億のベクトルに拡張可能です。

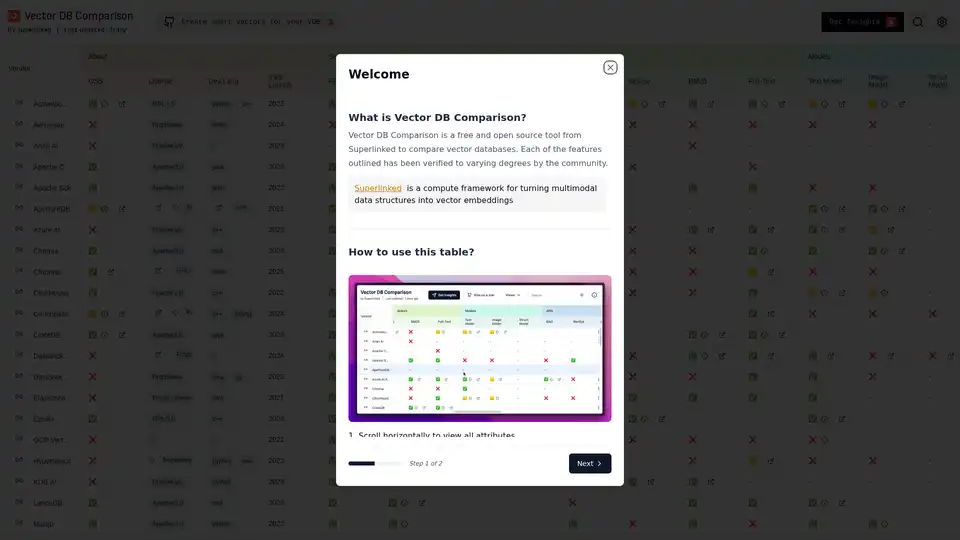

Vector DB Comparison は、Superlinked が提供する、ベクトルデータベースを比較するための無料のオープンソースツールです。 機能、ライセンス、言語などでフィルタリングして、AIプロジェクトに適したデータベースを見つけてください。

Infrabase.aiは、AIインフラストラクチャツールとサービスを発見するためのディレクトリです。ベクトルデータベース、プロンプトエンジニアリングツール、推論APIなどを見つけて、ワールドクラスのAI製品を構築してください。

YouTube-to-Chatbotは、オープンソースのPythonノートブックで、OpenAI、LangChain、Pineconeを使用してYouTubeチャンネル全体でAIチャットボットを訓練します。ビデオコンテンツから魅力的な会話エージェントを構築するクリエイターに最適です。

Pineconeは、数十億のアイテムから類似のマッチをミリ秒単位で検索できるベクトルデータベースで、知識豊富なAIアプリケーションを構築するために設計されています。

SvectorDB は、AWS 向けに構築されたサーバーレスベクトルデータベースであり、費用対効果の高いベクトル検索と、プロトタイプから本番環境へのシームレスなスケーリングを提供します。

LangSearchは、LLMアプリケーションをクリーンで正確なコンテキストに接続するためのWeb検索APIとセマンティックランキングAPIを提供します。

Infinityは、LLMアプリケーション向けに設計されたAIネイティブデータベースであり、密な埋め込み、疎な埋め込み、テンソル、および全文にわたる信じられないほど高速なハイブリッド検索を提供します。数百万規模のデータセットで0.1msのクエリレイテンシを実現します。

Lamatic.ai は、ローコードのビジュアルビルダーと組み込みのベクトルデータベースを備えたマネージド PaaS です。シームレスな統合とゼロ運用で、エッジ上で高性能な GenAI アプリを構築、テスト、デプロイします。

Superlinked:高性能な検索および推奨アプリケーションを構築するAIエンジニア向けのPythonフレームワークおよびクラウドインフラストラクチャ。

Singlebase は、AI ネイティブの Firebase の代替であり、AI アプリケーションに統合バックエンドを提供します。 ベクトル DB、NoSQL DB、認証、ストレージ、統合 AI サービスを 1 つのプラットフォームで提供します。