DeepSeek V3

Visão geral de DeepSeek V3

O que é o DeepSeek V3?

DeepSeek V3 é um modelo de linguagem de grande escala open-source revolucionário que possui impressionantes 671 bilhões de parâmetros, com 37 bilhões ativados por token para processamento eficiente. Desenvolvido como uma solução de IA state-of-the-art, capacita usuários a aproveitar compreensão e geração avançada de linguagem natural sem as barreiras de custo ou restrições proprietárias. Se você está explorando IA para pesquisa, desenvolvimento ou projetos comerciais, o DeepSeek V3 destaca-se por sua acessibilidade e performance, tornando-o uma escolha top entre modelos de IA gratuitos no panorama em rápida evolução de ferramentas de aprendizado de máquina.

Este modelo não é apenas outra iteração—ele é projetado para rivalizar com sistemas proprietários líderes enquanto permanece totalmente open-source. Lançado com foco em escalabilidade e usabilidade, o DeepSeek V3 suporta um generoso comprimento de contexto de 128K, permitindo o tratamento de entradas extensas como documentos longos ou conversas complexas. Sua arquitetura otimiza tanto profundidade quanto eficiência, garantindo saídas de alta qualidade mesmo em hardware modesto quando executado localmente.

Como o DeepSeek V3 funciona?

Em seu núcleo, o DeepSeek V3 opera na arquitetura baseada em transformers, um padrão em modelos de linguagem de grande escala modernos. Os 671 bilhões de parâmetros do modelo permitem capturar padrões intrincados em vastos conjuntos de dados, desde tarefas de processamento de linguagem natural até geração de conteúdo criativo. Para cada token processado, apenas 37 bilhões de parâmetros são ativados, o que é uma abordagem inteligente de mixture-of-experts (MoE) que reduz sobrecarga computacional sem sacrificar capacidade. Isso significa tempos de inferência mais rápidos e demandas de recursos menores comparado a modelos densos de escala similar.

Usuários podem interagir com o DeepSeek V3 de duas formas primárias: através de uma demo online intuitiva ou baixando o código-fonte completo para implantação local. A versão online executa diretamente no seu navegador, aproveitando infraestrutura em nuvem para acesso instantâneo—nenhuma configuração necessária. No lado local, a implementação open-source no GitHub fornece tudo necessário: pesos do modelo, código e documentação. A integração é direta via endpoints de API, suportando frameworks populares como a biblioteca Hugging Face Transformers do Python. Por exemplo, desenvolvedores podem carregar o modelo com um comando simples e começar a gerar texto, assistência de codificação ou até traduções.

O treinamento do modelo enfatiza fontes de dados diversificadas, incluindo textos multilíngues, repositórios de código e literatura científica, resultando em performance robusta across domains. Sua natureza open-source também convida contribuições da comunidade, fostering melhorias contínuas através de forks e pull requests no GitHub.

Como usar o DeepSeek V3?

Começar com o DeepSeek V3 é notavelmente simples, alinhando-se com seu ethos de acesso à IA sem barreiras.

Demo Online: Vá para a plataforma DeepSeek Online e clique em 'Try Now'. Nenhum registro ou cartão de crédito é necessário—apenas digite seu prompt e receba respostas em segundos. Isso é ideal para testes rápidos, brainstorming de ideias ou avaliar os pontos fortes do modelo em tempo real.

Instalação Local: Visite o repositório GitHub para baixar os modelos DeepSeek-V3-Base ou DeepSeek-V3 completos. Requisitos de sistema variam: uma GPU com pelo menos 24GB de VRAM é recomendada para performance ideal, embora o modo apenas CPU funcione para tarefas mais leves. A instalação envolve clonar o repo, instalar dependências via pip e executar scripts de inferência. Documentação abrangente guia você através de técnicas de quantização para ajustar o modelo em hardware consumer.

Integração API: Para aplicações de produção, use os wrappers de API fornecidos. Incorpore o DeepSeek V3 em chatbots, ferramentas de conteúdo ou pipelines de análise. Exemplos de snippets de código no repo demonstram como lidar com requisições, gerenciar contextos e fine-tunar para casos de uso específicos.

Acesso ilimitado significa que você pode experimentar livremente, sem limites de taxa na demo online. Para uso comercial, a licença permissiva permite redistribuição e modificação, desde que atribuição seja dada.

Por que escolher o DeepSeek V3?

Em um mercado inundado com serviços de IA pagos, o DeepSeek V3 brilha por seu modelo de custo zero e abertura incomparável. Eis por que é um game-changer:

Poder incomparável sem custo: Com 671 bilhões de parâmetros, ele oferece saídas comparáveis a modelos de topo como GPT-4 em benchmarks de raciocínio, codificação e tarefas multilíngues. No entanto, é totalmente gratuito, inclusive para empresas escalando soluções de IA.

Liberdade comercial: Diferente de muitos tiers gratuitos que restringem uso, o DeepSeek V3 permite aplicação comercial completa. Startups e empresas podem construir produtos geradores de receita sem taxas de licença.

Excelência driven pela comunidade: Apoiado por uma comunidade GitHub vibrante, o modelo beneficia-se de atualizações rápidas, correções de bugs e extensões. Contribuições de usuários já melhoraram suas capacidades de fine-tuning para domínios de nicho como texto jurídico ou médico.

Versátil e eficiente: A janela de contexto de 128K suporta geração de longo formato, enquanto a ativação MoE mantém o uso de energia baixo—crucial para desenvolvimento sustentável de IA.

Comparado a concorrentes, o DeepSeek V3 frequentemente supera em métricas de eficiência. Por exemplo, em benchmarks de codificação, ele gera scripts Python funcionais com menos erros que modelos abertos menores, e seu suporte multilíngue supera alternativas centradas em inglês.

Para quem é o DeepSeek V3?

DeepSeek V3 atende a um amplo público no ecossistema de IA:

Desenvolvedores e pesquisadores: Ideal para prototipar aplicações de IA, experimentar com fine-tuning ou avançar projetos de aprendizado de máquina. Seu código open-source acelera inovação sem vendor lock-in.

Empresas e startups: Perfeito para integração de IA custo-efetiva em bots de atendimento ao cliente, automação de conteúdo ou ferramentas de análise de dados. A licença comercial remove obstáculos legais para monetização.

Educadores e estudantes: Use a demo online para aprendizado hands-on sobre modelos de linguagem de grande escala. É uma forma prática de ensinar conceitos de NLP sem assinaturas caras.

Criadores de conteúdo e hobbyists: Gere artigos, snippets de código ou escrita criativa sem esforço. O acesso gratuito ilimitado torna acessível para usuários casuais explorando o potencial da IA.

Se você busca o melhor modelo de IA gratuito para tarefas como escrita automatizada de relatórios, depuração de código ou tradução multilíngue, o DeepSeek V3 encaixa perfeitamente.

Principais casos de uso e valor prático

A versatilidade do DeepSeek V3 desbloqueia inúmeras aplicações:

Geração de linguagem natural: Rascunhe emails, blogs ou cópia de marketing com precisão consciente de contexto. Por exemplo, insira um esboço de tópico e obtenha um artigo polido de 1000 palavras.

Assistência de codificação: Atua como um companheiro de programação IA, sugerindo completions, revisando código ou explicando algoritmos. Desenvolvedores relatam workflows 30-50% mais rápidos ao usá-lo alongside IDEs.

Pesquisa e análise: Resuma papers, gere hipóteses ou analise conjuntos de dados. Seu contexto longo lida com documentos de pesquisa completos, auxiliando acadêmicos em revisões de literatura.

Aplicações multilíngues: Suporta mais de 20 idiomas, tornando-o valioso para equipes globais em tradução, localização ou suporte ao cliente internacional.

O valor prático reside em democratizar IA high-end. Ao eliminar paywalls, ele nivela o campo, permitindo que pequenas equipes compitam com gigantes de tech. Usuários elogiam sua confiabilidade em FAQs, notando configuração rápida e resultados consistentes. Uma pergunta comum: "É realmente gratuito para uso comercial?" Sim—baixe e implante sem amarras.

Para requisitos de sistema, execuções locais need hardware robusto (ex.: GPUs NVIDIA A100 para velocidade total), mas versões quantizadas rodam em laptops. FAQs de integração cobrem troubleshooting, como lidar com chaves API ou otimizar para edge devices.

Perguntas frequentes

Quais são os requisitos de sistema para executar o DeepSeek V3?

Para uso local, uma máquina com 80+ GB de RAM e uma GPU high-end é ideal. Opções de cloud via demo online contornam isso.

Posso integrar o DeepSeek V3 em minhas aplicações existentes?

Absolutamente—use a documentação do GitHub para configuração de API. É compatível com os principais frameworks de ML.

Como o DeepSeek V3 se compara a outros modelos de IA?

Ele iguala ou excede muitos em benchmarks de eficiência e qualidade de saída, tudo enquanto é gratuito e aberto.

Em resumo, o DeepSeek V3 representa o futuro da IA acessível, misturando poder bruto com design user-friendly. Se você é um engenheiro de IA experiente ou um iniciante curioso, este modelo oferece valor tangível ao simplificar capacidades avançadas. Baixe hoje do GitHub ou teste a demo online para ver por que é aclamado como o modelo de IA gratuito mais poderoso disponível.

Melhores ferramentas alternativas para "DeepSeek V3"

MemoriPy é uma camada de memória AI de código aberto que equipa agentes de IA com memória semelhante à humana, permitindo conversas ricas em contexto e precisão aprimorada. Ideal para bots de suporte, assistentes pessoais e agentes de aprendizagem.

Promptfoo é uma ferramenta de segurança LLM de código aberto usada por mais de 200.000 desenvolvedores para red-teaming e avaliações de IA. Ajuda a encontrar vulnerabilidades, maximizar a qualidade da saída e detectar regressões em aplicações de IA.

FinGPT: Um grande modelo de linguagem financeira de código aberto para democratizar dados financeiros, análise de sentimento e previsão. Ajuste fino rapidamente para obter insights de mercado oportunos.

CrewAI é uma plataforma multi-agente de código aberto que permite construir e orquestrar fluxos de trabalho de automação IA com qualquer LLM e plataforma de nuvem para aplicações empresariais.

vLLM é um mecanismo de inferência e serviço de alto rendimento e com eficiência de memória para LLMs, apresentando PagedAttention e processamento em lote contínuo para desempenho otimizado.

Plataforma de IA ultrarrápida para desenvolvedores. Implante, ajuste e execute mais de 200 LLMs e modelos multimodais otimizados com APIs simples - SiliconFlow.

Sagify é uma ferramenta Python de código aberto que simplifica pipelines de ML no AWS SageMaker, com uma Gateway LLM unificada para integração perfeita de modelos de linguagem grande proprietários e open-source.

Explore o Qwen3 Coder, o modelo avançado de geração de código IA da Alibaba Cloud. Aprenda sobre seus recursos, benchmarks de desempenho e como usar esta ferramenta open-source poderosa para desenvolvimento.

DeepSeek se concentra em modelos AGI líderes. Eles lançaram vários modelos de bilhões de parâmetros como DeepSeek-LLM e DeepSeek-Coder.

Acuration IQ é um decodificador de mercado alimentado por IA que transforma dados complexos em insights acionáveis para sinergias B2B, pesquisa de mercado e tomada de decisões orientada por dados.

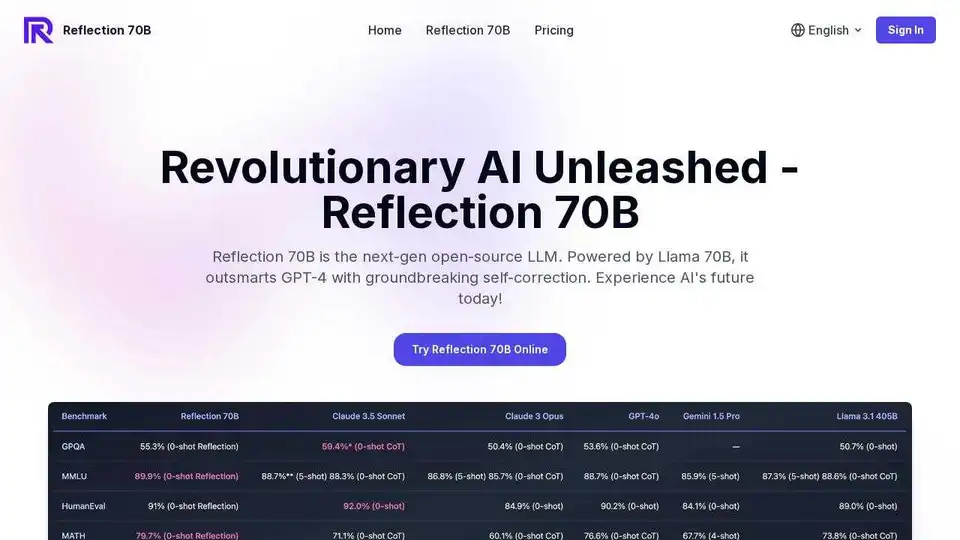

Experimente o Reflection 70B, o principal modelo de IA de código aberto do mundo. Treinado com Reflection-Tuning, ele detecta e corrige erros de raciocínio em tempo real, tornando-o perfeito para tarefas complexas.

DECipher: Ferramenta de IA que aproveita 75 anos de dados de desenvolvimento global da USAID para decisões informadas.

Experimente o Reflection 70B online, um LLM de código aberto baseado no Llama 70B. Supera o GPT-4 com autocorreção inovadora. Teste gratuito online disponível.

DeepSeek v3 é um poderoso LLM orientado por IA com 671 bilhões de parâmetros, oferecendo acesso à API e artigo de pesquisa. Experimente nossa demonstração online para obter um desempenho de última geração.