Mercury

Visão geral de Mercury

Mercury: Revolucionando a IA com LLMs de Difusão

O que é Mercury? Mercury, desenvolvido pela Inception, representa uma nova era em Modelos de Linguagem Grandes (LLMs) ao alavancar a tecnologia de difusão. Esses LLMs de difusão (dLLMs) oferecem vantagens significativas em velocidade, eficiência, precisão e controlabilidade em comparação com os LLMs autorregressivos tradicionais.

Como o Mercury funciona?

Ao contrário dos LLMs convencionais que geram texto sequencialmente, um token de cada vez, os dLLMs do Mercury geram tokens em paralelo. Esse processamento paralelo aumenta drasticamente a velocidade e otimiza a eficiência da GPU, tornando-o ideal para aplicações de IA em tempo real.

Principais Características e Benefícios:

- Inferência Incrivelmente Rápida: Experimente latência ultrabaixa, possibilitando interações de IA responsivas.

- Qualidade de Ponta: Beneficie-se da alta precisão e geração de texto controlável.

- Econômico: Reduza os custos operacionais com a eficiência máxima da GPU.

- Compatível com a API OpenAI: Integre perfeitamente o Mercury em fluxos de trabalho existentes como uma substituição direta para LLMs tradicionais.

- Janela de Contexto Grande: Tanto o Mercury Coder quanto o Mercury suportam uma janela de contexto de 128K.

Aplicações de IA Impulsionadas por Mercury:

A velocidade e a eficiência do Mercury desbloqueiam uma ampla gama de aplicações de IA:

- Codificação: Acelere os fluxos de trabalho de codificação com preenchimento automático extremamente rápido, sugestões de abas e edição.

- Voz: Ofereça experiências de voz responsivas em atendimento ao cliente, tradução e vendas.

- Pesquisa: Apresente instantaneamente dados relevantes de qualquer base de conhecimento, minimizando o tempo de pesquisa.

- Agentes: Execute sistemas complexos de várias rodadas, mantendo a baixa latência.

Modelos Mercury:

- Mercury Coder: Otimizado para fluxos de trabalho de codificação, suportando streaming, uso de ferramentas e saída estruturada. Preços: Entrada $0,25 | Saída $1 por 1 milhão de tokens.

- Mercury: dLLM de uso geral que fornece latência ultrabaixa, também suportando streaming, uso de ferramentas e saída estruturada. Preços: Entrada $0,25 | Saída $1 por 1 milhão de tokens.

Por que escolher Mercury?

Depoimentos de profissionais do setor destacam a velocidade e o impacto excepcionais do Mercury:

- Jacob Kim, Engenheiro de Software: "Fiquei surpreso com a rapidez. Os milhares de tokens por segundo eram absolutamente incríveis, nada que eu já tenha visto antes."

- Oliver Silverstein, CEO: "Depois de experimentar o Mercury, é difícil voltar atrás. Estamos animados para implementar o Mercury para dar suporte a todos os nossos agentes de voz."

- Damian Tran, CEO: "Reduzimos as despesas gerais de roteamento e classificação para latências abaixo de um segundo, mesmo em rastreamentos de agentes complexos."

Para quem é o Mercury?

Mercury foi projetado para empresas que buscam:

- Melhorar o desempenho de aplicações de IA.

- Reduzir os custos de infraestrutura de IA.

- Obter uma vantagem competitiva com tecnologia de IA de ponta.

Como integrar o Mercury:

Mercury está disponível por meio dos principais provedores de nuvem, como AWS Bedrock e Azure Foundry. Também é acessível por meio de plataformas como OpenRouter e Quora. Você pode começar com a API.

Para explorar ajuste fino, implementações privadas e suporte de engenharia implantado, entre em contato com a Inception.

Mercury oferece uma abordagem transformadora à IA, tornando-a mais rápida, mais eficiente e mais acessível para uma ampla gama de aplicações. Experimente a API Mercury hoje mesmo e experimente a próxima geração de IA.

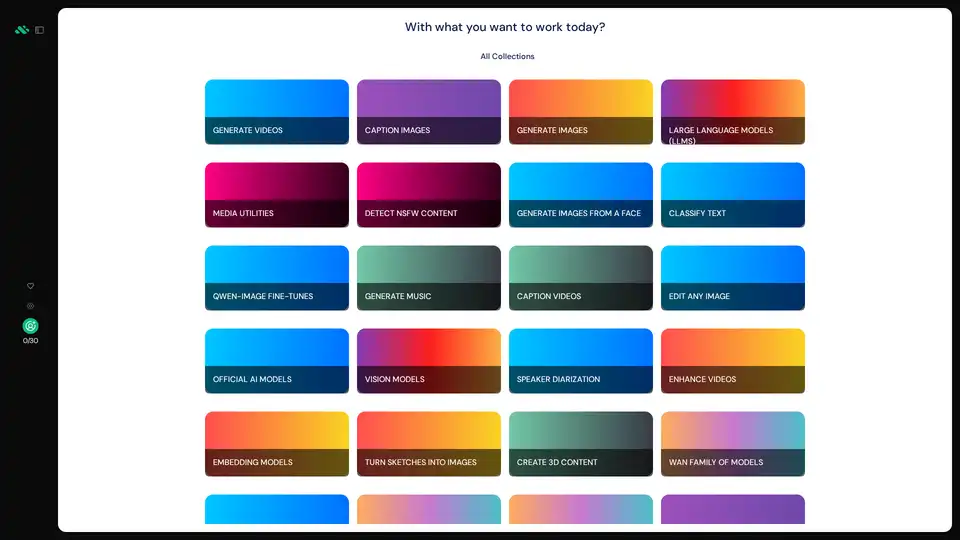

Melhores ferramentas alternativas para "Mercury"

AIverse é uma plataforma tudo-em-um que concede acesso a milhares de modelos de IA para geração de imagens/vídeos, LLMs, fala para texto, criação de música e mais. Uso ilimitado por US$ 20/mês.

Nuanced capacita ferramentas de codificação AI como Cursor e Claude Code com análise estática e grafos de chamadas TypeScript precisos, reduzindo o gasto de tokens em 33% e aumentando o sucesso de builds para geração de código eficiente e precisa.

JudgeAI é o primeiro sistema de arbitragem IA independente do mundo, oferecendo resoluções imparciais para disputas econômicas usando algoritmos legais avançados e IA multimodal para análise de evidências.

MotionAgent é uma ferramenta de IA open-source que transforma ideias em filmes em movimento, gerando roteiros, imagens estáticas de cinema, vídeos de alta resolução e música de fundo personalizada com modelos como Qwen-7B-Chat e SDXL.

Lilac permite que profissionais de dados e IA melhorem seus produtos, aprimorando seus dados.

Falcon LLM é uma família de modelos de linguagem grandes generativos de código aberto da TII, com modelos como Falcon 3, Falcon-H1 e Falcon Arabic para aplicações de IA multilíngues e multimodais que rodam eficientemente em dispositivos do dia a dia.

Private LLM é um chatbot de IA local para iOS e macOS que funciona offline, mantendo suas informações completamente no dispositivo, seguras e privadas. Desfrute de bate-papo sem censura no seu iPhone, iPad e Mac.

ModelFusion: Kit de ferramentas LLM completo para 2025 com calculadoras de custos, biblioteca de prompts e ferramentas de observabilidade de IA para GPT-4, Claude e muito mais.

xMem turbina aplicativos LLM com memória híbrida, combinando conhecimento de longo prazo e contexto em tempo real para uma IA mais inteligente.

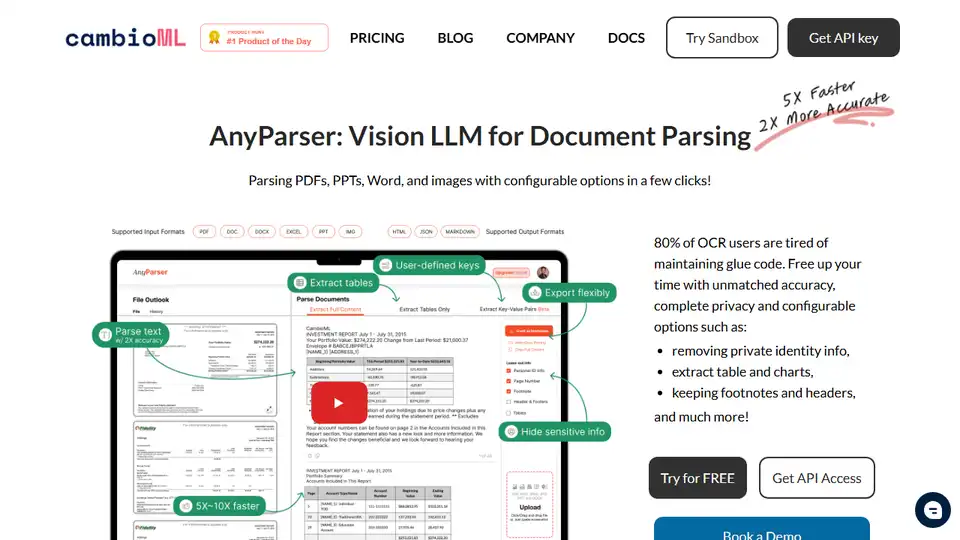

AnyParser: Visão LLM para análise de documentos. Extrai com precisão texto, tabelas, gráficos e layout de PDFs, PPTs e imagens. Prioriza a privacidade e a integração empresarial.

APIPark é um gateway LLM de código aberto e um portal para desenvolvedores de API para gerenciar LLMs em produção, garantindo estabilidade e segurança. Otimize os custos de LLM e construa seu próprio portal de API.

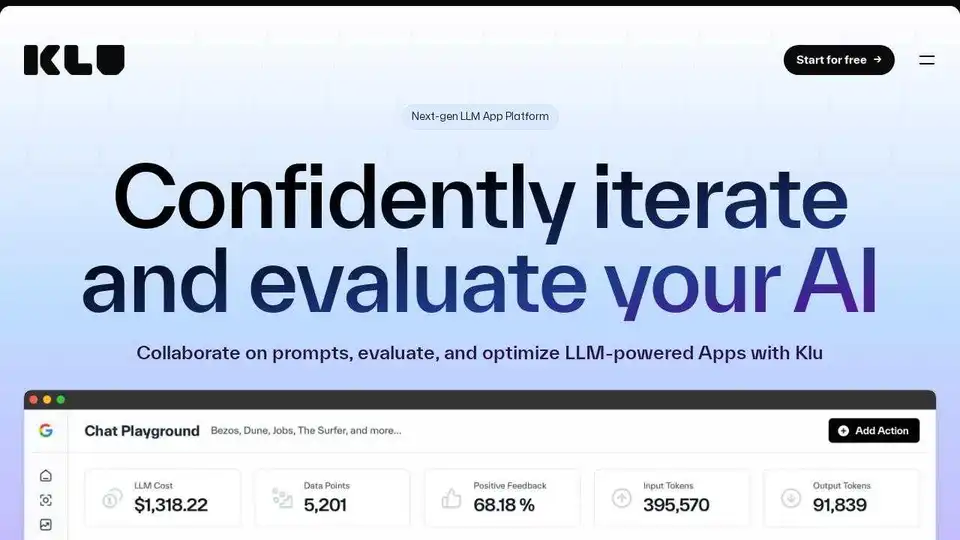

Klu é uma plataforma de aplicativos LLM de última geração projetada para ajudar as equipes a iterar, avaliar e otimizar com confiança aplicativos baseados em LLM. Colabore em prompts, rastreie alterações e itere rapidamente com insights.

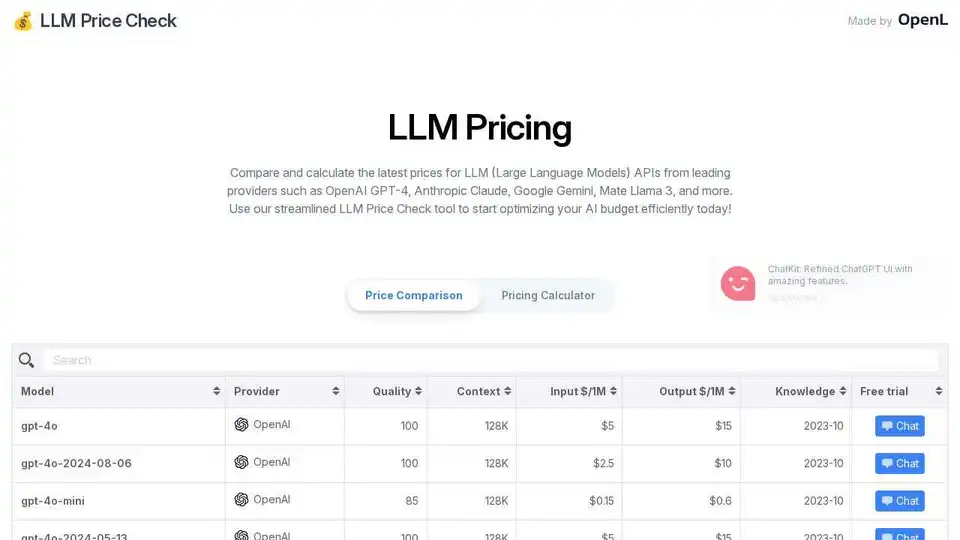

Compare os preços da API LLM da OpenAI, Anthropic, Google e muito mais. Otimize seu orçamento de IA com a calculadora de preços simplificada do LLM Price Check.

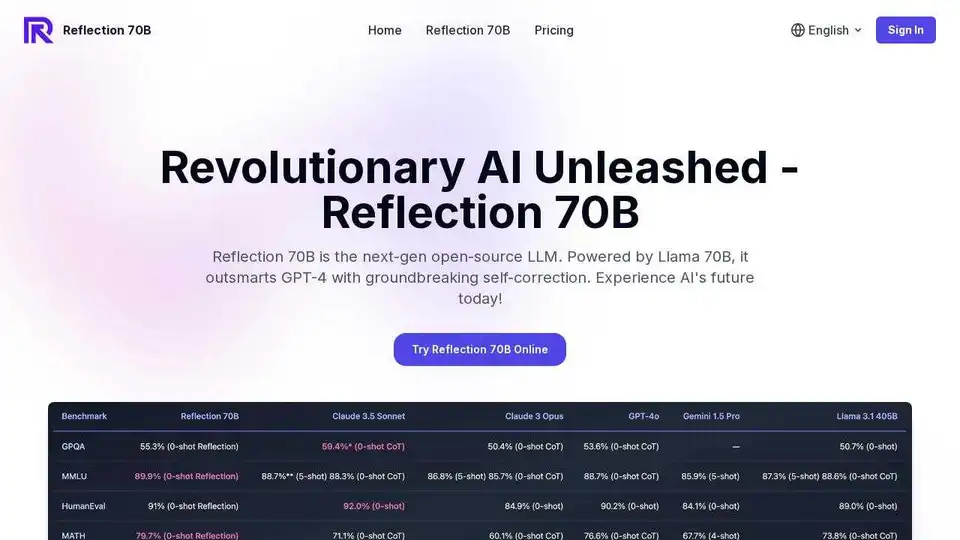

Experimente o Reflection 70B online, um LLM de código aberto baseado no Llama 70B. Supera o GPT-4 com autocorreção inovadora. Teste gratuito online disponível.