Reflection 70B 概述

Reflection 70B:世界领先的开源 AI 模型

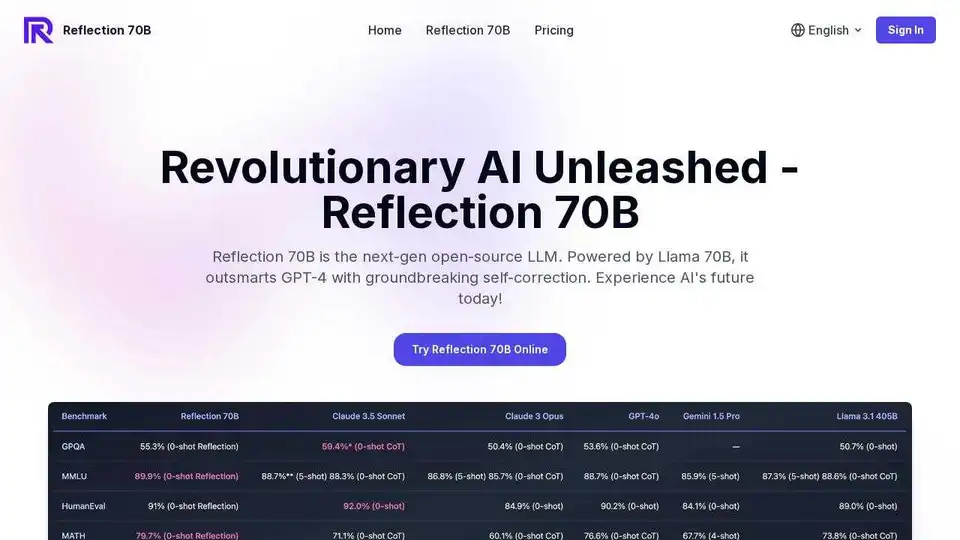

什么是 Reflection 70B?Reflection 70B 是一款突破性的开源大型语言模型 (LLM),它利用了一种名为 Reflection-Tuning 的新型训练技术。这种方法使模型能够实时检测和纠正自身推理错误,从而产生更准确和可靠的输出。

主要特点和优势:

- Reflection-Tuning: 采用独特的训练方法,使模型能够动态地识别和纠正推理错误。

- 顶级性能: 在各种基准测试中优于其他开源 LLM,展示了卓越的推理和语言理解能力。 这种卓越的性能使其成为 AI 研究人员和开发人员的首选。

- 实时推理: 通过清晰的思考、反思和输出阶段,提供模型思维过程的透明视图。 这使得用户能够理解模型如何得出结论。

- 多功能应用: 非常适合各种任务,包括复杂推理、问答和创意写作。 企业可以利用 Reflection 70B 实现各种用例,从客户服务到内容创建。

- 易于集成: 设计为与现有的 Llama 模型管道和聊天格式兼容,确保无缝集成到现有项目中。

- 开源: 可免费用于个人和商业项目,鼓励透明和协作的 AI 开发。

Reflection 70B 如何工作?

Reflection 70B 利用 Reflection-Tuning 技术。 Reflection-Tuning 如何工作? 这种技术教会模型批判性地评估自身的推理过程并识别错误。 通过反思自身的错误,模型学会纠正它们,从而产生更可靠和准确的输出。 这种能力使 Reflection 70B 与其他开源 LLM 区分开来。

常见问题

以下是一些关于 Reflection 70B 及其功能的最常见问题:

- 什么是 Reflection 70B? Reflection 70B 是世界领先的开源大型语言模型 (LLM),使用一种名为 Reflection-Tuning 的新型技术进行训练。 它可以检测和纠正推理过程中的错误。

- Reflection-Tuning 如何工作? Reflection-Tuning 教会模型识别推理中的错误并纠正它们,从而产生更准确和可靠的输出。

- 是什么让 Reflection 70B 与众不同? Reflection 70B 因其反思自身推理的能力、在基准测试中的卓越性能以及其开源性质而脱颖而出。

- 如何使用 Reflection 70B? 您可以通过我们的聊天界面使用 Reflection 70B,或者使用标准的 Llama 模型管道和聊天格式将其集成到您的项目中。

- Reflection 70B 可以免费使用吗? 是的,Reflection 70B 是开源的,可以免费用于个人和商业目的。

- Reflection 70B 可以处理哪些类型的任务? Reflection 70B 擅长复杂推理、问答、创意写作和各种其他自然语言处理任务。

- 我可以在移动设备上使用 Reflection 70B 吗? 是的,Reflection 70B 旨在在所有设备(包括智能手机和平板电脑)上实现完全响应和功能正常。

- Reflection 70B 是否存储任何个人数据? 不,Reflection 70B 不存储任何个人数据或用户输入的内容,从而确保隐私和安全。

- 在哪里可以找到有关 Reflection 70B 的更多信息? 您可以在我们的网站上或访问专门介绍 AI 技术的信誉良好的教育网站上找到有关 Reflection 70B 的更多信息。

- 我可以将 Reflection 70B 集成到我自己的项目中吗? 是的,欢迎开发人员将 Reflection 70B 集成到他们的项目中。 如需 API 访问和详细信息,请访问我们的开发者部分。

结论

Reflection 70B 代表了开源 AI 模型的重大进步,为用户提供了用于复杂推理、语言理解和创造性任务的强大工具。 其独特的 Reflection-Tuning 功能,加上其易于集成和免费可用性,使其成为 AI 开发人员、研究人员和企业的宝贵资源。 探索 Reflection 70B,释放您的 AI 项目中实时推理的潜力。

"Reflection 70B"的最佳替代工具

在线体验 Reflection 70B,一款基于 Llama 70B 的开源 LLM。凭借创新的自我修正功能,性能优于 GPT-4。提供在线免费试用。

Private LLM 是一款适用于 iOS 和 macOS 的本地 AI 聊天机器人,可离线工作,让您的信息完全在设备上、安全且私密。 在 iPhone、iPad 和 Mac 上享受无审查的聊天。

Nebius 是一个旨在普及 AI 基础设施的 AI 云平台,提供灵活的架构、经过测试的性能和长期价值,配备 NVIDIA GPU 和优化的集群,用于训练和推理。

Avian API为开源LLM提供最快的AI推理,在DeepSeek R1上实现351 TPS。使用兼容OpenAI的API以3-10倍的速度部署任何HuggingFace LLM。企业级性能和隐私。

PremAI是一个应用AI研究实验室,提供安全、个性化的AI模型,使用TrustML™的加密推理,以及像LocalAI这样可在本地运行LLM的开源工具。

Fireworks AI 使用最先进的开源模型为生成式人工智能提供极快的推理。 免费微调和部署您自己的模型。 在全球范围内扩展 AI 工作负载。

Nebius AI Studio Inference Service 提供托管开源模型,实现比专有 API 更快、更便宜、更准确的推理结果。无需 MLOps,即可无缝扩展,适用于 RAG 和生产工作负载。

Falcon LLM 是 TII 的开源生成式大语言模型家族,包括 Falcon 3、Falcon-H1 和 Falcon Arabic 等,支持多语言、多模态 AI 应用,可在日常设备上高效运行。

smolagents 是一个简约的 Python 库,用于创建通过代码推理和行动的 AI 代理。它支持模型无关的 LLM、安全沙箱以及与 Hugging Face Hub 的无缝集成,实现高效的基于代码的代理工作流。

Sagify 是一个开源 Python 工具,可简化 AWS SageMaker 上的机器学习管道,提供统一的 LLM 网关,实现专有和开源大型语言模型的无缝集成,提高生产力。

Atla AI 的 Selene 为您的 AI 应用性能提供精确的判断。探索开源 LLM Judge 模型,以获得行业领先的准确性和可靠的 AI 评估。

Xander是一个开源桌面平台,支持无代码AI模型训练。只需用自然语言描述任务,即可自动化文本分类、图像分析和LLM微调流程,在本地机器上确保隐私和性能。