Nebius 概述

Nebius: AI创新者的终极云平台

Nebius 旨在成为 AI 创新者的终极云平台,致力于普及 AI 基础设施并赋能全球开发者。它提供了一套全面的资源和服务,以支持 AI 开发生命周期的每个阶段。

什么是 Nebius?

Nebius 是一个专门为要求严苛的 AI 工作负载而设计的云平台。它集成了 NVIDIA GPU 加速器与预配置的驱动程序、高性能 InfiniBand 和 Kubernetes 或 Slurm 等编排工具。这种组合确保了 AI 模型训练和任意规模的推理的峰值效率。

主要特性和优势:

- 灵活的架构: 将 AI 工作负载从单个 GPU 无缝扩展到具有数千个 NVIDIA GPU 的预优化集群。

- 经过测试的性能: 专为要求严苛的 AI 工作负载而设计,确保峰值效率。

- 长期价值: 优化堆栈的每一层,以实现无与伦比的效率和巨大的客户价值。

- 最新的 NVIDIA GPU: 访问 NVIDIA GB200 NVL72、HGX B200、H200、H100 和 L40S GPU,这些 GPU 通过 InfiniBand 网络连接,每个主机的速度高达 3.2Tbit/s。

- 托管服务: 可靠地部署 MLflow、PostgreSQL 和 Apache Spark,无需任何维护工作。

- 云原生体验: 使用 Terraform、API 和 CLI 将基础设施作为代码进行管理,或者使用直观的控制台。

- 专家支持: 24/7 专家支持和解决方案架构师的专门协助。

Nebius 如何工作?

Nebius 优化 AI 堆栈的每一层,以提供高性能环境。这包括:

- NVIDIA GPU 集成: 利用带有预配置驱动程序的 NVIDIA GPU 加速器。

- 高性能网络: 采用 InfiniBand 技术以确保快速数据传输。

- 编排工具: 利用 Kubernetes 和 Slurm 实现高效的资源管理。

为什么选择 Nebius?

Nebius 相比竞争对手具有以下几个优势:

- 成本节省: 通过承诺至少 3 个月订购数百个 NVIDIA GPU,从而提高成本节省。

- 可扩展性: 能够从单个 GPU 扩展到集群中的数千个 GPU。

- 可靠性: 完全托管的服务确保关键工具和框架的可靠部署。

Nebius 适合谁?

Nebius 非常适合:

- AI 研究人员和开发人员

- 机器学习工程师

- 数据科学家

- 需要可扩展 AI 基础设施的组织

实际应用和用例:

Nebius 在加速各个领域的 AI 创新方面发挥了重要作用:

- CRISPR-GPT(基因编辑): 实现了快速的模型筛选和微调,将基因编辑转变为自动化工作流程。

- Shopify(电子商务): 提供大规模 GPU 集群用于 AI 模型开发,从而增强产品搜索和结账流程。

- vLLM(开源 LLM 推理): 优化了基于 Transformer 的模型的推理性能,具有高吞吐量和无缝的可扩展性。

- Brave Software(网络搜索): 提供用于搜索查询的实时 AI 摘要,同时保持隐私标准。

- CentML Platform(AI 部署): 优化推理平台,提供灵活的扩展和增强的硬件利用率。

- TheStage AI(Stable Diffusion): 通过 DNN 优化工具降低 GPU 成本。

- Recraft(AI 设计工具): 从头开始训练了第一个用于设计师的生成式 AI 模型。

- Wubble(音乐创作): 通过高质量、免版税的音乐生成简化了音乐创作。

- Simulacra AI(量子化学): 为分子动力学模型生成高精度数据集。

- Quantori(药物发现): 开发了一种 AI 框架,用于生成具有精确 3D 形状的分子。

Nebius AI Cloud 与 Nebius AI Studio

Nebius 提供两种主要产品:

- AI Cloud: 提供对 AI 基础设施的自助服务访问。

- AI Studio: 为 AI 开发提供托管环境。

定价

Nebius 为 NVIDIA GPU 提供具有竞争力的价格,包括:

- NVIDIA B200 GPU

- NVIDIA H200 GPU

- NVIDIA H100 GPU

结论

Nebius 是一款强大、灵活且经济高效的云平台,旨在加速 AI 创新。通过提供对尖端 NVIDIA GPU、优化基础设施和专家支持的访问,Nebius 使 AI 构建者能够在各个行业取得卓越成果。

"Nebius"的最佳替代工具

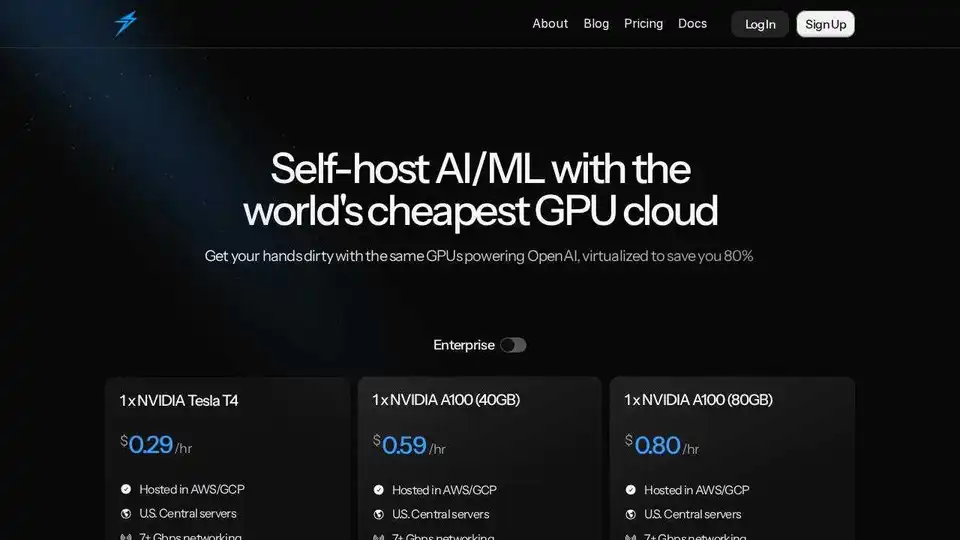

Thunder Compute是一个面向AI/ML的GPU云平台,在VSCode中提供一键式GPU实例,价格比竞争对手低80%。非常适合研究人员、初创公司和数据科学家。

Deep Infra 是一个低成本、可扩展的 AI 推理平台,支持 100 多个 ML 模型,如 DeepSeek-V3.2、Qwen 和 OCR 工具。提供开发者友好 API、GPU 租赁、零数据保留和美国安全基础设施,用于生产 AI 工作负载。

Cirrascale AI创新云加速AI开发、训练和推理工作负载。在高吞吐量和低延迟下,测试和部署在领先的AI加速器上。

Lumino 是一个易于使用的 SDK,用于在全球云平台上进行 AI 训练。 降低高达 80% 的 ML 训练成本,并访问其他地方无法使用的 GPU。 立即开始训练您的 AI 模型!

Phala Cloud 提供了一个无信任的开源云基础设施,用于部署 AI 代理和 Web3 应用程序,由 TEE 提供支持。 它确保隐私、可扩展性,并由代码管理。

Metaflow是由 Netflix 开源的框架,用于构建和管理真实的 ML、AI 和数据科学项目。轻松扩展工作流程、跟踪实验并部署到生产环境。

Massed Compute 提供用于 AI、机器学习和数据分析的按需 GPU 和 CPU 云计算基础设施。以灵活且经济实惠的计划访问高性能 NVIDIA GPU。

Deployo 简化了 AI 模型部署,可在几分钟内将模型转化为可用于生产的应用程序。与云无关、安全且可扩展的 AI 基础设施,可实现轻松的机器学习工作流程。