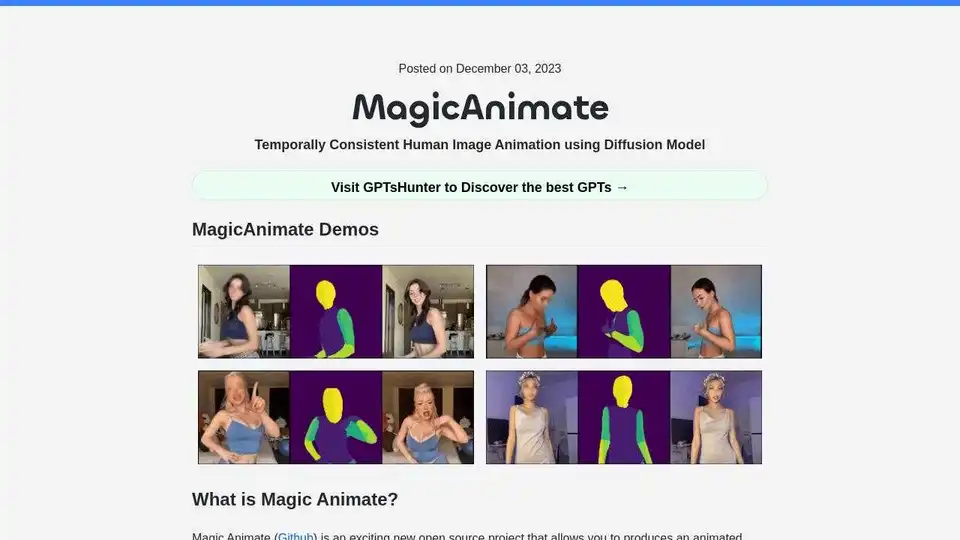

MagicAnimate 概述

MagicAnimate:使用扩散模型实现时间一致的人体图像动画

MagicAnimate 是一个开源项目,它使用基于扩散的框架从单个图像和运动视频生成动画视频。它专注于保持时间一致性,并在增强动画逼真度的同时保留参考图像。该工具由新加坡国立大学 Show Lab 和字节跳动开发。

什么是 MagicAnimate?

MagicAnimate 擅长使用来自各种来源的运动序列来动画参考图像,包括跨 ID 动画和未见过的领域,如油画和电影角色。它与 DALLE3 等文本到图像扩散模型集成,通过动态动作将文本提示的图像变为现实。

主要特性和优势:

- 时间一致性: 在整个动画过程中保持一致性。

- 参考图像保留: 忠实地保留参考图像的细节。

- 增强的动画逼真度: 提高动画的质量和真实感。

- 多功能的运动源: 支持来自各种来源的运动序列,包括未见过的领域。

- 与 T2I 模型集成: 与 DALLE3 等文本到图像扩散模型兼容。

缺点:

- 面部和手部的一些扭曲。

- 面部风格从动漫到现实主义的转变。

- 将动漫风格应用于真实人物视频时,身体比例会发生变化。

MagicAnimate 入门:

- 先决条件: 确保您已安装 Python >= 3.8、CUDA >= 11.3 和 FFmpeg。

- 安装:

conda env create -f environment.yml conda activate manimate

如何使用 MagicAnimate:

在线演示: 在 Hugging Face 或 Replicate 上尝试 MagicAnimate 在线演示。

Colab: 使用本教程在 Google Colab 上运行 MagicAnimate:如何在 Colab 上运行 MagicAnimate。

Replicate API: 使用 Replicate API 生成动画视频。

import Replicate from "replicate"; const replicate = new Replicate({ auth: process.env.REPLICATE_API_TOKEN, }); const output = await replicate.run( "lucataco/magic-animate:e24ad72cc67dd2a365b5b909aca70371bba62b685019f4e96317e59d4ace6714", { input: { image: "https://example.com/image.png", video: "Input motion video", num_inference_steps: 25, // Number of denoising steps guidance_scale: 7.5, // Scale for classifier-free guidance seed: 349324 // Random seed. Leave blank to randomize the seed } } );

如何生成运动视频:

- 使用 OpenPose(一个实时多人关键点检测库)将视频转换为运动视频。

- 使用此模型将运动视频转换为 OpenPose:视频转 OpenPose。

- 将 magic-animate-openpose 模型与 OpenPose 一起使用。

附加资源:

MagicAnimate 的主要功能是什么?

MagicAnimate 的主要功能是从单个参考图像和运动视频生成动画视频,确保时间一致性和高保真度。

MagicAnimate 如何工作?

MagicAnimate 使用基于扩散的框架来分析输入视频中的运动,并将其应用于参考图像,从而生成一个新视频,该视频模仿该运动,同时保留参考图像的视觉特征。

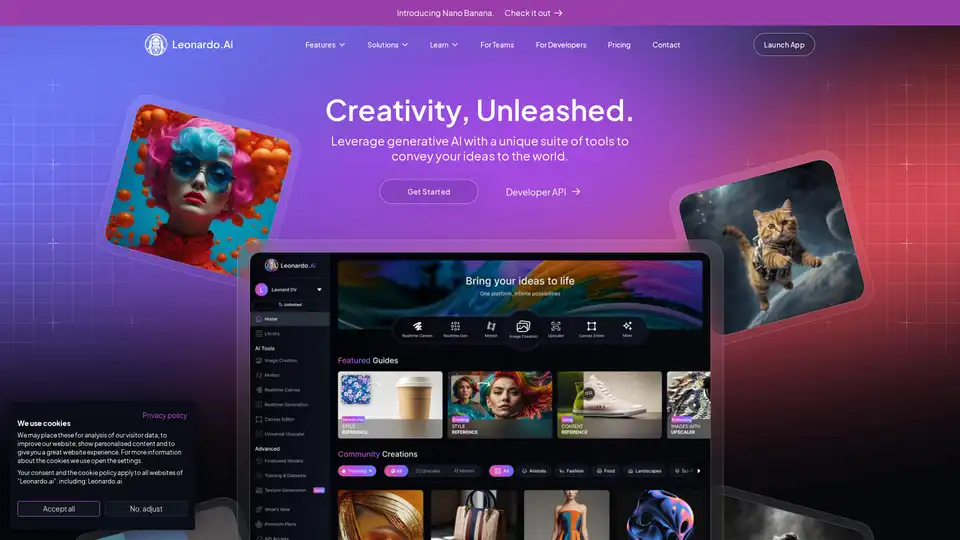

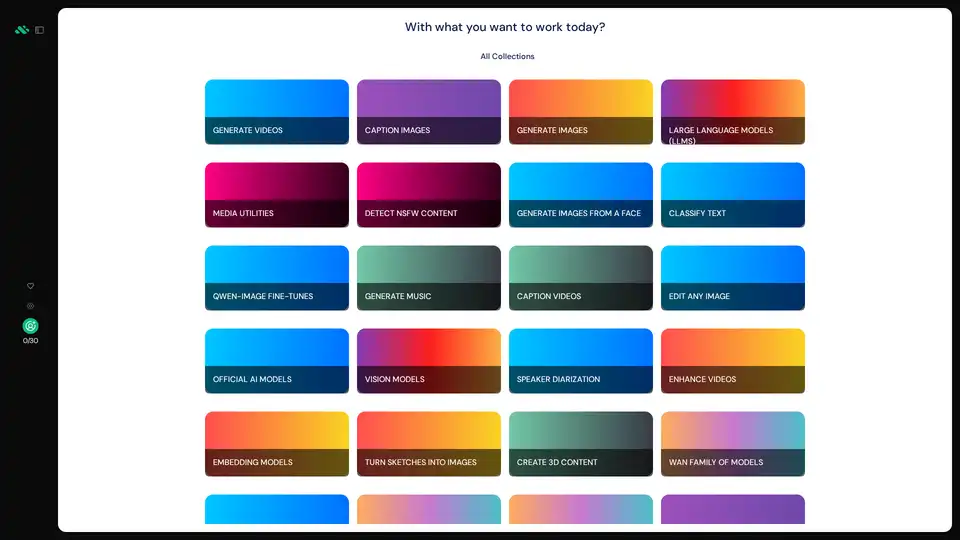

"MagicAnimate"的最佳替代工具

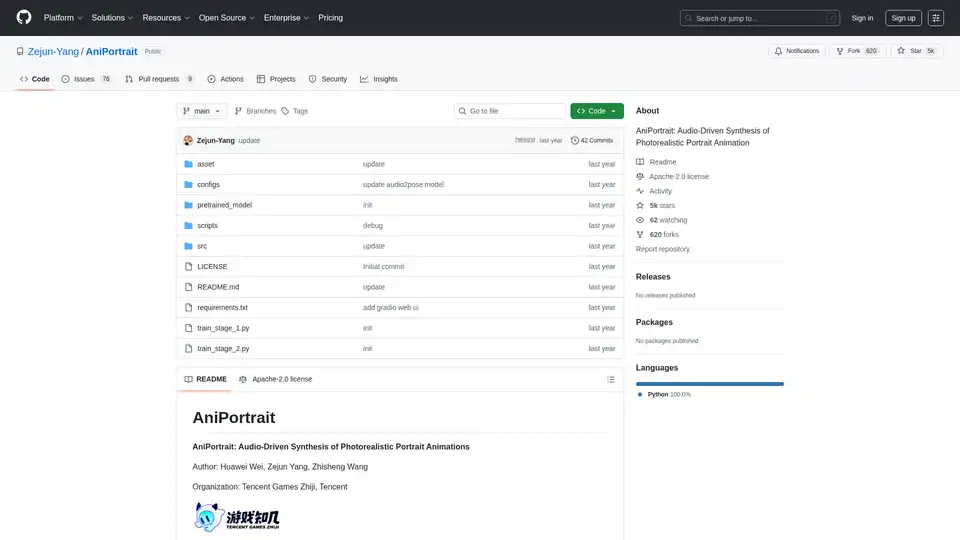

AniPortrait是一个开源AI框架,用于生成由音频或视频输入驱动的逼真肖像动画。它支持自驱动、面部重演和音频驱动模式,实现高质量视频合成。

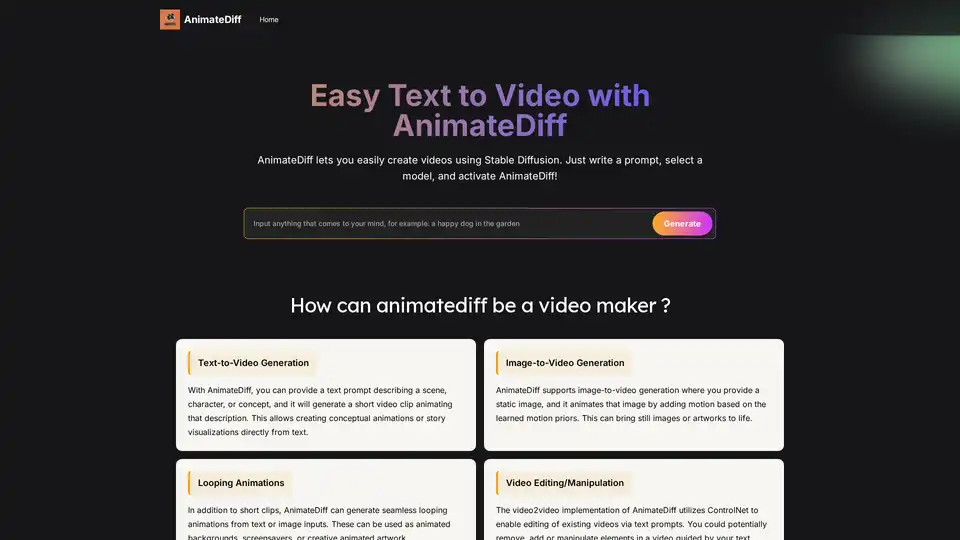

AnimateDiff 是一个免费的在线视频制作工具,能为 AI 生成的视觉内容注入动态。使用文本提示创建动画,或为现有图像添加从真实视频中学到的自然运动。这个即插即用框架为 Stable Diffusion 等扩散模型添加视频功能,而无需重新训练。探索 AnimateDiff 的文本转视频和图像转视频生成工具,开启 AI 内容创作的未来。

Lumiere是谷歌研究公司开发的一种用于视频生成的时空扩散模型。它支持文本到视频、图像到视频、视频风格化、电影图和修复,从而生成逼真且连贯的运动。

使用Media.io的AI视频生成器,在几秒钟内将您的想法转化为视频。只需输入文本或上传图像,即可创建令人惊叹的无水印视频——100%免费。

Ray3 是全球首款具备 HDR 生成和智能推理的 AI 视频模型。将文本转化为惊艳的 4K HDR 视频,使用草稿模式、高保真扩散、配音和字幕。适合创作者、企业和专业人士。

Hypergro 是一款 AI 创意伙伴,可在几分钟内将想法转化为高性能图像和视频广告,支持 Meta、YouTube 和 Instagram。适合寻求节省时间、成本效益广告创建的营销人员,提供易自定义和多语言支持。