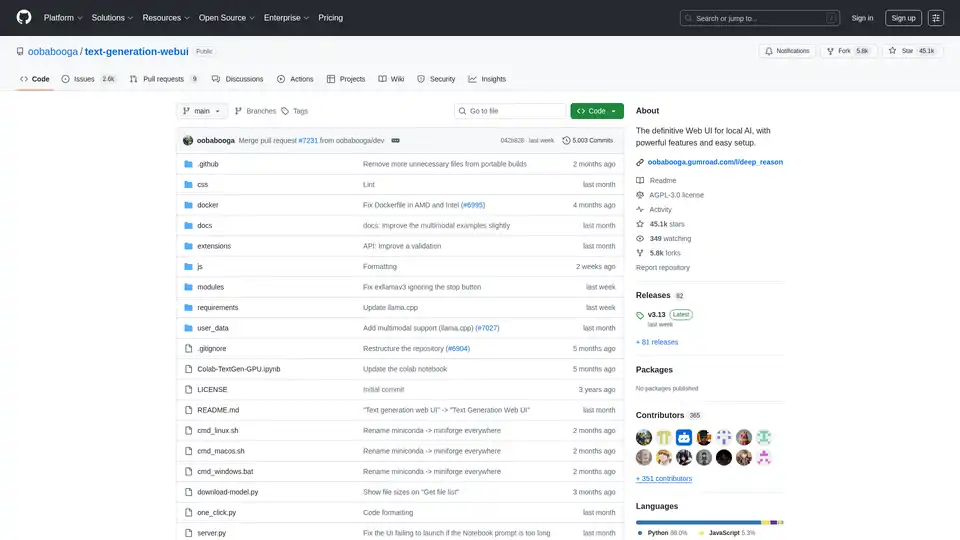

Text Generation Web UI 概述

Text Generation Web UI: 本地 AI 的终极 Web 界面

什么是 Text Generation Web UI?

Text Generation Web UI,也称为 oobabooga/text-generation-webui,是一个用户友好且功能丰富的 Gradio Web 界面,专为与本地大型语言模型 (LLM) 交互而设计。 它提供了一套全面的工具和功能,可以在您自己的机器上利用 AI 文本生成的能力,确保隐私和控制。

Text Generation Web UI 是如何工作的?

此 Web UI 充当您和各种本地文本生成后端之间的桥梁。 它支持多个后端,如 llama.cpp、Transformers、ExLlamaV3、ExLlamaV2 和 TensorRT-LLM。 该 UI 允许您:

- 选择您喜欢的后端: 选择适合您的硬件和模型要求的后端。

- 加载和管理模型: 轻松加载不同的 LLM 并在它们之间切换,而无需重新启动应用程序。

- 配置生成参数: 使用各种采样参数和生成选项微调文本生成过程。

- 与模型交互: 使用直观的聊天界面或自由形式的笔记本选项卡与模型交互。

为什么选择 Text Generation Web UI?

- 隐私: 所有处理都在本地完成,确保您的数据保持私密。

- 离线功能: 无需互联网连接,您可以随时随地使用该工具。

- 多功能性: 支持多个后端和模型类型,提供灵活性和定制。

- 可扩展性: 提供扩展支持以添加新功能。

- 易于使用: 用户友好的界面,具有黑暗和浅色主题、语法突出显示和 LaTeX 渲染。

主要特点:

- 多后端支持: 与

llama.cpp、Transformers、ExLlamaV3、ExLlamaV2和TensorRT-LLM无缝集成。 - 易于设置: 为 Windows/Linux/macOS 提供便携式版本,无需任何设置,以及用于独立环境的一键安装程序。

- 离线和私密: 100% 离线运行,没有遥测、外部资源或远程更新请求。

- 文件附件: 允许上传文本文件、PDF 文档和 .docx 文件,以便与 AI 讨论其内容。

- 视觉(多模态模型): 支持将图像附加到消息以进行视觉理解(教程)。

- 网络搜索: 可以选择使用 LLM 生成的查询搜索互联网,以向对话添加上下文。

- 美观的 UI: 具有干净且吸引人的用户界面,带有黑暗和浅色主题。

- 语法突出显示和 LaTeX 渲染: 为代码块提供语法突出显示,为数学表达式提供 LaTeX 渲染。

- 指令和聊天模式: 包括用于指令跟随的指令模式和用于与自定义角色交互的聊天模式。

- 自动提示格式: 使用 Jinja2 模板进行自动提示格式化。

- 消息编辑和对话分支: 允许编辑消息、在版本之间导航和分支对话。

- 多个采样参数: 通过各种采样参数和生成选项,提供对文本生成的复杂控制。

- 模型切换: 允许在 UI 中切换不同的模型,而无需重新启动。

- 自动 GPU 层: 自动为 NVIDIA GPU 上的 GGUF 模型配置 GPU 层。

- 自由形式文本生成: 提供一个笔记本选项卡,用于自由形式的文本生成,没有聊天轮次限制。

- OpenAI 兼容 API: 包括一个与 OpenAI 兼容的 API,具有聊天和完成端点,包括工具调用支持。

- 扩展支持: 支持众多内置和用户贡献的扩展。

如何安装 Text Generation Web UI:

- 便携式版本(推荐快速启动):

- 从 发布页面 下载便携式版本。

- 解压缩下载的文件。

- 运行可执行文件。

- 使用 venv 手动便携式安装:

git clone https://github.com/oobabooga/text-generation-webui cd text-generation-webui python -m venv venv # On Windows: venv\Scripts\activate # On macOS/Linux: source venv/bin/activate pip install -r requirements/portable/requirements.txt --upgrade python server.py --portable --api --auto-launch deactivate - 一键安装程序(适用于高级用户):

- 克隆存储库或下载源代码。

- 运行适用于您的操作系统的启动脚本(start_windows.bat、start_linux.sh 或 start_macos.sh)。

- 出现提示时选择您的 GPU 供应商。

- 安装后,在浏览器中打开

http://127.0.0.1:7860。

下载模型:

模型应放置在 text-generation-webui/user_data/models 文件夹中。 GGUF 模型应直接放置在此文件夹中,而其他模型类型应放置在子文件夹中。

示例:

text-generation-webui

└── user_data

└── models

└── llama-2-13b-chat.Q4_K_M.gguf

text-generation-webui

└── user_data

└── models

└── lmsys_vicuna-33b-v1.3

├── config.json

├── generation_config.json

├── pytorch_model-00001-of-00007.bin

...

您还可以使用 UI 从 Hugging Face 自动下载模型,或使用命令行工具:

python download-model.py organization/model

运行 python download-model.py --help 查看所有选项。

Text Generation Web UI 适合谁?

Text Generation Web UI 非常适合:

- 与 LLM 合作的研究人员和开发人员。

- 想要尝试文本生成的 AI 爱好者。

- 优先考虑隐私并希望在本地运行 LLM 的用户。

实用资源:

Text Generation Web UI 提供了一个强大而通用的平台,用于探索本地 AI 文本生成的功能。 它的易用性、广泛的功能以及对隐私的承诺使其成为任何有兴趣按照自己的方式使用大型语言模型的人的绝佳选择。

"Text Generation Web UI"的最佳替代工具

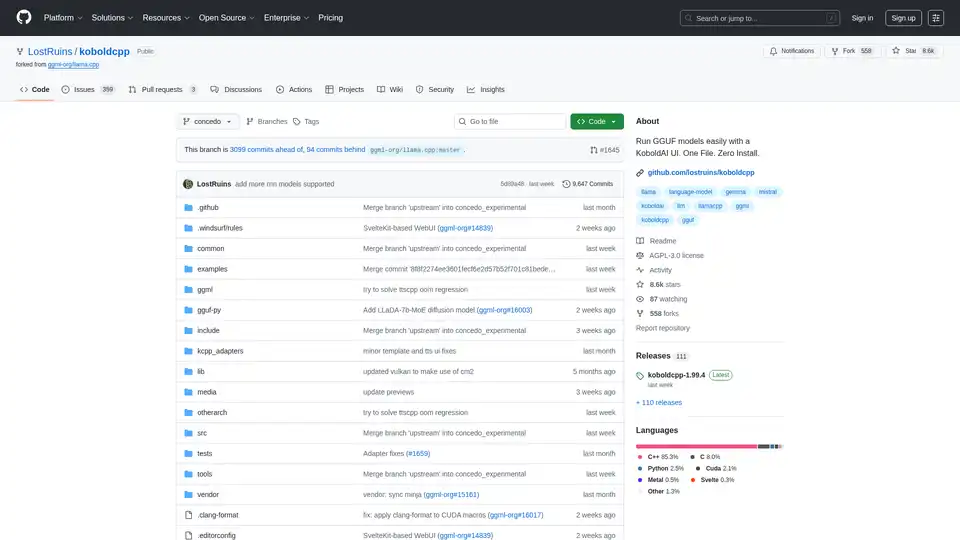

KoboldCpp:使用 KoboldAI UI 轻松运行 GGUF 模型,进行 AI 文本和图像生成。单文件,零安装。支持 CPU/GPU、语音转文本、文本转语音和 Stable Diffusion。

AI Runner是一个离线AI推理引擎,用于艺术创作、实时语音对话、LLM驱动的聊天机器人和自动化工作流程。在本地运行图像生成、语音聊天等!

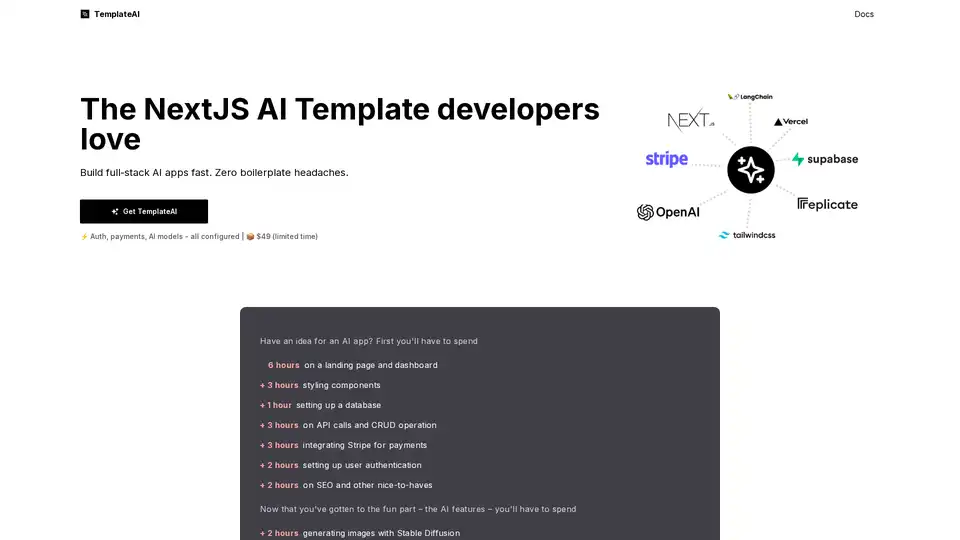

TemplateAI 是领先的 NextJS AI 应用模板,配备 Supabase 认证、Stripe 支付、OpenAI/Claude 集成,以及即用型 AI 组件,用于快速全栈开发。

OpenUI 是一个开源工具,让您用自然语言描述 UI 组件,并使用大语言模型实时渲染。将描述转换为 HTML、React 或 Svelte,实现快速原型设计。

ElevenLabs 的 AI 工程师包是每个开发者都需要的 AI 启动包。它提供对高级 AI 工具和服务的独家访问权限,如 ElevenLabs、Mistral 和 Perplexity。

TypingMind 是一款支持 GPT-4、Gemini、Claude 等 LLM 的 AI 聊天界面。 使用你的 API 密钥,只需为你使用的内容付费。适用于所有 AI 模型的最佳聊天 LLM 前端 UI。

发现Pal Chat,这是iOS的轻量级却强大的AI聊天客户端。访问GPT-4o、Claude 3.5等模型,完全隐私保护——不收集任何数据。在iPhone或iPad上生成图像、编辑提示,并享受无缝AI交互。

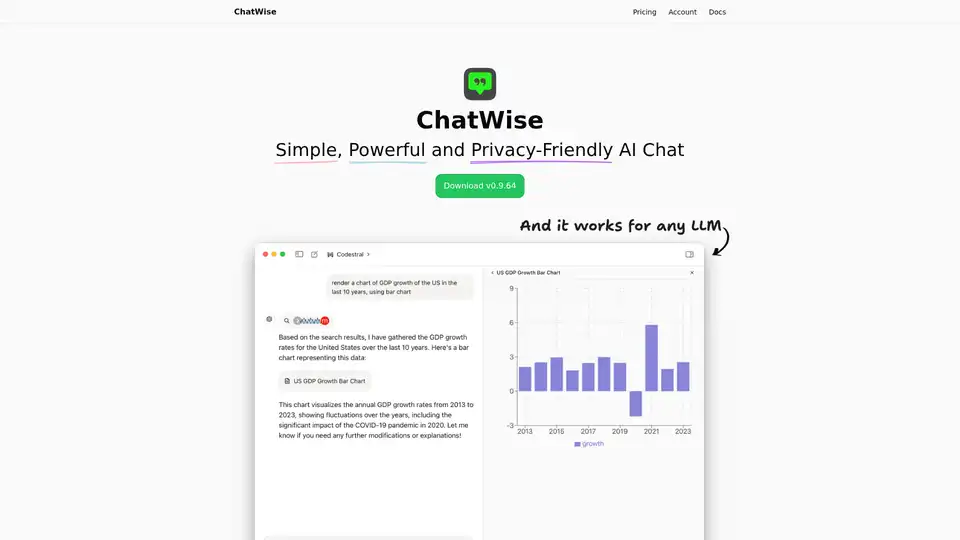

ChatWise 是一款高性能、注重隐私的桌面 AI 聊天机器人,支持 GPT-4、Claude、Gemini、Llama 等。功能包括本地数据存储、多模态聊天(音频、PDF、图像)、网络搜索、API 密钥集成和工件渲染,实现无缝生产力。

使用 Next.js, Groq, Llama-3 和 Langchain 构建一个 Perplexity 风格的 AI 问答引擎。高效获取来源、答案、图像和后续问题。

Agent TARS 是一个开源多模态 AI 代理,无缝集成浏览器操作、命令行和文件系统,实现增强的工作流自动化。体验先进的视觉解释和复杂的推理,以高效处理任务。

了解如何在 Google Colab 上使用 AUTOMATIC1111 的 Web UI 轻松运行 Stable Diffusion。安装模型、LoRA 和 ControlNet,实现快速 AI 图像生成,无需本地硬件。

探索Stable Diffusion,这是一个开源AI图像生成器,可从文本提示创建逼真图像。通过Stablediffusionai.ai访问或本地安装,用于艺术、设计和创意项目,具有高度自定义。

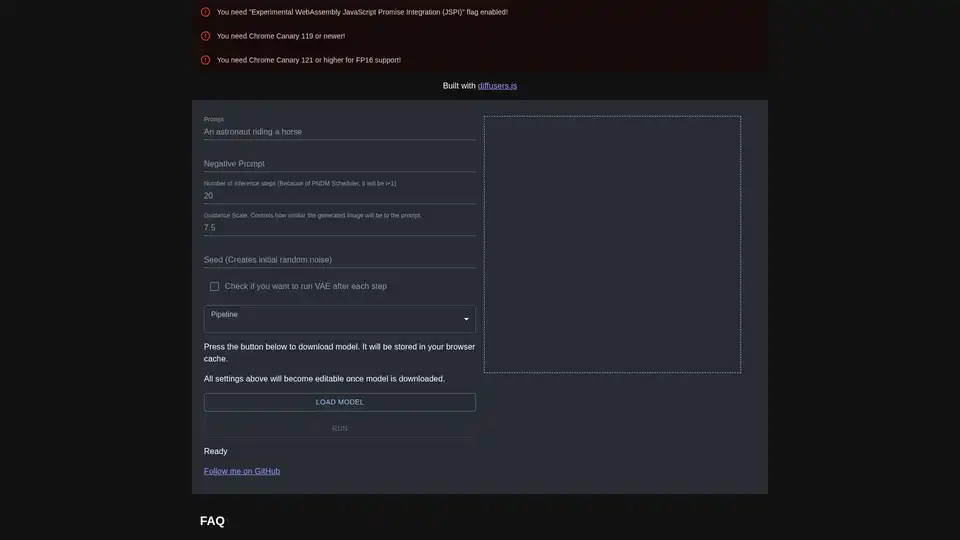

diffusers.js 是一个 JavaScript 库,通过 WebGPU 在浏览器中实现 Stable Diffusion AI 图像生成。下载模型,输入提示,并使用自定义设置如指导尺度与推理步骤,在 Chrome Canary 中直接创建惊艳视觉效果。