MCP Server Architektur und Funktionsweise: Vom Protokoll zum Ausführungsfluss

Während sich KI-Systeme weiterentwickeln, werden sie immer komplexer. Traditionelle API-Aufrufparadigmen (wie unabhängige HTTP-Anfragen und anbieterspezifische SDKs) stehen beim Aufbau hochentwickelter KI-Agenten-Systeme vor Herausforderungen wie geringer Entwicklungseffizienz, hohen Sicherheitsrisiken und schlechter Wartbarkeit. Zum Beispiel fehlen unabhängigen API-Definitionen ein einheitlicher Standard; verschiedene Modelle bieten unterschiedliche Spezifikationen für Funktionsaufrufe; und es mangelt an effizienten Mechanismen zur Fähigkeitserkennung und dynamischen Integration.

Das Model Context Protocol (MCP) entstand, um diese Probleme zu lösen. Durch Standardisierung auf Protokollebene führt es einen erweiterbaren, dienstübergreifenden Werkzeug- und Ressourcenaufrufmechanismus ein, der es KI-Agenten ermöglicht, robust mit externen Systemen zusammenzuarbeiten. Die Kern-Designphilosophie von MCP liegt in der Protokollabstraktion und der Trennung von Belangen (Separation of Concerns). Es schreibt keine spezifischen Implementierungen vor, sondern definiert eine universelle Sprache für die Interaktion zwischen KI-Anwendungen und externen Fähigkeiten.

Dieser Artikel bietet eine maßgebliche Erklärung der MCP Server Architektur, der Protokollprinzipien und des Ausführungsflusses. Er beleuchtet, warum eine Protokollebene einem SDK vorgezogen wird und wie MCP die skalierbaren Werkzeugaufrufe unterstützt, die moderne intelligente Systeme benötigen.

Zielgruppe:

- Technikbegeisterte und Einsteiger

- Fachleute und Manager, die Effizienzsteigerungen suchen

- Unternehmensentscheider und Abteilungsleiter

- Allgemeine Nutzer, die sich für zukünftige KI-Trends interessieren

Inhalt:

- 1. Kern-Designphilosophie des MCP-Protokolls

- 2. Kernkomponenten von MCP

- 3. MCP vs. traditionelle API-Integration: Architektur-Paradigmen

- 4. Wie MCP Server mit KI-Agenten zusammenarbeiten

- 5. Die drei Kern-Fähigkeitsprimitiva von MCP

- 6. Kommunikationsbeziehung: MCP Client, Server und LLM

- 7. Vollständiger MCP Server Aufrufprozess

- 8. MCP vs. traditionelle API / Funktionsaufruf: Unterschiede auf der Modell-Schnittstellenschicht

- 9. Einschränkungen und Herausforderungen von MCP

- Fazit

- MCP Häufig gestellte Fragen (FAQ)

1. Kern-Designphilosophie des MCP-Protokolls

MCP setzt auf Protokoll-Schicht-Abstraktion und bietet Kernvorteile wie Standardisierung, Sprachunabhängigkeit und starke Universalität, anstatt ein einheitliches SDK bereitzustellen. Dies bedeutet, dass jedes Programm, das die MCP-Protokollspezifikation implementiert – unabhängig von der verwendeten Programmiersprache oder dem Framework – mit anderen kommunizieren kann. Dieses Design maximiert die ökologische Offenheit und Interoperabilität. Die Kommunikation basiert auf JSON-RPC 2.0, einem leichtgewichtigen Remote Procedure Call (RPC)-Protokoll, dessen strukturierte Anfrage- und Antwortformate ideal für die automatisierte Maschine-zu-Maschine-Interaktion sind.

Kommunikationsnachrichtenformat

MCP nutzt JSON-RPC 2.0 als grundlegendes Nachrichtenformat und Kommunikationsstandard.

JSON-RPC ist ein zustandsloses, leichtgewichtiges Remote Procedure Call (RPC)-Protokoll. Es verwendet JSON als Datenformat und kann über verschiedene Transportschichten wie STDIO oder HTTP übertragen werden.

In MCP ist JSON-RPC verantwortlich für:

- Definieren von Anforderungs-/Antwortnachrichtenstrukturen;

- Standardisieren von Methodenaufrufen (z. B.

initialize,tools/list,tools/call); - Bereitstellen von erweiterbaren Fehler- und Stapelverarbeitungsmechanismen.

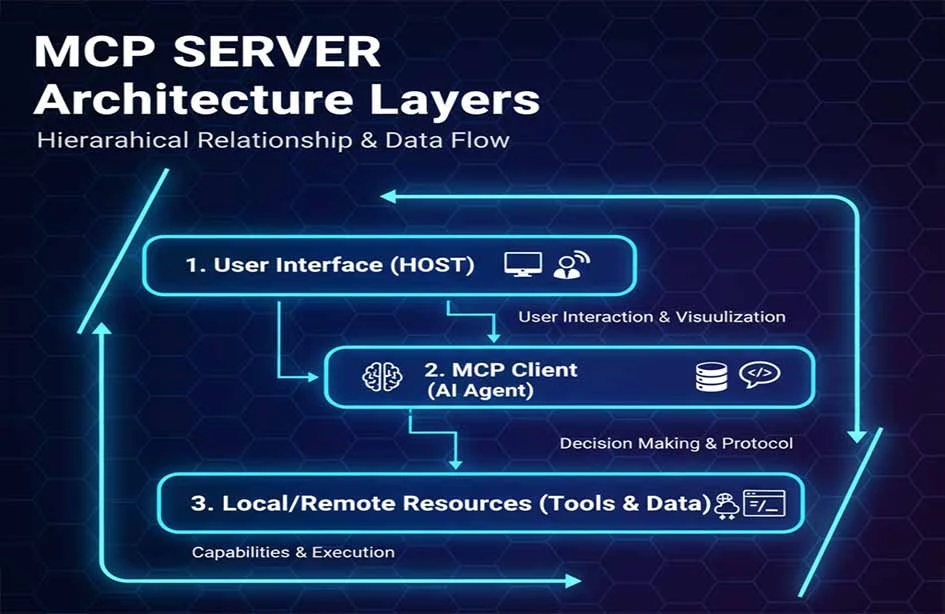

Dreischichtiges Architekturmodell

MCP verwendet ein dreischichtiges Architekturmodell: MCP Client, MCP Server und Ressource/Tool.

| MCP Hosts |

|---|

| MCP Clients |

| MCP Servers |

- MCP Hosts: Die LLM-Anwendung, die die Anfrage initiiert (z. B. Claude Desktop, eine IDE oder ein KI-Werkzeug).

- MCP Clients: Befinden sich innerhalb des Host-Programms und unterhalten eine 1:1-Verbindung mit dem MCP Server.

- MCP Servers: Stellen dem MCP Client Kontext-, Werkzeug- und Prompt-Informationen bereit.

Dieses geschichtete Design reduziert die Kopplung zwischen Modulen erheblich und verbessert die Skalierbarkeit des MCP Servers.

2. Kernkomponenten von MCP

Transportschicht Der MCP-Standardtransport umfasst STDIO und HTTP + Server-Sent Events (SSE), wobei SSE Streaming-Nachrichtenfähigkeiten vom Server zum Client bietet. MCP definiert derzeit zwei Standard-Transportmechanismen für die Client-Server-Kommunikation:

- STDIO: Sicherheit und Leistung zuerst. Der MCP Server startet als Kindprozess und läuft lokal mit der KI-Anwendung. Er nutzt lokale Interprozesskommunikation (IPC), bietet geringe Latenz und einfache Bereitstellung. Da die gesamte Kommunikation lokal bleibt, werden Netzwerkrisiken für Anmeldeinformationen und Daten vermieden. Dies ist die bevorzugte Methode zur Integration lokaler Funktionen in persönliche Produktivitätstools wie Claude Desktop.

- HTTP with Server-Sent Events (SSE): Zugänglichkeit und Skalierbarkeit zuerst. Der MCP Server wird als Netzwerkdienst bereitgestellt, der von mehreren Remote-Clients zugänglich ist. Er verwendet HTTP/POST in Kombination mit JSON-RPC zur Nachrichtenübertragung. Dies ist geeignet für gemeinsame Fähigkeits-Hubs innerhalb von Unternehmen oder SaaS-Diensten. HTTPS und Standard-HTTP-Authentifizierung bilden die Sicherheitsgrundlage.

Dieser Mechanismus ermöglicht es MCP, sowohl einfache Werkzeugaufrufe als auch große verteilte Server zu unterstützen. Die Wahl hängt vom Szenario ab: STDIO ist effizienter für die lokale Prozesskommunikation, während HTTP eine bessere Skalierbarkeit für entfernte Cluster-Bereitstellungen bietet.

Protokollschicht

Auf der Protokollschicht verwendet MCP die JSON-RPC 2.0 Spezifikation, um Standardmethoden zu definieren, wie zum Beispiel:

- Initialisieren von Verbindungen (

initialize); - Fähigkeitserkennung (

tools/list); - Werkzeugausführung (

tools/call).

Dieses Varianten-Design bewahrt die Kernprotokollstruktur von JSON-RPC und führt gleichzeitig MCP-spezifische Kommunikationssemantiken ein. JSON-RPC Tools

Sicherheit und Authentifizierung

MCP bietet keine Sicherheitsmechanismen direkt an. Das Sicherheitsdesign basiert auf der spezifischen MCP Server Implementierung unter Verwendung etablierter Lösungen, wie zum Beispiel:

- HTTPS/TLS verschlüsselte Übertragung;

- Authentifizierung über OAuth2, API Keys oder mTLS;

- Berechtigungssteuerung nach dem Prinzip der geringsten Rechte.

Dies bedeutet, dass das MCP-Protokoll selbst keine Sicherheitsspezifikationen enthält; stattdessen sind die Server-Implementierer dafür verantwortlich, Drittanbieter-Sicherheitssysteme zu entwerfen und zu integrieren. Beispielsweise können Unternehmensplattformen MCP mit Identitätsverwaltungssystemen für sichere Zugriffskontrolle, Governance und Auditierung integrieren.

Erweiterbarkeit und Plugin-Architektur

Die Erweiterbarkeit von MCP ergibt sich naturgemäß aus seinem Protokolldesign. Die Entwicklung eines "benutzerdefinierten Werkzeugs" beinhaltet die Erstellung eines Serverprogramms, das das MCP-Protokoll implementiert. Wenn dieser Server startet und sich mit der KI-Anwendung (MCP Client) verbindet, registriert er dynamisch seine Werkzeuge über die Standardmethode tools/list. Die KI-Anwendung entdeckt und nutzt diese neuen Funktionen ohne Vorkonfiguration oder Neukompilierung, wodurch eine echte Plug-and-Play-Funktionalität erreicht wird.

MCP Server umfassen typischerweise Mechanismen für:

- Entwicklung benutzerdefinierter Werkzeuge;

- Dynamische Registrierung/Erkennung von Werkzeugen und Fähigkeiten;

- Plugin-Unterstützung, um das Verhalten zu erweitern, ohne den Protokollkern zu modifizieren.

Werkzeuglebenszyklus und Sitzungsverwaltung

Der Lebenszyklus einer MCP-Verbindung beginnt mit dem initialize-Handshake und endet, wenn die Verbindung geschlossen wird. Während dieser Zeit teilen sich alle Werkzeugaufrufe und Ressourcenlesevorgänge eine logische Sitzung. Für MCP Server, die mehrere unabhängige Benutzer oder Sitzungen bedienen müssen (insbesondere im HTTP-Modus), muss die Implementierung die Zustandsisolation zwischen verschiedenen Clients oder Anfragen verwalten.

Der MCP Server verwaltet:

- Sitzungskontext: Speichern des Zustands über mehrere Aufrufe hinweg;

- Isolationsmechanismen: Sicherstellen, dass Sitzungen zwischen verschiedenen Clients isoliert sind, um Datenlecks oder Zustandsverunreinigungen zu verhindern.

Dieses Management unterstützt fortgeschrittene Anwendungsfälle wie lange Sitzungen und mehrstufige Operationen.

Systemleistung und Zuverlässigkeitsdesign

Als leichtgewichtiges Protokoll hängt die Leistung von MCP stark von der Effizienz der Server-Implementierung und der Netzwerklatenz ab. Für Hochverfügbarkeitsanforderungen können mehrere MCP Server-Instanzen hinter einem Lastverteiler bereitgestellt werden. Das Protokoll definiert eine logging-Schnittstelle, die es Servern ermöglicht, Ausführungsprotokolle an den Client zu senden, was die Grundlage für Audits bildet.

MCP Server-Designs umfassen häufig:

- Lastverteilung für die Bereitstellung mehrerer Repliken;

- Fehlerwiederherstellung, um hohe Verfügbarkeit zu gewährleisten;

- Protokollierung und Auditierung zur Verfolgung der Aufrufhistorie und für Diagnosen.

Diese Mechanismen erhöhen die Stabilität für den Einsatz in Unternehmensumgebungen.

Integration in moderne Ökosysteme

Um sich an Cloud-native Umgebungen anzupassen, arbeiten MCP Server oft mit Kubernetes und Cloud-Lastverteilern für Auto-Skalierung und elastische Bereitstellung zusammen. MCP Server können containerisiert und auf Plattformen wie Kubernetes bereitgestellt werden, was Gesundheitsprüfungen und zentralisiertes Management innerhalb moderner Unternehmensinfrastruktur-Stacks ermöglicht.

3. MCP vs. traditionelle API-Integration: Architektur-Paradigmen

Im Vergleich zur unabhängigen API-Integration nutzt MCP die Protokollabstraktion, um Sicherheit, Wartbarkeit und Cross-Plattform-Fähigkeiten zu verbessern.

| Funktion | MCP Server | Traditionelle API-Integration | Plugin-Systeme | SDK-Modus |

|---|---|---|---|---|

| Standardisierung | Industriestandard | Variiert pro API | Plattformspezifisch | Anbieterspezifisch |

| Entwicklungskosten | Niedrig (Einmal implementieren) | Hoch | Mittel | Hoch |

| Wartungskomplexität | Niedrig | Sehr Hoch | Mittel | Hoch |

| Cross-Plattform-Fähigkeit | Exzellent | Schlecht | Schlecht | Schlecht |

| Sicherheitsmodell | Einheitliche Kontrolle | Fragmentiert | Plattformgesteuert | Fragmentiert |

| Echtzeit-Unterstützung | Native Unterstützung | Polling/Webhooks | Begrenzt | Benutzerdefiniert |

| Community-Ökosystem | Wächst schnell | Fragmentiert | Geschlossen | Vendor Lock-in |

4. Wie MCP Server mit KI-Agenten zusammenarbeiten

In einer typischen planungsbasierten KI-Agenten-Architektur umfassen die Komponenten einen Planner, einen Executor und einen Speicher. Der MCP Server fungiert in dieser Architektur als standardisiertes Ausführungs-Backend.

- Planner: (Üblicherweise das LLM) formuliert Strategien basierend auf Eingaben. Es ruft die aktuelle Liste der verfügbaren

Toolsund deren Beschreibungen vom MCP Client ab. Der Planner skizziert dann eine Abfolge von Schritten (z. B. "Werkzeug A zur Abfrage von Daten verwenden, dann Werkzeug B zur Verarbeitung der Ergebnisse"). - Executor: (Üblicherweise der MCP Client) sendet

tools/call-Anfragen an den entsprechenden MCP Server basierend auf dem Plan. - Memory: Speichert Zustand und Kontext. Ausführungsergebnisse werden an den Agenten zurückgegeben, im Speicher abgelegt und für die weitere Planung verwendet. Zusätzlich können

Resourcesproaktiv Hintergrundwissen zur Aufgabe bereitstellen.

Der MCP Server dient als Fähigkeitsanbieter für den Executor und ermöglicht es dem Planner, Werkzeuge und Ressourcen über ein Standardprotokoll zuzugreifen.

Die Position von MCP in einer KI-Agenten-Architektur ähnelt der Schnittstelle eines Betriebssystems für externe Dienste, die die Ausführung von Fähigkeiten vereinheitlicht und standardisiert.

MCP ist komplementär zu Frameworks wie LangChain und AutoGen. Während diese Frameworks eine hohe Abstraktion und Orchestrierung für KI-Agenten-Workflows bieten, dient MCP als standardisierte Werkzeugausführungsebene. Es löst die Probleme des "Klebstoffcodes" und der Fragmentierung, mit denen diese Frameworks bei der Integration spezifischer Werkzeuge konfrontiert sind.

5. Die drei Kern-Fähigkeitsprimitiva von MCP

Diese Primitive definieren das MCP-Protokoll-Datenmodell und wie KI-Anwendungen mit dem Server interagieren.

- Werkzeuge (Tools): Aufrufbare Funktionen wie Such- oder Datenbankoperationen. Jedes Werkzeug hat einen klaren Namen, eine Beschreibung und ein JSON-Schema für Eingabeparameter. Das KI-Modell löst diese bei Bedarf aus (z. B. ein

send_email-Werkzeug). - Ressourcen (Resources): Zugängliche Datenquellen wie Dateisysteme oder Objektspeicher. Jede Ressource hat einen URI und einen MIME-Typ. KI-Anwendungen lesen diese Inhalte, um Kontext in Prompts zu injizieren (z. B. eine

file:///reports/weekly.md-Ressource). - Prompts: Vordefinierte Vorlagen oder Kontexte, die zur Unterstützung der LLM-Entscheidungsfindung verwendet werden. Diese bieten eine strukturierte Möglichkeit für Benutzer, spezifische Aufgaben zu starten (z. B. ein "Wochenendtrip planen"-Prompt, der das Modell zur Verwendung relevanter Werkzeuge anleitet).

Dieses dreistufige Design ermöglicht es dem MCP Server, seine ausführbaren Funktionen klar auszudrücken und gleichzeitig die dynamische Erkennung zu unterstützen. Zusätzlich erlaubt das Protokoll Servern, Modellgenerierung (LLM-Sampling) vom Client anzufordern. Dies ermöglicht es dem Server, das LLM des Clients für die Argumentation während seiner eigenen Ausführungslogik zu nutzen. Clients müssen diese Fähigkeit während der Initialisierung deklarieren, um sie zu unterstützen.

6. Kommunikationsbeziehung: MCP Client, Server und LLM

Das Verständnis der Beziehung zwischen diesen dreien ist entscheidend für das Verständnis des MCP-Workflows:

- Wer initiiert die Verbindung? Der MCP Client (in die KI-Anwendung integriert) initiiert aktiv die Verbindung zum MCP Server.

- Wer entscheidet über den Aufruf eines Werkzeugs? Das LLM (innerhalb der KI-Anwendung) trifft Entscheidungen basierend auf interner Logik. Der MCP Client stellt die Liste der verfügbaren Werkzeuge als Kontext bereit, und das LLM entscheidet, ob ein Werkzeug aufgerufen werden soll, welches und mit welchen Parametern.

- Wer führt die Operation aus? Der MCP Server ruft den eigentlichen Dienst oder die Ressource auf. Er empfängt die standardisierte

tools/call-Anfrage vom Client, übersetzt sie in Aktionen für das zugrunde liegende System (Datenbank, API, Datei) und gibt das standardisierte Ergebnis zurück.

7. Vollständiger MCP Server Aufrufprozess

Ein typischer Workflow umfasst:

- Initialisierung: Client und Server stellen eine Verbindung her und tauschen Protokollversionen und Fähigkeiten aus.

- Fähigkeitserkennung: Der Client ruft die Liste der Werkzeuge und Ressourcen vom Server über

tools/listab. - Werkzeugaufruf: Nachdem das LLM eine Entscheidung getroffen hat, sendet der Client eine

tools/call-Anfrage. Der Server führt die eigentliche Operation aus. - Ergebnisinjektion: Der Server gibt strukturierte Ergebnisse zurück, die der Client dem LLM für die endgültige Antwortgenerierung oder weitere Planung zur Verfügung stellt.

Typisches Zeitdiagramm für ein Aufrufprotokoll:

Unten ist ein vereinfachtes Zeitdiagramm für einen Fall einer Konferenzraumbuchung dargestellt, das die Kernprotokollinteraktion von der Initialisierung bis zur Ausführung zeigt:

8. MCP vs. traditionelle API / Funktionsaufruf: Unterschiede auf der Modell-Schnittstellenschicht

Die traditionelle API-Integration hängt von herstellerdefinierten Spezifikationen und SDKs ab. MCP abstrahiert das Aufrufverhalten in JSON-RPC-Methoden, wodurch eine Standardschnittstelle beibehalten wird, die unabhängig von spezifischen SDKs ist.

- Traditioneller Funktionsaufruf Dies ist eine Funktion, die von spezifischen Modell-Anbietern bereitgestellt wird. Entwickler definieren Funktionen im Format des Anbieters, und das Modell lernt, Anfragen in diesem Format auszugeben. Es ist an die proprietäre Schnittstelle des Anbieters gebunden.

- MCP Architektur MCP ist ein modellunabhängiges offenes Protokoll. Es definiert universelle, standardisierte Formate für die Fähigkeitenbeschreibung und den Aufruf. Jede KI-Anwendung, die MCP unterstützt (unabhängig vom zugrunde liegenden Modell), kann mit jedem MCP Server interagieren. Es befreit die Werkzeugintegration vom Modell-Anbieter-Lock-in.

MCP eignet sich besser für die langfristige Wartung und den Aufbau von Ökosystemen in großen, Multi-Modell-Umgebungen.

Anwendungsfallgrenzen: Wenn Sie ein einzelnes Modell mit einfachen, festen Werkzeuganforderungen verwenden, kann ein Funktionsaufruf ausreichen. Wenn Sie ein komplexes Agenten-System aufbauen, das mehrere Modelle und Werkzeuge umfasst und langfristige Skalierbarkeit erfordert, sind die Standardisierung und Entkopplung durch MCP unerlässlich.

9. Einschränkungen und Herausforderungen von MCP

Obwohl der MCP Server eine standardisierte Methode für KI-Agenten zur Interaktion mit Werkzeugen bietet, ist er keine "Wunderwaffe". Es ist entscheidend zu verstehen, was MCP nicht löst und welche Herausforderungen in realen technischen Umgebungen bestehen.

1. Fähigkeitskonflikte und Governance bei mehreren MCP Servern

In komplexen Systemen sind oft mehrere MCP Server verbunden. Verschiedene Server können Werkzeuge mit ähnlicher Semantik oder überlappenden Funktionen offenlegen. Das MCP-Protokoll behandelt Deklarations- und Aufrufspezifikationen, umfasst aber nicht:

- Rangfolge der Werkzeugpriorität

- Konflikterkennung oder -lösung

- Strategie zur optimalen Werkzeugauswahl basierend auf dem Kontext

Das bedeutet: Die Entscheidungsverantwortung liegt vollständig beim MCP Client oder der KI-Agenten-Schicht. Der Planner oder das Strategiemodul muss seine eigene Werkzeugauswahllogik implementieren. Daher ist MCP eine "Fähigkeits-Expositions- und Kommunikationsschicht", kein "intelligentes Planungssystem".

2. Kontextdruck durch Langzeit- und Mehrrunden-Aufrufe

In Agenten-Szenarien umfassen Aufgaben mehrere Schritte:

- Planung

- Mehrere Werkzeugaufrufe (

tools/call) - Ergebnisinjektion

- Neu-Argumentation und Entscheidungsfindung

Dieser Prozess hängt kontinuierlich Informationen an das Kontextfenster des LLM an. Es ist wichtig zu beachten:

- MCP ist nicht verantwortlich für Kontextbeschneidung, -komprimierung oder -zusammenfassung.

- Es verfügt über keine integrierte Speicherverwaltung oder Kontextoptimierung.

Bei langen Aufgaben kann dies führen zu:

- Schnell steigenden Token-Kosten

- Annäherung an Modellkontextgrenzen

- Wichtige Informationen werden "überflutet"

Das Kontextmanagement bleibt eine Herausforderung, die von der Agenten-Architektur-Schicht gelöst werden muss, nicht vom MCP-Protokoll.

3. Unterschiede im Reifegrad der Sprachimplementierungen

Obwohl das Protokoll sprachunabhängig ist, variiert der Reifegrad in der Praxis:

- Die JavaScript/Node.js- und Python-Ökosysteme sind am weitesten entwickelt.

- Implementierungen für Rust, Go und Java entwickeln sich noch.

- Die Unterstützung für die neuesten Spezifikationen kann zwischen den Implementierungen variieren.

Entwicklungsteams müssen:

- Die Konsistenz zwischen Implementierungen und Spezifikationen gewährleisten.

- Die Stabilität und Wartbarkeit von MCP Server-Implementierungen für Produktionsumgebungen bewerten.

Dies ist bei jedem aufkommenden Protokoll in seinen frühen Phasen üblich.

4. Sicherheit und Berechtigungen verlassen sich auf externe Systeme

MCP ist als "protokollneutral" konzipiert und enthält kein integriertes Sicherheitssystem. Speziell:

- MCP definiert Fähigkeitsgrenzen (Werkzeuge / Ressourcen).

- Es schreibt keine spezifischen Authentifizierungs-, Autorisierungs- oder Auditmechanismen vor.

Im realen Einsatz muss die Sicherheit über externe Systeme implementiert werden, wie zum Beispiel:

- OAuth / OIDC

- API Gateways

- Zero Trust Architekturen

- Enterprise IAM Systeme

Ein MCP Server sollte betrachtet werden als:

Ein Fähigkeitsdienst, der in ein Sicherheitssystem eingebettet ist, anstatt das Sicherheitskontrollzentrum selbst.

Dies ist ein Hauptgrund, warum MCP sich flexibel an verschiedene Unternehmen und Cloud-Umgebungen anpassen kann, erhöht aber auch die Komplexität des Systemdesigns.

5. Schnelle Entwicklung des Protokolls und Ökosystems

Als neues Protokoll für KI-Agenten entwickelt sich MCP schnell:

- Protokolldetails und Primitive werden verfeinert.

- Es gibt eine Zeitverzögerung, bis verschiedene Implementierungen neue Funktionen unterstützen.

- Best Practices für fortgeschrittene Anwendungsfälle werden noch etabliert.

MCP sollte als langfristiges Infrastrukturprotokoll betrachtet werden und nicht als ein finalisierter, statischer Standard.

MCP Server konzentrieren sich darauf, eine standardisierte Methode zur Entdeckung, zum Aufruf und zur Kombination von Werkzeugen bereitzustellen. Das Verständnis dieser Einschränkungen hilft Entwicklern:

- Klare Verantwortlichkeitsgrenzen zu definieren.

- Eine übermäßige Abhängigkeit vom Protokoll selbst zu vermeiden.

- Komplexität auf der entsprechenden Architektur-Schicht zu lösen.

Fazit

In der praktischen Ingenieurwissenschaft fungiert MCP als "Fähigkeitsprotokoll-Grundlage", dessen Wert mit zunehmender Systemkomplexität deutlicher wird. Der MCP Server ersetzt weder traditionelle APIs noch Funktionsaufrufe; stattdessen bietet er eine standardisierte, erweiterbare und sichere Protokollschicht für KI-Agenten. Durch die Einführung dieser Schicht werden die zentralen technischen Herausforderungen der Skalierung von KI-Agenten angegangen: Reduzierung der Integrationskomplexität von N×M auf N+M, Bereitstellung eines Frameworks für dynamische Erkennung und sichere Ausführung sowie Entkopplung des Werkzeug-Ökosystems von KI-Modellen. Dies ermöglicht intelligenten Agenten:

- Fähigkeiten systematisch zuzugreifen;

- Werkzeuge/Ressourcen dynamisch zu entdecken und aufzurufen;

- Modell- und plattformübergreifend zu interagieren.

MCP legt den Grundstein für ein reichhaltiges, zusammensetzbares KI-Werkzeug-Ökosystem. Es markiert einen Übergang von "manueller Integration" zu "standardisierter Infrastruktur" und bietet eine Grundlage für den Aufbau interoperabler, skalierbarer und sicherer Unternehmens-KI-Systeme.

MCP Häufig gestellte Fragen (FAQ)

1. Wird MCP traditionelle APIs oder Funktionsaufrufe ersetzen?

Nein. MCP ist kein Ersatz, sondern agiert auf einer höheren Ebene, wodurch der MCP Client Fähigkeiten dynamisch von einem MCP Server über die list-Methode entdecken kann.

- Für einfache, feste, Einzelmodell-Szenarien ist der Funktionsaufruf effizient.

- Für Multi-Modell-, Multi-Werkzeug-, sich entwickelnde Agenten-Systeme bietet MCP eine bessere Entkopplung und Wartbarkeit.

In realen Systemen haben die beiden oft eine komplementäre Beziehung.

2. Benötigt MCP ein spezifisches LLM?

Nein. MCP ist modellunabhängig. Es regelt die Kommunikation zwischen Client und Server und ist unabhängig davon, ob das zugrunde liegende Modell von OpenAI, Anthropic, Google oder einem lokalen Open-Source-Modell stammt. Solange die KI-Anwendung den Werkzeugkontext bereitstellen und Aufrufe gemäß dem MCP-Protokoll initiieren kann, kann sie den MCP Server nutzen.

3. Hat MCP eine integrierte Sicherheit?

Nein. Es ist protokollneutral. Sicherheit (HTTPS, OAuth2, IAM) muss von der Bereitstellungsumgebung und externen Systemen bereitgestellt werden.

4. Wie werden Werkzeugkonflikte bei mehreren MCP Servern gehandhabt?

MCP löst keine Konflikte. Wenn mehrere Server ähnliche Werkzeuge anbieten, liegt die Verantwortung für die Werkzeugauswahl und -priorität beim Client oder der Planner-Schicht des Agenten.

5. Verursacht MCP eine Überlastung des Kontextfensters?

Das kann passieren, aber dies ist eine inhärente Herausforderung von LLM-Agenten. MCP verwaltet den Kontext nicht; Zusammenfassung und Speicherverwaltung liegen in der Verantwortung der Agentenarchitektur.

6. Ist MCP für den Einsatz in Unternehmen mit hoher Parallelität geeignet?

Ja, vorausgesetzt, die Implementierung ist robust. Hohe Parallelität hängt von der Serverqualität, der Bereitstellung mehrerer Instanzen und Cloud-nativen Architekturen wie Kubernetes ab.

7. Sind die Kosten für die Einführung von MCP hoch?

Die Codierung ist relativ einfach, erfordert aber ein architektonisches Verständnis von Agenten-Systemen und Werkzeug-Governance. Es ist am besten geeignet für Teams, die mittelgroße bis große KI-Anwendungen entwickeln.

8. Ist MCP "stabil"?

Das Kerndesign ist stabil, aber das Ökosystem entwickelt sich noch. Es ist ein zukunftsorientiertes Infrastrukturprotokoll und keine "einmalige" Lösung.

9. Ist MCP für einzelne Entwickler geeignet?

Ja, wenn Skalierbarkeit benötigt wird. Für sehr einfache Projekte könnte es "übertrieben" sein, aber es verhindert hohe Refactoring-Kosten, wenn ein System wächst.

10. Welches Problem löst MCP am besten?

Es zeichnet sich durch die Standardisierung des Zugriffs auf mehrere Werkzeuge/Dienste aus, entkoppelt die Fähigkeitserkennung von der Ausführung und ermöglicht die Wiederverwendung von Fähigkeiten über verschiedene Modelle und Teams hinweg.

MCP-Artikelserie:

- Umfassende Analyse des MCP-Servers: Die Drehscheibe für Kontext und Tool-Kommunikation im Zeitalter der KI-Agenten

- Welche Kernprobleme löst der MCP-Server? Warum AI-Agents ihn brauchen

- MCP Server Architektur und Funktionsweise: Vom Protokoll zum Ausführungsfluss

- MCP Server Praxisleitfaden: Aufbau, Test und Bereitstellung von 0 auf 1

- MCP Server: Bewertung von Anwendungsszenarien und Leitfaden zur Technischen Auswahl

Über den Autor

Dieser Inhalt wird vom Redaktionsteam von NavGood zusammengestellt und veröffentlicht. NavGood ist eine Plattform, die sich auf KI-Werkzeuge und Anwendungsökosysteme konzentriert und die Entwicklung und Implementierung von KI-Agenten, automatisierten Workflows und generativer KI verfolgt.

Haftungsausschluss: Dieser Artikel repräsentiert das persönliche Verständnis und die Erfahrung des Autors. Er spiegelt nicht die offizielle Position eines Frameworks oder Unternehmens wider und stellt keine kommerzielle oder Anlageberatung dar.

Referenzen: [1]: https://json-rpc.dev/learn/mcp-basics "Understanding JSON-RPC for AI Integration" [2]: https://modelcontextprotocol.io/docs/learn/architecture "Architecture overview - Model Context Protocol" [3]: https://json-rpc.org/specification "JSON-RPC 2.0 Specification" [4]: https://modelcontextprotocol.io/docs/learn/architecture "About MCP: Architecture overview"