Welche Kernprobleme löst der MCP-Server? Warum AI-Agents ihn brauchen

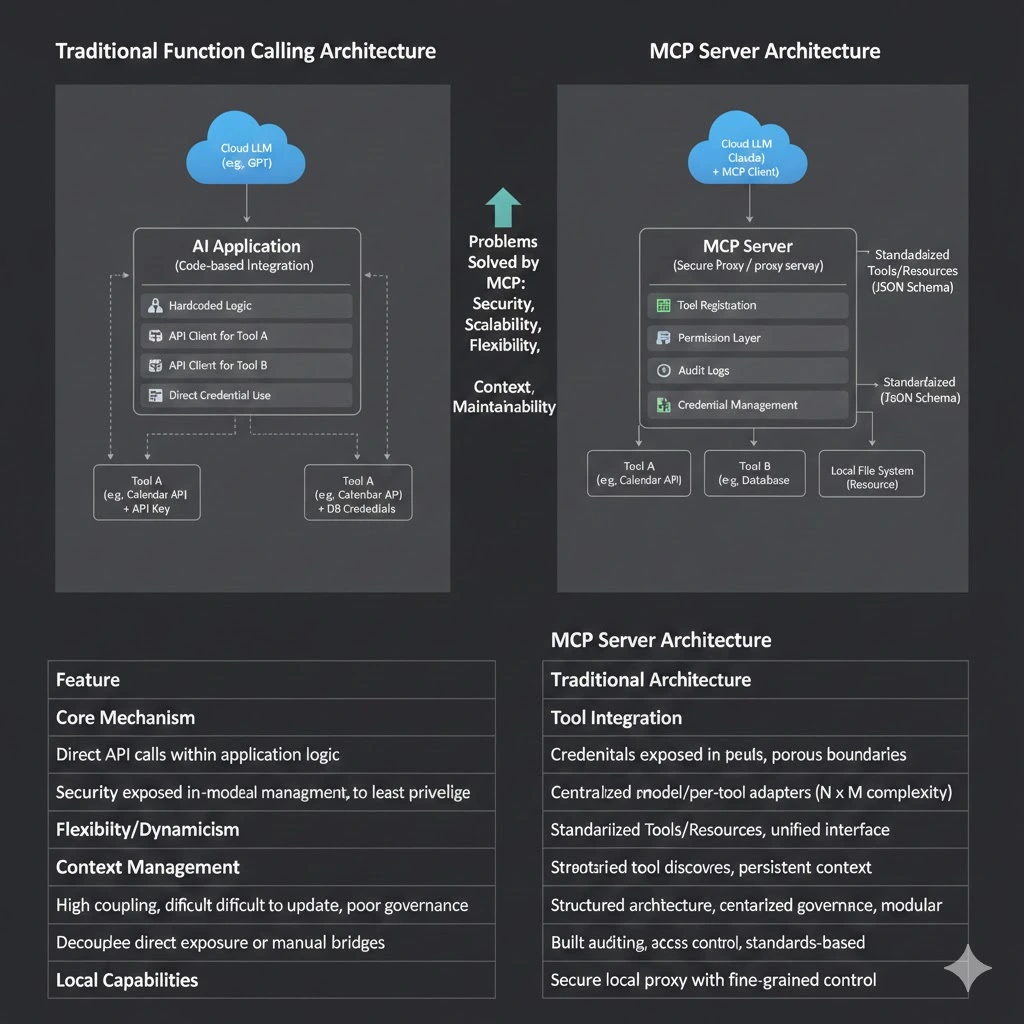

In der Anfangszeit von KI-Anwendungen reichte das Aufrufen von APIs via "Function Calling" für einfache Automatisierungsanforderungen aus. Da sich die KI jedoch von einem reinen "Konversationstool" zu einem Agenten mit autonomen Planungs- und Ausführungsfähigkeiten entwickelt, stoßen wir auf eine Reihe systemischer technischer Herausforderungen: Schwierigkeiten bei der Vereinheitlichung und sicheren Anbindung von Tools sowie Architekturen, die sich nur schwer flexibel mit den Modelliterationen weiterentwickeln lassen.

Die Ursache dieser Probleme liegt im Fehlen einer standardisierten Fähigkeitsebene, die speziell für KI-Interaktionsmuster entwickelt wurde. Das Model Context Protocol (MCP) und seine Kernimplementierung, der MCP-Server, sind in diesem Zusammenhang entstanden. Es definiert einen standardisierten Weg, um Modelle mit externen Datenquellen, Tools und Diensten zu verbinden und unterstützt so skalierbare AI-Agent-Systeme.

Dieser Artikel erläutert den zentralen Wert, den die Einführung von MCP-Servern bietet, und die wichtigsten Probleme, die sie lösen.

Zielgruppe:

- Tech-Enthusiasten und Einsteiger

- Fach- und Führungskräfte, die Effizienzsteigerungen anstreben

- Entscheidungsträger in Unternehmen und Geschäftsbereichsleiter

- Allgemeine Nutzer, die an zukünftigen KI-Trends interessiert sind

Inhaltsverzeichnis:

- 1. Wenn LLMs "Handlungsfähigkeiten" benötigen: Wie greift man sicher auf die reale Welt zu?

- 2. Wenn Aufgaben offen gestaltet sind: Warum scheitern fest codierte Workflows?

- 3. Wenn sich Modelle ständig ändern: Wie vermeidet man die Tool-Modell-Kopplung?

- 4. Wenn Aufgaben länger werden: Warum wird der Kontext fragmentiert?

- 5. Wenn Funktionen lokal sind: Wie verbindet man sich sicher mit Cloud-Modellen?

- 6. Wenn die Agent-Skalierung zunimmt: Wie wartet man das System?

- 7. Wenn KI in das Unternehmen einzieht: Wie lassen sich interne Systeme sicher wiederverwenden?

- MCP-Server ist nicht nur ein Protokoll, sondern eine Schlüssel-Infrastruktur für die Ära der AI-Agents

1. Wenn LLMs "Handlungsfähigkeiten" benötigen: Wie greift man sicher auf die reale Welt zu?

Hintergrund

Large Language Models (LLMs) sind im Wesentlichen Textgeneratoren, aber sie besitzen von Natur aus nicht die Fähigkeit, direkt auf externe Systeme zuzugreifen oder Aktionen auszuführen. Um ein LLM mit der Außenwelt zu verbinden, muss man Zugriff auf APIs, Datenbanken oder Dateisysteme gewähren. Dies führt sofort zu Sicherheits- und Anpassungshürden; ohne eine einheitliche sichere Ausführungsebene ist die individuelle Anpassung jedes Tools sowohl mühsam als auch unsicher.

Ohne MCP-Server

Entwickler müssen spezifischen Integrationscode für jedes Tool schreiben und sensible Zugangsdaten (wie API-Keys) oder interne Systeme direkt gegenüber der KI-Anwendung offenlegen. Dies führt zu verschwommenen Sicherheitsgrenzen und hohen Risiken. Zusammenfassung:

- LLMs können nur "Text generieren" und keine physischen Aktionen auslösen.

- Für jedes externe System muss ein individueller Anpassungscode für jeden Modelltyp geschrieben werden.

- API-Keys oder interne Anmeldedaten müssen dem Aufrufer offengelegt werden, was Sicherheitsrisiken birgt.

Die Lösung durch den MCP-Server

Eine der Kernaufgaben eines MCP-Servers ist die Funktion als Sicherheits-Proxy. Er läuft in einer vertrauenswürdigen Umgebung und ist für die Speicherung und Verwaltung aller sensiblen Zugangsdaten verantwortlich. Gemäß den offiziellen MCP-Definitionen stellt der Server standardisierte Tools bereit, die ihre Funktionen und erforderlichen Parameter über ein klares JSON-Schema beschreiben. Die KI-Anwendung (MCP-Client) ruft Tool-Beschreibungen über tools/list ab, und das Modell entscheidet basierend auf diesen Beschreibungen, wann ein Tool aufgerufen werden soll. Die spezifische Ausführung – einschließlich Berechtigungsprüfung und Audit-Logging – wird vollständig vom MCP-Server gesteuert. Dieses Design gewährleistet die Umsetzung des Prinzips der minimalen Rechtevergabe (Principle of Least Privilege).

Ein MCP-Server ist ein serverseitiges Programm, das dem MCP-Protokoll folgt. Er kann externe Funktionen standardmäßig in Tool-Schnittstellen (Tools) oder Ressourcen-Schnittstellen (Resources) kapseln und den Zugriff durch Sicherheitsmechanismen steuern.

- Kapselt verschiedene reale Funktionen (Datenbanken, APIs, Dateisysteme) in standardisierte Tools.

- Modelle müssen lediglich die Funktionsbeschreibung und die Parameterstruktur des Tools verstehen.

- Die tatsächliche Berechtigungsprüfung, Ausführung und die Sicherheitsgrenzen werden vom MCP-Server verwaltet.

LLMs sind so in der Lage, sicher mit der realen Welt zu interagieren und entwickeln sich vom reinen "Chatten" zu aufgabenorientierten AI-Agents, ohne das Risiko einzugehen, Kernsysteme direkt offenzulegen. Es ist wichtig zu beachten, dass das MCP-Protokoll zwar den Standard für die Bereitstellung und den Aufruf von Funktionen definiert, die Sicherheitskontrolle und Berechtigungsmodelle jedoch durch spezifische MCP-Server-Implementierungen gehandhabt werden.

2. Wenn Aufgaben offen gestaltet sind: Warum scheitern fest codierte Workflows?

Hintergrund

Der Wert eines AI-Agenten liegt in der Bearbeitung offener, mehrstufiger und komplexer Aufgaben, bei denen der Ausführungspfad oft dynamisch und nicht deterministisch ist. Traditionelle API-Integrationsmodelle basieren darauf, dass Entwickler eine feste Aufruflogik vorab programmieren, die sich nicht an diese Flexibilität anpassen kann.

Einschränkungen traditioneller API / Function Calling Methoden

Jedes Mal, wenn sich ein Aufgaben-Workflow ändert oder ein Tool hinzugefügt wird, muss der Anwendungscode geändert und neu bereitgestellt werden. Dies schafft ein starres System, das Schwierigkeiten hat, sich an schnell wechselnde Anforderungen anzupassen. Kernprobleme sind:

- Die Aufruflogik ist fest in die Anwendung einprogrammiert.

- Das Hinzufügen von Tools oder das Ändern von Prozessen erfordert Code-Änderungen und eine Neuverteilung.

- Ungeeignet für offene, dynamische Entscheidungsaufgaben.

Die Lösung durch den MCP-Server

Das MCP-Protokoll unterstützt die dynamische Tool-Erkennung. Ein MCP-Client (der in die KI-Anwendung integriert ist) kann beim Start automatisch erkennen, welche Tools ein verbundener Server bereitstellt. Das bedeutet, dass das Tool-Set unabhängig von der KI-Anwendung aktualisiert und erweitert werden kann. Agenten können autonom entscheiden und planen, welche Tools sie in welcher Reihenfolge aufrufen, basierend auf den in Echtzeit entdeckten Fähigkeiten. Dies markiert einen grundlegenden Wandel von "menschdefinierten Workflows" hin zu "modellgesteuerter dynamischer Planung".

Das MCP-Protokoll definiert Standard-Schemas für Tools und Ressourcen, wodurch diese "dynamisch entdeckt und aufgerufen" werden können.

- Tools legen ihre Funktionalität durch standardisierte Schemas offen.

- Aufrufentscheidungen und Ausführungssequenzen werden durch Modell-Reasoning bestimmt, nicht durch harte Codierung.

- MCP bietet die notwendige Funktionsbereitstellung und Kontextgrundlage für die autonome Planung von Agenten.

Der entscheidende Wandel

Der Intelligenzkern des Systems verlagert sich von einer fixen Codelogik hin zu einem Echtzeit-Reasoning des Modells, das auf dem Verständnis der Tool-Fähigkeiten basiert. Es bewegt sich weg von "menschdefinierten Prozessen" hin zu "modellgeplanten Prozessen basierend auf Semantik".

3. Wenn sich Modelle ständig ändern: Wie vermeidet man die Tool-Modell-Kopplung?

Hintergrund

Modelle im KI-Bereich iterieren rasant. Ein Unternehmen könnte gleichzeitig Modelle von OpenAI, Anthropic, Google oder anderen Open-Source-Anbietern nutzen. Wenn der Tool-Integrationscode tief an das SDK oder die Aufrufmethode eines spezifischen Modells gebunden ist, verursacht der Wechsel oder das Hinzufügen von Modellen enorme Kosten für redundante Entwicklung und Wartung.

Ohne MCP-Server

Jedes Modell benötigt eine unabhängige Tool-Anpassungsebene, was eine Integrationskomplexität von N Modellen x M Tools (N x M) erzeugt. Die Wartungskosten steigen exponentiell.

- Jedes Modell hat seine eigenen Tool-Definitionen.

- Entwickler müssen Kompatibilitätslogik für verschiedene Modelle separat schreiben.

- Die Systemwartungskosten steigen erheblich.

Die Lösung durch den MCP-Server

Als offenes Protokoll fungiert MCP als universelle Zwischensprache. Jede KI-Anwendung, die einen MCP-Client implementiert (wie Claude Desktop, Cursor IDE usw.), kann mit jedem Server kommunizieren, der dem MCP-Protokoll folgt. Tool-Entwickler müssen einen MCP-Server nur einmal gemäß dem Standard implementieren, um seine Funktionen für mehrere KI-Anwendungen mit unterschiedlichen Backends verfügbar zu machen. Dies entkoppelt Tools vollständig von spezifischen KI-Modellen; ein einzelner MCP-Server kann von mehreren verschiedenen LLMs gleichzeitig genutzt werden.

Die Entstehung des MCP-Servers befreit Entwickler von der repetitiven Arbeit, "Adapter" für spezifische Modelle zu schreiben, und ermöglicht ihnen den Aufbau einer nachhaltigen, wiederverwendbaren und modellagnostischen KI-Infrastruktur.

4. Wenn Aufgaben länger werden: Warum wird der Kontext fragmentiert?

Hintergrund

In komplexen, mehrstufigen Agenten-Aufgaben sind Informationen über verschiedene Tool-Ergebnisse, gelesene Dateiinhalte und den Gesprächsverlauf verteilt. Bei herkömmlichen Methoden ist es eine große Herausforderung, diese unstrukturierten Informationen effektiv zu organisieren und dem Modell kontinuierlich zur Verfügung zu stellen, was oft dazu führt, dass das Modell Schlüsselinformationen "vergisst" oder widersprüchliche Entscheidungen trifft.

Häufige Probleme

- Tool-Aufrufergebnisse sind schwer wiederzuverwenden.

- Zustände sind über mehrstufige Aufgaben hinweg inkonsistent.

- Modellen fehlt ein ganzheitliches Kontextbewusstsein.

Die Lösung durch den MCP-Server

Das MCP-Protokoll definiert Resources als Kernprimitive. Ressourcen sind schreibgeschützte, strukturierte Datenquellen (wie Dateien, API-Dokumentationen oder Datenbank-Schemas). Ein MCP-Server kann Ressourcen bereitstellen, und ein MCP-Client kann diese nach Bedarf lesen (resources/read), um ihren Inhalt dem Modell als Kontext zur Verfügung zu stellen. Dies bietet dem Agenten ein kontinuierliches, strukturiertes externes Wissen und mildert effektiv das Problem der Kontextfragmentierung.

MCP-Server ermöglichen es Agenten, einen kontinuierlichen, strukturierten Kontext über mehrstufige Aufgaben hinweg beizubehalten, anstatt sich "Informationen temporär zu merken".

5. Wenn Funktionen lokal sind: Wie verbindet man sich sicher mit Cloud-Modellen?

Viele zentrale Unternehmensfunktionen (wie der Zugriff auf lokale Dateisysteme, Git-Repositories oder interne Entwicklungstools) befinden sich auf dem lokalen Rechner eines Benutzers oder in einem Unternehmens-Intranet. Benutzer möchten möglicherweise leistungsstarke cloudbasierte LLMs nutzen, um diese Funktionen zu steuern, aber die direkte Vergabe lokaler Berechtigungen an Cloud-Modelle ist höchst unsicher.

Ohne MCP-Server

- Auf Dateisysteme und Versionskontrollsysteme kann nicht sicher zugegriffen werden.

- Es müssen übermäßig hohe Berechtigungen erteilt werden, um Aufrufe zu ermöglichen.

- Hohes Risiko von Credential-Leckagen oder Missbrauch.

Die Lösung durch den MCP-Server

Ein MCP-Server kann als leichtgewichtiger Prozess in einer lokalen Umgebung ausgeführt werden und nur autorisierte Funktionen offenlegen; so kann das Modell sicher auf erforderliche Ressourcen zugreifen, ohne Grenzen zu überschreiten. In Claude Desktop beispielsweise können Benutzer lokale Dateisystem- oder Git-MCP-Server konfigurieren. Diese Server geben nur streng definierte, harmlose Operationen (wie das Lesen von Dateien in einem bestimmten Verzeichnis oder das Abrufen eines Git-Logs) an das cloudbasierte Claude frei. Alle Anfragen laufen über einen sicheren lokalen Kanal, und Befehle des Cloud-Modells werden vom lokalen Server validiert und ausgeführt. Der Umfang der Funktionsfreigabe wird präzise kontrolliert. Dies ist genau der Grund für die schnelle Akzeptanz von MCP in IDEs und lokalen Entwicklungsszenarien.

Dieses Design ist der Hauptgrund für die schnelle Verbreitung von MCP in IDEs und Szenarien der lokalen Softwareentwicklung.

6. Wenn die Agent-Skalierung zunimmt: Wie wartet man das System?

In großflächigen Systemen muss ein Agent möglicherweise auf Dutzende von Tools zugreifen. Komplexe Berechtigungsrichtlinien und eine verstreute Aufruflogik erschweren die Wartung.

Schmerzpunkte traditioneller Architektur

- Tools sind überall verstreut, ohne einheitliche Governance.

- Die Agenten-Logik wird zu komplex für die Wartung.

- Berechtigungen und Auditing sind fragmentiert.

Die Lösung durch den MCP-Server

MCP bietet eine zentralisierte Verwaltungsebene für Tools und den Datenzugriff:

- Zentralisierte Registrierung und Verwaltung von Tools.

- Agenten kümmern sich nur um ihre verfügbaren Fähigkeiten.

- Der MCP-Server wird zur "Abstraktionsebene für Fähigkeiten" für den Agenten.

Diese schichtweise Governance ist ideal für die Modernisierung von Systemarchitekturen auf Unternehmensebene.

7. Wenn KI in das Unternehmen einzieht: Wie lassen sich interne Systeme sicher wiederverwenden?

Unternehmen möchten KI nutzen, um die betriebliche Effizienz zu steigern, aber interne Systeme (wie CRM, ERP und Datenbanken) verfügen in der Regel über nicht standardisierte Schnittstellen, komplexe Berechtigungsmodelle und strenge Compliance- und Auditing-Anforderungen. Es ist unsicher, diese Systeme direkt einem Modell auszusetzen.

Die Lösung durch den MCP-Server

In der Unternehmensarchitektur kann der MCP-Server als KI-spezifisches "Capability Gateway" fungieren. Jedes wichtige interne System (wie Salesforce, Jira oder interne Datenbanken) kann durch einen dedizierten MCP-Server gekapselt werden. Dieser Server ist verantwortlich für:

- Anpassung und Abstraktion: Umwandlung komplexer interner APIs in standardisierte MCP-Tools, wobei die Komplexität der internen APIs verborgen wird.

- Zentralisierung von Berechtigungen: Integration der Unternehmensidentitätsauthentifizierung (wie SSO) und Implementierung von Zugriffskontrollen auf Tool-Ebene.

- Audit-Protokollierung: Zentrale Aufzeichnung detaillierter Protokolle aller von der KI initiierten Operationen, um Compliance-Anforderungen zu erfüllen.

Auf diese Weise kann ein MCP-Server als "Firewall und Adapter" der KI-Fähigkeitsebene innerhalb einer Unternehmensarchitektur betrachtet werden. Er bietet eine konsistente und sichere Zugriffsmethode für verschiedene Agenten und Modelle und ermöglicht es der KI, Geschäftsprozesse unter sicheren und kontrollierbaren Bedingungen zu unterstützen.

MCP-Server ist nicht nur ein Protokoll, sondern eine Schlüssel-Infrastruktur für die Ära der AI-Agents

Zusammenfassend lässt sich sagen, dass der MCP-Server nicht nur einen einzelnen technischen Punkt löst, sondern eine Reihe von strukturellen Herausforderungen adressiert, denen AI-Agents gegenüberstehen, wenn sie in Richtung groß angelegter, technischer Anwendungen gehen:

- Sicherheitsherausforderungen: Implementierung des Least-Privilege-Zugriffs über ein Proxy-Modell.

- Integrationsherausforderungen: Entkopplung von Tools und Modellen durch ein standardisiertes Protokoll zur Reduzierung der

N x MIntegrationskomplexität. - Flexibilitätsherausforderungen: Unterstützung autonomer Agentenplanung durch dynamische Erkennung zur Anpassung an offene Aufgaben.

- Kontextherausforderungen: Bereitstellung von strukturiertem externem Speicher durch Primitive wie Resources.

- Unternehmensherausforderungen: Erfüllung von Berechtigungs-, Audit- und Compliance-Anforderungen über ein Gateway-Modell.

MCP (Model Context Protocol) definiert nicht nur eine standardisierte Art und Weise, wie Modelle mit externen Systemen kommunizieren, sondern bietet auch die Infrastruktur für den Aufbau skalierbarer, sicherer AI-Agent-Plattformen.

Es löst eine ganze Klasse systemischer Probleme, die von der "Bereitstellung von Fähigkeiten" und der "Tool-Governance" bis hin zur "Modellentkopplung", dem "Kontextmanagement" und dem "sicheren Zugriff" reichen. Dies macht die Entwicklung von AI-Agents in Multi-Modell-, Multi-Tool- und komplexen Aufgabenszenarien nachhaltig, wartbar und sicher.

Wie Anthropic bei der Ankündigung der Spende von MCP an die Linux Foundation zur Gründung der Agentic AI Foundation erklärte, zielt dieser Schritt darauf ab, die offene Entwicklung von Interoperabilitätsstandards für AI-Agents zu fördern. Der MCP-Server ist eine Schlüsselkomponente dieser Vision und bietet eine solide und zuverlässige Infrastrukturschicht für eine Zukunft, in der verschiedene KIs und Tools sicher und effizient zusammenarbeiten. Während sich die KI von Demos zur Produktion und von Einzelpunktanwendungen zu komplexen Systemen bewegt, bietet der MCP-Server eine durchdachte, skalierbare technische Antwort.

MCP-Artikelserie:

- Umfassende Analyse des MCP-Servers: Die Drehscheibe für Kontext und Tool-Kommunikation im Zeitalter der KI-Agenten

- Welche Kernprobleme löst der MCP-Server? Warum AI-Agents ihn brauchen

- MCP Server Architektur und Funktionsweise: Vom Protokoll zum Ausführungsfluss

- MCP Server Praxisleitfaden: Aufbau, Test und Bereitstellung von 0 auf 1

- MCP Server: Bewertung von Anwendungsszenarien und Leitfaden zur Technischen Auswahl

Über den Autor

Dieser Inhalt wurde vom NavGood Content Editorial Team zusammengestellt und veröffentlicht. NavGood ist eine Plattform, die sich auf KI-Tools und das KI-Anwendungsökosystem konzentriert und langfristige Beobachtungen zu AI-Agents, automatisierten Workflows sowie der Entwicklung und praktischen Umsetzung generativer KI-Technologie bietet.

Haftungsausschluss: Dieser Artikel gibt das persönliche Verständnis und die praktischen Erfahrungen des Autors wieder. Er stellt weder die offizielle Position eines Frameworks, einer Organisation oder eines Unternehmens dar, noch stellt er eine kommerzielle, finanzielle oder Investitionsberatung dar. Alle Informationen basieren auf öffentlichen Quellen und der unabhängigen Recherche des Autors.

Referenzen:

[1]: https://modelcontextprotocol.io/docs/learn/server-concepts "Understanding MCP servers - Model Context Protocol"

[2]: https://modelcontextprotocol.io/docs/learn/architecture "Architecture overview - Model Context Protocol"

[3]: https://cloud.google.com/blog/products/ai-machine-learning/announcing-official-mcp-support-for-google-services "Announcing Model Context Protocol (MCP) support for Google services"

[4]: https://developer.pingidentity.com/identity-for-ai/agents/idai-what-is-mcp.html "What is Model Context Protocol (MCP)?"