Robots.txt Generator

Übersicht von Robots.txt Generator

Robots.txt Generator: Die perfekte robots.txt-Datei erstellen

Was ist eine robots.txt-Datei?

Eine robots.txt-Datei ist eine Textdatei, die Suchmaschinen-Crawlern mitteilt, welche Seiten oder Dateien der Crawler von Ihrer Website anfordern darf oder nicht. Sie ist wichtig für die Suchmaschinenoptimierung (SEO), da sie Ihnen hilft zu kontrollieren, welche Teile Ihrer Website indexiert werden, und verhindert, dass Crawler auf sensible oder doppelte Inhalte zugreifen.

Wie funktioniert der Robots.txt Generator?

Dieses kostenlose Robots.txt Generator- und Validierungstool hilft Webmastern, SEO-Experten und Marketern, diese erforderliche Datei schnell und einfach zu erstellen. Sie können die Datei anpassen, indem Sie Direktiven (Crawling zulassen oder verbieten), den Pfad (bestimmte Seiten und Dateien) und die Bots einrichten, die den Direktiven folgen sollen. Oder Sie wählen eine vorgefertigte robots.txt-Vorlage mit einer Reihe der gängigsten allgemeinen und CMS-Direktiven. Sie können der Datei auch eine Sitemap hinzufügen.

Hauptmerkmale:

- Standardkonfigurationen:

- Allen Robotern den Zugriff auf die gesamte Website erlauben.

- Allen Robotern den Zugriff auf die gesamte Website verbieten.

- Ein bestimmtes Verzeichnis oder eine bestimmte Datei blockieren.

- Nur einem bestimmten Roboter (z. B. Googlebot) den Zugriff erlauben und alle anderen blockieren.

- Bestimmte URL-Parameter blockieren.

- Das Crawlen eines bestimmten Verzeichnisses erlauben und alles andere blockieren.

- Bilder aus einem bestimmten Verzeichnis blockieren.

- Den Zugriff auf CSS- und JS-Dateien blockieren.

- CMS-Vorlagen: Vorgefertigte robots.txt-Vorlagen für beliebte CMS-Plattformen, darunter:

- WordPress

- Shopify

- Magento

- Drupal

- Joomla

- PrestaShop

- Wix

- BigCommerce

- Squarespace

- Weebly

- AI Bot Blocking: Optionale Konfigurationen zum Blockieren oder Zulassen bestimmter AI Bots, wie zum Beispiel:

- GPTBot

- ChatGPT-User

- Google-Extended

- PerplexityBot

- Amazonbot

- ClaudeBot

- Omgilibot

- FacebookBot

- Applebot

- und viele mehr.

- Sitemap-Integration: Option zum Hinzufügen Ihrer Sitemap-URL zur robots.txt-Datei.

So verwenden Sie den Robots.txt Generator:

- Beginnen Sie mit einer Standardkonfiguration: Wählen Sie eine Basiskonfiguration, die Ihren Anforderungen entspricht. Zu den Optionen gehören das Zulassen aller Roboter, das Blockieren aller Roboter oder das Blockieren bestimmter Verzeichnisse oder Dateien.

- Direktiven anpassen: Richten Sie Direktiven ein, um das Crawlen zuzulassen oder zu verbieten, Pfade anzugeben (bestimmte Seiten und Dateien) und die Bots zu identifizieren, die den Direktiven folgen sollen.

- Wählen Sie eine Vorlage aus: Wählen Sie eine vorgefertigte robots.txt-Vorlage für gängige CMS-Plattformen.

- Fügen Sie eine Sitemap hinzu: Fügen Sie Ihre Sitemap-URL hinzu, damit Bots Ihre Website-Inhalte effizienter crawlen können.

- Herunterladen und Implementieren: Laden Sie die generierte robots.txt-Datei herunter und fügen Sie sie dem Stammordner Ihrer Website hinzu.

Wie füge ich die generierte robots.txt-Datei zu meiner Website hinzu?

Suchmaschinen und andere Crawling-Bots suchen nach einer robots.txt-Datei im Hauptverzeichnis Ihrer Website. Nachdem Sie die robots.txt-Datei generiert haben, fügen Sie sie dem Stammordner Ihrer Website hinzu, der unter https://yoursite.com/robots.txt zu finden ist.

Die Methode zum Hinzufügen einer robots.txt-Datei hängt vom verwendeten Server und CMS ab. Wenn Sie nicht auf das Stammverzeichnis zugreifen können, wenden Sie sich an Ihren Webhosting-Provider.

Vorteile der Verwendung des Robots.txt Generators:

- SEO-Optimierung: Steuern Sie, welche Teile Ihrer Website von Suchmaschinen indexiert werden, und verbessern Sie so die SEO-Leistung Ihrer Website.

- Anpassung: Passen Sie die robots.txt-Datei mit verschiedenen Direktiven und Vorlagen an Ihre spezifischen Bedürfnisse an.

- AI Bot Kontrolle: Blockieren oder erlauben Sie bestimmten AI Bots, Ihre Website zu crawlen.

- Einfache Sitemap-Integration: Fügen Sie Ihre Sitemap-URL hinzu, damit Bots Ihre Website-Inhalte effizient crawlen können.

- Open-Source-Beitrag: Beteiligen Sie sich am Projekt auf GitHub, um neue Funktionen hinzuzufügen, Fehler zu beheben oder bestehenden Code zu verbessern.

Beitrag zum Projekt:

Dies ist ein Open-Source-Projekt, und jeder ist herzlich eingeladen, teilzunehmen. Sie können zu diesem Projekt beitragen, indem Sie neue Funktionen hinzufügen, Fehler beheben oder den bestehenden Code verbessern, indem Sie einen Pull Request erstellen oder ein Problem in unserem GitHub repository melden.

FAQs

Wie übermittle ich eine robots.txt-Datei an Suchmaschinen?

Sie müssen keine robots.txt-Datei an Suchmaschinen übermitteln. Crawler suchen nach einer robots.txt-Datei, bevor sie eine Website crawlen. Wenn sie eine finden, lesen sie diese zuerst, bevor sie Ihre Website scannen.

Wenn Sie Änderungen an Ihrer robots.txt-Datei vornehmen und Google benachrichtigen möchten, können Sie sie an die Google Search Console senden. Verwenden Sie den Robots.txt Tester, um die Textdatei einzufügen und auf Senden zu klicken.

Beste Alternativwerkzeuge zu "Robots.txt Generator"

Firecrawl ist die führende Web-Crawling-, Scraping- und Such-API für KI-Anwendungen. Sie verwandelt Websites in saubere, strukturierte, LLM-bereite Daten im großen Maßstab und versorgt KI-Agenten mit zuverlässiger Web-Extraktion ohne Proxys oder Kopfschmerzen.

Rush Analytics: SEO-Plattform mit Rank Tracking, Keyword-Recherche, Site-Audit und PBN-Tools. Überwachen, entdecken und optimieren Sie für ein besseres Ranking.

Flexbe.AI ist ein KI-gestützter Website-Builder, der Websites in weniger als 60 Sekunden generiert. Es bietet KI-gestützte Marktforschung, Design und Inhaltserstellung sowie einen professionellen Editor und E-Commerce-Tools.

Skills.ai: No-Code-KI-Datenanalyse-Engine für Führungskräfte und Content-Ersteller. Generieren Sie sofort datengesteuerte Artikel und Präsentationen für Kundentreffen und soziale Medien.

Verwandeln Sie jede Website mit Skrape.ai in saubere, strukturierte Daten. Unsere KI-gestützte API extrahiert Daten in Ihrem bevorzugten Format für KI-Training.

ScrapeStorm ist ein KI-gestütztes visuelles Web Scraping Tool, mit dem Benutzer Daten von Websites ohne Programmierung extrahieren können. Es bietet intelligente Datenerkennung, mehrere Exportoptionen und unterstützt verschiedene Betriebssysteme.

FYRAN ist ein kostenloser KI-Chatbot-Builder, der digitale menschliche Antworten unterstützt. Erstellen Sie benutzerdefinierte Chatbots mit PDF-, Text-, MP3- und docx-Dateien. Einfache Integration über Website, API, JS oder HTML.

CoverLetterAI ist ein KI-gestütztes Tool, das personalisierte, ATS-optimierte Bewerbungsschreiben in Sekunden für nur 5 $ pro Schreiben erstellt. Laden Sie Ihren Lebenslauf und Stellenbeschreibung hoch, um maßgeschneiderte, professionelle Schreiben zu erhalten, die Bewerbern bei Vorstellungsgesprächen in verschiedenen Branchen helfen.

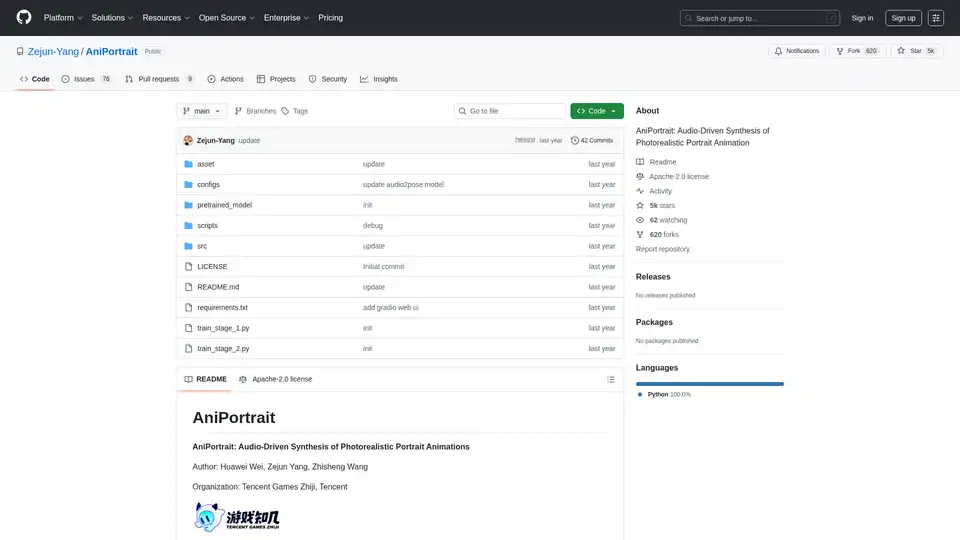

AniPortrait ist ein Open-Source-AI-Framework zur Generierung fotorealistischer Porträt-Animationen, angetrieben durch Audio- oder Videoeingaben. Es unterstützt Selbstgesteuerte, Gesichts-Reenactment- und Audio-gesteuerte Modi für hochqualitative Videosynthese.

Erkunden Sie Robotik und KI: Entdecken Sie Roboter, KI-Tools, Veranstaltungen und Jobs in Robotik und KI. Steigern Sie die Produktivität und Kreativität mit erstklassigen KI-Tools.

Verbessern Sie Telegram-Konversationen mit KI-Bots und -Agenten. Beschwören Sie sie, um Fragen zu beantworten, bei Aufgaben zu helfen oder Inhalte zu erstellen, ohne Telegram zu verlassen. Entdecken Sie AI Inline Assistant, Llama 3.1, DALL·E, Gemini und mehr!

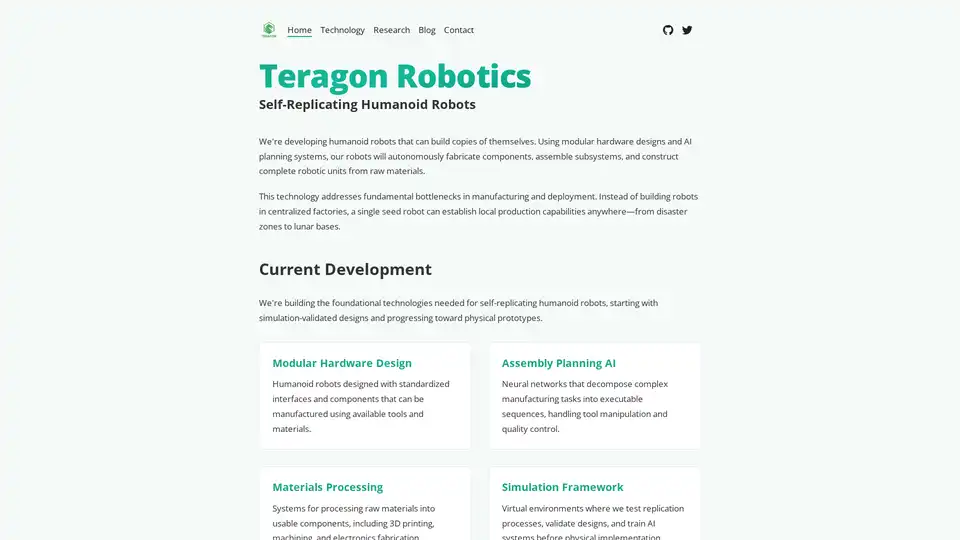

Teragon Robotics entwickelt selbstreplizierende humanoide Roboter unter Verwendung von KI-Planung und modularer Hardware. Diese Roboter fertigen autonom Komponenten und montieren neue Einheiten, wodurch Fertigungsengpässe in abgelegenen und Katastrophengebieten behoben werden.

Lucky Robots generiert unendlich viele synthetische Daten für das Training von Robotik-KI-Modellen. Trainieren Sie schneller und günstiger mit realistischen Simulationen. Iterieren, trainieren und testen Sie vor dem Einsatz in der realen Welt.

Starving Robots bietet benutzerdefinierten KI-Kunstdruck und personalisierte KI-Kunstdrucke. Erstellen Sie mit KI einzigartige Kunstposter und Leinwände.