APIPark

Übersicht von APIPark

APIPark: Das Open-Source LLM Gateway und API-Entwicklerportal

Was ist APIPark? APIPark ist ein Open-Source, All-in-One LLM-Gateway, das entwickelt wurde, um das Management von Large Language Models (LLMs) in Produktionsumgebungen zu optimieren. Es verbessert die Sicherheit, Stabilität und operative Integrität von Unternehmensanwendungen, die LLMs nutzen. Es bietet auch eine Lösung für den Aufbau von API-Portalen, die es Unternehmen ermöglicht, interne APIs sicher mit Partnern zu teilen und die Zusammenarbeit zu rationalisieren.

Hauptmerkmale und Vorteile

- Multi-LLM-Management: Verbinden Sie sich mit über 200 LLMs und wechseln Sie einfach zwischen ihnen, ohne bestehenden Code mithilfe der API-Signatur von OpenAI zu modifizieren.

- Kostenoptimierung: Optimieren Sie die LLM-Kosten mit einer detaillierten, visuellen Verwaltung von LLMs. Weisen Sie jedem Mandanten LLM-Traffic-Quoten zu und priorisieren Sie bestimmte LLMs.

- Load Balancer: Gewährleistet einen nahtlosen Wechsel zwischen LLMs, indem Anfragen effizient auf mehrere LLM-Instanzen verteilt werden, wodurch die Systemreaktionsfähigkeit und -zuverlässigkeit verbessert werden.

- Traffic Control: Konfigurieren Sie LLM-Traffic-Quoten für jeden Mandanten und priorisieren Sie bestimmte LLMs, um eine optimale Ressourcenzuweisung zu gewährleisten.

- Echtzeitüberwachung: Bietet Dashboards für Echtzeit-Einblicke in LLM-Interaktionen, die Ihnen helfen, die Leistung zu verstehen und zu optimieren.

- Semantisches Caching: Reduziert die Latenz von Upstream-LLM-Aufrufen, verbessert die Reaktionszeiten und reduziert die LLM-Ressourcenauslastung. (Kommt bald)

- Flexibles Prompt-Management: Bietet flexible Vorlagen zur einfachen Verwaltung und Modifizierung von Prompts, im Gegensatz zu traditionellen Methoden, die Prompts fest codieren.

- API-Konvertierung: Kombinieren Sie schnell AI-Modelle und Prompts zu neuen APIs und teilen Sie sie mit zusammenarbeitenden Entwicklern zur sofortigen Verwendung.

- Datenmaskierung: Schützt durch Sicherheitsvorkehrungen wie Datenmaskierung vor LLM-Angriffen, Missbrauch und internen sensiblen Datenlecks.

- API Open Portal: Optimierte Lösung für den Aufbau von API-Portalen, die es Unternehmen ermöglicht, interne APIs sicher mit Partnern zu teilen und die Zusammenarbeit zu rationalisieren.

- API Billing: Verfolgen Sie effizient die API-Nutzung jedes Benutzers und fördern Sie die API-Monetarisierung für Ihr Unternehmen.

- Zugriffskontrolle: Bietet End-to-End API-Zugriffsverwaltung und stellt sicher, dass Ihre APIs in Übereinstimmung mit den Unternehmensrichtlinien freigegeben und verwendet werden.

- AI Agent Integration: Erweitert Szenarien für AI-Anwendungen durch die Integration mit AI Agents.

Wie funktioniert APIPark?

APIPark bietet eine einheitliche API-Signatur (unter Verwendung der API-Signatur von OpenAI), die es Ihnen ermöglicht, mehrere LLMs gleichzeitig ohne Code-Änderung zu verbinden. Es bietet auch Load-Balancing-Lösungen, um die Verteilung von Anfragen auf mehrere LLM-Instanzen zu optimieren.

Wie man APIPark benutzt

Stellen Sie Ihr LLM Gateway & Developer Portal in 5 Minuten mit nur einer Befehlszeile bereit:

curl -sSO https://download.apipark.com/install/quick-start.sh; bash quick-start.sh

Warum ist APIPark wichtig?

APIPark adressiert die Herausforderungen der Verwaltung und Optimierung von LLMs in Produktionsumgebungen. Es bietet eine sichere, stabile und kosteneffektive Lösung für Unternehmen, die die Leistungsfähigkeit von LLMs nutzen möchten.

Für wen ist APIPark?

APIPark wurde entwickelt für:

- Unternehmen, die LLMs in der Produktion einsetzen.

- Entwickler, die AI-gestützte Anwendungen erstellen.

- Unternehmen, die interne APIs mit Partnern teilen möchten.

APIPark vs. andere Lösungen

APIPark bietet eine überlegene Leistung im Vergleich zu Kong und Nginx und bewältigt hohe Parallelität und große Anfragen mit geringer Latenz und hohem Durchsatz. Es bietet außerdem ein entwicklerorientiertes Design mit einfachen APIs, klarer Dokumentation und einer flexiblen Plugin-Architektur. Die nahtlose Integration in bestehende Tech-Stacks und starke Sicherheitsfunktionen machen APIPark zu einer überzeugenden Wahl.

F.A.Q

- Was ist ein LLM / AI Gateway?

- Welche Probleme löst APIPark?

- Warum sollte ich APIPark verwenden, um LLMs bereitzustellen?

Beste Alternativwerkzeuge zu "APIPark"

Sagify ist ein Open-Source-Python-Tool, das Machine-Learning-Pipelines auf AWS SageMaker vereinfacht und eine einheitliche LLM-Gateway für die nahtlose Integration proprietärer und Open-Source-Großsprachmodelle bietet.

LiteLLM ist ein LLM-Gateway, das den Modellzugriff, die Ausgabenverfolgung und Fallbacks für über 100 LLMs vereinfacht, alles im OpenAI-Format.

LM Studio ist eine benutzerfreundliche Desktop-Anwendung zum lokalen Ausführen und Herunterladen von Open-Source-Sprachmodellen (LLMs) wie LLaMa und Gemma auf Ihrem Computer. Es bietet eine In-App-Chat-Benutzeroberfläche und einen OpenAI-kompatiblen Server für die Offline-KI-Modellinteraktion, wodurch fortschrittliche KI ohne Programmierkenntnisse zugänglich wird.

Entdecken Sie AI Library, den umfassenden Katalog mit über 2150 neuronalen Netzen und KI-Tools für generative Inhaltscreation. Finden Sie die besten KI-Kunstmodelle, Tools für Text-zu-Bild, Videogenerierung und mehr, um Ihre kreativen Projekte zu fördern.

Dialoq AI ist eine einheitliche API-Plattform, die es Entwicklern ermöglicht, einfach auf über 200 KI-Modelle zuzugreifen und diese auszuführen, wodurch Entwicklungszeit und -kosten reduziert werden. Es bietet Funktionen wie Caching, Load Balancing und automatische Fallbacks für eine zuverlässige KI-App-Entwicklung.

Portkey stattet KI-Teams mit einem Produktionsstapel aus: Gateway, Observability, Schutzmaßnahmen, Governance und Prompt-Management in einer Plattform.

UsageGuard bietet eine einheitliche KI-Plattform für sicheren Zugriff auf LLMs von OpenAI, Anthropic und mehr, mit integrierten Schutzmaßnahmen, Kostoptimierung, Echtzeit-Überwachung und Enterprise-Sicherheit, um die KI-Entwicklung zu vereinfachen.

NextReady ist eine sofort einsatzbereite Next.js-Vorlage mit Prisma, TypeScript und shadcn/ui, die Entwicklern helfen soll, Webanwendungen schneller zu erstellen. Beinhaltet Authentifizierung, Zahlungen und Admin-Panel.

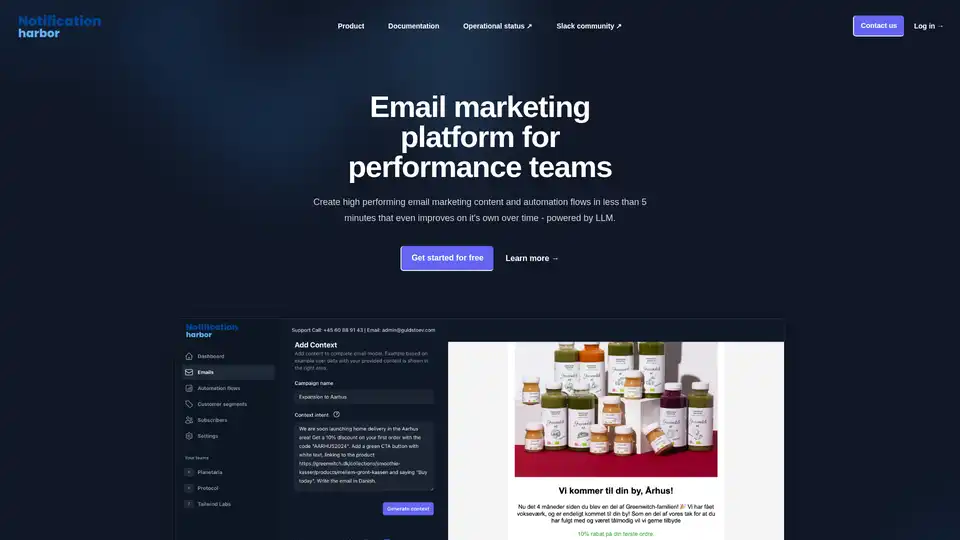

Notification Harbor ist eine KI-gestützte E-Mail-Marketing-Plattform, die LLM verwendet, um leistungsstarke E-Mail-Inhalte und Automatisierungsabläufe zu erstellen und E-Mail-Kampagnen mit Echtzeit-Personalisierung zu optimieren.

PromptMage ist ein Python-Framework, das die Entwicklung von LLM-Anwendungen vereinfacht. Es bietet Prompt-Tests, Versionskontrolle und eine automatisch generierte API für einfache Integration und Bereitstellung.

Notification Harbor ist eine KI-gestützte E-Mail-Marketing-Plattform, die LLM nutzt, um schnell optimierte Inhalte und Automatisierungsabläufe zu erstellen. Es bietet KI-generierte Vorlagen und Echtzeit-Personalisierung.

Alan AI ist eine Adaptive App AI-Plattform, die Self-Coding Intelligence für Unternehmensanwendungen ermöglicht. Stellen Sie Funktionen bei Bedarf mit einem Self-Coding-System bereit, reduzieren Sie den Entwickleraufwand und transformieren Sie die Benutzererfahrung.

xMem beschleunigt LLM-Apps mit Hybrid-Speicher und kombiniert langfristiges Wissen und Echtzeitkontext für intelligentere KI.

PromptLayer ist eine KI-Engineering-Plattform für Prompt-Management, -Bewertung und LLM-Observability. Arbeiten Sie mit Experten zusammen, überwachen Sie KI-Agenten und verbessern Sie die Prompt-Qualität mit leistungsstarken Tools.