PromptLayer

Übersicht von PromptLayer

PromptLayer: Die KI-Engineering-Workbench für Prompt-Management und LLM-Observability

Was ist PromptLayer?

PromptLayer ist eine Plattform, die entwickelt wurde, um den KI-Engineering-Prozess zu optimieren, insbesondere mit Fokus auf Prompt-Management, -Evaluierung und Large Language Model (LLM) Observability. Sie dient als zentrale Anlaufstelle für Teams, um ihre Prompts und Agents mithilfe robuster Evaluierungen, Tracing und Regressionssets zu versionieren, zu testen und zu überwachen.

Wie funktioniert PromptLayer?

PromptLayer vereinfacht das Prompt-Engineering durch die Ermöglichung von:

- Visuelle Bearbeitung: Bearbeiten, A/B-Testen und Bereitstellen von Prompts visuell, ohne auf Engineering-Redeploys warten zu müssen.

- Zusammenarbeit: Fördern Sie die Zusammenarbeit zwischen technischen und nicht-technischen Stakeholdern, indem Sie LLM Observability bereitstellen, die es Benutzern ermöglicht, Protokolle zu lesen, Edge Cases zu finden und Prompts zu verbessern.

- Evaluierung: Evaluieren Sie Prompts anhand der Nutzungshistorie, vergleichen Sie Modelle, planen Sie Regressionstests und erstellen Sie Batch Runs.

Hauptmerkmale und Vorteile:

- Prompt-Management: Organisieren Sie Prompts in einer Registry, verwalten Sie Versionen und stellen Sie Updates interaktiv bereit.

- Zusammenarbeit mit Experten: Ermöglichen Sie es Fachexperten, ohne Programmierkenntnisse zum Prompt-Engineering beizutragen.

- Iterative Evaluierung: Testen Sie Prompts vor der Bereitstellung rigoros mithilfe von historischen Backtests, Regressionstests und Modellvergleichen.

- Nutzungsüberwachung: Verstehen Sie, wie Ihre LLM-Anwendung verwendet wird, mit detaillierten Kosten-, Latenzstatistiken und benutzerspezifischen Protokollen.

Warum ist PromptLayer wichtig?

PromptLayer adressiert die Herausforderungen der Verwaltung und Optimierung von Prompts in KI-Anwendungen. Durch die Bereitstellung einer zentralen Plattform für Prompt-Engineering ermöglicht sie es Teams:

- Die Prompt-Qualität zu verbessern und Fehler zu reduzieren

- Entwicklungszyklen zu beschleunigen

- Die Zusammenarbeit zwischen technischen und nicht-technischen Stakeholdern zu ermöglichen

- Die LLM-Anwendungsleistung zu überwachen und zu optimieren

- Die Debugging-Zeit zu reduzieren

Für wen ist PromptLayer geeignet?

PromptLayer ist für eine breite Palette von Benutzern geeignet, darunter:

- KI-Ingenieure

- Prompt-Ingenieure

- Produktmanager

- Content-Autoren

- Fachexperten

Wie verwende ich PromptLayer?

- Melden Sie sich für ein kostenloses Konto an: Beginnen Sie mit PromptLayer, indem Sie ein kostenloses Konto auf deren Website erstellen.

- Integrieren Sie sich in Ihre LLM-Anwendung: Verbinden Sie PromptLayer mit Ihrer LLM-Anwendung über deren API oder SDK.

- Erstellen und verwalten Sie Prompts: Verwenden Sie die Prompt Registry, um Prompts zu erstellen, zu versionieren und bereitzustellen.

- Evaluieren Sie Prompts: Führen Sie Evaluierungen durch, um die Prompt-Leistung zu testen und Bereiche für Verbesserungen zu identifizieren.

- Überwachen Sie die Nutzung: Verfolgen Sie die LLM-Anwendungsnutzung und Leistungsmetriken.

Anwendungsfälle:

- Kundensupport-Automatisierung: Gorgias hat die Kundensupport-Automatisierung mit LLMs und PromptLayer um das 20-fache skaliert.

- Lehrplanentwicklung: Speak komprimierte Monate der Lehrplanentwicklung mit PromptLayer in eine einzige Woche.

- Personalisierte KI-Interaktionen: ParentLab erstellte personalisierte KI-Interaktionen mit PromptLayer 10x schneller.

- Debugging von LLM Agents: Ellipsis reduzierte die Debugging-Zeit mit PromptLayer um 75%.

Was Benutzer sagen:

- "Mit PromptLayer habe ich die Arbeit von vielen Monaten in einer einzigen Woche erledigt." - Seung Jae Cha, Product Lead bei Speak

- "PromptLayer ist ein Game-Changer für uns. Es hat unserem Content-Team ermöglicht, Prompts schnell zu iterieren, den richtigen Ton zu finden und Edge Cases zu adressieren, alles ohne unsere Ingenieure zu belasten." - John Gilmore, VP of Operations bei ParentLab

PromptLayer befähigt nicht-technische Teams, AI-Funktionen unabhängig zu iterieren, wodurch Engineering-Zeit und -Kosten gespart werden. Es hilft auch, LLM Agents effizient zu debuggen und die Debugging-Zeit deutlich zu reduzieren.

Zusammenfassend:

PromptLayer ist ein wertvolles Werkzeug für Teams, die ihren KI-Engineering-Prozess optimieren und die Leistung ihrer LLM-Anwendungen verbessern möchten. Seine Funktionen für Prompt-Management, Zusammenarbeit, Evaluierung und Monitoring machen es zu einer unverzichtbaren Plattform für alle, die mit AI arbeiten.

Beste Alternativwerkzeuge zu "PromptLayer"

Liefern Sie wirkungsvolle KI-gestützte Software in Minuten, ohne Kompromisse bei der Qualität einzugehen. Nahtlos versenden, überwachen, testen und iterieren, ohne den Fokus zu verlieren.

Athina ist eine kollaborative AI-Plattform, die Teams dabei hilft, LLM-basierte Funktionen 10-mal schneller zu entwickeln, zu testen und zu überwachen. Mit Tools für Prompt-Management, Evaluierungen und Observability gewährleistet sie Datenschutz und unterstützt benutzerdefinierte Modelle.

UsageGuard bietet eine einheitliche KI-Plattform für sicheren Zugriff auf LLMs von OpenAI, Anthropic und mehr, mit integrierten Schutzmaßnahmen, Kostoptimierung, Echtzeit-Überwachung und Enterprise-Sicherheit, um die KI-Entwicklung zu vereinfachen.

Maxim AI ist eine End-to-End-Bewertungs- und Observability-Plattform, die Teams dabei unterstützt, KI-Agenten zuverlässig und 5-mal schneller bereitzustellen, mit umfassenden Test-, Überwachungs- und Qualitätssicherungswerkzeugen.

Lunary ist eine Open-Source-LLM-Engineering-Plattform, die Observability, Prompt-Management und Analysen für die Erstellung zuverlässiger KI-Anwendungen bietet. Es bietet Tools für das Debugging, die Leistungsverfolgung und die Gewährleistung der Datensicherheit.

Latitude ist eine Open-Source-Plattform für Prompt-Engineering, die es Fachexperten ermöglicht, mit Ingenieuren zusammenzuarbeiten, um LLM-Funktionen in Produktionsqualität bereitzustellen. KI-Produkte mit Vertrauen erstellen, bewerten und bereitstellen.

Freeplay ist eine KI-Plattform, die Teams bei der Entwicklung, dem Testen und der Verbesserung von KI-Produkten durch Prompt-Management, Evaluierungen, Observability und Datenprüfungsworkflows unterstützt. Sie optimiert die KI-Entwicklung und gewährleistet eine hohe Produktqualität.

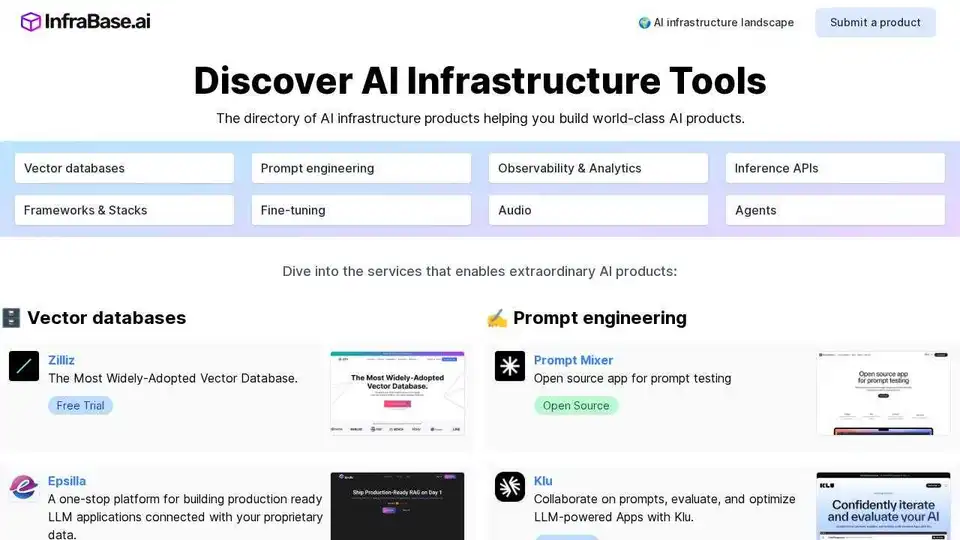

Infrabase.ai ist das Verzeichnis zur Entdeckung von KI-Infrastruktur-Tools und -Diensten. Finden Sie Vektor-Datenbanken, Prompt-Engineering-Tools, Inferenz-APIs und mehr, um erstklassige KI-Produkte zu entwickeln.

Parea AI ist eine KI-Experimentier- und Annotationsplattform, die Teams dabei unterstützt, LLM-Anwendungen zuverlässig auszuliefern. Sie bietet Funktionen für die Experimentverfolgung, Observability, Human Review und Prompt-Bereitstellung.

Trainkore: Eine Prompting- und RAG-Plattform zur Automatisierung von Prompts, Modellwechsel und Evaluierung. Sparen Sie 85 % der LLM-Kosten.

Teammately ist der KI-Agent für KI-Ingenieure, der jeden Schritt beim Aufbau zuverlässiger KI in großem Maßstab automatisiert und beschleunigt. Bauen Sie schneller KI in Produktionsqualität mit Prompt-Generierung, RAG und Observabilität.

Parea AI ist die ultimative Experimentier- und Human-Annotationsplattform für AI-Teams, die nahtlose LLM-Bewertung, Prompt-Tests und Produktionsbereitstellung für zuverlässige AI-Anwendungen ermöglicht.

Confident AI ist eine auf DeepEval basierende LLM-Evaluierungsplattform, die Ingenieurteams befähigt, die Leistung von LLM-Anwendungen zu testen, zu bewerten, zu sichern und zu verbessern. Sie bietet erstklassige Metriken, Schutzmaßnahmen und Beobachtbarkeit zur Optimierung von KI-Systemen und zum Aufdecken von Regressionen.

Future AGI ist eine einheitliche LLM-Observability- und KI-Agenten-Evaluierungsplattform, die Unternehmen dabei hilft, durch umfassende Test-, Evaluierungs- und Optimierungswerkzeuge 99% Genauigkeit in KI-Anwendungen zu erreichen.