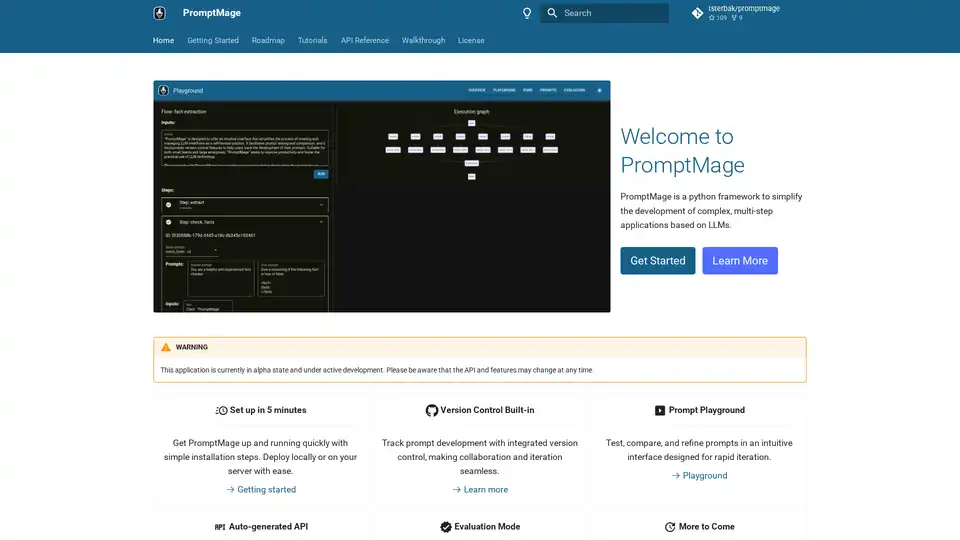

PromptMage

Übersicht von PromptMage

PromptMage: Die Entwicklung von LLM-Anwendungen vereinfachen

Was ist PromptMage? PromptMage ist ein Python-Framework, das entwickelt wurde, um die Entwicklung komplexer, mehrstufiger Anwendungen auf Basis von Large Language Models (LLMs) zu optimieren. Es bietet eine intuitive Schnittstelle zum Erstellen und Verwalten von LLM-Workflows und ist damit eine wertvolle, selbst gehostete Lösung für Entwickler, Forscher und Organisationen.

Hauptmerkmale und Vorteile:

- Vereinfachte LLM-Workflow-Verwaltung: PromptMage vereinfacht die Erstellung und Verwaltung von LLM-Workflows mit einer intuitiven Schnittstelle.

- Prompt-Tests und -Vergleich: Ermöglicht das Testen und Vergleichen von Prompts, sodass Benutzer Prompts für eine optimale Leistung verfeinern können.

- Versionskontrolle: Beinhaltet Versionskontrollfunktionen, mit denen Benutzer die Entwicklung ihrer Prompts verfolgen und effektiv zusammenarbeiten können.

- Automatisch generierte API: Nutzt eine FastAPI-basierte, automatisch erstellte API für einfache Integration und Bereitstellung.

- Evaluierungsmodus: Bewertet die Prompt-Leistung durch manuelle und automatische Tests und gewährleistet so die Zuverlässigkeit vor der Bereitstellung.

- Schnelle Iteration: Der Prompt-Spielplatz ermöglicht schnelles Testen, Vergleichen und Verfeinern von Prompts.

- Nahtlose Zusammenarbeit: Die integrierte Versionskontrolle ermöglicht eine nahtlose Zusammenarbeit und Iteration.

- Einfache Integration und Bereitstellung: Eine automatisch erstellte API vereinfacht die Integration und Bereitstellung.

Wie funktioniert PromptMage?

PromptMage stellt eine Reihe von Tools und Funktionen bereit, die den Prozess der Entwicklung und Verwaltung von LLM-basierten Anwendungen vereinfachen. Dazu gehören:

- Prompt Playground: Eine Web-Oberfläche zum Testen und Vergleichen von Prompts.

- Version Control: Ein System zur Verfolgung von Änderungen an Prompts im Laufe der Zeit.

- API Generation: Ein Tool zur automatischen Generierung von APIs aus Prompts.

- Evaluation Mode: Ein System zur Bewertung der Leistung von Prompts.

Kernfunktionalität:

- Prompt Playground Integration: Integrieren Sie den Prompt Playground nahtlos in Ihren Workflow für schnelle Iterationen.

- Prompts as First-Class Citizens: Behandeln Sie Prompts als vollwertige Bürger mit Versionskontrolle und Kollaborationsfunktionen.

- Manuelles und automatisches Testen: Validieren Sie Prompts durch manuelles und automatisches Testen.

- Einfaches Teilen: Teilen Sie Ergebnisse einfach mit Fachexperten und Stakeholdern.

- FastAPI API: Integrierte, automatisch erstellte API mit FastAPI für einfache Integration und Bereitstellung.

- Type Hinting: Verwenden Sie Type-Hinting für automatische Inferenz und Validierungsmagie.

Für wen ist PromptMage geeignet?

PromptMage ist geeignet für:

- Entwickler, die LLM-gestützte Anwendungen entwickeln

- Forscher, die mit LLMs experimentieren

- Organisationen, die ihre LLM-Workflows optimieren möchten

Anwendungsfälle

- product-review-research: Eine KI-Webanwendung, die mit PromptMage entwickelt wurde, um detaillierte Analysen für Produkte durch die Recherche vertrauenswürdiger Online-Bewertungen bereitzustellen.

Erste Schritte

Um mit PromptMage zu beginnen, können Sie diese Schritte befolgen:

- Installieren Sie PromptMage mit pip:

pip install promptmage - Erkunden Sie die Dokumentation und die Tutorials, um zu erfahren, wie Sie das Framework verwenden.

- Beginnen Sie mit der Entwicklung Ihrer LLM-Anwendung!

Warum PromptMage wählen?

PromptMage ist eine pragmatische Lösung, die die aktuelle Lücke im LLM-Workflow-Management schließt. Es unterstützt Entwickler, Forscher und Organisationen, indem es die LLM-Technologie zugänglicher und verwaltbarer macht und so die nächste Welle von KI-Innovationen unterstützt.

Durch die Verwendung von PromptMage können Sie:

- Die Produktivität steigern

- Die Qualität Ihrer LLM-Anwendungen verbessern

- Die Zusammenarbeit erleichtern

- Die Innovation beschleunigen

Beitrag zu PromptMage leisten

Das PromptMage-Projekt freut sich über Beiträge aus der Community. Wenn Sie daran interessiert sind, PromptMage zu verbessern, können Sie auf folgende Weise beitragen:

- Bugs melden: Senden Sie ein Problem in unserem Repository und geben Sie eine detaillierte Beschreibung des Problems sowie die Schritte zur Reproduktion an.

- Dokumentation verbessern: Wenn Sie Fehler finden oder Vorschläge zur Verbesserung der Dokumentation haben, reichen Sie bitte ein Problem oder einen Pull-Request ein.

- Bugs beheben: Sehen Sie sich unsere Liste der offenen Probleme an und senden Sie einen Pull-Request, um alle gefundenen Fehler zu beheben.

- Funktionsanfragen: Haben Sie Ideen, wie PromptMage verbessert werden kann? Wir würden uns freuen, von Ihnen zu hören! Bitte reichen Sie ein Problem ein und beschreiben Sie Ihre Vorschläge detailliert.

- Pull-Requests: Beiträge über Pull-Requests werden sehr geschätzt. Bitte stellen Sie sicher, dass Ihr Code den Codierungsstandards des Projekts entspricht, und reichen Sie einen Pull-Request mit einer klaren Beschreibung Ihrer Änderungen ein.

Für weitere Informationen oder Anfragen können Sie sich an die Projektverantwortlichen unter promptmage@tobiassterbak.com wenden.

Beste Alternativwerkzeuge zu "PromptMage"

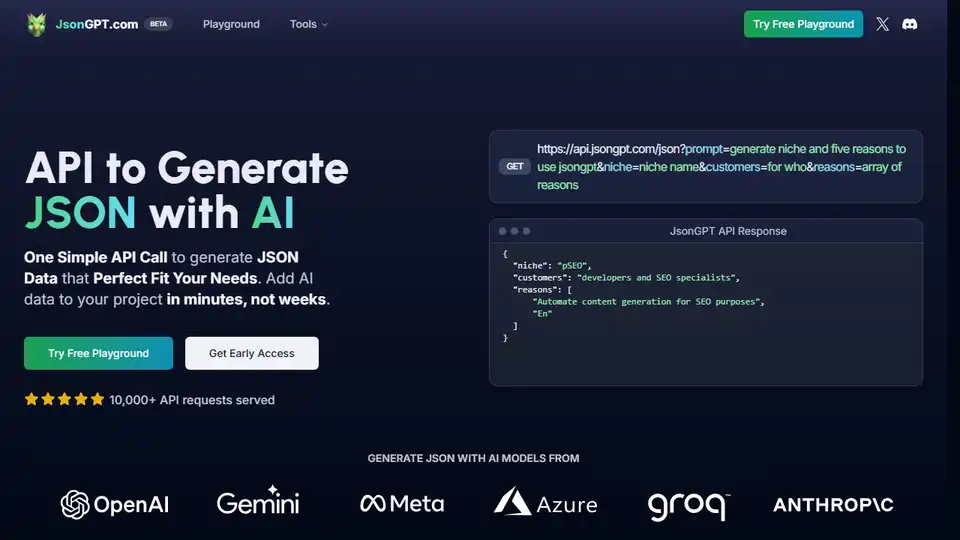

JsonGPT ist eine KI-API, die die JSON-Datengenerierung mit OpenAI vereinfacht. Es bietet Funktionen wie JSON-Validierung, Caching und Streaming, um die Entwicklung zu beschleunigen und Kosten zu senken.

Confident AI: DeepEval LLM-Evaluierungsplattform zum Testen, Benchmarking und zur Verbesserung der Leistung von LLM-Anwendungen.

UpTrain ist eine Full-Stack-LLMOps-Plattform, die Tools der Enterprise-Klasse zur Bewertung, zum Experimentieren, Überwachen und Testen von LLM-Anwendungen bereitstellt. Hosten Sie in Ihrer eigenen sicheren Cloud-Umgebung und skalieren Sie KI zuverlässig.

BAML ist ein Open-Source-Toolkit zum Erstellen von TYP-sicheren und zuverlässigen KI-Anwendungen. Verwenden Sie BAML, um KI-Agenten mit Zuversicht zu definieren, zu testen und bereitzustellen. Perfekt für Entwickler, die eine hohe Zuverlässigkeit in ihren KI-Pipelines anstreben.

Agents-Flex ist ein einfaches und leichtgewichtiges LLM-Anwendungsentwicklungs-Framework, das in Java entwickelt wurde und LangChain ähnelt.

Verdant Forest bietet LLM-gestützte Softwarelösungen für Rapid Prototyping, Videogenerierung und Marketing-Automatisierung. Ermöglicht kostengünstige Innovation.

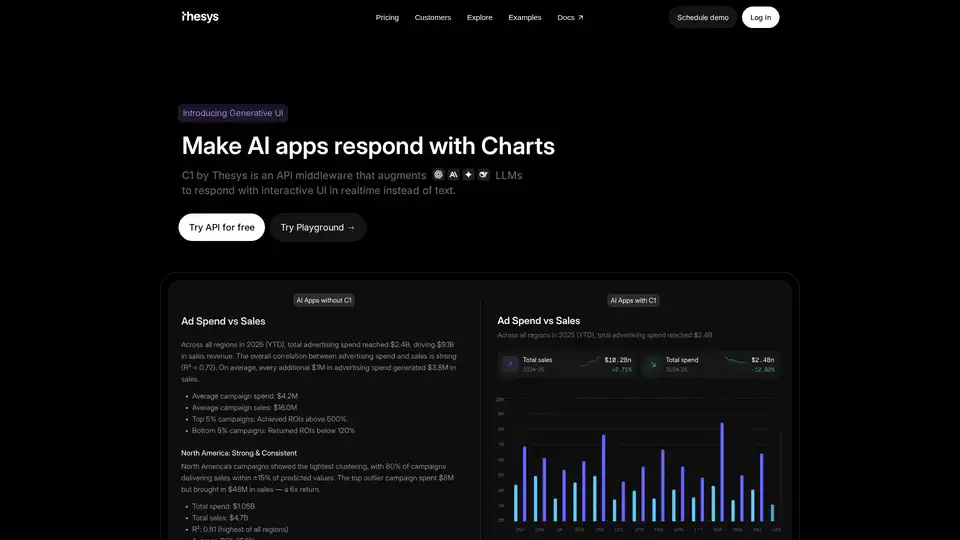

C1 von Thesys ist eine API-Middleware, die LLMs erweitert, um in Echtzeit mit interaktiven UIs anstelle von Text zu antworten und die Antworten Ihres Modells mithilfe von React SDK in Live-Schnittstellen zu verwandeln.

Scoopika ist eine Open-Source-Plattform zum Erstellen multimodaler KI-Apps mit LLMs und KI-Agenten, mit Fehlerbehebung, Streaming und Datenvalidierung.

Appsmith ist eine Open-Source-Low-Code-Plattform, die es Entwicklern ermöglicht, schnell benutzerdefinierte KI-gestützte Anwendungen und interne Tools zu erstellen. Es verbindet sich mit verschiedenen Datenquellen und bietet die volle Kontrolle über die Anwendungsentwicklung.

Vergleichen Sie die KI-Modellpreise für ChatGPT, Claude, Gemini & mehr mit AI Models Pricing. Berechnen Sie die Kosten und finden Sie die kostengünstigste KI-Lösung für Ihre Anforderungen.

Velvet, übernommen von Arize, bot ein Entwickler-Gateway zur Analyse, Bewertung und Überwachung von KI-Funktionen. Arize ist eine einheitliche Plattform für KI-Bewertung und -Beobachtbarkeit, die zur Beschleunigung der KI-Entwicklung beiträgt.

Batteries Included ist eine selbstgehostete KI-Plattform, die die Bereitstellung von LLMs, Vektordatenbanken und Jupyter Notebooks vereinfacht. Erstellen Sie erstklassige KI-Anwendungen auf Ihrer Infrastruktur.

SQLPilot ist ein KI-gestützter SQL-Abfragegenerator, mit dem Sie mithilfe von natürlicher Sprache und Wissensdatenbankunterstützung genaue und optimierte SQL-Abfragen schreiben können. Unterstützt PostgreSQL und MySQL.

UBOS ist ein Geschäftsbetriebssystem für KI-Agenten und bietet eine Low-Code-Plattform zum Erstellen, Bereitstellen und Verwalten von KI-gesteuerten Anwendungen mit Multi-Agenten-Orchestrierung und Open-Source-Tools.