ChatLLaMA

Übersicht von ChatLLaMA

Was ist ChatLLaMA?

ChatLLaMA stellt einen bahnbrechenden Schritt in der zugänglichen KI-Technologie dar, konzipiert als persönlicher KI-Assistent, der durch LoRA (Low-Rank Adaptation)-Feinabstimmung auf LLaMA-Modellen angetrieben wird. Dieses Open-Source-Tool ermöglicht es Nutzern, personalisierte konversationelle KI direkt auf ihren eigenen GPUs auszuführen, ohne Cloud-Abhängigkeiten und mit gesteigerter Privatsphäre. Speziell auf dem hochwertigen HH-Datensatz von Anthropic trainiert, der sich auf hilfreiche und ehrliche Dialoge konzentriert, zeichnet sich ChatLLaMA durch die Modellierung nahtloser, natürlicher Gespräche zwischen Nutzern und KI-Assistenten aus. Ob Sie Entwickler sind, die mit lokalen KI-Setups experimentieren, oder Enthusiasten, die einen maßgeschneiderten Chatbot suchen – ChatLLaMA bringt fortschrittliche Fähigkeiten von Sprachmodellen direkt auf Ihren Desktop.

Derzeit in Versionen für 30B-, 13B- und 7B-LLaMA-Modelle verfügbar, unterstützt es Sequenzlängen bis zu 2048 Token, was es vielseitig für ausgedehnte Interaktionen macht. Das Tool umfasst eine benutzerfreundliche Desktop-GUI, die die Einrichtung und Nutzung für Nicht-Experten vereinfacht. Zu einem erschwinglichen Preis von nur 3 $, hat es über 2.011 Verkäufe und eine solide 4,8-Sterne-Bewertung von 127 Nutzern erzielt, wobei 92 % fünf Sterne vergeben haben. Nutzer loben seinen innovativen Ansatz, obwohl einige mitteilen, dass sie es noch nicht vollständig getestet haben – was die Aufregung um sein Potenzial unterstreicht.

Wie funktioniert ChatLLaMA?

Im Kern nutzt ChatLLaMA LoRA, eine effiziente Feinabstimmungsmethode, die vortrainierte große Sprachmodelle wie LLaMA anpasst, ohne massive Rechenressourcen zu benötigen. Statt das gesamte Modell neu zu trainieren, führt LoRA niedrigrangige Matrizen in die Gewichte des Modells ein und konzentriert Updates auf Schlüsselparameter. Dies ergibt einen leichten Adapter – die LoRA-Gewichte –, der auf Basis-LLaMA-Modelle geladen werden kann, um sie für konversationelle Aufgaben zu spezialisieren.

Der Trainingsprozess verwendet den HH-Datensatz (Helpful and Harmless) von Anthropic, eine Sammlung von Dialogbeispielen, die ethische, nützliche Antworten betonen. Dies stellt sicher, dass ChatLLaMA Antworten erzeugt, die nicht nur ansprechend, sondern auch sicher und kontextuell angemessen sind. Zum Beispiel simuliert es realistische Hin- und Her-Gespräche, sodass Interaktionen menschlicher wirken als bei generischen Chatbots.

Eine bevorstehende RLHF-Version (Reinforcement Learning from Human Feedback) verspricht eine noch bessere Ausrichtung auf Nutzerpräferenzen und potenziell verbesserte Antwortqualität durch menschlich bewertete Verfeinerungen. Um es auszuführen, laden Nutzer die LoRA-Gewichte für ihre gewählte Modellgröße herunter und integrieren sie in eine lokale LLaMA-Inferenz-Setup. Die Desktop-GUI vereinfacht dies: Starten Sie die Oberfläche, wählen Sie Ihr Modell aus, laden Sie die Gewichte und beginnen Sie mit dem Chatten – alles angetrieben von Ihrer GPU für niedrige Latenzzeiten.

Keine Grundmodell-Gewichte werden bereitgestellt, da ChatLLaMA für Forschungszwecke gedacht ist und voraussetzt, dass Nutzer Zugriff auf Basis-LLaMA-Modelle haben (die offen verfügbar sind). Dieses modulare Design ermöglicht Flexibilität; zum Beispiel können Sie mit verschiedenen Basis-Modellen experimentieren oder Datensätze für zukünftige Trainingsiterationen beitragen.

Wie verwendet man ChatLLaMA?

Der Einstieg in ChatLLaMA ist unkompliziert, besonders mit der Desktop-GUI. Hier eine schrittweise Anleitung:

Basis-Modell erwerben: Laden Sie die LLaMA-7B-, 13B- oder 30B-Modell-Gewichte von offiziellen Quellen wie Hugging Face herunter. Stellen Sie sicher, dass Ihr System eine kompatible GPU hat (NVIDIA empfohlen mit ausreichend VRAM – mindestens 8 GB für 7B, mehr für größere Modelle).

LoRA-Gewichte kaufen und herunterladen: Für 3 $ erhalten Sie die auf Ihre Modellgröße zugeschnittenen ChatLLaMA-LoRA-Gewichte. Diese sind in Standard- und 2048-Sequenz-Varianten für längere Kontexte verfügbar.

Desktop-GUI installieren: Die Open-Source-GUI wird als Teil des Pakets bereitgestellt. Installieren Sie Abhängigkeiten wie Python, PyTorch und kompatible LLaMA-Bibliotheken (z. B. llama.cpp für effiziente Inferenz). Führen Sie die GUI-Executable aus, um Ihre Umgebung einzurichten.

Laden und Starten: In der GUI weisen Sie auf Ihr Basis-Modell und die LoRA-Gewichte hin. Konfigurieren Sie Einstellungen wie Temperatur für die Kreativität der Antworten oder maximale Tokens für die Ausgabelänge. Starten Sie eine Chat-Sitzung, um den konversationellen Fluss zu testen.

Anpassen und Experimentieren: Geben Sie Prompts ein, um Dialoge zu simulieren. Für fortgeschrittene Nutzer: Passen Sie den LoRA-Adapter an oder integrieren Sie ihn mit Skripten für Automatisierung. Bei Einrichtungsproblemen bietet die aktive Discord-Community Echtzeit-Support.

Die GUI übernimmt viel der aufwendigen Arbeit, sodass es auch für Einsteiger in der KI-Bereitstellung zugänglich ist. Reaktionszeiten sind auf leistungsfähiger Hardware schnell, oft unter einer Sekunde pro Zug.

Warum ChatLLaMA wählen?

In einer von Cloud-basierten KI wie ChatGPT dominierten Landschaft hebt sich ChatLLaMA durch seinen Fokus auf lokale Ausführung hervor. Das bedeutet keine Abonnementgebühren, keine Daten an externe Server und volle Kontrolle über Ihre KI-Interaktionen – ideal für datenschutzbewusste Nutzer oder solche in Regionen mit begrenzter Internetverbindung. Sein LoRA-basierter Ansatz ist ressourcenschonend und ermöglicht feinabgestimmte Leistung ohne den Overhead eines vollständigen Modelltrainings, das Tausende an Rechenkosten verursachen kann.

Nutzerfeedback unterstreicht seinen Wert: Ein Rezensent nannte es „süß“ für das Konzept, während andere das Potenzial für benutzerdefinierte Assistenten schätzen. Mit hohen Bewertungen und starken Verkäufen ist klar, dass ChatLLaMA in der KI-Community Anklang findet. Zudem lädt der Open-Source-Geist des Projekts zur Zusammenarbeit ein; Entwickler werden ermutigt, Code beizutragen, und GPU-Ressourcen werden im Austausch über Discord angeboten.

Im Vergleich zu Alternativen gibt ChatLLaMA durch den Fokus auf Dialog-Datensätze wie HH einen Vorteil in der natürlichen Konversationsmodellierung. Es ist nicht nur ein Chatbot – es ist eine Grundlage für die Erstellung spezialisierter Assistenten, von Recherche-Tools bis zu persönlichen Produktivitätshelfern.

Für wen ist ChatLLaMA?

ChatLLaMA ist für ein vielfältiges Publikum zugeschnitten:

KI-Forscher und Entwickler: Perfekt zum Experimentieren mit LoRA-Feinabstimmung, RLHF-Integration oder Datensatz-Beiträgen. Wenn Sie Open-Source-KI-Apps bauen, bietet dieses Tool eine fertige konversationelle Basis.

Technik-Enthusiasten und Hobbyisten: Führen Sie Ihren eigenen KI-Begleiter offline aus und passen Sie ihn für Spaß oder Lernen an. Kein fortgeschrittenes Codieren erforderlich dank der GUI.

Datenschutz-orientierte Nutzer: Unternehmen oder Individuen, die Cloud-KI misstrauisch gegenüberstehen, können sichere, lokale Instanzen für interne Chats oder Prototyping einsetzen.

Pädagogen und Studenten: Nutzen Sie es, um große Sprachmodelle hands-on zu erkunden und ethische KI-Dialoge ohne Infrastrukturbarrieren zu simulieren.

Es eignet sich besonders für diejenigen mit Mittelklasse-GPUs, da das 7B-Modell auf bescheidener Hardware läuft. Allerdings ist es forschungsorientiert, erwarten Sie also, Basis-Modelle selbst zu handhaben – nicht plug-and-play für absolute Anfänger.

Beste Wege, das Potenzial von ChatLLaMA zu maximieren

Um das Beste aus ChatLLaMA herauszuholen:

Hochwertige Datensätze integrieren: Teilen Sie Dialog-Datensätze mit dem Team für community-getriebene Verbesserungen. Das könnte zu spezialisierten Versionen führen, wie branchenspezifischen Assistenten.

Mit anderen Tools kombinieren: Koppeln Sie es mit Sprachoberflächen für hybride Setups oder einbetten Sie es in Apps über APIs für breitere Anwendungen.

Leistung überwachen: Verfolgen Sie Metriken wie Kohärenz und Relevanz in Gesprächen. Das bevorstehende RLHF-Update wird diese wahrscheinlich weiter steigern.

Der Community beitreten: Discord ist voller Tipps, von Optimierungsanpassungen bis zu Kollaborationsmöglichkeiten. Entwickler: Kontaktieren Sie @devinschumacher für GPU-unterstützte Projekte.

Zusammenfassend demokratisiert ChatLLaMA fortschrittliche KI, indem es LoRA-angetriebene, lokale konversationelle Modelle zugänglich und anpassbar macht. Ob Sie persönliche KI revolutionieren oder zu Open-Source-Innovationen beitragen – dieses Tool bietet immensen praktischen Wert in der sich entwickelnden Welt großer Sprachmodelle. Tauchen Sie ein und bleiben Sie funky, während Sie seine Fähigkeiten erkunden.

Beste Alternativwerkzeuge zu "ChatLLaMA"

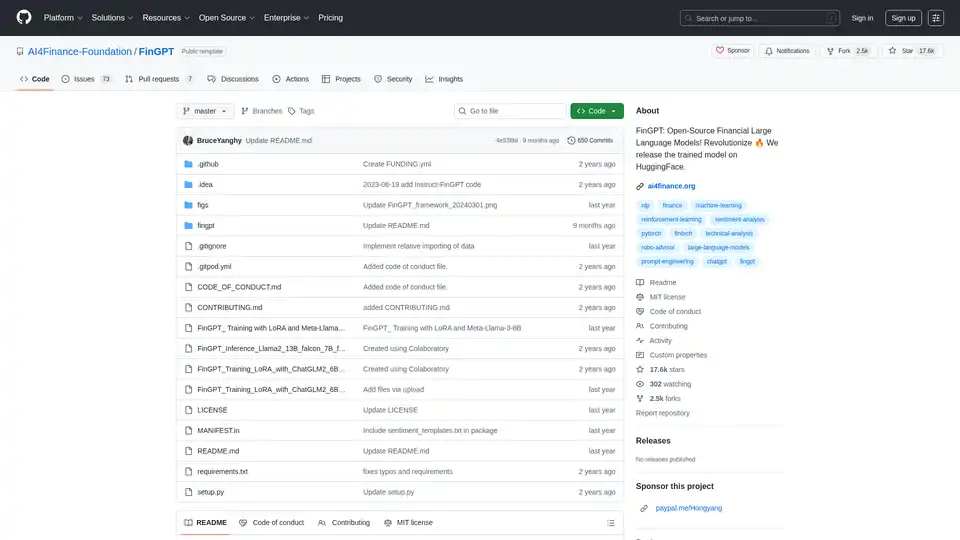

FinGPT: Ein Open-Source-Finanz-Large-Language-Modell zur Demokratisierung von Finanzdaten, Sentimentanalyse und Prognose. Schnelle Feinabstimmung für zeitnahe Markteinblicke.

Scade.pro ist eine umfassende No-Code AI-Plattform, die Benutzern ermöglicht, AI-Funktionen zu erstellen, Workflows zu automatisieren und über 1500 AI-Modelle ohne technische Kenntnisse zu integrieren.

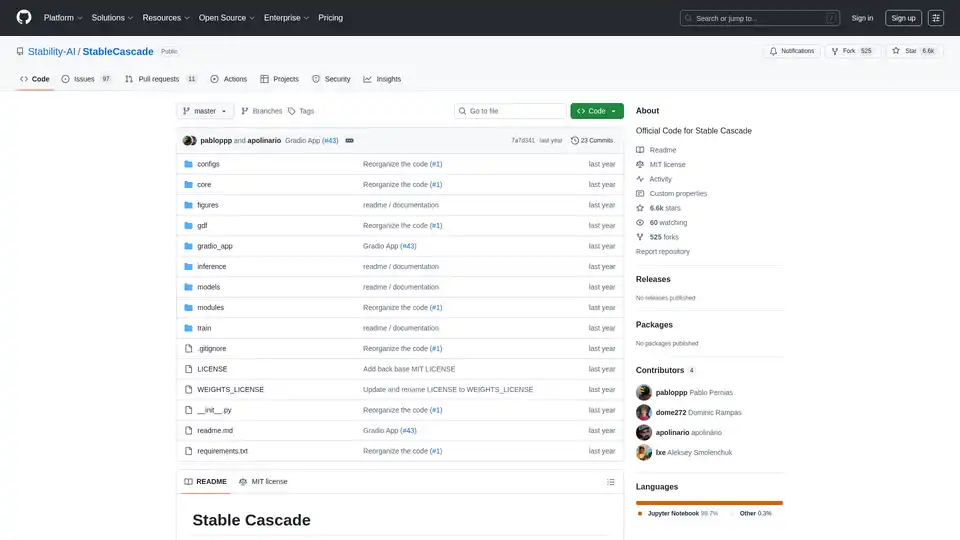

Stable Cascade ist ein effizientes Text-zu-Bild-Modell, das auf der Würstchen-Architektur basiert und eine schnelle Inferenz und ein kostengünstiges Training bietet. Entdecken Sie seine Fähigkeiten für die Bilderzeugung und mehr.

Entdecken Sie Pykaso AI, die ultimative Plattform zum Erstellen ultra-realistischer AI-Bilder, Videos und benutzerdefinierter Charaktere. Trainieren Sie LoRa-Modelle, verbessern Sie Hauttexturen und generieren Sie virales Content mühelos für Social-Media-Erfolg.

Erfahren Sie, wie Sie Stable Diffusion mit der Web-Oberfläche von AUTOMATIC1111 auf Google Colab ausführen. Installieren Sie Modelle, LoRAs und ControlNet für schnelle KI-Bildgenerierung ohne lokale Hardware.

xTuring ist eine Open-Source-Bibliothek, die Benutzern ermöglicht, Large Language Models (LLMs) effizient anzupassen und zu optimieren, mit Fokus auf Einfachheit, Ressourcenoptimierung und Flexibilität für die KI-Personalisierung.

Nano Banana (Gemini 2.5 Flash Image) erhält perfekte Charakterkonsistenz und ermöglicht die Bearbeitung von Bildern mit Textprompts in höherer Geschwindigkeit.

Mit der Stable Diffusion API können Sie mühelos KI-Bilder generieren und feinabstimmen. Greifen Sie auf Text-zu-Bild-, Bild-zu-Bild- und Inpainting-APIs zu, ohne teure GPUs zu benötigen.

Mit Replicate können Sie Open-Source-Modelle für maschinelles Lernen mit einer Cloud-API ausführen und optimieren. Erstellen und skalieren Sie KI-Produkte mit Leichtigkeit.

Predibase ist eine Entwicklerplattform zum Feinabstimmen und Bereitstellen von Open-Source-LLMs. Erzielen Sie unübertroffene Genauigkeit und Geschwindigkeit mit einer End-to-End-Trainings- und Bereitstellungsinfrastruktur mit Verstärkungsfeinabstimmung.

Verwandeln Sie Text mit dem Flux AI Image Generator in beeindruckende Bilder. Entdecken Sie verschiedene Modelle wie Flux Pro und Flux Schnell, um kostenlos online hochwertige KI-Kunst zu erstellen.

Mit Image Pipeline können Sie mit den neuesten Technologien wie Stable Diffusion, ControlNets und benutzerdefinierten Modellen KI-Visuals in Produktionsqualität mit maximaler Kontrolle erstellen. Konzentrieren Sie sich auf die Entwicklung von KI-Produkten ohne GPU-Wartung.

Erstellen Sie personalisierte visuelle Geschichten mit TheFluxTrain. Trainieren Sie KI mit Ihren eigenen Bildern, um konsistente Charaktere zu generieren und sie in fesselnde visuelle Erzählungen, KI-Influencer und Produktmodelle zu verwandeln.

Fireworks AI bietet blitzschnelle Inferenz für generative KI unter Verwendung modernster Open-Source-Modelle. Optimieren und stellen Sie Ihre eigenen Modelle ohne zusätzliche Kosten bereit. Skalieren Sie KI-Workloads global.