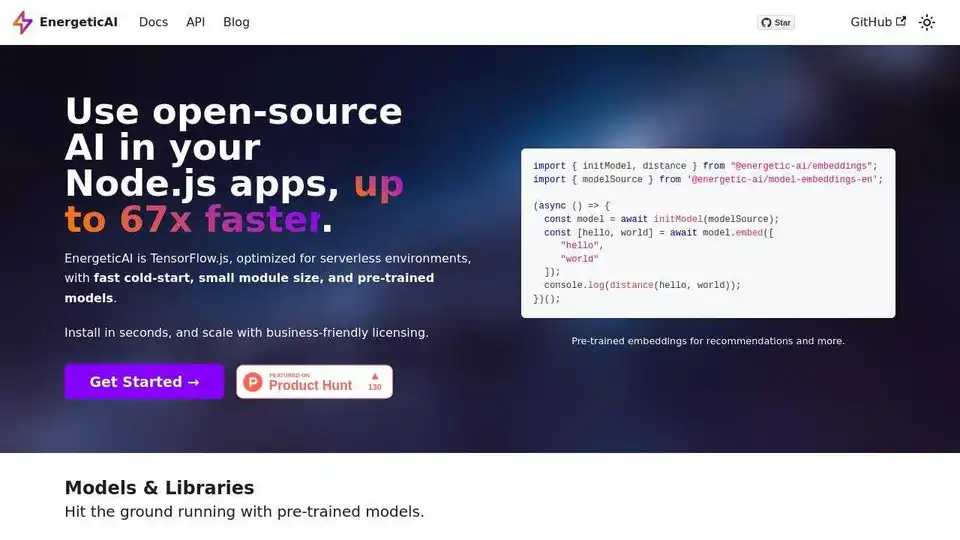

EnergeticAI

Übersicht von EnergeticAI

EnergeticAI: Verbessere deine Node.js Apps mit Open-Source-KI

Was ist EnergeticAI?

EnergeticAI ist eine Open-Source-Bibliothek, die entwickelt wurde, um die Leistungsfähigkeit der KI mit beispielloser Geschwindigkeit und Effizienz in deine Node.js-Anwendungen zu bringen. EnergeticAI baut auf TensorFlow.js auf und ist speziell für serverlose Umgebungen optimiert, wobei die üblichen Herausforderungen von Kaltstarts und Modulgröße berücksichtigt werden.

Wie funktioniert EnergeticAI?

EnergeticAI erzielt seine Leistungssteigerungen durch mehrere wichtige Optimierungen:

- Optimiertes TensorFlow.js: Es basiert auf TensorFlow.js, ist aber feinabgestimmt für serverlose Umgebungen.

- Schneller Kaltstart: EnergeticAI reduziert die Kaltstartzeiten erheblich, was ein kritischer Faktor für die Leistung serverloser Funktionen ist.

- Kleine Modulgröße: Durch die Minimierung der Modulgröße stellt EnergeticAI schnellere Bereitstellungen und einen geringeren Ressourcenverbrauch sicher.

- Vorab trainierte Modelle: Beginne sofort mit der Verwendung von sofort verfügbaren, vorab trainierten Modellen für gängige KI-Aufgaben.

Hauptmerkmale und Vorteile:

- Bis zu 67x schneller: Erlebe deutliche Geschwindigkeitsverbesserungen im Vergleich zu Standard-TensorFlow.js-Implementierungen, insbesondere in serverlosen Funktionen.

- Vorab trainierte Embeddings: Nutze vorab trainierte englische Embeddings zum Erstellen von Empfehlungssystemen und semantischen Suchanwendungen.

- Textklassifizierer: Klassifiziere Text mit minimalen Trainingsbeispielen in verschiedene Kategorien.

- Geschäftsfreundliche Lizenzierung: EnergeticAI ist unter Apache 2.0 lizenziert und bietet Flexibilität für die kommerzielle Nutzung.

- Einfache Installation: Installiere EnergeticAI schnell mit npm:

npm install @energetic-ai/core.

Anwendungsfälle:

- Empfehlungssysteme: Generiere Produkt- oder Inhaltsempfehlungen basierend auf Benutzerpräferenzen.

- Semantische Suche: Implementiere eine Suchfunktion, die die Bedeutung hinter den Suchanfragen versteht.

- Textklassifizierung: Automatisiere die Kategorisierung von Textdaten für verschiedene Anwendungen.

So geht's los:

- Installation: Installiere das Core-Paket mit npm:

npm install @energetic-ai/core - Module importieren: Importiere die notwendigen Module in deinen Node.js-Code.

import { initModel, distance } from "@energetic-ai/embeddings";

import { modelSource } from '@energetic-ai/model-embeddings-en';

(async () => {

const model = await initModel(modelSource);

const [hello, world] = await model.embed([

"hello",

"world"

]);

console.log(distance(hello, world));

})();

Performance-Benchmarks:

EnergeticAI zeigt im Vergleich zu Tensorflow.js eine beeindruckende Leistung in Bezug auf Kaltstartgeschwindigkeit, Warmstartgeschwindigkeit und Modulgröße. Dies macht es besonders geeignet für serverlose Umgebungen, in denen Kaltstarts die Reaktionsfähigkeit der Anwendung beeinträchtigen können. Die Inferenzgeschwindigkeit in serverlosen Funktionen wird von der Kaltstartgeschwindigkeit dominiert. Der Benchmark initialisiert das Modell und berechnet ein Embedding für einen 5-Satz-Absatz auf einem M1 Max Macbook Pro.

Für wen ist EnergeticAI gedacht?

EnergeticAI wurde für Node.js-Entwickler entwickelt, die KI-Funktionen in ihre Anwendungen integrieren möchten, ohne Leistung oder Benutzerfreundlichkeit zu beeinträchtigen. Es ist besonders wertvoll für Projekte, die in serverlosen Umgebungen bereitgestellt werden.

Warum ist EnergeticAI wichtig?

In serverlosen Umgebungen können Kaltstarts die Leistung von KI-gestützten Anwendungen erheblich beeinträchtigen. EnergeticAI behebt dieses Problem, indem es TensorFlow.js für serverlose Funktionen optimiert und so schnellere Reaktionszeiten und eine bessere Benutzererfahrung gewährleistet.

Mehr erfahren:

- Dokumentation: In der offiziellen Dokumentation findest du detaillierte Informationen zur Verwendung von EnergeticAI.

- GitHub: Erkunde den Quellcode und trage zum Projekt auf GitHub bei.

EnergeticAI ermöglicht es Entwicklern, intelligente Anwendungen mit Geschwindigkeit und Effizienz zu erstellen. Durch die Bewältigung der Herausforderungen von Kaltstarts und Modulgröße macht EnergeticAI KI für Node.js-Entwickler, die in serverlosen Umgebungen arbeiten, zugänglicher und praktischer.

KI-Programmierassistent Automatische Codevervollständigung KI-Code-Überprüfung und -Optimierung KI-gesteuerte Low-Code- und No-Code-Entwicklung

Beste Alternativwerkzeuge zu "EnergeticAI"

Vereinfachen Sie die KI-Bereitstellung mit Synexa. Führen Sie leistungsstarke KI-Modelle sofort mit nur einer Codezeile aus. Schnelle, stabile und entwicklerfreundliche Serverless-KI-API-Plattform.

Yugo vereinfacht die Integration von KI in Web-Dienste durch automatisierte API-Analyse, personalisierte Funktionsempfehlungen und Ein-Klick-Implementierung, wodurch Entwickler effizient fortschrittliche Anwendungen erstellen können.

Pipedream ist eine Low-Code-Integrationsplattform, um APIs, KI und Datenbanken zu verbinden und Workflows zu automatisieren. Erstellen und implementieren Sie KI-Agenten und Integrationen mit Leichtigkeit.

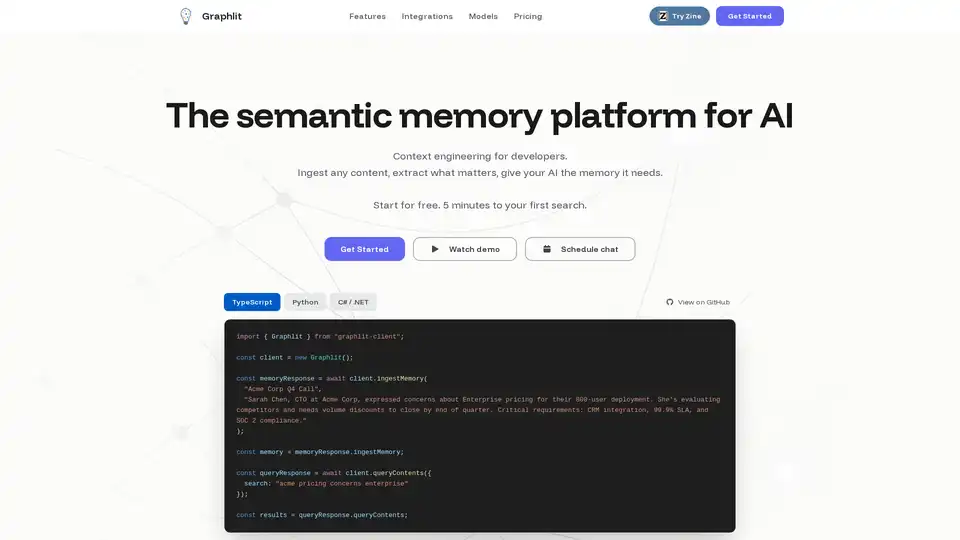

Graphlit ist eine semantische Speicherplattform für KI, die Content-Ingestion, semantische Suche und KI-gestützte Abrufe über eine einzige API bietet. Es hilft Entwicklern, KI-Speicher effizient aufzubauen und zu pflegen.