huntr

Übersicht von huntr

huntr: Die Bug-Bounty-Plattform für AI/ML-Sicherheit

Was ist huntr?

Huntr ist die weltweit erste Bug-Bounty-Plattform, die speziell für AI- und Machine Learning (ML)-Projekte entwickelt wurde. Sie dient als zentrale Anlaufstelle, an der Sicherheitsforscher Schwachstellen in AI/ML-Open-Source-Anwendungen, -Bibliotheken und Modelldateiformaten melden können, um die Sicherheit und Stabilität dieser kritischen Komponenten zu stärken. Durch die Bereitstellung einer strukturierten und incentivierten Umgebung für die Offenlegung von Schwachstellen spielt huntr eine wichtige Rolle im wachsenden Bereich der AI-Sicherheit.

Wie funktioniert huntr?

Huntr ermöglicht einen optimierten Prozess für die Meldung und Behebung von Schwachstellen:

- Offenlegung: Sicherheitsforscher identifizieren und reichen Schwachstellen über ein sicheres Formular auf der huntr-Plattform ein.

- Validierung: Das huntr-Team kontaktiert den Betreuer des betroffenen Projekts und gewährt ihm 31 Tage Zeit, um auf den Bericht zu antworten. Wenn keine Antwort eingeht, behebt huntr manuell hohe und kritische Berichte innerhalb von 14 Tagen.

- Belohnung: Wenn der Bericht entweder vom Betreuer oder von huntr validiert wird, erhält der Forscher eine Belohnung (Bounty) für seinen Beitrag.

- Veröffentlichung: Bei Open-Source-Projekten werden Schwachstellenberichte nach 90 Tagen veröffentlicht, damit die Betreuer Zeit haben, das Problem zu beheben. Die Betreuer können bei Bedarf Verlängerungen beantragen. Berichte zu Modelldateiformaten werden nicht öffentlich bekannt gegeben.

Warum ist huntr wichtig?

Da AI und ML zunehmend in verschiedene Aspekte unseres Lebens integriert werden, ist es von größter Bedeutung, die Sicherheit dieser Systeme zu gewährleisten. Huntr trägt diesem Bedarf Rechnung durch:

- Incentivierung der Schwachstellenentdeckung: Durch das Anbieten von Bounties ermutigt huntr Sicherheitsforscher, aktiv nach Schwachstellen in AI/ML-Projekten zu suchen und diese zu melden.

- Förderung der Zusammenarbeit: Huntr bietet eine Plattform für Forscher und Betreuer, um gemeinsam an der Behebung von Sicherheitsproblemen zu arbeiten.

- Verbesserung der AI/ML-Sicherheit: Durch die Identifizierung und Behebung von Schwachstellen trägt huntr zur allgemeinen Sicherheit und Stabilität von AI/ML-Systemen bei.

Für wen ist huntr?

Huntr ist für eine Vielzahl von Stakeholdern von Wert:

- Sicherheitsforscher: Eine Plattform, um Schwachstellen zu melden und Belohnungen zu verdienen, wodurch zur Sicherheit von AI/ML-Projekten beigetragen wird.

- AI/ML-Projektbetreuer: Eine Möglichkeit, Sicherheitsprobleme in ihren Projekten proaktiv zu identifizieren und zu beheben.

- Organisationen, die AI/ML verwenden: Erhöhtes Vertrauen in die Sicherheit der AI/ML-Komponenten, auf die sie sich verlassen.

Unterstützte AI/ML-Projekte:

Huntr unterstützt über 240 AI/ML-Programme, darunter beliebte Projekte wie:

- NVIDIA/nvidia-container-toolkit

- apache/spark

- huggingface/text-generation-inference

- intel/neural-compressor

- mongodb/mongo-python-driver

- huggingface/transformers

- pytorch/pytorch

- scikit-learn/scikit-learn

- keras-team/keras

- apache/airflow

- numpy/numpy

- microsoft/LightGBM

- onnx/onnx

- jupyter/jupyter

- mlflow/mlflow

- aws/aws-cli

- nltk/nltk

- kubeflow/kubeflow

- apache/arrow

- apache/tvm

- microsoft/onnxruntime

- deepmind/sonnet

- NVIDIA/TensorRT

- triton-inference-server/server

- huggingface/tokenizers

- Netflix/metaflow

- elastic/elasticsearch-py

- pytorch/serve

- h5py/h5py

- aimhubio/aim

- joblib/joblib

- scikit-optimize/scikit-optimize

- keras-team/keras-tuner

- aws/sagemaker-python-sdk

- run-llama/llama_index

- facebookresearch/faiss

- facebookresearch/fairseq

- deepjavalibrary/djl

- microsoft/autogen

- microsoft/promptbench

- ollama/ollama

- huggingface/smolagents

Diese Projekte decken ein breites Spektrum von AI/ML-Anwendungen ab und unterstreichen den umfassenden Ansatz von huntr zur AI-Sicherheit.

Hauptmerkmale

- Bug-Bounty-Plattform für AI/ML-Projekte

- Sicherer Prozess zur Offenlegung von Schwachstellen

- Incentiviertes Belohnungssystem für Forscher

- Zusammenarbeit zwischen Forschern und Betreuern

- Öffentliche Schwachstellenberichte für Open-Source-Projekte

Huntr wird von Protect AI unterstützt und ist führend auf dem Weg zu MLSecOps und mehr AI-Sicherheit.

Der beste Weg, Ihre AI/ML-Projekte zu sichern? Treten Sie huntr noch heute bei und tragen Sie zu einem sichereren AI-Ökosystem bei.

Beste Alternativwerkzeuge zu "huntr"

Pervaziv AI bietet generative KI-gestützte Softwaresicherheit für Multi-Cloud-Umgebungen, die sicheres Scannen, Beheben, Erstellen und Bereitstellen von Anwendungen ermöglicht. Schnellere und sicherere DevSecOps-Workflows auf Azure, Google Cloud und AWS.

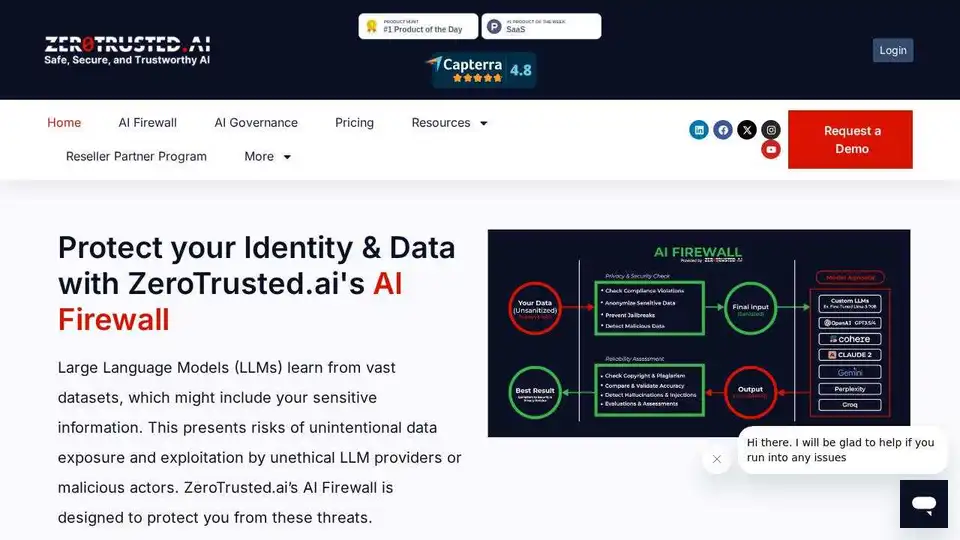

ZeroTrusted.ai bietet eine KI-Firewall, ein KI-Gateway und einen KI-Health-Check, um Ihr KI-Ökosystem zu schützen. Entdecken und blockieren Sie nicht autorisierte KI-Tools, gewährleisten Sie Datensicherheit und halten Sie die Compliance ein.

AquilaX Security ist eine KI-gestützte DevSecOps-Plattform, die Sicherheitsüberprüfungen automatisiert, Fehlalarme reduziert und Entwicklern hilft, sicheren Code schneller auszuliefern. Integriert SAST-, SCA-, Container-, IaC-, Geheimnis- und Malware-Scanner.

Think AI Agency hilft bei der Umwandlung von Ideen in MVPs mithilfe von KI und Automatisierung. Sie bieten eine schnelle und kostengünstige MVP-Entwicklung, unterstützt von YC & Alchemist, und versprechen eine Fertigstellung innerhalb weniger Wochen. Zu den Dienstleistungen gehören NLP, benutzerdefinierte LLMs und mehr.

Modernisieren Sie Ihre Legacy-Anwendungen in Wochen mit iBEAMs KI-gestütztem 4-Schritte-Prozess. Steigern Sie die Leistung, senken Sie Kosten, verbessern Sie die Sicherheit und gewährleisten Sie Skalierbarkeit mit expertengeführter App-Transformation.

Amazon Q Developer ist ein generativer KI-gestützter Assistent auf AWS für die Softwareentwicklung, der Funktionen wie Code-Implementierung, Tests und Refactoring bietet, um den Entwicklungslebenszyklus zu beschleunigen.

nbot.ai ist ein KI-gestützter Content-Curator, der personalisierte Feeds aus Web-Quellen erstellt, Insights zusammenfasst, Rauschen filtert und Echtzeit-Chat-Verfeinerung für jede Nische ermöglicht.

Confident AI ist eine auf DeepEval basierende LLM-Evaluierungsplattform, die Ingenieurteams befähigt, die Leistung von LLM-Anwendungen zu testen, zu bewerten, zu sichern und zu verbessern. Sie bietet erstklassige Metriken, Schutzmaßnahmen und Beobachtbarkeit zur Optimierung von KI-Systemen und zum Aufdecken von Regressionen.

Learn Prompting bietet umfassende Prompt-Engineering-Kurse an, die ChatGPT, LLMs und KI-Sicherheit abdecken und von Millionen weltweit genutzt werden. Beginnen Sie jetzt kostenlos zu lernen!

Mit Nyckel können Sie schnell benutzerdefinierte ML-Modelle erstellen, bereitstellen und integrieren. Es vereinfacht den Prozess, macht ihn ohne Doktortitel zugänglich und konzentriert sich auf Genauigkeit, Sicherheit und Benutzerfreundlichkeit.

Cursor ist der ultimative KI-gestützte Code-Editor, der die Entwicklerproduktivität mit Funktionen wie intelligenter Autovervollständigung, agentischer Codierung und nahtlosen Integrationen für effizientes Software-Bauen steigert.

Innovatiana bietet Experten-Datenbeschriftung und erstellt hochwertige KI-Datensätze für ML, DL, LLM, VLM, RAG und RLHF, um ethische und wirkungsvolle KI-Lösungen zu gewährleisten.

Dify ist eine Open-Source-Plattform zum Erstellen produktionsreifer KI-Anwendungen, Agentic-KI-Workflows und RAG-Pipelines. Stärken Sie Ihr Team mit No-Code-KI.

Entdecken Sie Lab2, das KI-Tool, das Text-Prompts in Python-Apps mit Streamlit, Gradio und Flask umwandelt. Ideal für schnelles Prototyping ohne Coding-Kenntnisse.