Confident AI

Übersicht von Confident AI

Was ist Confident AI?

Confident AI ist eine hochmoderne LLM-Evaluierungsplattform, die entwickelt wurde, um Ingenieurteams zu befähigen, ihre Anwendungen für Große Sprachmodelle (LLM) zu entwickeln, zu testen, zu benchmarken, abzusichern und deren Leistung erheblich zu verbessern. Erstellt von den Machern von DeepEval, einem gefeierten Open-Source-LLM-Evaluierungsframework, bietet Confident AI eine umfassende Suite von Tools zur Gewährleistung der Zuverlässigkeit, Genauigkeit und Effizienz von KI-Systemen in der Produktion. Es bietet einen strukturierten Ansatz, um LLMs zu validieren, ihr Verhalten zu optimieren und ihren Wert den Stakeholdern zu demonstrieren, wodurch Unternehmen effektiv geholfen wird, "ihren KI-Graben zu bauen".

Wie funktioniert Confident AI?

Confident AI integriert sich nahtlos in den LLM-Entwicklungslebenszyklus und bietet sowohl eine intuitive Plattformoberfläche als auch eine leistungsstarke zugrunde liegende Open-Source-Bibliothek, DeepEval. Der Prozess umfasst typischerweise vier unkomplizierte Schritte für Entwickler:

- DeepEval installieren: Unabhängig von Ihrem bestehenden Framework können Entwickler DeepEval problemlos in ihre Projekte integrieren. Diese Bibliothek bildet das Rückgrat für die Definition und Ausführung von Evaluierungen.

- Metriken auswählen: Die Plattform bietet eine reiche Auswahl von über 30 "LLM-as-a-judge"-Metriken. Diese spezialisierten Metriken sind auf verschiedene Anwendungsfälle zugeschnitten und ermöglichen es Teams, Aspekte wie faktenbasierte Konsistenz, Relevanz, Kohärenz, Toxizität und die Einhaltung spezifischer Anweisungen präzise zu messen.

- Anschließen: Entwickler dekorieren ihre LLM-Anwendungen im Code, um die ausgewählten Metriken anzuwenden. Dies ermöglicht die direkte Integration der Evaluierungslogik in die Codebasis der Anwendung, wodurch das Testen zu einem intrinsischen Bestandteil der Entwicklung wird.

- Eine Evaluierung durchführen: Nach der Integration können Evaluierungen durchgeführt werden, um detaillierte Testberichte zu generieren. Diese Berichte sind entscheidend, um Regressionen zu erkennen, Leistungsprobleme mit Traces zu debuggen und tiefe Einblicke in das Verhalten des LLMs zu gewinnen.

Hauptmerkmale und Vorteile von Confident AI

Confident AI bietet einen robusten Satz von Funktionen, um die komplexen Herausforderungen der LLM-Entwicklung und -Bereitstellung zu bewältigen:

LLM-Evaluierung & Benchmarking

- End-to-End-Evaluierung: Messen Sie die Gesamtleistung verschiedener Prompts und Modelle, um die effektivsten Konfigurationen für Ihre LLM-Anwendungen zu identifizieren. Dies hilft bei der Optimierung der Modellwahl und der Prompt-Engineering-Strategien.

- Benchmarking von LLM-Systemen: Vergleichen Sie systematisch verschiedene LLM-Modelle und Prompting-Techniken. Diese Funktion ist entscheidend für datengesteuerte Entscheidungen bei der Modellauswahl, Feinabstimmung und Prompt-Optimierung, um sicherzustellen, dass Sie die besten verfügbaren Ressourcen nutzen.

- Best-in-Class-Metriken: Nutzen Sie die leistungsstarken Metriken von DeepEval, einschließlich "LLM-as-a-judge"-Fähigkeiten, um nuancierte und genaue Bewertungen der LLM-Outputs zu erhalten. Diese Metriken gehen über einfache Genauigkeit hinaus, um die Qualität aus verschiedenen Perspektiven zu bewerten.

LLM-Beobachtbarkeit & Überwachung

- Echtzeit-Produktionseinblicke: Überwachen, verfolgen und A/B-testen Sie LLM-Anwendungen in Echtzeit in Produktionsumgebungen. Dies bietet sofortige Einblicke in die Leistung der Modelle in Live-Szenarien.

- Tracing-Beobachtbarkeit: Analysieren, debuggen und iterieren Sie LLM-Pipelines mit erweiterten Tracing-Funktionen. Dies ermöglicht Teams, Schwachstellen auf Komponentenebene zu identifizieren und genau zu verstehen, wo und warum Probleme auftreten.

- Intuitive Produktanalyse-Dashboards: Nicht-technische Teammitglieder können auf intuitive Dashboards zugreifen, um die LLM-Leistung zu verstehen, was eine funktionsübergreifende Zusammenarbeit und datengesteuerte Produktentscheidungen ohne tiefes technisches Fachwissen ermöglicht.

Regressionstests & Absicherung

- Automatisierte LLM-Tests: Confident AI bietet eine zielgerichtete Lösung zur Kuratierung von Datensätzen, zur Abstimmung von Metriken und zur Automatisierung von LLM-Tests, besonders wertvoll für die Integration in CI/CD-Pipelines.

- LLM-Regressionen mindern: Implementieren Sie Unit-Tests innerhalb von CI/CD-Pipelines, um Leistungsabfälle zu verhindern. Dies ermöglicht Teams, Updates häufig und zuverlässig bereitzustellen, selbst an herausfordernden Tagen wie Freitagen.

- KI-Systeme absichern: Proaktives Identifizieren und Beheben von Breaking Changes, wodurch die Hunderte von Stunden, die typischerweise für reaktives Debugging aufgewendet werden, erheblich reduziert werden. Dies führt zu stabileren und zuverlässigeren KI-Bereitstellungen.

Entwicklungs- und Betriebseffizienz

- Dataset Editor & Prompt Management: Tools zur Kuratierung von Evaluierungsdatensätzen und zur Verwaltung von Prompts optimieren den iterativen Prozess zur Verbesserung der LLM-Leistung.

- Reduzierte Inferenzkosten: Durch die Optimierung von Modellen und Prompts durch rigorose Evaluierung können Unternehmen die Inferenzkosten erheblich senken, potenziell um bis zu 80 %.

- Stakeholder-Vertrauen: Demonstrieren Sie konsistent, dass KI-Systeme Woche für Woche besser werden, bauen Sie Vertrauen auf und überzeugen Sie Stakeholder vom Wert und Fortschritt der KI-Initiativen.

Für wen ist Confident AI geeignet?

Confident AI wurde primär für Ingenieurteams, KI/ML-Entwickler und Datenwissenschaftler entwickelt, die aktiv LLM-Anwendungen entwickeln und bereitstellen. Die intuitiven Produktanalyse-Dashboards richten sich jedoch auch an Produktmanager und Geschäftsinteressenten, die den Einfluss und die Leistung von KI-Systemen verstehen müssen, ohne sich in den Code zu vertiefen. Es ist ein unschätzbares Werkzeug für:

- Teams, die schnell mit der LLM-Entwicklung vorankommen und gleichzeitig hohe Qualität aufrechterhalten möchten.

- Organisationen, die robuste Tests und Überwachung für ihre KI-Systeme implementieren müssen.

- Unternehmen, die LLM-Kosten optimieren und die Effizienz verbessern möchten.

- Unternehmen, die Sicherheit und Compliance auf Enterprise-Niveau für ihre KI-Bereitstellungen benötigen.

Warum Confident AI wählen?

Confident AI zu wählen bedeutet, eine bewährte, End-to-End-Lösung für die LLM-Evaluierung zu übernehmen, der eine große Open-Source-Community vertraut und die von führenden Akzeleratoren wie Y Combinator unterstützt wird. Das duale Angebot einer leistungsstarken Open-Source-Bibliothek (DeepEval) und einer Enterprise-Grade-Plattform gewährleistet Flexibilität und Skalierbarkeit.

Vorteile sind:

- Einen KI-Graben aufbauen: Durch die konsequente Optimierung und Absicherung Ihrer LLM-Anwendungen schaffen Sie einen Wettbewerbsvorteil.

- Immer Fortschritt: Automatisierte Regressionstests stellen sicher, dass jede Bereitstellung die Leistung verbessert oder aufrechterhält, wodurch kostspielige Rückschläge verhindert werden.

- Datengesteuerte Entscheidungen: Mit erstklassigen Metriken und klarer Beobachtbarkeit sind Entscheidungen über LLM-Verbesserungen kein Ratespiel mehr, sondern basieren auf soliden Daten.

- Enterprise-Grade-Zuverlässigkeit: Für große Organisationen bietet Confident AI Funktionen wie HIPAA-, SOCII-Konformität, Multi-Data Residency, RBAC, Datenmaskierung, 99,9 % Verfügbarkeits-SLA und On-Prem-Hosting-Optionen, um Sicherheit und Compliance selbst für die am stärksten regulierten Branchen zu gewährleisten.

Confident AI und die Open-Source-Community

Confident AI ist tief in der Open-Source-Community durch DeepEval verwurzelt. Mit über 12.000 GitHub-Sternen und Hunderttausenden von monatlichen Dokumentationslesern hat DeepEval eine lebendige Community von über 2.500 Entwicklern auf Discord aufgebaut. Dieses starke Community-Engagement spiegelt die Transparenz, Zuverlässigkeit und kontinuierliche Verbesserung wider, die durch seine Open-Source-Natur gefördert werden. Dies bedeutet auch, dass Benutzer von einer breiten Palette von Community-Beiträgen und geteiltem Wissen profitieren, was die Fähigkeiten und Anpassungsfähigkeit des Tools verbessert.

Zusammenfassend bietet Confident AI die notwendigen Tools und Einblicke, um die Komplexität der LLM-Entwicklung zu meistern und Teams zu ermöglichen, leistungsstarke, zuverlässige und kostengünstige KI-Anwendungen mit Vertrauen bereitzustellen.

Beste Alternativwerkzeuge zu "Confident AI"

LangWatch ist eine Plattform für KI-Agenten-Tests, LLM-Evaluierung und LLM-Observability. Testen Sie Agenten, verhindern Sie Regressionen und beheben Sie Probleme.

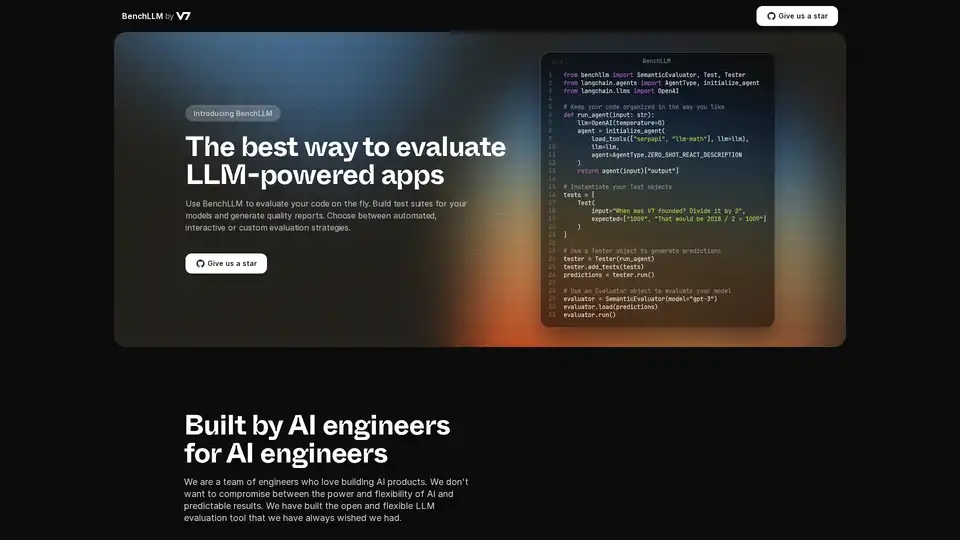

BenchLLM ist der beste Weg, LLM-gestützte Apps zu bewerten. Es hilft Ihnen, Testsuiten für Ihre Modelle zu erstellen und Qualitätsberichte mit automatisierten, interaktiven oder benutzerdefinierten Bewertungsstrategien zu erstellen.

Bolt Foundry bietet Context-Engineering-Tools, um KI-Verhalten vorhersagbar und testbar zu machen, und hilft Ihnen so, vertrauenswürdige LLM-Produkte zu entwickeln. Testen Sie LLMs wie Sie Code testen.

Future AGI bietet eine einheitliche LLM Observability- und KI-Agenten-Evaluierungsplattform für KI-Anwendungen, die Genauigkeit und verantwortungsvolle KI von der Entwicklung bis zur Produktion gewährleistet.

PromptLayer ist eine KI-Engineering-Plattform für Prompt-Management, -Bewertung und LLM-Observability. Arbeiten Sie mit Experten zusammen, überwachen Sie KI-Agenten und verbessern Sie die Prompt-Qualität mit leistungsstarken Tools.

Freeplay ist eine KI-Plattform, die Teams bei der Entwicklung, dem Testen und der Verbesserung von KI-Produkten durch Prompt-Management, Evaluierungen, Observability und Datenprüfungsworkflows unterstützt. Sie optimiert die KI-Entwicklung und gewährleistet eine hohe Produktqualität.

Openlayer ist eine KI-Unternehmensplattform, die eine einheitliche KI-Bewertung, Observability und Governance für KI-Systeme von ML bis LLMs bietet. Testen, überwachen und verwalten Sie KI-Systeme während des gesamten KI-Lebenszyklus.

Vivgrid ist eine KI-Agenten-Infrastrukturplattform, die Entwicklern hilft, KI-Agenten mit Sicherheitsvorkehrungen und Inferenz mit niedriger Latenz zu erstellen, zu beobachten, zu bewerten und bereitzustellen. Es unterstützt GPT-5, Gemini 2.5 Pro und DeepSeek-V3.

Future AGI ist eine einheitliche LLM-Observability- und KI-Agenten-Evaluierungsplattform, die Unternehmen dabei hilft, durch umfassende Test-, Evaluierungs- und Optimierungswerkzeuge 99% Genauigkeit in KI-Anwendungen zu erreichen.

Maxim AI ist eine End-to-End-Bewertungs- und Observability-Plattform, die Teams dabei unterstützt, KI-Agenten zuverlässig und 5-mal schneller bereitzustellen, mit umfassenden Test-, Überwachungs- und Qualitätssicherungswerkzeugen.

UpTrain ist eine Full-Stack-LLMOps-Plattform, die Tools der Enterprise-Klasse zur Bewertung, zum Experimentieren, Überwachen und Testen von LLM-Anwendungen bereitstellt. Hosten Sie in Ihrer eigenen sicheren Cloud-Umgebung und skalieren Sie KI zuverlässig.

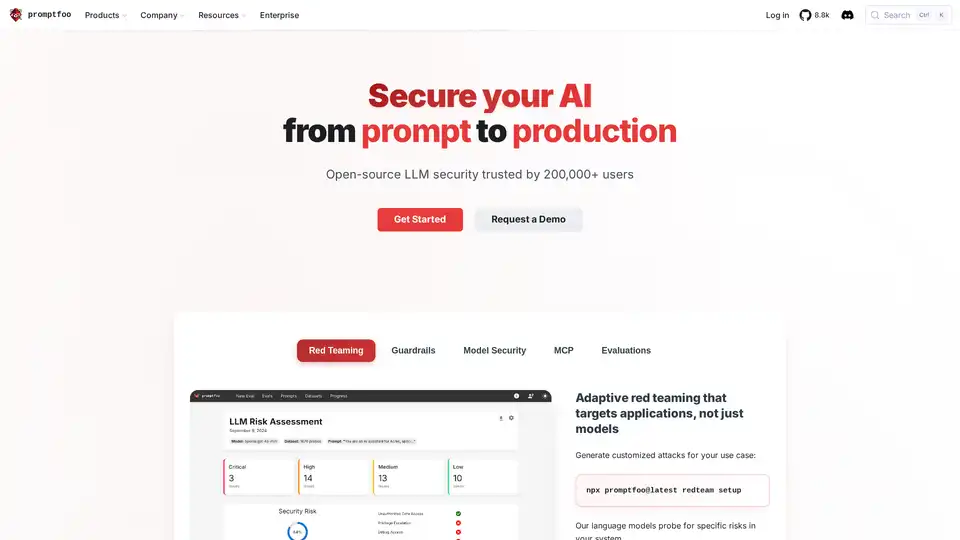

Promptfoo ist ein Open-Source-LLM-Sicherheitstool, das von über 200.000 Entwicklern für AI Red-Teaming und Bewertungen verwendet wird. Es hilft, Schwachstellen zu finden, die Ausgabequalität zu maximieren und Regressionen in KI-Anwendungen abzufangen.

Athina ist eine kollaborative AI-Plattform, die Teams dabei hilft, LLM-basierte Funktionen 10-mal schneller zu entwickeln, zu testen und zu überwachen. Mit Tools für Prompt-Management, Evaluierungen und Observability gewährleistet sie Datenschutz und unterstützt benutzerdefinierte Modelle.

Trainieren, verwalten und evaluieren Sie benutzerdefinierte große Sprachmodelle (LLMs) schnell und effizient auf Entry Point AI, ohne dass Code erforderlich ist.