Runpod

Übersicht von Runpod

Runpod: Die All-in-One AI Cloud Plattform

Was ist Runpod?

Runpod ist eine umfassende Cloud-Plattform, die entwickelt wurde, um den Prozess des Erstellens, Trainierens und Bereitstellens von AI Modellen zu optimieren. Es adressiert die häufigen Herausforderungen, mit denen AI Ingenieure konfrontiert sind, wie z.B. Infrastrukturmanagement, Skalierung und Kaltstarts. Durch die Bereitstellung einer vollständig ausgestatteten, GPU-fähigen Umgebung, die in weniger als einer Minute hochgefahren werden kann, zielt Runpod darauf ab, die AI Entwicklung zugänglicher und effizienter zu gestalten.

Hauptmerkmale:

- Mühelose Bereitstellung: Vereinfacht den Prozess, AI Modelle in die Produktion zu bringen.

- Globale Reichweite: Ermöglicht es Benutzern, Workloads über mehrere Regionen weltweit auszuführen.

- Autoscaling: Passt sich dynamisch an die Anforderungen der Workloads an und skaliert in Echtzeit von 0 auf 100+ Compute-Worker.

- Zero Cold Starts: Gewährleistet eine ununterbrochene Ausführung mit Always-on-GPUs.

- FlashBoot: Ermöglicht blitzschnelle Skalierung mit Kaltstarts unter 200 ms.

- Persistent Data Storage: Bietet S3-kompatiblen Speicher für vollständige AI Pipelines ohne Egress-Gebühren.

Wie funktioniert Runpod?

Runpod bietet eine Plattform, auf der Sie Ihre AI Workloads schnell bereitstellen und skalieren können. Es bietet mehrere wichtige Funktionen, die dies ermöglichen:

- GPU-fähige Umgebungen: Runpod bietet Zugriff auf GPU-gestützte Umgebungen, die für das Training und die Ausführung von AI Modellen unerlässlich sind.

- Autoscaling: Die Plattform kann Ressourcen automatisch basierend auf der Nachfrage skalieren und sicherstellen, dass Sie die Rechenleistung haben, die Sie benötigen, wenn Sie sie benötigen.

- Geringe Latenz: Mit Funktionen wie FlashBoot und globalen Bereitstellungsoptionen hilft Runpod, die Latenz zu reduzieren und die Leistung zu verbessern.

- Persistenter Speicher: Die Plattform bietet persistenten Datenspeicher, sodass Sie Ihre Daten verwalten können, ohne Egress-Gebühren zu verursachen.

Anwendungsfälle:

Runpod eignet sich für eine breite Palette von AI Anwendungen, einschließlich:

- Inferenz: Bereitstellung von Inferenz für Bild-, Text- und Audio-Generierung.

- Fine-Tuning: Training kundenspezifischer Modelle auf bestimmten Datensätzen.

- Agents: Aufbau intelligenter agentenbasierter Systeme und Workflows.

- Rechenintensive Aufgaben: Ausführen von Rendering und Simulationen.

Vorteile:

- Kosteneffektiv: Zahlen Sie nur für das, was Sie nutzen, abgerechnet pro Millisekunde.

- Skalierbar: Reagieren Sie sofort auf die Nachfrage mit GPU-Workern, die in Sekunden von 0 auf 1000+ skalieren.

- Zuverlässig: Garantiert 99,9% Uptime für kritische Workloads.

- Sicher: Engagiert für Sicherheit mit SOC2-, HIPAA- und GDPR-Zertifizierungen in Bearbeitung.

Wie man mit Runpod anfängt?

- Anmelden: Erstellen Sie ein Konto auf der Runpod-Plattform.

- Vorlagen erkunden: Verwenden Sie vorgefertigte Vorlagen, um Ihre AI Workflows zu starten.

- Anpassen: Konfigurieren Sie GPU-Modelle, Skalierungsverhalten und andere Einstellungen, um sie an Ihre spezifischen Bedürfnisse anzupassen.

- Bereitstellen: Runpod vereinfacht den Prozess der Bereitstellung und Skalierung von AI Modellen, sodass Sie sich auf Innovationen anstatt auf Infrastrukturmanagement konzentrieren können.

Warum ist Runpod wichtig?

Runpod begegnet den Herausforderungen der Bereitstellung von AI Modellen, indem es eine skalierbare, kosteneffektive und einfach zu bedienende Plattform bietet. Es ermöglicht AI Ingenieuren, sich auf den Aufbau und die Innovation zu konzentrieren, ohne durch das Infrastrukturmanagement behindert zu werden. Mit Funktionen wie Autoscaling, Zero Cold Starts und persistentem Datenspeicher ist Runpod ein wertvolles Werkzeug für jeden, der mit AI arbeitet.

Kundenstimmen:

Mehrere Unternehmen haben Runpod für seine Fähigkeit gelobt, die GPU-Infrastruktur zu skalieren und die Infrastrukturkosten zu senken. Zum Beispiel erklärte Bharat, Mitbegründer von InstaHeadshots, dass Runpod es ihnen ermöglicht hat, sich vollständig auf Wachstum und Produktentwicklung zu konzentrieren, ohne sich um die GPU-Infrastruktur kümmern zu müssen.

Fazit:

Runpod ist eine leistungsstarke und vielseitige Cloud-Plattform für AI Entwicklung und Bereitstellung. Sein Fokus auf Einfachheit, Skalierbarkeit und Kosteneffizienz macht es zu einer attraktiven Option für Unternehmen und Einzelpersonen, die die Leistungsfähigkeit von AI nutzen möchten. Durch die Abstraktion der Komplexitäten des Infrastrukturmanagements befähigt Runpod die Benutzer, die Zukunft zu gestalten, ohne durch Infrastrukturbeschränkungen behindert zu werden.

Beste Alternativwerkzeuge zu "Runpod"

Runpod ist eine KI-Cloud-Plattform, die die Erstellung und Bereitstellung von KI-Modellen vereinfacht. Bietet On-Demand-GPU-Ressourcen, serverlose Skalierung und Enterprise-Grade-Uptime für KI-Entwickler.

GreenNode bietet umfassende KI-fähige Infrastruktur und Cloud-Lösungen mit H100-GPUs ab 2,34 $/Stunde. Greifen Sie auf vorkonfigurierte Instanzen und eine Full-Stack-KI-Plattform für Ihre KI-Reise zu.

Massed Compute bietet On-Demand-GPU- und CPU-Cloud-Computing-Infrastruktur für KI, maschinelles Lernen und Datenanalyse. Greifen Sie mit flexiblen und erschwinglichen Plänen auf hochleistungsfähige NVIDIA-GPUs zu.

SaladCloud bietet eine erschwingliche, sichere und Community-gesteuerte verteilte GPU-Cloud für KI/ML-Inferenz. Sparen Sie bis zu 90 % der Rechenkosten. Ideal für KI-Inferenz, Stapelverarbeitung und mehr.

eeat ist ein KI-gestütztes Analysetool mit GPT-3.5 und GPT-4, das detaillierte Daten zu kommerziellen Keywords und Wettbewerbern sammelt, um EEAT-konformes Experten-Content zu erstellen und Suchmaschinen-Rankings sowie die Geschäftskonkurrenzfähigkeit zu steigern.

Novita AI bietet mehr als 200 Model-APIs, benutzerdefinierte Bereitstellung, GPU-Instanzen und serverlose GPUs. Skalieren Sie die KI, optimieren Sie die Leistung und innovieren Sie mühelos und effizient.

Vocareum bietet KI-Bildungslösungen mit Cloud-Labs, KI-Notebooks und KI-Gateways für praktisches Lernen und Forschung.

QSC Cloud bietet erstklassige NVIDIA GPU Cloud-Cluster für KI-, Deep-Learning- und HPC-Workloads mit globaler GPU-Konnektivität.

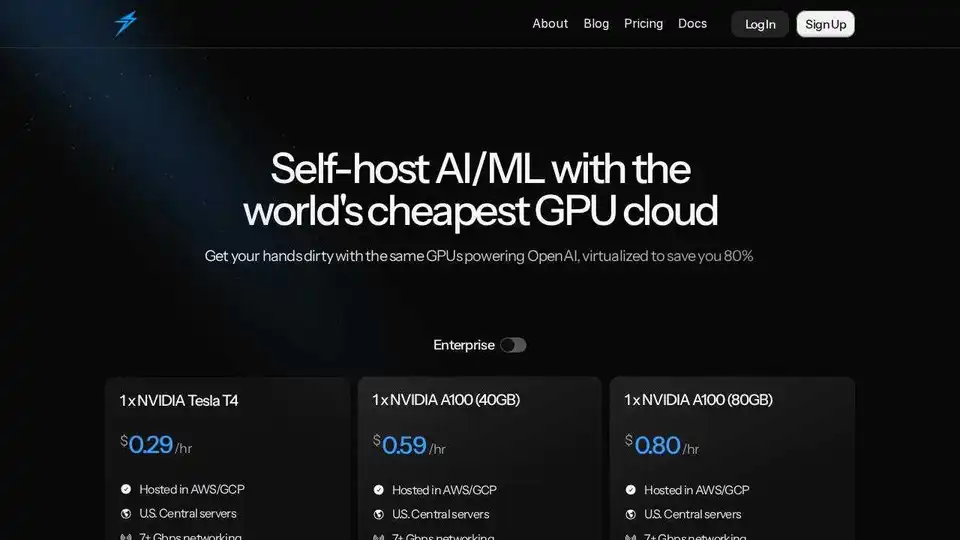

Thunder Compute ist eine GPU-Cloud-Plattform für KI/ML, die GPU-Instanzen mit einem Klick in VSCode zu Preisen anbietet, die 80 % niedriger sind als die der Konkurrenz. Perfekt für Forscher, Startups und Datenwissenschaftler.

Mieten Sie mit Vast.ai kostengünstig Hochleistungs-GPUs. Stellen Sie sofort GPU-Mieten für KI, maschinelles Lernen, Deep Learning und Rendering bereit. Flexible Preise und schnelle Einrichtung.

Cirrascale AI Innovation Cloud beschleunigt die KI-Entwicklung, das Training und die Inferenz-Workloads. Testen und implementieren Sie auf führenden KI-Beschleunigern mit hohem Durchsatz und geringer Latenz.

Phala Cloud bietet eine vertrauenswürdige Open-Source-Cloud-Infrastruktur für die Bereitstellung von KI-Agenten und Web3-Anwendungen, die von TEE unterstützt wird. Es gewährleistet Datenschutz, Skalierbarkeit und wird durch Code gesteuert.

Juice ermöglicht GPU-over-IP und ermöglicht Ihnen, Ihre GPUs mit Software für KI- und Grafik-Workloads zu vernetzen und zu bündeln.

AIStocks.io ist eine KI-gestützte Aktienforschungsplattform, die Echtzeit-Prognosen, automatisierte Trading-Signale und umfassende Risikomanagement-Tools für selbstbewusste Anlageentscheidungen bietet.