GreenNode

Übersicht von GreenNode

GreenNode: Ihre Komplettlösung für die AI-Entwicklung

GreenNode ist eine umfassende AI-Plattform, die entwickelt wurde, um Benutzern die notwendige Infrastruktur und Tools bereitzustellen, um ihre AI-Reise anzutreten und zu beschleunigen. Sie bietet eine Reihe von Services, darunter vorkonfigurierte GPU-Instanzen, eine Full-Stack-AI-Plattform, High-Speed-Networking und AI-zentrischen Speicher, um den vielfältigen Bedürfnissen von Unternehmen und AI-Startups gerecht zu werden.

Was ist GreenNode?

GreenNode ist eine Cloud-basierte Plattform, die sich auf die Bereitstellung von AI-fähiger Infrastruktur und Anwendungen spezialisiert hat. Sie nutzt modernste NVIDIA GPU-Technologie, einschließlich H100 GPUs, um hochleistungsfähige Computing-Lösungen für AI-Modelltraining, Bereitstellung und Skalierung anzubieten. GreenNode zielt darauf ab, die Komplexität des AI-Infrastrukturmanagements zu vereinfachen, sodass sich Benutzer auf Innovation und Entwicklung konzentrieren können.

Hauptmerkmale und Vorteile

- Vorkonfigurierte GPU-Instanzen: GreenNode bietet eine breite Palette von GPU- und CPU-Instanzen, um spezifische Unternehmensanforderungen zu erfüllen. Dazu gehört der Zugriff auf NVIDIA H100 und H200 GPUs, um eine optimale Leistung für anspruchsvolle AI-Workloads zu gewährleisten.

- Full-Stack-AI-Plattform: Benutzer können mit vorkonfigurierten Instanzen, gemeinsam genutztem Speicher und InfiniBand-Netzwerkverbindungen mit dem Training von AI-Modellen beginnen, alles auf einer Pay-as-you-go (PAYG)-Basis. Dies reduziert Vorabinvestitionen und bietet Flexibilität.

- InfiniBand-Netzwerk: GreenNode verwendet ein High-Speed-InfiniBand-Netzwerk, das der NVIDIA-Architektur entspricht, für blitzschnelle Datenübertragung. Dies ist entscheidend für das Training mit mehreren GPUs und die Verarbeitung großer Datensätze.

- AI-zentrischer Speicherservice: Die Plattform umfasst einen Speicherservice, der von VAST Data unterstützt wird und ideal für große Datensätze und Checkpoints von AI/ML-Workloads ist. Dies gewährleistet eine effiziente Speicherung und Abfrage kritischer Daten.

- Optimierter Block Storage: GreenNode bietet hochleistungsfähigen Block Storage, der eine konsistente Leistung mit geringer Latenz bietet und die Anforderungen verschiedener AI-Anwendungen unterstützt.

- Managed Kubernetes: Die Plattform bietet GPU-gestützte Kubernetes-Container mit intuitiver Instanzbereitstellung und automatischen Skalierungsfunktionen. Dies vereinfacht die Bereitstellung und Verwaltung von containerisierten AI-Anwendungen.

- Top-notch API: GreenNode bietet eine robuste API (CLI, GraphQL), um Workflows zu optimieren und GPU/CPU-Ressourcen sofort bereitzustellen, wodurch die Entwicklerproduktivität gesteigert wird.

- Enterprise Grade: Sofortiger Zugriff auf verfügbare Tools und Frameworks für AI-Anwendungen für Unternehmen.

Wie funktioniert GreenNode?

GreenNode bietet eine optimierte Umgebung für die AI-Entwicklung, indem es vorgefertigte Notebooks mit Single- oder Multi-Node-AI-Trainingsfunktionen anbietet. Dies ermöglicht es Benutzern, ihre AI-Vision mit einem Ein-Klick-AI-Modelltrainingsprozess zu validieren. Die Plattform bietet auch kompetente Unterstützung durch erfahrene Ingenieure, die sich auf die Bereitstellung verschiedener LLM-Modelle und AI-Anwendungen spezialisiert haben.

Warum ist GreenNode wichtig?

GreenNode geht die Herausforderungen an, mit denen Unternehmen und AI-Startups beim Zugriff und der Verwaltung von hochleistungsfähiger AI-Infrastruktur konfrontiert sind. Durch die Bereitstellung einer umfassenden, AI-fähigen Plattform ermöglicht GreenNode Unternehmen Folgendes:

- AI-Entwicklung beschleunigen: Mit vorkonfigurierten Instanzen und optimierten Workflows können Benutzer schnell AI-Modelle bereitstellen und trainieren, wodurch die Markteinführungszeit verkürzt wird.

- Kosten senken: Das Pay-as-you-go-Preismodell und die optimierte Ressourcenauslastung helfen Unternehmen, die Infrastrukturkosten zu minimieren.

- Effizient skalieren: Die skalierbare Infrastruktur von GreenNode ermöglicht es Benutzern, sich problemlos an veränderte Anforderungen anzupassen und ihre AI-Anwendungen nach Bedarf zu skalieren.

- Zugang zu Expertise: Die Plattform bietet Zugang zu AI-Engineering-Expertise und hilft Benutzern, technische Herausforderungen zu meistern und ihre AI-Projekte zu optimieren.

Kundenreferenzen

- Div Garg, CEO von MultiOn: Hebt die Rolle von GreenNode bei der Bereitstellung des Zugangs zu NVIDIA H100 GPUs hervor, die es ihnen ermöglichen, ihr AI-Agent-Produkt zu skalieren und die Kosten effektiv zu verwalten.

- Khoa Tran, CEO von SongGen.AI: Betont die Expertise des AI-Engineering-Teams von GreenNode, das dazu beigetragen hat, ihre Trainingszeit zu halbieren und ihren Entwicklungsprozess zu beschleunigen.

- Quynh Tran, Country Head, Fuse Vietnam: Lobt die regionale Expertise von GreenNode in den Bereichen OCR/IDP, flexible Preisgestaltung und praktische Unterstützung bei der Skalierung ihres Startups.

- Chu Hong Hanh, Head of Innovation Lab, ACB: Vermerkt die bahnbrechende IDP OCR-Lösung von GreenNode, die die für die Verarbeitung komplexer Bankdokumente benötigte Zeit erheblich reduziert hat.

FAQs

- Wann wird GreenNode den Service starten? Der Service soll im Januar 2024 starten. Benutzer können GPUs im Voraus reservieren.

- Was sind die Hauptmerkmale von NVIDIA H100? Die NVIDIA H100 GPU umfasst Tensor Cores der vierten Generation, eine Transformer Engine, NVLink Network Interconnect und Secure MIG, die Effizienz, Geschwindigkeit und Sicherheit verbessern.

- Wie kann GreenNode meine AI/ML-Modelle unterstützen? Die GPUs von GreenNode erhöhen die Verarbeitungsgeschwindigkeit erheblich, ermöglichen die Verarbeitung großer und komplexer Modelle und bieten die Effizienz, die für Echtzeitanwendungen erforderlich ist.

- Was sollte ich bei der Bereitstellung eines AI/ML-Modells in der Cloud beachten? Zu den wichtigsten Überlegungen gehören Datenaufbereitung, Modellbereitstellung, Skalierbarkeit, Sicherheit, Containerisierung, Microservices-Architektur, Infrastructure as Code (IaC), Überwachung, CI/CD und Kostenmanagement.

Fazit

GreenNode zeichnet sich als eine wertvolle Lösung für Unternehmen aus, die die Leistungsfähigkeit von AI nutzen möchten. Seine umfassende Suite von Services, einschließlich des Zugriffs auf hochleistungsfähige NVIDIA GPUs, eine Full-Stack-AI-Plattform und kompetente Unterstützung, erleichtert es Unternehmen, AI-Anwendungen zu entwickeln, bereitzustellen und zu skalieren. Egal, ob Sie ein Unternehmen sind, das Innovationen vorantreiben möchte, oder ein AI-Startup, das sein Wachstum beschleunigen möchte, GreenNode bietet die Tools und Ressourcen, die Sie benötigen, um im AI-Zeitalter erfolgreich zu sein. Durch die Bereitstellung einer umfassenden AI-fähigen Infrastruktur und Cloud-Lösungen ist GreenNode gut positioniert, um Unternehmen dabei zu helfen, Enterprise AI mit Zuversicht anzuführen.

Beste Alternativwerkzeuge zu "GreenNode"

Denvr Dataworks bietet hochleistungsfähige KI-Rechenservices, darunter On-Demand-GPU-Cloud, KI-Inferenz und eine private KI-Plattform. Beschleunigen Sie Ihre KI-Entwicklung mit NVIDIA H100, A100 und Intel Gaudi HPUs.

Mieten Sie mit Vast.ai kostengünstig Hochleistungs-GPUs. Stellen Sie sofort GPU-Mieten für KI, maschinelles Lernen, Deep Learning und Rendering bereit. Flexible Preise und schnelle Einrichtung.

Massed Compute bietet On-Demand-GPU- und CPU-Cloud-Computing-Infrastruktur für KI, maschinelles Lernen und Datenanalyse. Greifen Sie mit flexiblen und erschwinglichen Plänen auf hochleistungsfähige NVIDIA-GPUs zu.

Nebius ist eine KI-Cloud-Plattform, die entwickelt wurde, um die KI-Infrastruktur zu demokratisieren und eine flexible Architektur, getestete Leistung und langfristigen Wert mit NVIDIA-GPUs und optimierten Clustern für Training und Inferenz bietet.

Float16.Cloud bietet serverlose GPUs für eine schnelle KI-Entwicklung. Führen Sie KI-Modelle ohne Einrichtung sofort aus, trainieren und skalieren Sie sie. Mit H100-GPUs, sekundengenauer Abrechnung und Python-Ausführung.

Cerebrium ist eine serverlose KI-Infrastrukturplattform, die die Bereitstellung von Echtzeit-KI-Anwendungen mit geringer Latenz, Zero DevOps und sekundengenauer Abrechnung vereinfacht. Stellen Sie LLMs und Vision-Modelle global bereit.

Entdecken Sie Qwen3 Coder, das fortschrittliche KI-Code-Generierungsmodell von Alibaba Cloud. Erfahren Sie mehr über seine Funktionen, Leistungsbenchmarks und wie Sie dieses leistungsstarke Open-Source-Tool für die Entwicklung nutzen.

Runpod ist eine KI-Cloud-Plattform, die die Erstellung und Bereitstellung von KI-Modellen vereinfacht. Bietet On-Demand-GPU-Ressourcen, serverlose Skalierung und Enterprise-Grade-Uptime für KI-Entwickler.

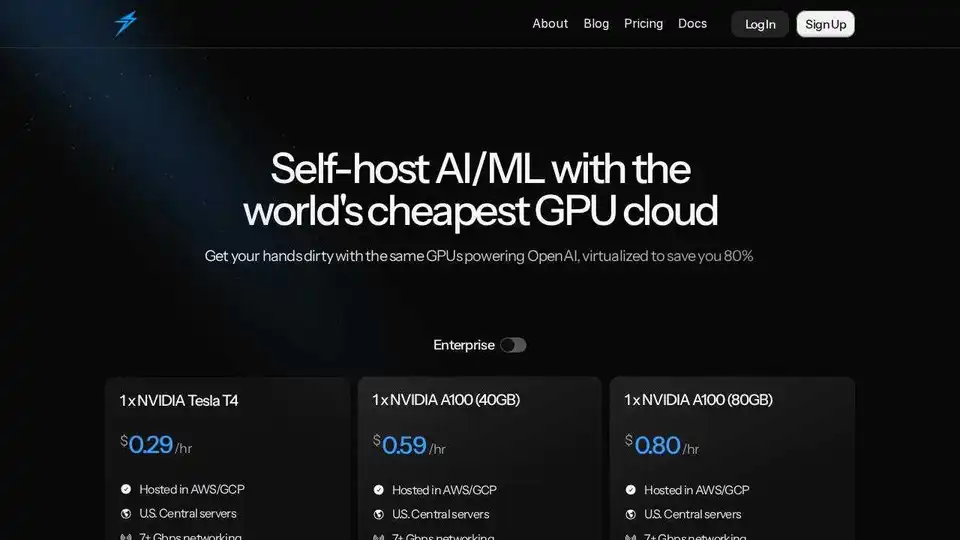

Thunder Compute ist eine GPU-Cloud-Plattform für KI/ML, die GPU-Instanzen mit einem Klick in VSCode zu Preisen anbietet, die 80 % niedriger sind als die der Konkurrenz. Perfekt für Forscher, Startups und Datenwissenschaftler.

Runpod ist eine All-in-One-KI-Cloud-Plattform, die das Erstellen und Bereitstellen von KI-Modellen vereinfacht. Trainieren, optimieren und stellen Sie KI mühelos mit leistungsstarker Rechenleistung und automatischer Skalierung bereit.

SaladCloud bietet eine erschwingliche, sichere und Community-gesteuerte verteilte GPU-Cloud für KI/ML-Inferenz. Sparen Sie bis zu 90 % der Rechenkosten. Ideal für KI-Inferenz, Stapelverarbeitung und mehr.

RunComfy: Führende Cloud-basierte ComfyUI für stabile Diffusion. Ermöglicht KI-Kunst mit Hochgeschwindigkeits-GPUs und effizienten Workflows, keine technischen Einstellungen erforderlich.

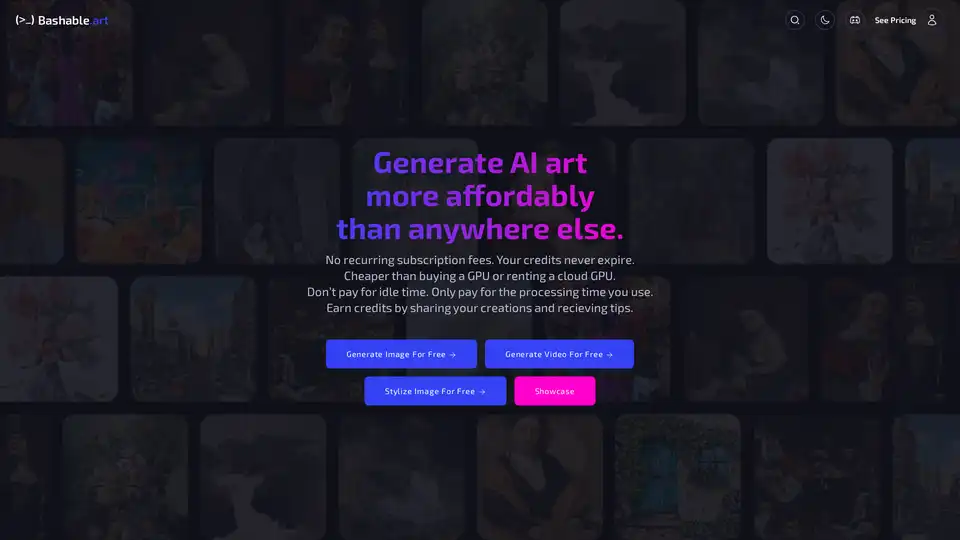

Bashable.art ist eine KI-gestützte Plattform zum Generieren realistischer Bilder und Videos ohne Abonnementgebühren. Bezahlen Sie nur für die von Ihnen genutzte Bearbeitungszeit und verdienen Sie Gutschriften, indem Sie Ihre Kreationen teilen.

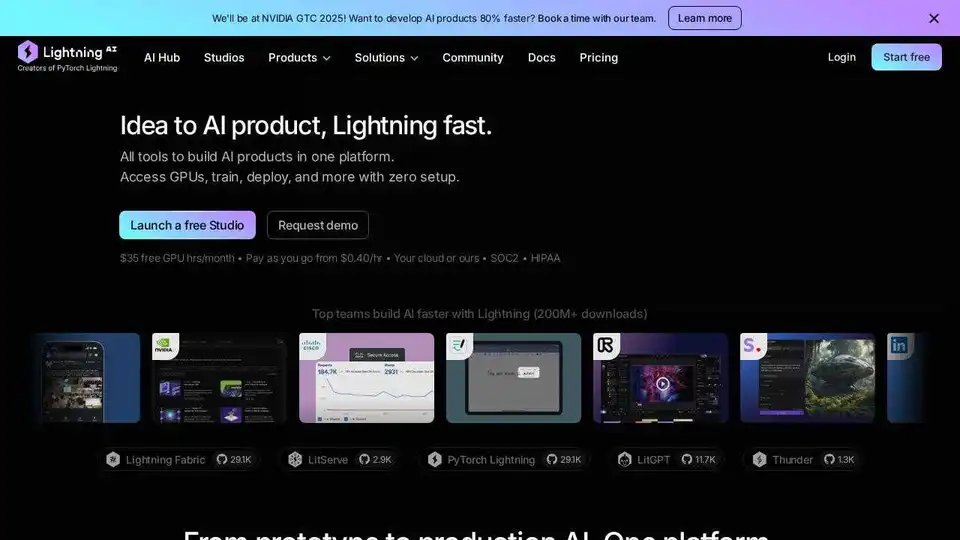

Lightning AI ist ein All-in-One-Cloud-Arbeitsbereich, der zum Erstellen, Bereitstellen und Trainieren von KI-Agenten, Daten und KI-Apps entwickelt wurde. Erhalten Sie Modell-APIs, GPU-Training und Multi-Cloud-Bereitstellung in einem Abonnement.