Sagify

Descripción general de Sagify

¿Qué es Sagify?

Sagify es una biblioteca innovadora de código abierto en Python diseñada para simplificar las complejidades de los flujos de trabajo de machine learning (ML) y modelos de lenguaje grandes (LLM) en AWS SageMaker. Al abstraer los detalles intrincados de la infraestructura en la nube, Sagify permite a los científicos de datos e ingenieros de ML enfocarse en lo que realmente importa: desarrollar y desplegar modelos de alto impacto. Ya sea que estés entrenando clasificadores personalizados, ajustando hiperparámetros o integrando LLMs potentes como la serie GPT de OpenAI o alternativas de código abierto como Llama 2, Sagify proporciona una interfaz modular e intuitiva que acelera tu camino desde el prototipo hasta la producción.

En su núcleo, Sagify aprovecha las capacidades robustas de AWS SageMaker mientras elimina la necesidad de tareas manuales de DevOps. Esto lo convierte en una herramienta esencial para equipos que buscan aprovechar el poder del ML basado en la nube sin quedar atrapados en la configuración y gestión. Con soporte para LLMs propietarios (por ejemplo, de OpenAI, Anthropic) y modelos de código abierto desplegados en endpoints de SageMaker, Sagify cierra la brecha entre la experimentación y el despliegue escalable, asegurando que tus proyectos de ML sean eficientes, rentables e innovadores.

¿Cómo funciona Sagify?

Sagify opera a través de una interfaz de línea de comandos (CLI) y API de Python que automatiza etapas clave del ciclo de vida de ML. Su arquitectura está construida alrededor de la modularidad, con componentes distintos para flujos de trabajo generales de ML y un Gateway de LLM especializado para manejar modelos de lenguaje.

Arquitectura principal para flujos de trabajo de ML

Para tareas tradicionales de ML, Sagify comienza inicializando una estructura de proyecto con sagify init. Esto crea un diseño de directorio estandarizado, incluyendo módulos de entrenamiento y predicción, configuraciones de Docker y entornos de prueba locales. Los usuarios implementan funciones simples como train() y predict() en plantillas proporcionadas, que Sagify empaqueta en imágenes de Docker mediante sagify build.

Una vez construidas, estas imágenes pueden empujarse a AWS ECR con sagify push, y el entrenamiento comienza en SageMaker usando sagify cloud train. La herramienta maneja la carga de datos a S3, el aprovisionamiento de recursos (por ejemplo, tipos de instancias EC2 como ml.m4.xlarge) y la gestión de salidas. Para el despliegue, sagify cloud deploy inicia endpoints que sirven predicciones a través de APIs REST, soportando inferencia en tiempo real con latencia mínima.

Sagify también destaca en funciones avanzadas como la optimización de hiperparámetros. Al definir rangos de parámetros en una configuración JSON (por ejemplo, para kernels de SVM o valores gamma), los usuarios pueden ejecutar trabajos de ajuste bayesiano con sagify cloud hyperparameter-optimization. Esto automatiza procesos de prueba y error, registrando métricas como precisión o exactitud directamente desde tu código de entrenamiento usando la función log_metric de Sagify. Se soportan instancias spot para ahorros de costos en trabajos más largos, lo que lo hace ideal para tareas intensivas en recursos.

La transformación por lotes y la inferencia en streaming completan las capacidades de ML. Los trabajos por lotes procesan grandes conjuntos de datos fuera de línea (por ejemplo, sagify cloud batch-transform), mientras que el streaming experimental a través de Lambda y SQS habilita pipelines en tiempo real para aplicaciones como recomendadores.

LLM Gateway: Acceso unificado a modelos de lenguaje grandes

Una de las características destacadas de Sagify es el LLM Gateway, una API RESTful basada en FastAPI que proporciona un punto de entrada único para interactuar con diversos LLMs. Este gateway soporta múltiples backends:

- LLMs propietarios: Integración directa con OpenAI (por ejemplo, GPT-4, DALL-E para generación de imágenes), Anthropic (modelos Claude) y plataformas emergentes como Amazon Bedrock o Cohere.

- LLMs de código abierto: Despliegue de modelos como Llama 2, Stable Diffusion o modelos de embedding (por ejemplo, BGE, GTE) como endpoints de SageMaker.

El flujo de trabajo es directo: Despliega modelos con comandos sin código como sagify cloud foundation-model-deploy para modelos base, o sagify llm start para configuraciones personalizadas. Las variables de entorno configuran claves de API y endpoints, y el gateway maneja solicitudes para completaciones de chat, embeddings y generaciones de imágenes.

Por ejemplo, para generar embeddings en modo por lotes, prepara entradas JSONL con IDs únicos (por ejemplo, recetas para búsqueda semántica), carga a S3 y activa sagify llm batch-inference. Las salidas se enlazan de vuelta vía IDs, perfectas para poblar bases de datos vectoriales en sistemas de búsqueda o recomendación. Tipos de instancias soportadas como ml.p3.2xlarge aseguran escalabilidad para embeddings de alta dimensionalidad.

Los endpoints de API reflejan el formato de OpenAI para una migración fácil:

- Completaciones de chat: POST a

/v1/chat/completionscon mensajes, temperatura y tokens máximos. - Embeddings: POST a

/v1/embeddingspara representaciones vectoriales. - Generaciones de imágenes: POST a

/v1/images/generationscon prompts y dimensiones.

Las opciones de despliegue incluyen ejecuciones locales de Docker o AWS Fargate para producción, con plantillas de CloudFormation para orquestación.

Características clave y beneficios

Las características de Sagify están adaptadas para agilizar el desarrollo de ML y LLM:

- Automatización de infraestructura: No más aprovisionamiento manual—Sagify maneja builds de Docker, pushes a ECR, manejo de datos en S3 y trabajos de SageMaker.

- Pruebas locales: Comandos como

sagify local trainysagify local deploysimulan entornos en la nube en tu máquina. - Despliegue relámpago: Para modelos preentrenados (por ejemplo, scikit-learn, Hugging Face, XGBoost), usa

sagify cloud lightning-deploysin código personalizado. - Monitoreo y gestión de modelos: Lista plataformas y modelos con

sagify llm platformsosagify llm models; inicia/detiene infraestructura bajo demanda. - Eficiencia de costos: Aprovecha instancias spot, procesamiento por lotes y autoescalado para optimizar el gasto en AWS.

El valor práctico es inmenso. Los equipos pueden reducir el tiempo de despliegue de semanas a días, como se destaca en la promesa de Sagify: "del idea al modelo desplegado en solo un día". Esto es particularmente útil para experimentación iterativa con LLMs, donde cambiar entre proveedores (por ejemplo, GPT-4 para chat, Stable Diffusion para visuales) de otro modo requeriría configuraciones fragmentadas.

Testimonios de usuarios y ejemplos, como entrenar un clasificador Iris o desplegar Llama 2 para chat, demuestran confiabilidad. Para embeddings, inferencia por lotes en modelos como GTE-large habilita sistemas eficientes de RAG (Generación Aumentada por Recuperación), mientras que endpoints de imágenes impulsan apps de AI creativas.

Usando Sagify: Guía paso a paso

Instalación y configuración

Los prerrequisitos incluyen Python 3.7+, Docker y AWS CLI. Instala vía pip:

pip install sagify

Configura tu cuenta AWS creando roles IAM con políticas como AmazonSageMakerFullAccess y configurando perfiles en ~/.aws/config.

Inicio rápido para ML

- Clona un repo de demo (por ejemplo, clasificación Iris).

- Ejecuta

sagify initpara configurar el proyecto. - Implementa funciones

train()ypredict(). - Construye y prueba localmente:

sagify build,sagify local train,sagify local deploy. - Empuja y entrena en la nube:

sagify push,sagify cloud upload-data,sagify cloud train. - Despliega:

sagify cloud deploye invoca vía curl o Postman.

Inicio rápido para LLMs

- Despliega un modelo:

sagify cloud foundation-model-deploy --model-id model-txt2img-stabilityai-stable-diffusion-v2-1-base. - Establece variables de entorno (por ejemplo, claves de API para OpenAI).

- Inicia gateway:

sagify llm gateway --start-local. - Consulta APIs: Usa curl, requests de Python o fetch de JS para completaciones, embeddings o imágenes.

Para inferencia por lotes, prepara archivos JSONL y ejecuta sagify llm batch-inference.

¿Por qué elegir Sagify para tus proyectos de ML y LLM?

En un panorama abarrotado de frameworks de ML, Sagify destaca por sus optimizaciones específicas de SageMaker y unificación de LLM. Aborda puntos de dolor comunes como la sobrecarga de infraestructura y la fragmentación de modelos, permitiendo una innovación más rápida. Ideal para startups que escalan prototipos de AI o empresas que construyen apps de LLM de grado producción, la naturaleza de código abierto de Sagify fomenta contribuciones de la comunidad, con soporte continuo para nuevos modelos (por ejemplo, Mistral, Gemma).

¿Para quién es? Científicos de datos cansados de código boilerplate, ingenieros de ML que buscan automatización y desarrolladores de AI experimentando con LLMs. Al enfocarse en la lógica del modelo sobre ops, Sagify empodera a los usuarios para entregar soluciones impactantes—ya sea búsqueda semántica, arte generativo o analítica predictiva—mientras se adhiere a mejores prácticas para despliegues seguros y escalables en AWS.

Para obtener los mejores resultados en flujos de trabajo de ML o integraciones de LLM, comienza con Sagify hoy. Su combinación de simplicidad y poder lo convierte en la herramienta principal para desbloquear el potencial completo de AWS SageMaker.

Mejores herramientas alternativas a "Sagify"

Qualcomm AI Hub es una plataforma para la IA en el dispositivo, que ofrece modelos de IA optimizados y herramientas para implementar y validar el rendimiento en dispositivos Qualcomm. Es compatible con varios tiempos de ejecución y proporciona un ecosistema para soluciones de ML de extremo a extremo.

Weco AI automatiza experimentos de aprendizaje automático usando tecnología AIDE ML, optimizando pipelines ML mediante evaluación de código impulsada por IA y experimentación sistemática para mejorar métricas de precisión y rendimiento.

Un estudio empresarial de próxima generación para constructores de IA que entrenan, validan, afinan y despliegan modelos de IA. Descubre las herramientas integradas de IBM watsonx.ai para el desarrollo de IA generativa escalable.

DeepClaude es una herramienta de código abierto que une el razonamiento avanzado de DeepSeek R1 con la creatividad de Claude para una generación de código AI fluida. Disfrute de respuestas sin latencia, privacidad y APIs personalizables sin registro.

BasicAI ofrece una plataforma líder de anotación de datos y servicios de etiquetado profesional para modelos de IA/ML, confiable por miles en aplicaciones de AV, ADAS y Smart City. Con más de 7 años de experiencia, garantiza soluciones de datos de alta calidad y eficiencia.

Xander es una plataforma de escritorio de código abierto que permite el entrenamiento de modelos de IA sin código. Describe tareas en lenguaje natural para pipelines automatizados en clasificación de texto, análisis de imágenes y ajuste fino de LLM, garantizando privacidad y rendimiento en tu máquina local.

Inferless ofrece inferencia GPU sin servidor ultrarrápida para implementar modelos ML. Proporciona despliegue escalable y sin esfuerzo de modelos de aprendizaje automático personalizados con funciones como escalado automático, agrupamiento dinámico y seguridad empresarial.

AI Bucket se erige como el directorio principal para las mejores herramientas de IA, con una extensa colección de más de 2000 herramientas de IA en más de 20 categorías.

xTuring es una biblioteca de código abierto que permite a los usuarios personalizar y ajustar finamente Modelos de Lenguaje Grandes (LLMs) de manera eficiente, enfocándose en simplicidad, optimización de recursos y flexibilidad para personalización de IA.

Perpetual ML es un estudio todo en uno para el aprendizaje automático a gran escala, que ofrece AutoML, aprendizaje continuo, seguimiento de experimentos, implementación de modelos y monitoreo de datos, integrado de forma nativa con Snowflake.

SaladCloud ofrece una nube GPU distribuida, asequible, segura e impulsada por la comunidad para la inferencia de AI/ML. Ahorre hasta un 90 % en costos de computación. Ideal para inferencia de IA, procesamiento por lotes y más.

Thordata ofrece proxies residenciales de alta calidad para un web scraping de datos sin problemas, perfecto para IA, BI y flujos de trabajo. Accede a más de 60 millones de IPs con facturación basada en el tráfico y un rendimiento fiable.

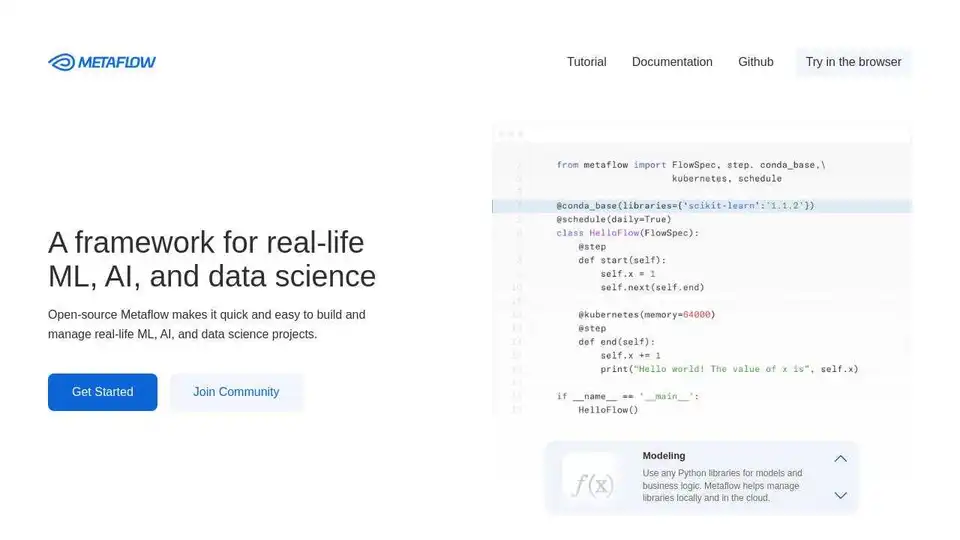

Metaflow es un framework de código abierto de Netflix para construir y gestionar proyectos de ML, IA y ciencia de datos en la vida real. Escala flujos de trabajo, rastrea experimentos e implementa en producción fácilmente.

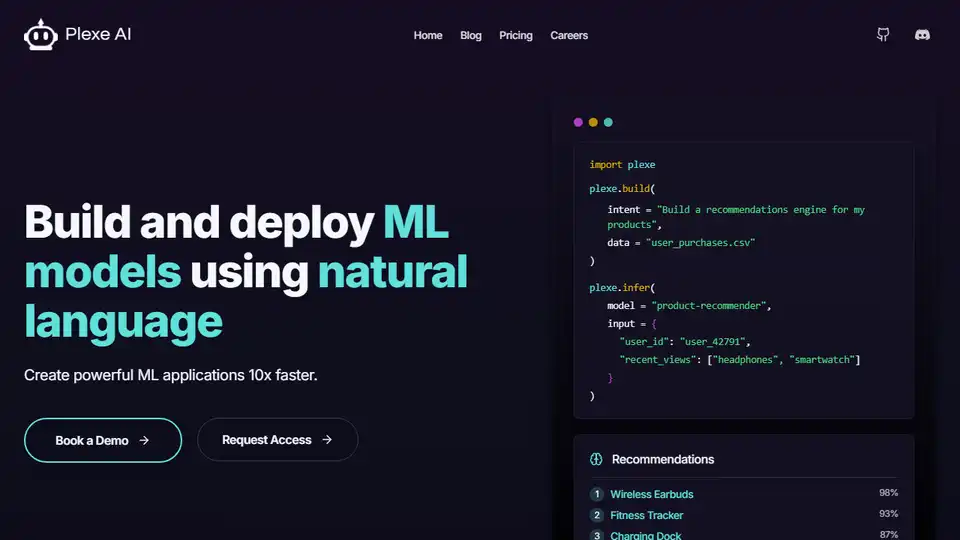

PlexeAI: Construye, entrena y despliega modelos ML utilizando comandos sencillos en inglés, sin necesidad de codificación. Crea potentes aplicaciones ML 10 veces más rápido.