Deployo の概要

Deployo: モデルからAPIへ、数分で

Deployoとは?

Deployoは、機械学習のワークフローを効率化するために設計されたAIインフラストラクチャプラットフォームです。ユーザーはAIモデルを、ライブでスケーラブルなAPIとして数分で本番環境にデプロイできます。デプロイの複雑さを抽象化し、データサイエンティストや機械学習エンジニアがモデルの構築と改善に集中できるようにします。

Deployoの仕組み

Deployoは、直感的で、クラウドに依存せず、安全なプラットフォームでデプロイプロセスを簡素化します。ユーザーは、あらゆるフレームワークからあらゆるMLモデルを持ち込み、数回クリックするだけでデプロイできます。Deployoは、デプロイスクリプトの作成を自動化し、ネットワークポリシーを管理し、GPUパフォーマンスを最適化し、Swaggerエンドポイントのドキュメントを提供します。

主な機能と利点:

- 簡単なデプロイ: 数回クリックするだけでモデルをデプロイでき、複雑なデプロイスクリプトやDevOpsの専門知識は不要です。

- クラウドに依存しない: ベンダーロックインなしで、任意のクラウドプロバイダーまたはオンプレミス環境にデプロイします。

- 汎用性: あらゆるMLモデルをサポートし、Weights & BiasesやHugging Faceなどの一般的なツールと統合します。

- スケーラブル: 使用状況に基づいてコンピューティングリソースを自動的にスケールアップまたはスケールダウンし、リソースの割り当てとコストを最適化します。

- 安全: 自動ネットワークポリシー管理による安全な環境を提供します。

コア機能:

- モデルからAPIへ: モデルをライブでスケーラブルなAPIに自動的に変換します。

- GPU最適化されたパフォーマンス: GPUアクセラレーションモデルのパフォーマンスを最適化します。

- Swaggerエンドポイントドキュメント: APIドキュメントを自動的に生成します。

- 自動ネットワークポリシー管理: 安全なネットワーク構成を提供します。

- デプロイ戦略: さまざまなニーズに合わせて、さまざまなデプロイ戦略を提供します。

- 自動バージョン互換性: モデルの異なるバージョン間の互換性を保証します。

- クラウドに依存しないデプロイ: パブリッククラウドであろうと内部サーバーであろうと、どこにでもデプロイできます。

- オンプレミスVMフレンドリー: オンプレミス仮想マシンへのデプロイが簡単です。

- エンタープライズ対応環境: エンタープライズレベルのデプロイに適しています。

- マルチモデルチェーン: 複数のモデルをチェーンすることをサポートします。

- カスタムPythonパッケージのサポート: カスタムPythonパッケージの使用を許可します。

- 水平および垂直オートスケーリング: 需要に基づいてリソースを自動的にスケールします。

- サーバーレスデプロイオプション: サーバーレスデプロイオプションを提供します。

- ロードアウェア分散: ロードに基づいてトラフィックを分散します。

- リクエストバッチ処理のサポート: パフォーマンスを向上させるために、リクエストのバッチ処理をサポートします。

ユースケース:

- 迅速なプロトタイピング: テストと検証のためにモデルを迅速にデプロイします。

- 本番環境へのデプロイ: スケーラビリティと信頼性を備えた本番環境で使用するためにモデルをデプロイします。

- 内部ツール: 組織内で内部的に使用するためにモデルをデプロイします。

Deployoを始めるには?

Deployoは現在、近日公開予定です。詳細情報と早期アクセスについては、営業チームにお問い合わせください。

FAQ:

- Deployoで何ができますか? AIモデルをスケーラブルなAPIとして本番環境に迅速にデプロイできます。

- Deployoを使用するメリットは何ですか? デプロイプロセスを自動化することで、時間とリソースを節約できます。

- Deployoはチームとのコラボレーションをどのように支援しますか? Deployoは、コラボレーションとバージョン管理のためのツールを提供します。

- Deployoをデータで信頼できますか? はい、Deployoはデータのための安全な環境を提供します。

- Deployoを使用してAIモデルをどこにでもデプロイできますか? はい、Deployoはクラウドに依存せず、オンプレミスデプロイをサポートしています。

- Deployoは、より良いビジネス成果を達成するのにどのように役立ちますか? Deployoを使用すると、モデルをより迅速にデプロイできるため、モデルをより迅速に反復して改善できます。

"Deployo" のベストな代替ツール

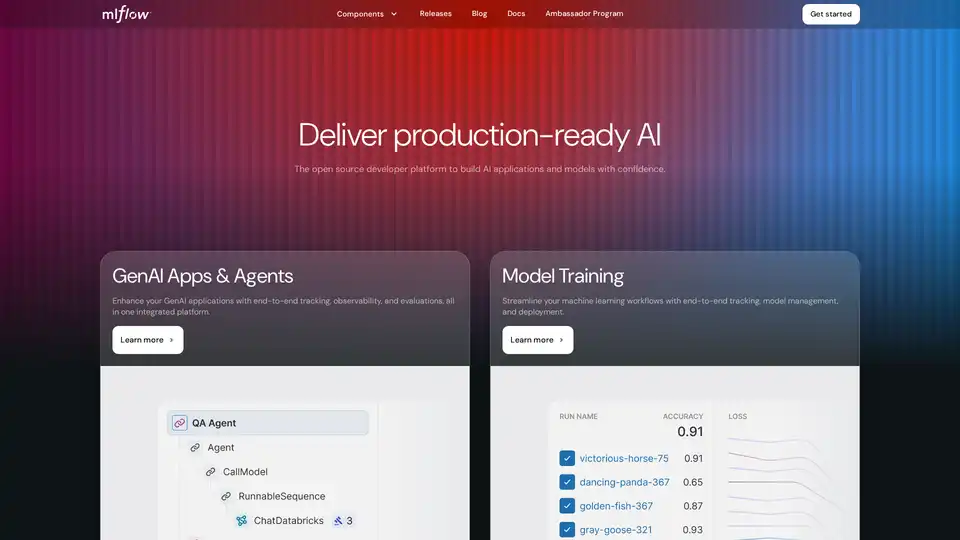

MLflow は、機械学習のライフサイクル全体を管理するために設計されたオープンソースプラットフォームです。 実験の追跡、モデルの管理、デプロイメントの合理化のためのツールを提供し、数千の組織から信頼されています。

Buzzi.aiは、業界固有のニーズに合わせた安全で統合されたAIソリューションを通じて、業務タスクを自動化し、運用効率を向上させ、成長を促進するカスタムAIエージェントを開発します。

Batteries Includedは、LLM、ベクターデータベース、Jupyter Notebookのデプロイを簡素化するセルフホストAIプラットフォームです。インフラストラクチャ上でワールドクラスのAIアプリケーションを構築します。

Lightning AIは、AIエージェント、データ、AIアプリを構築、展開、トレーニングするために設計されたオールインワンのクラウドワークスペースです。モデルAPI、GPUトレーニング、マルチクラウド展開を1つのサブスクリプションで入手できます。

LLMOps Space は、LLM 実践者のためのグローバルコミュニティです。 大規模言語モデルの本番環境へのデプロイメントに関連するコンテンツ、ディスカッション、イベントに焦点を当てています。

Hopsworks は、特徴ストアを備えたリアルタイム AI レイクハウスであり、AI パイプラインのシームレスな統合と、データおよび AI チーム向けの優れたパフォーマンスを提供します。品質を追求して構築され、主要な AI チームから信頼されています。

Addepto は、業界全体にわたるカスタム AI および機械学習ソリューションを提供し、AI コンサルティング、生成 AI 開発、ビッグデータ分析に焦点を当てて、ビジネスの変革を推進します。

Korticalは、データサイエンティスト向けに設計されたAIプラットフォームであり、エンタープライズグレードのAIソリューションを迅速に構築およびデプロイするためのAutoMLおよびML Ops機能を提供します。 コードおよびUIインターフェイスをサポートし、より高速な反復とより優れたモデルパフォーマンスを促進します。

AIビルダー向けの次世代エンタープライズスタジオで、AIモデルをトレーニング、検証、チューニング、デプロイ。IBM watsonx.aiの統合ツールでスケーラブルな生成AI開発を発見。

Centrox AI:カスタムLLMからデータアノテーションまで、フルサイクルGen AI開発サービスを提供し、あらゆる産業のAIイノベーションを支援します。

Qubinetsは、AIとビッグデータインフラストラクチャのデプロイメントと管理を簡素化するオープンソースプラットフォームです。 簡単に構築、接続、デプロイできます。 構成ではなく、コードに集中してください。

Cerebriumは、低遅延、ゼロDevOps、秒単位課金でリアルタイムAIアプリケーションのデプロイメントを簡素化するサーバーレスAIインフラストラクチャプラットフォームです。LLMとビジョンモデルをグローバルにデプロイします。

NVIDIA NIM API を利用して、主要な AI モデルの最適化された推論とデプロイメントを実現しましょう。サーバーレス API を使用してエンタープライズ生成 AI アプリケーションを構築したり、GPU インフラストラクチャでセルフホストしたりできます。

Datatureは、企業や開発者向けにデータラベリング、モデルトレーニング、デプロイメントを加速するエンドツーエンドのビジョンAIプラットフォームです。本番環境対応のデータセットを10倍高速に構築し、ビジョンインテリジェンスをシームレスに統合します。