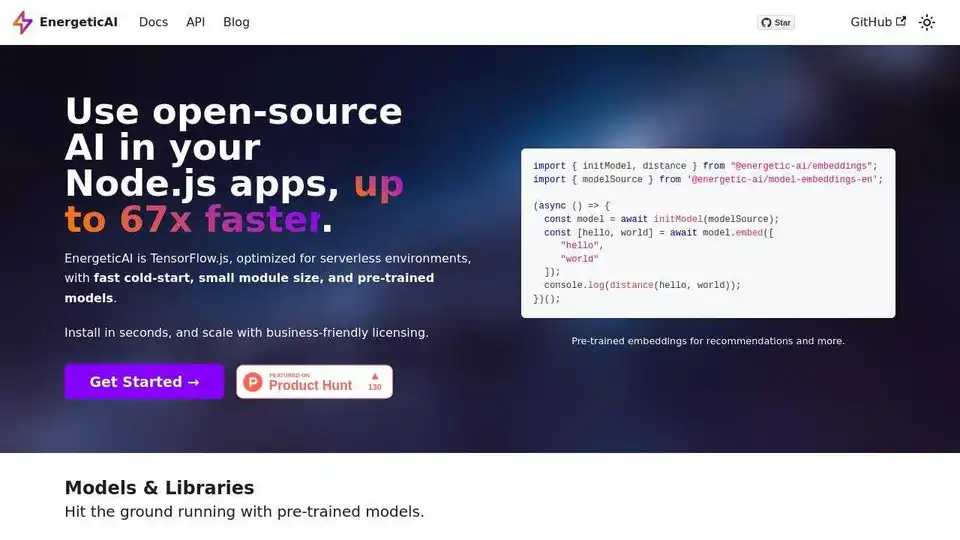

EnergeticAI の概要

EnergeticAI: オープンソース AI で Node.js アプリを強化

EnergeticAI とは?

EnergeticAI は、比類のないスピードと効率で AI の力を Node.js アプリケーションにもたらすように設計されたオープンソースライブラリです。TensorFlow.js をベースに構築された EnergeticAI は、サーバーレス環境向けに特別に最適化されており、コールドスタートとモジュールサイズの一般的な課題に対応しています。

EnergeticAI の仕組み

EnergeticAI は、いくつかの重要な最適化を通じてパフォーマンス向上を実現しています。

- 最適化された TensorFlow.js: TensorFlow.js をベースに構築されていますが、サーバーレス環境向けに微調整されています。

- 高速コールドスタート: EnergeticAI はコールドスタート時間を大幅に短縮し、サーバーレス関数のパフォーマンスにおける重要な要素となります。

- 小さなモジュールサイズ: モジュールサイズを最小限に抑えることで、EnergeticAI は迅速なデプロイメントとリソース消費の削減を保証します。

- 事前トレーニング済みモデル: 一般的な AI タスクのためにすぐに利用できる事前トレーニング済みモデルをすぐに使い始めることができます。

主な機能と利点:

- 最大 67 倍の高速化: 標準的な TensorFlow.js の実装、特にサーバーレス関数と比較して、大幅な速度向上を体験してください。

- 事前トレーニング済み埋め込み: レコメンデーションシステムとセマンティック検索アプリケーションを構築するために、事前トレーニング済みの英語埋め込みを活用してください。

- テキスト分類器: 最小限のトレーニング例でテキストをさまざまなカテゴリに分類します。

- ビジネスフレンドリーなライセンス: EnergeticAI は Apache 2.0 ライセンスであり、商用利用に柔軟性を提供します。

- 簡単なインストール: npm を使用して EnergeticAI をすばやくインストールします:

npm install @energetic-ai/core.

ユースケース:

- レコメンデーションシステム: ユーザーの好みに基づいて製品またはコンテンツの推奨を生成します。

- セマンティック検索: クエリの背後にある意味を理解する検索機能を実装します。

- テキスト分類: さまざまなアプリケーションのテキストデータを自動的に分類します。

はじめ方:

- インストール: npm を使用してコアパッケージをインストールします:

npm install @energetic-ai/core - モジュールのインポート: 必要なモジュールを Node.js コードにインポートします。

import { initModel, distance } from "@energetic-ai/embeddings";

import { modelSource } from '@energetic-ai/model-embeddings-en';

(async () => {

const model = await initModel(modelSource);

const [hello, world] = await model.embed([

"hello",

"world"

]);

console.log(distance(hello, world));

})();

パフォーマンスベンチマーク:

EnergeticAI は、Tensorflow.js と比較して、コールドスタート速度、ウォームスタート速度、モジュールサイズにおいて印象的なパフォーマンスを示しています。これにより、コールドスタートがアプリケーションの応答性に影響を与える可能性のあるサーバーレス環境に特に適しています。サーバーレス関数における推論速度は、コールドスタート速度によって支配されます。このベンチマークでは、モデルを初期化し、M1 Max Macbook Pro で 5 文の段落の埋め込みを計算します。

EnergeticAI は誰のためのものですか?

EnergeticAI は、パフォーマンスや使いやすさを犠牲にすることなく、AI 機能をアプリケーションに統合したい Node.js 開発者向けに設計されています。サーバーレス環境にデプロイされたプロジェクトに特に役立ちます。

EnergeticAI が重要な理由は何ですか?

サーバーレス環境では、コールドスタートが AI を活用したアプリケーションのパフォーマンスに大きな影響を与える可能性があります。EnergeticAI は、サーバーレス関数向けに TensorFlow.js を最適化することでこの問題に対処し、より高速な応答時間とより良いユーザーエクスペリエンスを保証します。

詳しくはこちら:

- ドキュメント: EnergeticAI の使用に関する詳細については、公式ドキュメントを参照してください。

- GitHub: GitHub でソースコードを調べて、プロジェクトに貢献してください。

EnergeticAI は、開発者がスピードと効率でインテリジェントなアプリケーションを構築できるようにします。コールドスタートとモジュールサイズの課題に対処することで、EnergeticAI はサーバーレス環境で作業する Node.js 開発者にとって AI をよりアクセスしやすく、実用的にします。

"EnergeticAI" のベストな代替ツール

Synexa を使用して AI のデプロイを簡素化します。わずか 1 行のコードで、強力な AI モデルを瞬時に実行できます。高速、安定、開発者フレンドリーなサーバーレス AI API プラットフォーム。

Pipedreamは、API、AI、データベースを接続してワークフローを自動化するためのローコード統合プラットフォームです。AIエージェントと統合を簡単に構築およびデプロイできます。

Graphlitは、単一のAPIを通じてコンテンツの取り込み、セマンティック検索、AI駆動の検索を提供する、AIのためのセマンティックメモリプラットフォームです。開発者がAIメモリを効率的に構築および維持するのに役立ちます。

Yugo は、API の自動分析、パーソナライズされた機能の推奨、およびワンクリックの実装により、AI とウェブサービスの統合を簡素化し、開発者が効率的に先進的なアプリケーションを構築できるようにします。