Featherless.ai

Visão geral de Featherless.ai

O que é Featherless.ai?

Featherless.ai é um provedor de hospedagem LLM sem servidor que oferece acesso a uma vasta biblioteca de modelos de código aberto do Hugging Face. Esqueça as complexidades do gerenciamento de servidores e das despesas gerais operacionais; o Featherless cuida de tudo, permitindo que você se concentre em aproveitar a IA para seus projetos.

Características principais:

- Vasto catálogo de modelos: Acesse mais de 11.900 modelos de código aberto.

- Inferência sem servidor: Implante modelos sem gerenciar servidores.

- Preços fixos: Faturamento previsível com tokens ilimitados.

- Baixa latência: Beneficie-se do carregamento avançado de modelos e da orquestração de GPU.

- Compatibilidade com LangChain: Potencialize seus aplicativos com Featherless usando a compatibilidade com OpenAI SDK.

Como usar Featherless.ai?

- Inscreva-se: Crie uma conta em Featherless.ai.

- Explore os modelos: Navegue pelo vasto catálogo de modelos.

- Implante: Implante instantaneamente modelos para ajuste fino, teste ou produção.

- Integre: Use a API para integrar modelos em seus aplicativos.

Por que escolher Featherless.ai?

Featherless.ai oferece uma alternativa atraente a outros provedores, combinando um vasto catálogo de modelos com infraestrutura sem servidor e preços previsíveis. É a solução ideal para equipes de IA que desejam aproveitar o poder dos modelos de código aberto sem o incômodo do gerenciamento de servidores.

Casos de uso:

- OpenHands: Agilize o desenvolvimento de software com tarefas de codificação baseadas em IA.

- NovelCrafter: Melhore a escrita criativa com assistência de IA durante todo o processo de escrita de romances.

- WyvernChat: Crie personagens únicos com personalidades personalizadas usando uma ampla variedade de modelos de código aberto.

Preços:

Featherless.ai oferece três planos de preços:

- Feather Basic: US$ 10/mês para modelos com até 15 bilhões de parâmetros.

- Feather Premium: US$ 25/mês para acesso aos modelos DeepSeek e Kimi-K2.

- Feather Scale: US$ 75/mês para planos de negócios com simultaneidade escalonável.

Perguntas frequentes:

O que é Featherless?

Featherless é um provedor de hospedagem LLM que oferece acesso a uma biblioteca em constante expansão de modelos HuggingFace.

Vocês registram meu histórico de bate-papo?

Não, os prompts e conclusões enviados à nossa API não são registrados.

Quais arquiteturas de modelos são suportadas?

Uma ampla variedade de modelos de lhama é suportada, incluindo Llama 2 e 3, Mistral, Qwen e DeepSeek.

Para obter mais detalhes, visite Featherless.ai e explore a documentação.

Melhores ferramentas alternativas para "Featherless.ai"

A Avian API oferece a inferência de IA mais rápida para LLMs de código aberto, atingindo 351 TPS no DeepSeek R1. Implante qualquer LLM HuggingFace com uma velocidade de 3 a 10 vezes maior com uma API compatível com OpenAI. Desempenho e privacidade de nível empresarial.

Habilite a inferência LLM eficiente com llama.cpp, uma biblioteca C/C++ otimizada para diversos hardwares, com suporte a quantização, CUDA e modelos GGUF. Ideal para implantação local e em nuvem.

Plataforma de IA ultrarrápida para desenvolvedores. Implante, ajuste e execute mais de 200 LLMs e modelos multimodais otimizados com APIs simples - SiliconFlow.

Phala Cloud oferece uma infraestrutura de nuvem de código aberto e sem confiança para implementar agentes de IA e aplicações Web3, alimentada por TEE. Garante privacidade, escalabilidade e é regido por código.

Deep Infra é uma plataforma de inferência IA escalável e de baixo custo com +100 modelos ML como DeepSeek-V3.2, Qwen e ferramentas OCR. APIs amigáveis para desenvolvedores, aluguel de GPUs e retenção zero de dados.

Awan LLM fornece uma plataforma de API de inferência LLM ilimitada, irrestrita e econômica. Permite que usuários e desenvolvedores acessem modelos LLM poderosos sem limitações de tokens, ideal para agentes de IA, roleplay, processamento de dados e conclusão de código.

Confident AI é uma plataforma de avaliação LLM construída sobre DeepEval, capacitando equipes de engenharia a testar, comparar, proteger e aprimorar o desempenho de aplicativos LLM. Oferece métricas e guardrails de ponta, além de observabilidade para otimizar sistemas de IA e detectar regressões.

Batteries Included é uma plataforma de IA auto-hospedada que simplifica a implantação de LLMs, bases de dados vetoriais e Jupyter notebooks. Crie aplicações de IA de classe mundial em sua infraestrutura.

Falcon LLM é uma família de modelos de linguagem grandes generativos de código aberto da TII, com modelos como Falcon 3, Falcon-H1 e Falcon Arabic para aplicações de IA multilíngues e multimodais que rodam eficientemente em dispositivos do dia a dia.

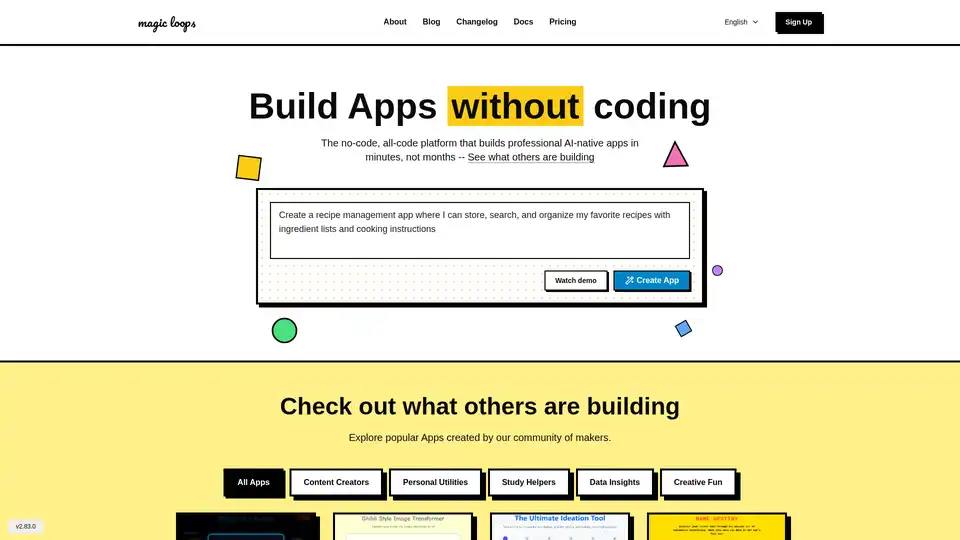

Magic Loops é uma plataforma sem código que combina LLMs e código para construir apps nativos de IA profissionais em minutos. Automatize tarefas, crie ferramentas personalizadas e explore apps da comunidade sem habilidades de codificação.

Vext cria soluções de IA personalizadas para empresas, incluindo aplicações LLM, ajuste fino de modelos, hospedagem gerenciada e serviços de API personalizadas.

Crie aplicativos de dados com tecnologia de IA em minutos com Morph. Estrutura Python + hospedagem com autenticação integrada, conectores de dados, CI/CD.

Lunary é uma plataforma de engenharia LLM de código aberto que fornece observabilidade, gestão de prompts e análises para construir aplicações de IA confiáveis. Oferece ferramentas para depuração, rastreamento de desempenho e garantia de segurança de dados.

Athina é uma plataforma colaborativa de IA que ajuda as equipes a construir, testar e monitorar recursos baseados em LLM 10 vezes mais rápido. Com ferramentas para gerenciamento de prompts, avaliações e observabilidade, garante a privacidade de dados e suporta modelos personalizados.