llama.cpp

Visão geral de llama.cpp

llama.cpp: Sua Biblioteca Essencial para Inferência de LLM em C/C++

lama.cpp é uma biblioteca de código aberto poderosa, projetada para permitir a inferência eficiente de Modelos de Linguagem Grandes (LLM) usando C/C++. Otimizada para uma ampla gama de hardware, desde máquinas locais até implementações em nuvem, ela se destaca por sua configuração mínima e desempenho de ponta.

O que é llama.cpp?

lama.cpp é um projeto focado em realizar inferência de LLM em C/C++. É projetado para fornecer excelente desempenho em diversas configurações de hardware com dependências mínimas.

Principais Recursos e Benefícios

- Implementação Simples em C/C++: Elimina dependências externas, simplificando a implementação.

- Otimização para Apple Silicon: Aproveita os frameworks ARM NEON, Accelerate e Metal para desempenho máximo em dispositivos Apple.

- Suporte à Arquitetura x86: Inclui suporte a AVX, AVX2, AVX512 e AMX para desempenho otimizado em CPUs x86.

- Quantização: Suporta quantização de inteiros de 1,5 bit a 8 bits, reduzindo o uso de memória e acelerando a inferência.

- Aceleração de GPU: Kernels CUDA personalizados fornecem execução eficiente de LLM em GPUs NVIDIA. Também suporta GPUs AMD via HIP e GPUs Moore Threads via MUSA.

- Inferência Híbrida CPU+GPU: Facilita o uso de modelos maiores do que a VRAM disponível, distribuindo a carga de trabalho entre CPU e GPU.

- Múltiplos Backends: Suporta Metal, BLAS, BLIS, SYCL, MUSA, CUDA, HIP, Vulkan, CANN, OpenCL, IBM zDNN e WebGPU (em andamento).

Como funciona o llama.cpp?

lama.cpp funciona implementando a inferência de LLM diretamente em C/C++. Essa abordagem reduz a sobrecarga e permite um controle preciso sobre os recursos de hardware. A biblioteca é projetada para ser modular, com diferentes backends otimizados para várias plataformas de hardware. Ela usa técnicas como quantização para reduzir a pegada de memória dos modelos, tornando possível executar modelos grandes em dispositivos com recursos limitados.

Como usar o llama.cpp?

Instalação:

- Usando Gerenciadores de Pacotes: Instale via brew, nix ou winget.

- Docker: Use as imagens Docker fornecidas.

- Binários Pré-compilados: Baixe os binários da página de releases.

- Compilar do Código Fonte: Clone o repositório e siga o guia de compilação.

Obtenção de Modelos:

- Baixe modelos GGUF do Hugging Face ou de outros sites de hospedagem de modelos.

- Converta modelos para o formato GGUF usando os scripts Python fornecidos.

Executando a Inferência:

- Use a ferramenta

llama-clipara experimentação. - Implante um servidor HTTP local usando

llama-serverpara compatibilidade com a API OpenAI.

- Use a ferramenta

Comandos de Exemplo:

## Use a local model file

llama-cli -m my_model.gguf

## Or download and run a model directly from Hugging Face

llama-cli -hf ggml-org/gemma-3-1b-it-GGUF

## Launch OpenAI-compatible API server

llama-server -hf ggml-org/gemma-3-1b-it-GGUF

Para quem é o llama.cpp?

lama.cpp é ideal para:

- Desenvolvedores: Implementando aplicações alimentadas por LLM com C/C++.

- Pesquisadores: Experimentando com LLMs em várias plataformas de hardware.

- Hobbistas: Executando LLMs em computadores e dispositivos pessoais.

- Organizações: Implantando LLMs em ambientes de produção com sobrecarga mínima.

Aplicações Práticas de llama.cpp

lama.cpp pode ser usado em vários cenários, incluindo:

- Inferência de LLM Local: Execute modelos em computadores pessoais sem depender de serviços de nuvem.

- Computação de Borda: Implante LLMs em dispositivos de borda para aplicações de baixa latência.

- Aplicações Móveis: Integre LLMs em aplicativos móveis para processamento no dispositivo.

- Soluções de IA Personalizadas: Construa soluções de IA personalizadas adaptadas a ambientes de hardware e software específicos.

Por que escolher llama.cpp?

lama.cpp fornece uma combinação única de desempenho, flexibilidade e facilidade de uso, tornando-o uma excelente escolha para inferência de LLM. Suas principais vantagens incluem:

- Desempenho Otimizado: Projetado para desempenho máximo em uma ampla gama de hardware.

- Dependências Mínimas: Simplifica a implementação e reduz o risco de conflitos.

- Suporte à Quantização: Permite o uso de modelos grandes em dispositivos com recursos limitados.

- Comunidade Ativa: Beneficia-se do desenvolvimento contínuo e do suporte da comunidade.

- Ferramentas Versáteis: inclui ferramentas como

llama-cli,llama-server,llama-perplexityellama-benchpara vários casos de uso.

Backends Suportados

lama.cpp suporta vários backends, visando uma ampla gama de dispositivos:

| Backend | Target Devices |

|---|---|

| Metal | Apple Silicon |

| BLAS | All |

| BLIS | All |

| SYCL | Intel and Nvidia GPU |

| MUSA | Moore Threads GPU |

| CUDA | Nvidia GPU |

| HIP | AMD GPU |

| Vulkan | GPU |

| CANN | Ascend NPU |

| OpenCL | Adreno GPU |

| IBM zDNN | IBM Z & LinuxONE |

| WebGPU | All (In Progress) |

| RPC | All |

Como contribuir para o llama.cpp

Contribuições para llama.cpp são bem-vindas! Você pode contribuir por:

- Abrir pull requests com correções de bugs ou novos recursos.

- Colaborar em problemas e projetos existentes.

- Ajudar a gerenciar problemas, PRs e projetos.

- Melhorar a documentação e os exemplos.

O que é GGUF?

GGUF é um formato de arquivo exigido pelo llama.cpp para armazenar modelos. Modelos em outros formatos de dados podem ser convertidos para GGUF usando os scripts Python convert_*.py no repositório.

Conclusão

lama.cpp é uma biblioteca versátil e poderosa que torna a inferência de LLM acessível a um público amplo. Seja você um desenvolvedor, pesquisador ou hobbista, llama.cpp fornece as ferramentas e a flexibilidade necessárias para aproveitar o poder dos LLMs em seu hardware de escolha. Com seu foco em desempenho, facilidade de uso e suporte da comunidade, llama.cpp está posicionado para permanecer um player-chave no cenário de rápida evolução da inferência de IA.

Para mais informações, visite o repositório llama.cpp GitHub.

Melhores ferramentas alternativas para "llama.cpp"

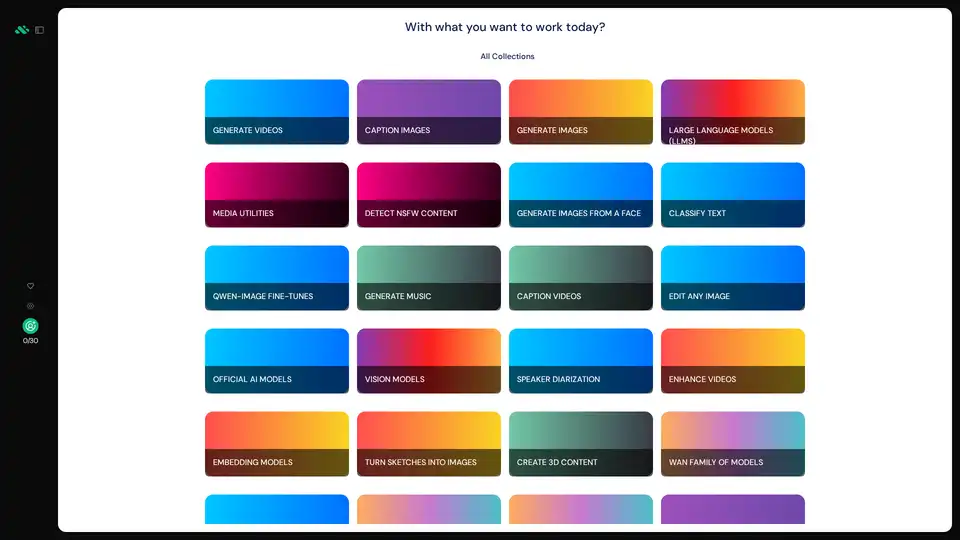

AI Runner é um mecanismo de inferência de IA offline para arte, conversas de voz em tempo real, chatbots alimentados por LLM e fluxos de trabalho automatizados. Execute geração de imagens, chat de voz e muito mais localmente!

Friendli Inference é o mecanismo de inferência LLM mais rápido, otimizado para velocidade e custo-benefício, reduzindo os custos de GPU em 50-90%, oferecendo alto rendimento e baixa latência.

Plataforma de IA ultrarrápida para desenvolvedores. Implante, ajuste e execute mais de 200 LLMs e modelos multimodais otimizados com APIs simples - SiliconFlow.

AIverse é uma plataforma tudo-em-um que concede acesso a milhares de modelos de IA para geração de imagens/vídeos, LLMs, fala para texto, criação de música e mais. Uso ilimitado por US$ 20/mês.

xTuring é uma biblioteca open-source que capacita os usuários a personalizar e fazer fine-tuning de Modelos de Linguagem Grandes (LLMs) de forma eficiente, focando em simplicidade, otimização de recursos e flexibilidade para personalização de IA.

Sagify é uma ferramenta Python de código aberto que simplifica pipelines de ML no AWS SageMaker, com uma Gateway LLM unificada para integração perfeita de modelos de linguagem grande proprietários e open-source.

Selene da Atla AI fornece avaliações precisas sobre o desempenho do seu aplicativo de IA. Explore os modelos LLM Judge de código aberto para obter precisão líder do setor e avaliação de IA confiável.

LlamaChat é um aplicativo macOS que permite que você converse com modelos LLaMA, Alpaca e GPT4All localmente no seu Mac. Baixe agora e experimente o bate-papo LLM local!

Spice.ai é um mecanismo de inferência de dados e IA de código aberto para construir aplicativos de IA com federação de consultas SQL, aceleração, busca e recuperação baseadas em dados empresariais.

Deep Infra é uma plataforma de inferência IA escalável e de baixo custo com +100 modelos ML como DeepSeek-V3.2, Qwen e ferramentas OCR. APIs amigáveis para desenvolvedores, aluguel de GPUs e retenção zero de dados.

Falcon LLM é uma família de modelos de linguagem grandes generativos de código aberto da TII, com modelos como Falcon 3, Falcon-H1 e Falcon Arabic para aplicações de IA multilíngues e multimodais que rodam eficientemente em dispositivos do dia a dia.

Firecrawl é a API líder de rastreamento, raspagem e busca na web projetada para aplicativos de IA. Ela transforma sites em dados limpos, estruturados e prontos para LLM em escala, alimentando agentes de IA com extração web confiável sem proxies ou dores de cabeça.

Meteron AI é um conjunto de ferramentas de IA tudo-em-um que lida com medição, balanceamento de carga e armazenamento de LLM e IA generativa, libertando os desenvolvedores para se concentrarem na criação de produtos alimentados por IA.

Execute instantaneamente qualquer modelo Llama do HuggingFace sem configurar nenhum servidor. Mais de 11.900 modelos disponíveis. A partir de US$ 10/mês para acesso ilimitado.