MCP Server 架构与工作原理详解:从协议到执行流程

AI 系统发展到现在,正变得日益复杂,传统的 API 调用范式(如独立 HTTP 请求、供应商 SDK)在构建复杂的AI Agent系统时面临着开发效率低、安全风险高和可维护性差等挑战。比如:每个 API 独立定义,缺乏统一标准;不同模型提供各自不同的函数调用规范;缺乏高效的能力发现和动态集成机制等。

Model Context Protocol(MCP) 的出现,旨在解决这些问题,通过协议层面的标准化设计引入一种可扩展的、跨服务的工具与资源调用机制,使 AI 代理能够与外部系统稳健协作。MCP的设计理念核心在于协议抽象与职责分离,它并不规定具体的实现,而是定义了AI应用与外部能力之间交互的通用语言。

本文章围绕 MCP Server 架构、协议原理及其执行流程进行权威详解,重点解释为何采用协议层而非 SDK,以及 MCP 如何支撑现代智能系统的可扩展工具调用。

适宜的阅读人群:

- 技术爱好者和入门级学习者

- 寻求效率提升的职场人士与管理者

- 企业决策者与业务部门负责人

- 对AI未来发展趋势感兴趣的普通用户

本文目录:

- 1. MCP 协议核心设计理念

- 2. MCP核心组件

- 3. MCP vs 传统API集成方案:架构范式

- 4. MCP Server 如何与 AI Agent 协作

- 5. MCP Server 的三大能力原语

- 6. MCP Client、Server、LLM 的通信关系

- 7. MCP Server 的完整调用流程

- 8. MCP 与传统 API / Function Calling 的模型接口层差异

- 9. MCP 的局限性与挑战

- 总结

- MCP 常见问题(FAQ)

1. MCP 协议核心设计理念

MCP选择了协议层抽象,其核心优势在于**:标准化、语言无关、通用性强**。而非提供统一的SDK。这意味着任何实现了MCP协议规范的程序,无论使用何种编程语言或框架,都可以相互通信。这种设计最大化了生态的开放性和互操作性。协议通信基于 JSON-RPC 2.0, 这是一种轻量级的远程过程调用协议,其结构化的请求和响应格式非常适合机器之间的自动化交互。

通信消息格式

MCP 使用JSON-RPC 2.0 作为基础消息格式与通信规范。

JSON-RPC 是一种轻量级、传输无关的远程过程调用(RPC)协议,使用 JSON 作为消息格式,可承载在不同传输层之上,如 STDIO、HTTP 等。

JSON-RPC 在 MCP 中负责:

定义请求/响应消息结构;

标准化方法调用(如

initialize、tools/list、tools/call);提供可扩展的错误与批处理机制。

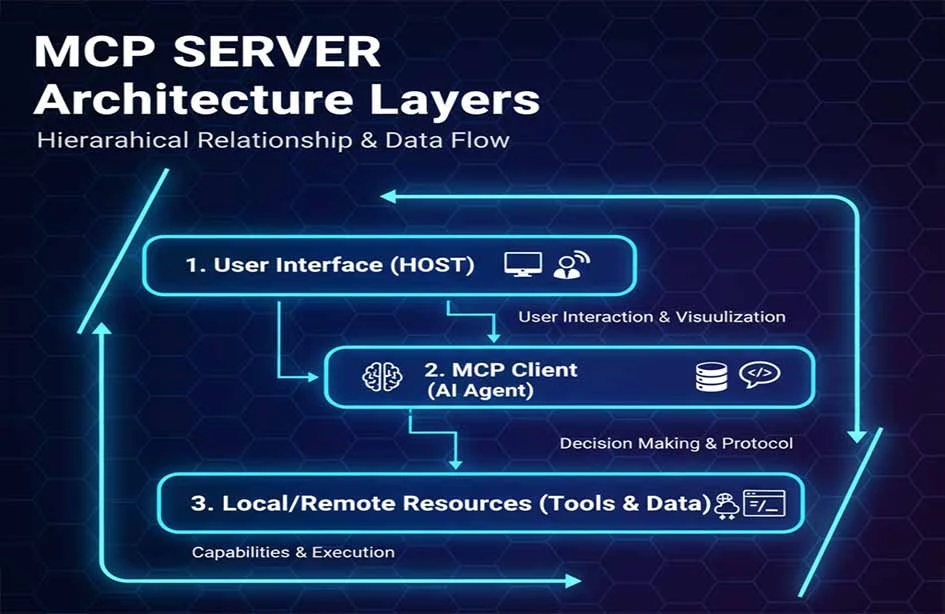

三层架构模型

MCP 采用三层架构模型:MCP Client,MCP Server,Resource/Tool。

| MCP Hosts |

|---|

| MCP Clients |

| MCP Servers |

MCP 主机(MCP Hosts) :发起请求的 LLM 应用程序(例如 Claude Desktop、IDE 或 AI 工具)。

MCP 客户端(MCP Clients) :在主机程序内部,与 MCP server 保持 1:1 的连接。

MCP 服务器(MCP Servers) :为 MCP client 提供上下文、工具和 prompt 信息。

这一分层设计大大的降低了模块之间的耦合度与提高MCP Server的可扩展性。

2. MCP核心组件

Transport 层 MCP 标准传输包含 STDIO 和 HTTP + Server-Sent Events (SSE),其中 SSE 提供从服务器到客户端的流式消息能力。 MCP 目前定义了两种用于客户端-服务器通信的标准传输机制:

STDIO :安全与性能优先 。MCP Server作为子进程启动,与AI应用同机运行,本地进程间通信,延迟低、部署简单。所有通信不经过网络,避免了凭证和数据的网络传输风险。这是Claude Desktop等个人生产力工具集成本地能力的首选方式。

HTTP with Server-Sent Events (SSE) :可访问性与扩展性优先 。MCP Server作为网络服务部署,可被多个远程Client访问,通过 HTTP/POST 搭配 JSON-RPC 实现消息传输。这适用于企业内共享的能力中台或SaaS服务。HTTPS和标准HTTP认证机制提供了安全基础。

这种机制使 MCP 能支持简单工具调用,也能适配大型分布式 Server。选择标准取决于运行场景。对于本地子进程通信,STDIO 更高效;对于远程集群部署,HTTP 具备更好扩展性。

协议层

在协议层,MCP 借助 JSON-RPC 2.0 规范定义一系列标准方法,例如:

- 初始化连接(

initialize); - 能力发现(

tools/list); - 工具调用(

tools/call)。

这种变体设计保持了 JSON-RPC 的核心协议结构,同时引入了 MCP 特定的通信语义。 JSON-RPC Tools

安全与身份认证

MCP 本身并不直接提供安全机制。安全设计依赖于具体的 MCP Server 在实现时采用成熟的方案,例如:

- HTTPS/TLS 加密传输;

- OAuth2、API Key、mTLS 等身份认证机制;

- 最小权限授权控制。

这意味着 MCP 协议本身不包含安全规格,而是由 Server 实现者负责设计与整合第三方安全体系。例如,某些企业级平台会将 MCP 与企业身份管理系统集成,以实现安全访问控制与策略治理,同时确保审计与追踪功能。

扩展性与插件架构

MCP的扩展性天然源于其协议设计。开发一个“自定义工具”就是开发一个实现了MCP协议的Server程序。这个Server在启动并连接到AI应用(MCP Client)时,会通过标准的tools/list方法动态注册其提供的工具列表。AI应用无需预先配置或重新编译,即可发现和使用这些新能力,实现了真正的即插即用。

MCP Server 通常内置机制用于:

- 自定义工具的开发;

- 动态注册/发现工具及能力;

- 支持通过插件扩展行为,无需修改协议核心。

工具生命周期与会话管理

MCP连接的生命周期始于initialize握手,终于连接关闭。在此期间,通过同一连接进行的所有工具调用和资源读取共享一个逻辑会话。对于需要服务多个独立用户或会话的MCP Server(特别是HTTP模式),其实现需要自行管理不同客户端或请求之间的状态隔离。

MCP Server 需要管理:

- 会话上下文: 用于多个调用之间保存状态;

- 隔离机制: 确保不同客户端的会话彼此隔离,防止信息泄露或状态污染。

这种管理有利于支持长会话、多步骤操作等高级用例。

系统性能与可靠性设计

作为轻量级协议,MCP的性能很大程度上取决于Server实现的效率和网络延迟。对于高可用性需求,可以通过部署多个MCP Server实例并结合负载均衡器来实现。MCP协议定义了logging接口,Server可以将执行日志发送给Client,这是实现审计的基础。

MCP Server 的设计通常包括:

- 负载均衡: 用于多副本部署;

- 故障恢复: 保证 Server 高可用;

- 日志与审计机制:用于追踪调用历史与错误诊断。

这些机制提升企业级使用场景的稳健性。

与生态集成模式

为了适配现代云原生环境,MCP Server 常与 Kubernetes 、云负载均衡等协作,实现自动扩缩与弹性伸缩部署。MCP Server可以被封装为容器镜像,部署在Kubernetes等云原生平台上。这允许对MCP Server进行弹性扩缩容、健康检查和集中管理,使其能够融入现代的企业基础设施栈。

3. MCP vs 传统API集成方案:架构范式

相比传统 API 独立集成方式,MCP 利用协议抽象提升了安全、维护性与跨平台能力。

| 特性 | MCP Server | 传统 API 集成 | 插件系统 | SDK 模式 |

|---|---|---|---|---|

| 标准化程度 | 行业协议标准 | 每个 API 不同 | 平台特定 | 供应商特定 |

| 开发成本 | 低(一次实现) | 高 | 中等 | 高 |

| 维护复杂度 | 低 | 非常高 | 中等 | 高 |

| 跨平台能力 | 优秀 | 差 | 差 | 差 |

| 安全模型 | 统一权限控制 | 分散管理 | 平台控制 | 分散管理 |

| 实时性支持 | 原生支持 | 需轮询/Webhook | 有限 | 需定制 |

| 社区生态 | 快速增长 | 碎片化 | 封闭 | 供应商锁定 |

4. MCP Server 如何与 AI Agent 协作

在一个典型的基于规划的AI Agent架构中,包含Planner(规划器)、Executor(执行器)和Memory(记忆)等组件。MCP Server在此架构中扮演着标准化执行后端的角色。

- Planner: (通常是LLM)根据输入制定策略。它从MCP Client处获取当前所有可用的

Tools列表及其功能描述。Planner基于对工具能力的理解,规划出一个步骤序列(例如:“先调用A工具查询数据,再调用B工具处理结果”) - Executor: (通常是MCP Client)根据规划,通过MCP协议向相应的MCP Server发起

tools/call请求。 - Memory: 状态与上下文存储,Executor执行结果返回给Agent,可以被存入Memory,并作为下一步规划的依据。同时,

Resources原语可以主动为Agent提供任务相关的背景知识。

MCP Server 充当 Executor 端能力 Provider,通过标准协议让 Planner 访问工具与资源。

MCP 在 AI Agent 架构中的位置类似操作系统调用外部服务的接口层,使能力执行统一标准化。

MCP与LangChain、AutoGen等框架是互补关系。这些框架提供了构建AI Agent工作流的高级抽象和编排能力,而MCP则可以作为这些框架底层标准化、统一化的工具执行层。它解决了这些框架在集成具体工具时仍需面对“胶水代码”和碎片化的问题。

5. MCP Server 的三大能力原语

这是MCP协议核心的数据模型,决定了AI应用能与Server如何交互。

- Tools:对外可调用的功能,比如搜索、数据库操作。每个Tool有明确的名称、描述和输入参数JSON Schema。AI模型在认为需要时发起调用。例如,一个

send_email工具。 - Resources:对外可访问的数据源,如文件系统、对象存储等。每个Resource有一个URI和MIME类型。AI应用可以根据需要读取其内容,注入到给模型的提示中。例如,一个

file:///reports/weekly.md资源或一个能查询数据库的模板URI。 - Prompts:预定义的模板或语境,用于辅助语言模型决策。它是一种预定义的提示词结构,用户可以方便地调用它以启动特定任务。例如,一个“计划周末旅行”的Prompt,它会自动引导模型使用相关的旅行工具和资源。

这样的三层能力原语设计,使得 MCP Server 能够清晰表达其可执行功能,同时支持客户端动态发现。另外,MCP 协议还允许服务器请求客户端进行模型生成(LLM sampling)的能力扩展。它允许 MCP Server 在自己执行逻辑过程中向 Client 请求模型生成内容,使 Server 能使用 Client 执行 LLM 推理(生成)。支持 Sampling 的客户端必须在初始化时声明该能力才能使用该功能。

6. MCP Client、Server、LLM 的通信关系

理解三者关系是理解MCP工作流的关键:

- 谁发起连接? MCP Client(集成在AI应用内)主动向MCP Server发起连接。

- 谁决策调用? LLM(在AI应用内)根据内部策略逻辑做出决策。MCP Client将可用工具列表作为上下文提供给LLM,LLM根据用户请求和对话历史,决定是否调用、调用哪个工具以及传入什么参数。

- 谁执行操作? MCP Server 调用相应的 Service 或资源。它接收来自MCP Client的标准化

tools/call请求,将其转化为对底层真实系统(数据库、API、文件)的具体操作,并将结果标准化后返回。

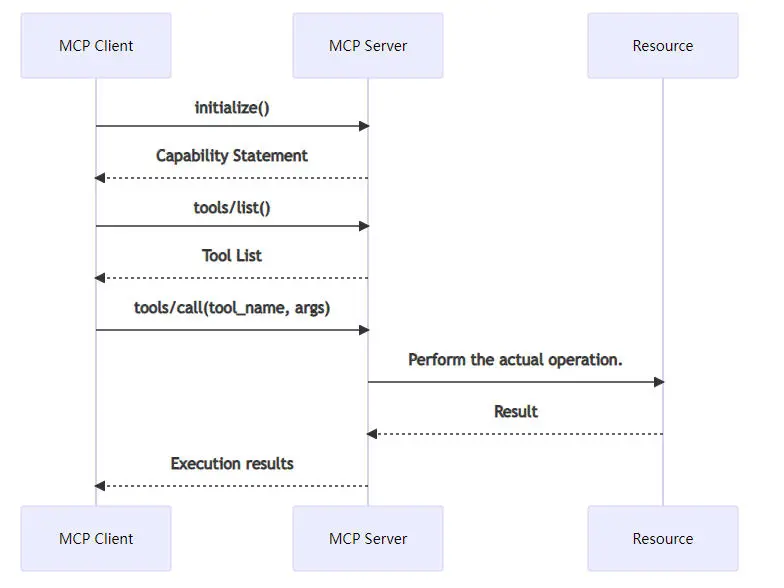

7. MCP Server 的完整调用流程

典型流程包含:

- 初始化:Client与Server建立连接,交换协议版本和支持的能力。

- 能力发现:Client通过

tools/list等方法,获取Server提供的Tools、Resources等清单。 - 工具调用:LLM决策后,Client通过

tools/call发起请求。Server执行实际操作。 - 结果回注:Server返回结构化结果,Client将其提供给LLM,用于生成最终回答或规划下一步。

典型的调用协议时序示意图:

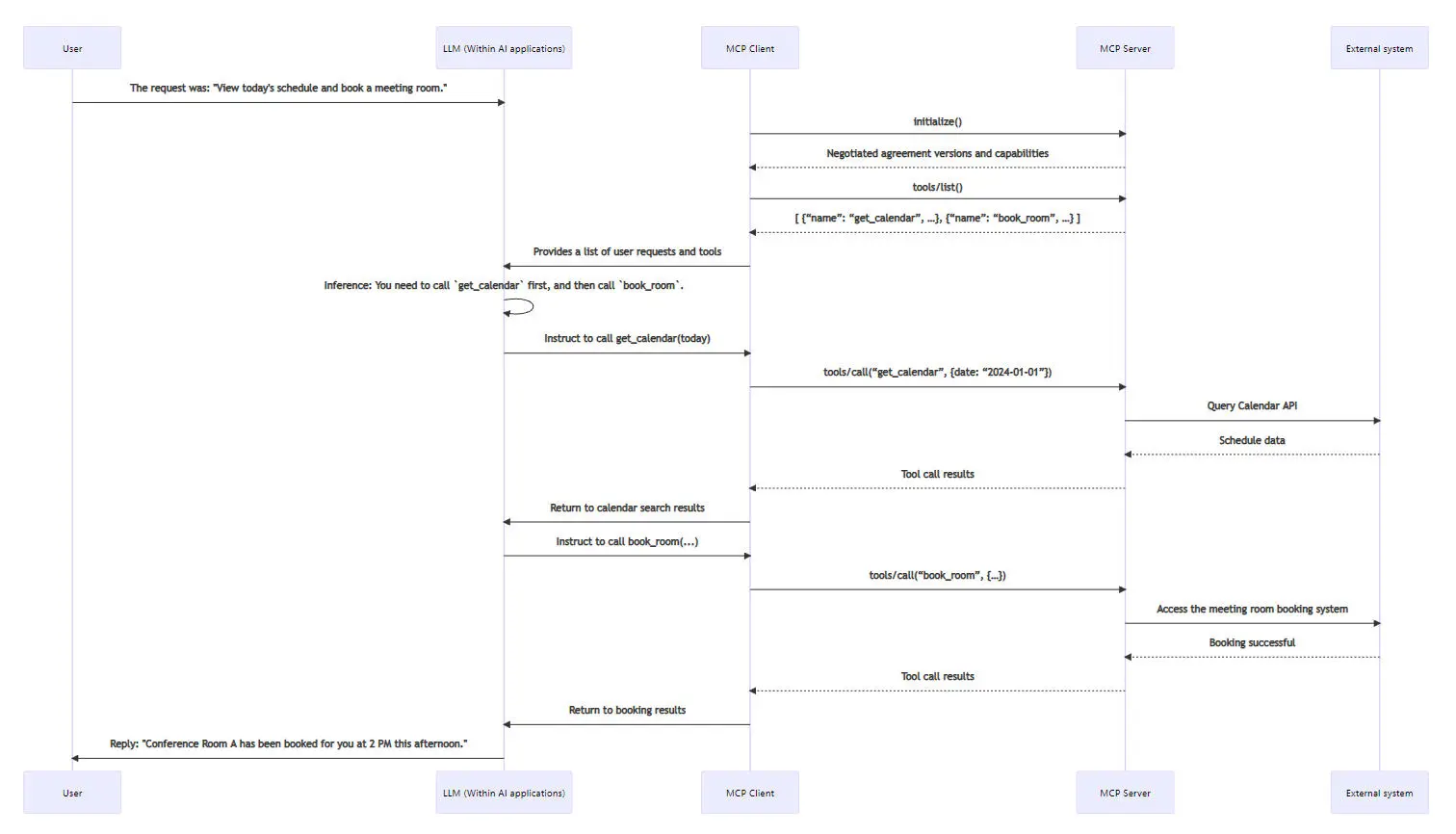

以下是一个简化的会议室预定案例调用时序图,展示了从初始化到执行的核心协议交互:

8. MCP 与传统 API / Function Calling 的模型接口层差异

传统 API 集成通常依赖供应商定义的规范与 SDK,而 MCP 将调用行为抽象成 JSON-RPC 方法,使得客户端与 Server 之间保持清晰标准的接口,不再依赖特定 SDK。

传统Function Calling

传统Function Calling是特定模型供应商提供的一种能力。开发者按照该供应商的格式定义函数,该模型学会在合适的时候输出符合该格式的调用请求。它绑定于该模型的专有接口。

MCP架构

MCP协议是一个与模型无关的开放协议。它定义了一套通用的、标准化的能力描述和调用格式。任何支持MCP的AI应用(无论底层使用OpenAI、Anthropic还是开源模型)都可以与任何MCP Server交互。它将工具集成从模型供应商的锁定中解放出来。

MCP 在大规模、多模型、多服务的生态中更适合长期维护和生态建设。

适用边界:如果仅使用单一模型且工具需求简单固定,Function Calling可能足够。若要构建涉及多模型、多工具、且需要长期维护和扩展的复杂Agent系统,MCP提供的标准化和解耦优势将至关重要。

9. MCP 的局限性与挑战

尽管 MCP Server 为 AI Agent 提供了一种更标准化、可组合的工具与资源交互方式,但它并非一个“全能解决方案”。理解 MCP 当前不解决什么问题,以及在真实工程环境中可能面临的挑战,对于合理使用该协议同样重要。

1. 多 MCP Server 并存下的能力冲突与治理问题

在复杂系统中,往往会同时接入多个 MCP Server,不同 Server 可能暴露出语义相近或功能重叠的工具(Tools)。

MCP 协议本身仅负责能力的声明与调用规范,并不包含以下能力:

- 工具优先级排序

- 工具冲突检测或消解

- 基于上下文的最优工具选择策略

这意味着,当多个 Server 提供相似能力时:决策责任完全落在 MCP Client 或 AI Agent 层,Planner 或策略模块需要自行实现工具选择与治理逻辑。因此,MCP 更像是“能力暴露与通信层”,而不是“智能调度或仲裁系统”。

2. 长上下文与多轮工具调用带来的上下文压力

在 Agent 场景中,一个完整任务往往涉及多轮流程:

- 规划(Planning)

- 多次工具调用(tools/call)

- 执行结果回注入(Result Injection)

- 再次推理与决策

这些过程会持续向 LLM 的上下文窗口中追加信息。

需要明确的是:

- MCP 不负责上下文裁剪、压缩或摘要

- 也不内置任何 Memory 管理或上下文优化机制

在长任务或高复杂度 Agent 中,这可能带来:

- Token 成本快速上升

- 上下文窗口逼近模型上限

- 早期关键信息被“淹没”

因此,上下文管理(如摘要、分段记忆、外部记忆存储)仍然是 Agent 架构层必须解决的问题,而非 MCP 协议的职责范围。

3. 跨语言实现成熟度存在差异

虽然 MCP 协议本身是语言无关的,但在实际生态中,不同语言的实现成熟度并不一致:

- JavaScript / Node.js、Python 生态最为成熟

- Rust、Go、Java 等语言实现仍在持续演进

- 不同实现对最新规范的支持程度可能存在差异

这在工程实践中意味着:

- 多语言团队需要关注实现与规范的一致性

- 在生产环境中选择 MCP Server 实现时,需要评估其稳定性与维护活跃度

这种差异并非 MCP 独有,而是任何新兴协议在早期生态阶段的常见现象。

4. 安全与权限模型高度依赖外部系统

MCP 在设计上刻意保持“协议中立性”,并不内置完整的安全体系。

具体来说:

- MCP 定义了能力边界(Tools / Resources)

- 但不强制规定身份认证、授权或审计机制

在真实部署中,安全能力通常需要通过外部系统实现,例如:

- OAuth / OIDC

- API Gateway

- Zero Trust 架构

- 企业级 IAM 系统

因此,应当将 MCP Server 视为:

被安全体系包裹的能力服务,而不是安全控制中心本身

这也是 MCP 能够灵活适配不同企业与云环境的重要原因,但同时也提高了系统设计的复杂度。

5. 协议与生态仍处于快速演进阶段

作为一项面向 AI Agent 的新型通信协议,MCP 仍在持续演进中:

- 协议细节和能力原语在不断完善

- 不同实现对新特性的支持存在时间差

- 某些高级用法仍需要通过实践逐步沉淀最佳模式

这意味着,MCP 更适合被视为一个长期演进的基础设施协议,而非已经完全固化的终态标准。

MCP Server 并不试图解决所有 Agent 架构问题,而是专注于为 AI Agent 提供一种标准化、可扩展的方式来发现、调用和组合工具与资源。

理解 MCP 的这些局限性,有助于开发者在系统设计中:

- 明确职责边界

- 避免过度依赖协议本身

- 将复杂性放在更合适的架构层中解决

总结

在实际工程中,MCP 更像是一种‘能力协议底座’,其价值往往在系统复杂度上升后才逐渐显现。MCP Server不是为了取代 传统API/Function Calling,而是为 AI Agents 提供一套 标准化、可扩展、安全的协议层。它通过引入一个标准化的协议层,解决了AI Agent规模化应用中的核心工程挑战:将工具集成从N×M的复杂度降为N+M,提供了动态发现和安全执行的框架,并将工具生态与AI模型解耦。从而让这些智能代理能够:

- 系统性访问能力;

- 动态发现和调用工具/资源;

- 跨模型与跨平台互操作。

通过协议层标准化,MCP 为未来更加丰富、可组合的 AI 工具生态奠定基础。它标志着AI Agent开发从“手工集成”走向“标准化基础设施”的关键一步,为构建可互操作、可扩展且安全的企业级智能体系统奠定了基础。

MCP 常见问题(FAQ)

1. MCP 会取代传统 API 或 Function Calling 吗?

不会。MCP 的定位并不是替代传统 API 或模型厂商提供的 Function Calling,而是在更高一层实现MCP Client通过协议定义的list方法从MCP Server动态发现能力的调用协议。

- 对于简单、固定、单模型的场景,Function Calling 依然高效且足够;

- 对于多模型、多工具、长期演进的 Agent 系统,MCP 提供了更好的解耦性和可维护性。

二者在实际系统中往往是互补关系。

2. MCP 是否强制要求使用某一种大模型?

不需要。MCP 是一个与模型无关(Model-agnostic) 的协议。MCP 只规范 Client 与 Server 之间的通信方式; 不关心底层使用的是 OpenAI、Anthropic、Google,还是本地部署的开源模型。只要 AI 应用能够按照 MCP 协议暴露工具上下文并发起调用,就可以使用 MCP Server。

3. MCP 是否内置权限控制和安全机制?

没有内置完整安全体系。MCP 的设计原则是协议层中立,安全能力通常由部署环境和外部系统提供,例如:

- HTTPS / TLS

- OAuth2 / API Key / mTLS

- 企业级 IAM 与审计系统

这意味着 MCP Server 必须被视为受保护的能力服务,而不是安全边界本身。

4. 在多个 MCP Server 同时存在时,如何避免工具冲突?

MCP 协议本身不解决工具冲突问题。当多个 Server 暴露语义相似的工具时:

- MCP 只负责提供标准化的能力描述;

- 工具选择、优先级判断和冲突治理由 Client 或 Agent 的 Planner 层负责。

在企业级系统中,通常会通过:

- 命名空间约定

- 工具标签(Tags)

- 策略规则或人工约束 来减少冲突风险。

5. MCP 是否会导致上下文窗口快速膨胀?

有这种风险,但并非 MCP 独有问题。在多轮工具调用和复杂 Agent 流程中:

- 工具描述

- 调用参数

- 返回结果 都会占用上下文窗口。

需要明确的是:

- MCP 不负责上下文管理

- 上下文压缩、摘要、长期记忆存储属于 Agent 架构层问题

这是所有基于 LLM 的 Agent 系统都需要面对的挑战。

6. MCP Server 是否适合高并发和企业级场景?

可以,但取决于实现方式。MCP 协议本身是轻量的,是否支持高并发主要取决于:

- MCP Server 的实现质量

- 是否支持多实例部署

- 是否结合负载均衡、容器化和云原生架构

在实践中,MCP Server 常被:

- 容器化部署

- 运行在 Kubernetes 等平台上

- 作为内部能力中台使用

7. MCP 的学习和接入成本高吗?

相对较低,但需要架构理解。从代码层面看,实现一个基础 MCP Server 并不复杂;

- 真正的学习成本在于理解 Agent 架构、工具治理和系统边界。

因此,MCP 更适合:

- 有一定工程经验的开发者

- 构建中大型 AI 应用或 Agent 系统的团队

8. MCP 目前是否已经“成熟稳定”?

MCP 核心设计是稳定的,但生态仍在演进中。

- 协议方向清晰,核心原语已经成型;

- 不同语言实现的成熟度存在差异;

- 最佳实践仍在不断沉淀。

它更适合作为:

面向未来的 Agent 基础设施协议 而不是一次性“封顶”的解决方案。

9. MCP 是否适合个人开发者或小团队?

适合,但前提是有明确需求。如果你的项目:

- 工具数量少

- 架构简单

- 不需要频繁扩展

那么 MCP 可能显得“过重”。但如果你希望:

- 工具可复用

- 模型可替换

- 架构可长期演进

那么 MCP 能在早期就避免后期重构成本。

10. MCP 最适合解决哪一类问题?

MCP 最擅长解决的是:

- 多工具、多服务的标准化接入

- AI Agent 的能力发现与执行解耦

- 跨模型、跨团队的能力复用

它的价值在于工程层面的可持续性,而不是单次调用的便利性。

MCP系列文章:

- MCP Server 全面解析:AI Agent 时代的上下文与工具通信中枢

- MCP Server 解决了哪些关键问题?为什么 AI Agent 需要它

- MCP Server 架构与工作原理详解:从协议到执行流程

- MCP Server 实战指南:从 0 到 1 构建、测试与部署

- MCP Server 应用场景评估与技术选型指南

关于作者

本文内容由 NavGood 内容编辑团队 整理发布。

NavGood 是一个专注于 AI 工具与 AI 应用生态的导航与内容平台,长期跟踪 AI Agent、自动化工作流与生成式 AI 技术的发展与落地实践。

免责声明: 本文仅代表作者的个人理解和实践经验。它不代表任何框架、组织或公司的官方立场,也不构成商业、金融或投资建议。所有信息均基于公开来源和作者的独立研究。

References:

[1]: https://json-rpc.dev/learn/mcp-basics "Understanding JSON-RPC for AI Integration"

[2]: https://modelcontextprotocol.io/docs/learn/architecture "Architecture overview - Model Context Protocol"

[3]: https://json-rpc.org/specification "JSON-RPC 2.0 Specification"

[4]: https://modelcontextprotocol.io/docs/learn/architecture "About MCP:Architecture overview"